数通知识宝典

Version 1.6.1

朱仕耿 00261992

华为技术有限公司¶

版权所有 侵权必究

修订记录¶

| 日期 | 版本 | 描述 | 作者/修订人 |

|---|---|---|---|

| 2014-07-01 | 1.0 | 初稿完成 | 朱仕耿 00261992 |

| 2014-07-20 | 1.1 | 增加VRP配置基础;修订NAT的部分内容; 增加GREOver IPSec;增加IPv6内容 | 朱仕耿 00261992 |

| 2014-08-01 | 1.2 | 增加Smart Link;增加组播内容;修订部分章节 | 朱仕耿 00261992 |

| 2015-10-20 | 1.3 | 修订部分章节及已知文档错误;增加堆叠技术内容 | 朱仕耿 00261992 |

| 2017-04-28 | 1.5 | 修订部分章节,优化文档结构,修改已知文档错误;增加网 络故障处理等章节;刷新防火墙配置(基于NGFW) | 朱仕耿 00261992 |

| 2017-08-09 | 1.6 | 增加MPLS与MPLS VPN章节,删除部分老旧内容 | 朱仕耿 00261992 |

目 录¶

数据通信与网络 知识地图 10#_bookmark0

- 网络基础 11

- 利用TCP/IP模型理解数据通信过程 11

- IP地址的概念及IP子网划分 19

- VRP基础 27

- 使用Console接口管理设备 32

- eNSP华为官方数通模拟器 37

- 交换基础 43

- 二层交换基础 43

- VLAN及Trunk 47

- VLAN的基本概念 47

- Access类型的接口 49

- Trunk类型的接口 50

- 接口类型小结 51

- VLAN及Trunk的基础配置 54

- Hybrid接口的配置 57

- QinQ 62

- 二层接口、三层接口、以及PVID、VLAN-ID等概念杂谈 65

- 二层防环技术 66

- STP 66

- STP的特性及优化 79

- MSTP 89

- Smart Link及Monitor Link 98

- 实现VLAN间的互访 115

- 通过子接口实现VLAN间的互访 115

- 通过vlan-interface实现VLAN间的互访 118

- 链路聚合 122

- 链路聚合技术背景 122

- 工作方式:手工负载分担(Manual load-balance) 123

- 工作方式:LACP 124

- 基础实验 126

- 交换安全 130

- 端口镜像 130

- 捕获业务报文 135

- 端口隔离 138

- 路由基础 141

- IP路由基础 141

- 什么是IP路由 141

- IP路由表 142

- 路由优先级 143

- 静态路由 144

- 静态路由简单实验 146

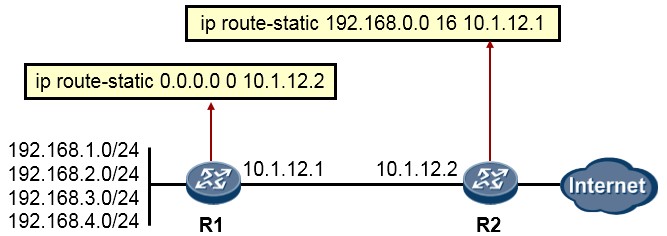

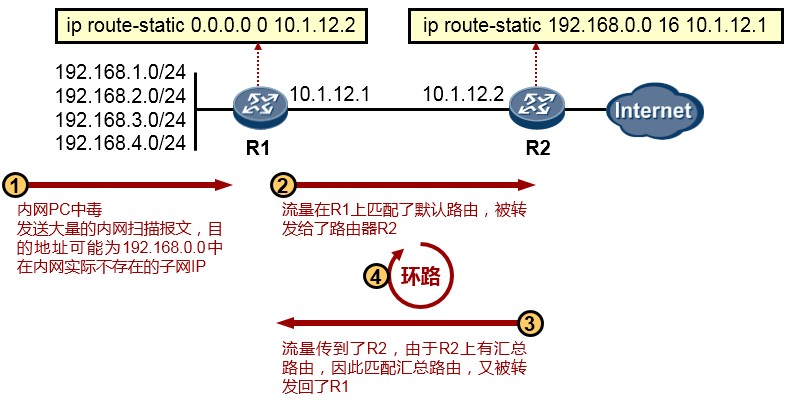

- 默认路由(缺省路由) 149

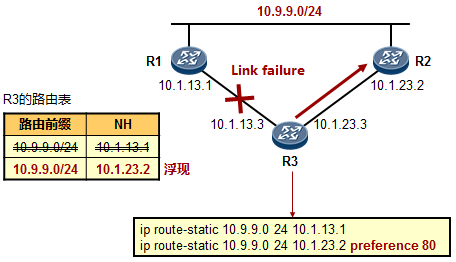

- 浮动静态路由 150

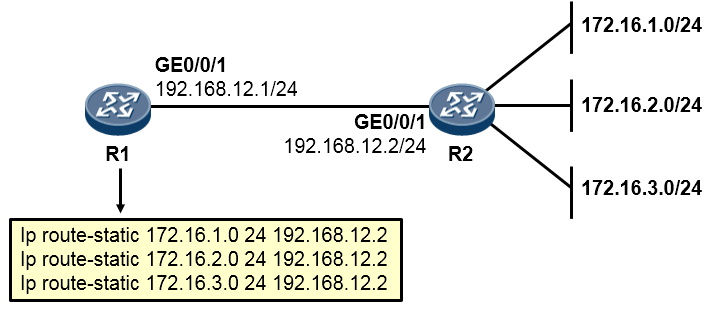

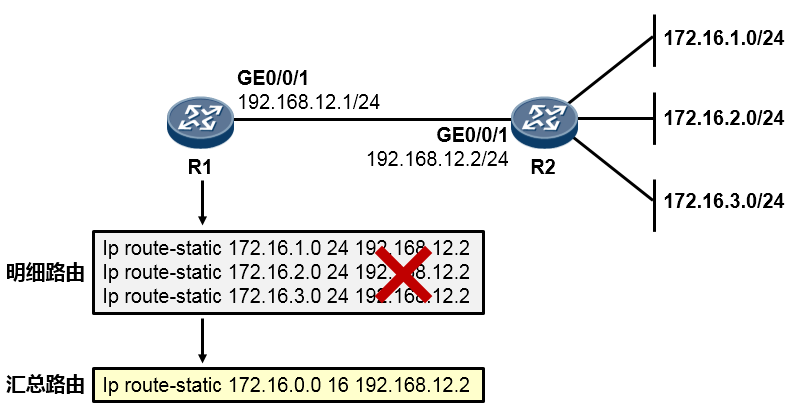

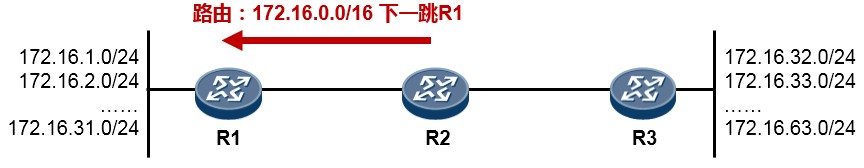

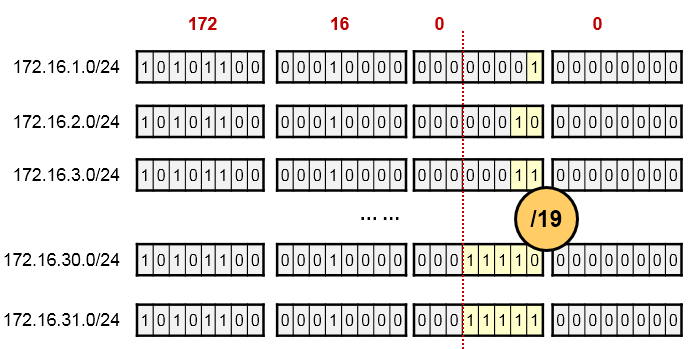

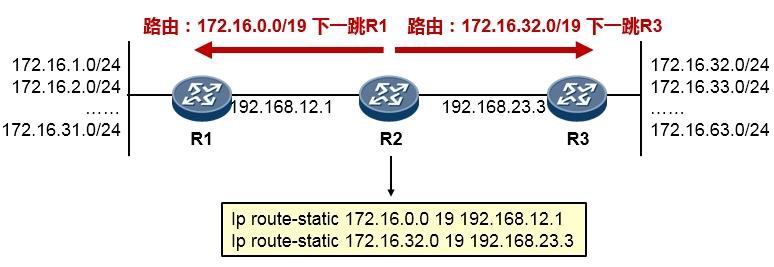

- 路由汇总(路由聚合) 151

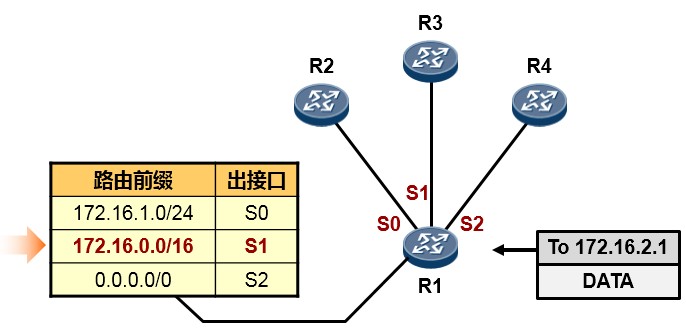

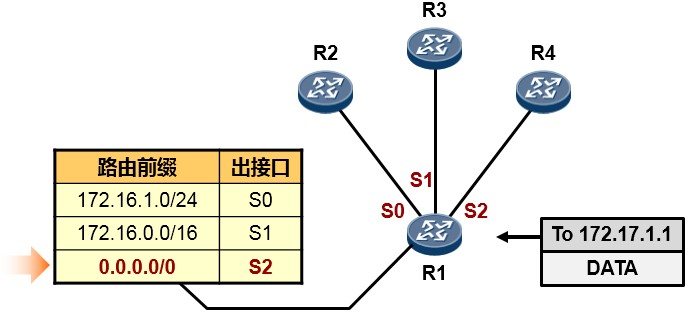

- 最长匹配原则 155

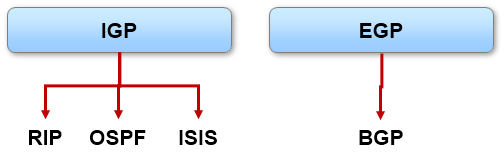

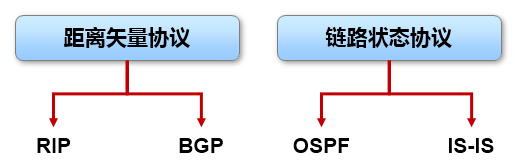

- 动态路由协议基础 159

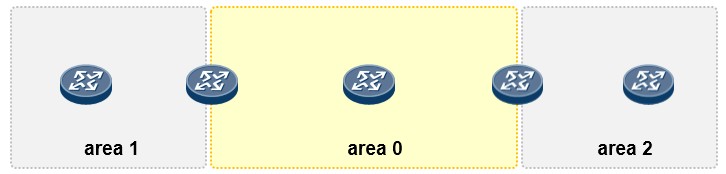

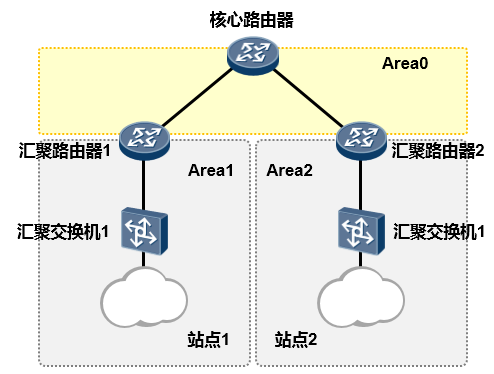

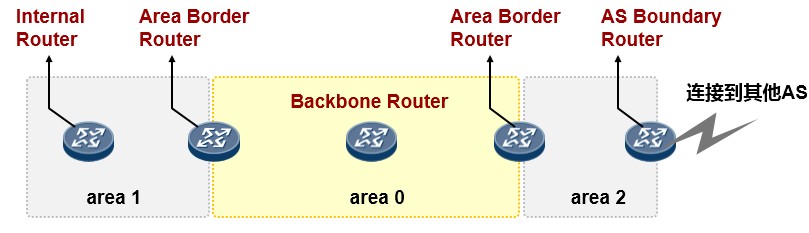

- OSPF 161

- OSPF概述 161

- OSPF基本概念 164

- OSPF的基础配置 172

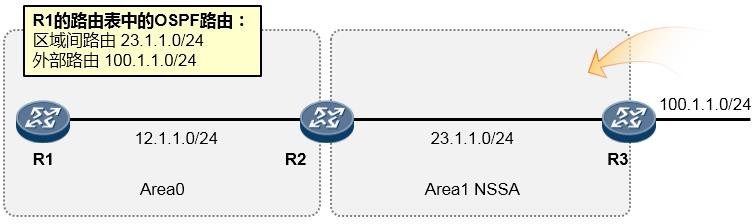

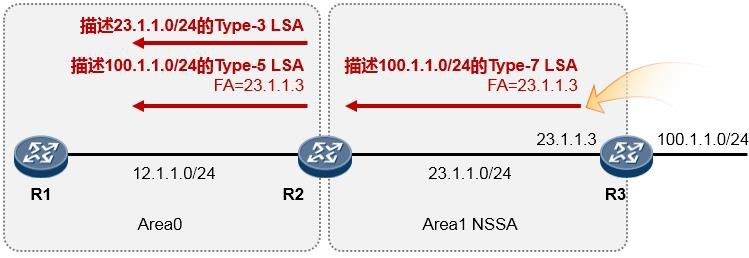

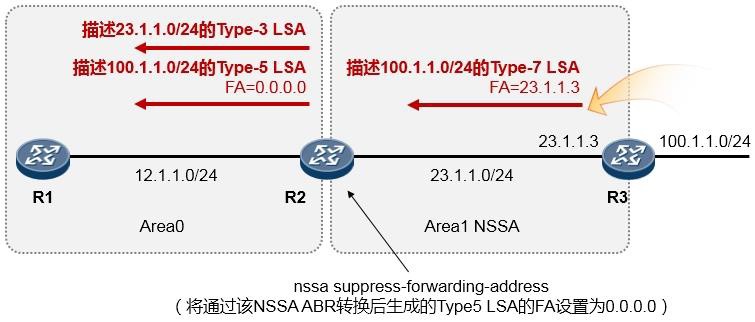

- OSPF LSA及特殊区域 182

- OSPF高级 192

- IP路由基础 141

-

交换提高 196

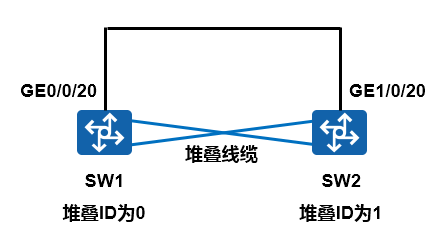

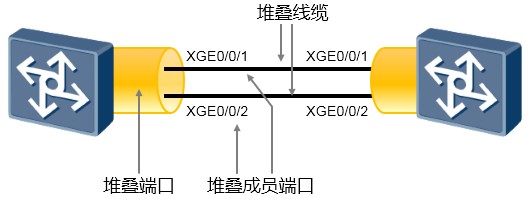

4.1 S5300交换机堆叠 196

-

理论部分 196

-

配置指导 198

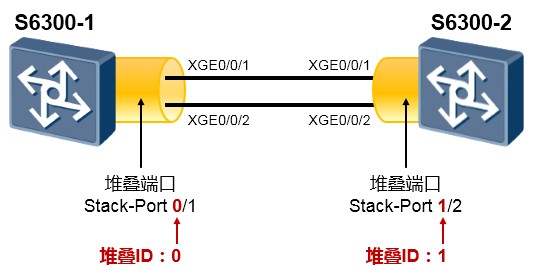

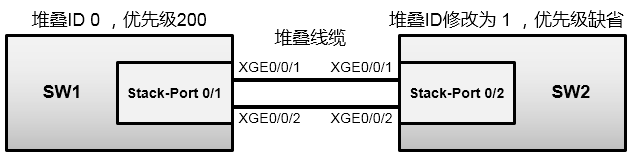

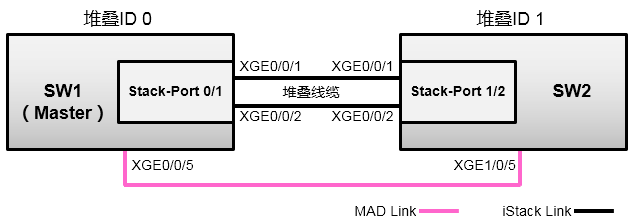

4.2 S6300交换机堆叠 200

-

理论部分 200

- 配置指导 202

- Traffic-policy流量统计 205

- VLAN映射 206

- 路由提高 207

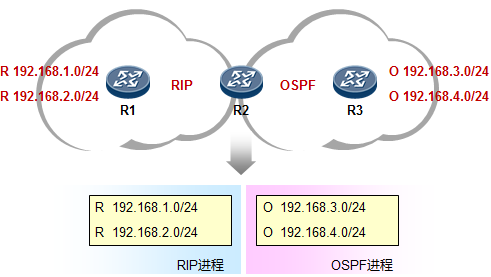

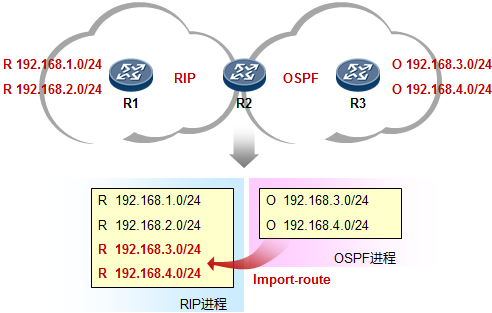

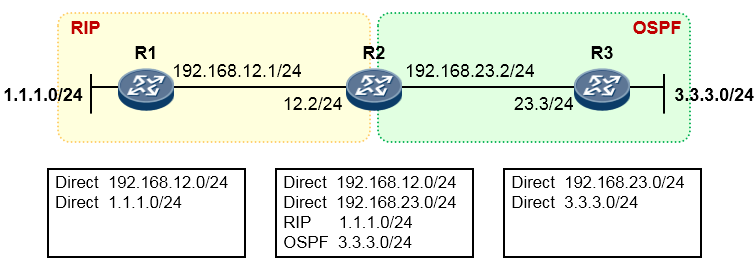

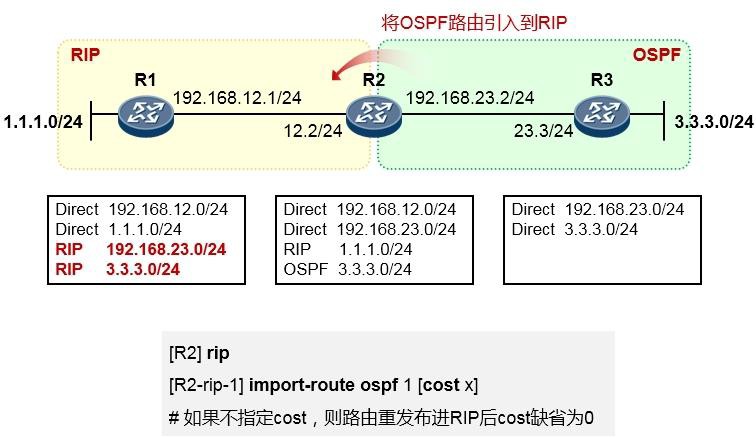

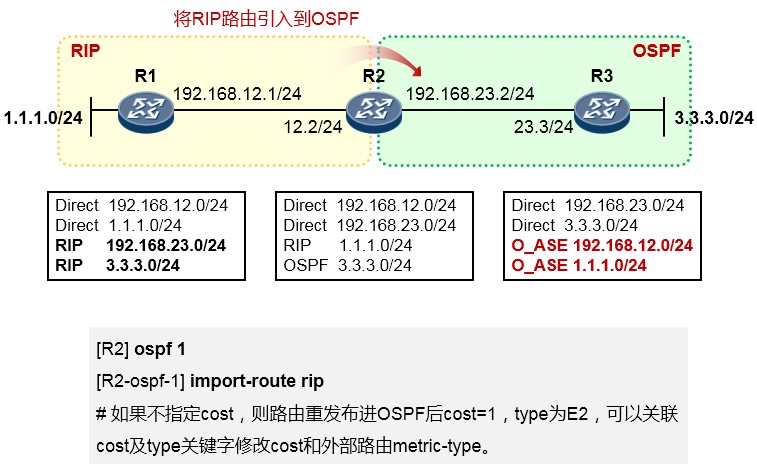

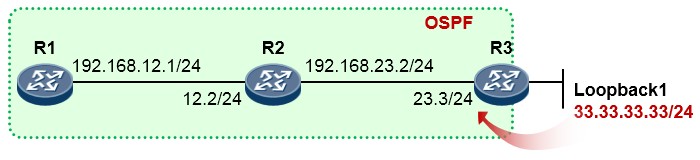

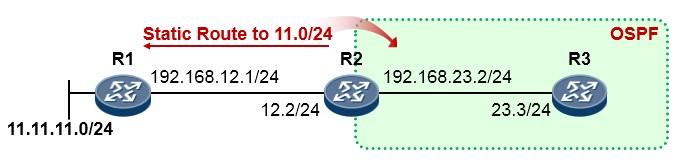

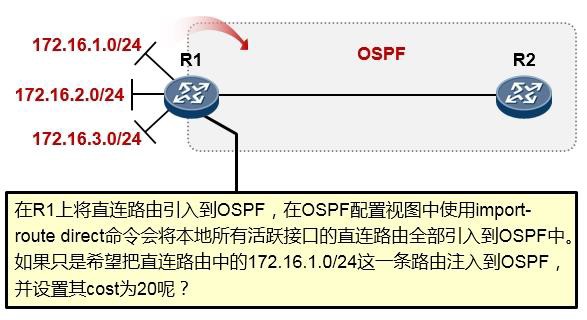

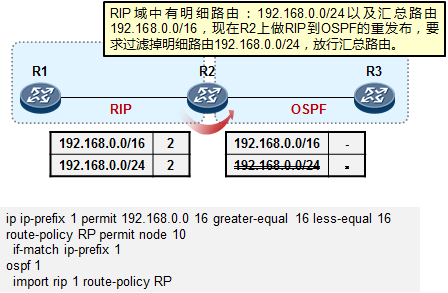

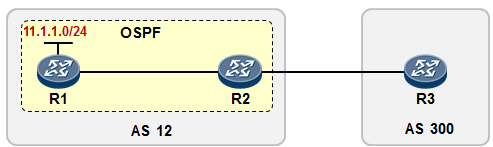

- 路由重发布 207

- 技术背景 207

- 实施要点 210

- 路由重发布的配置 211

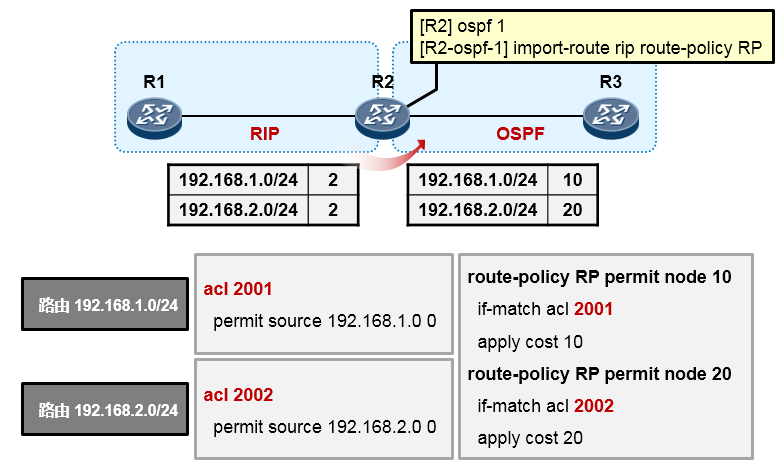

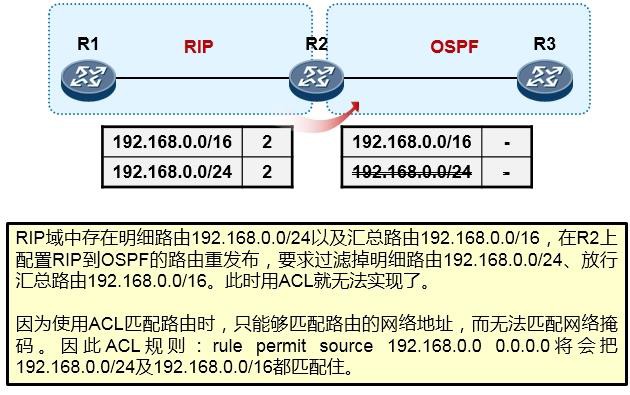

- 路由策略 215

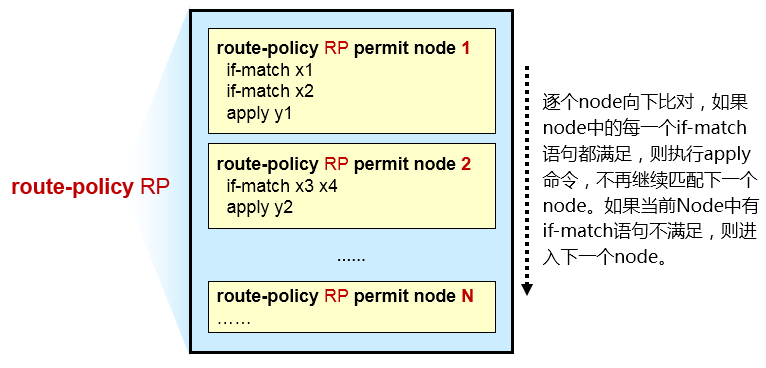

- Route-policy 215

-

IP-Prefix 218

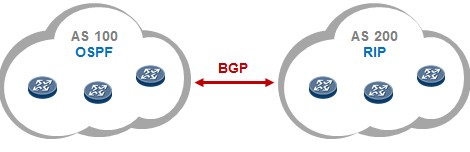

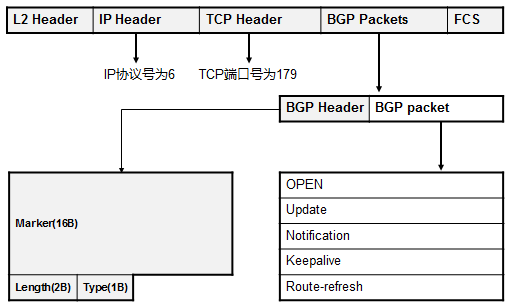

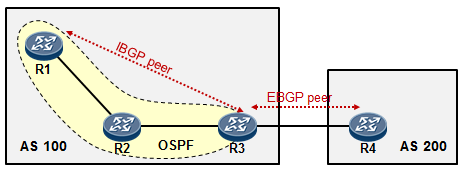

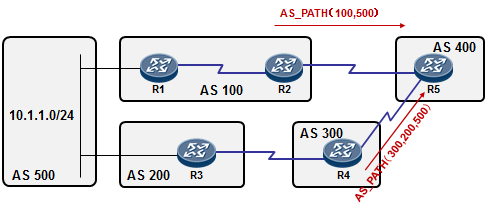

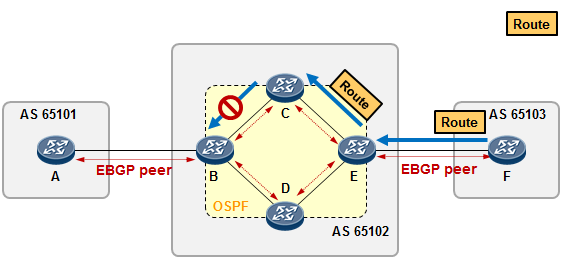

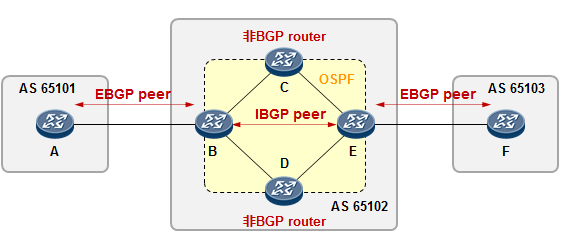

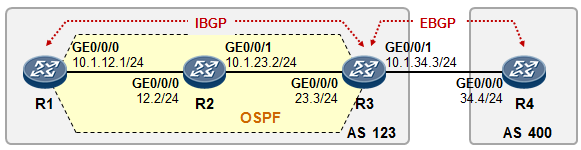

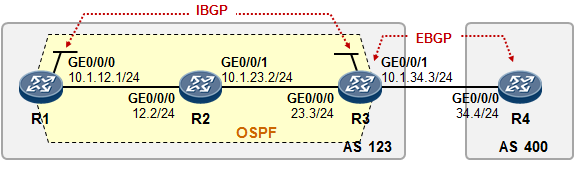

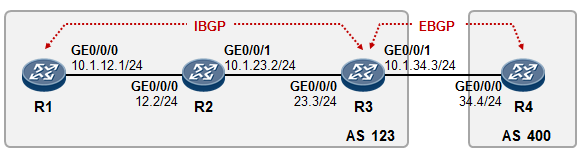

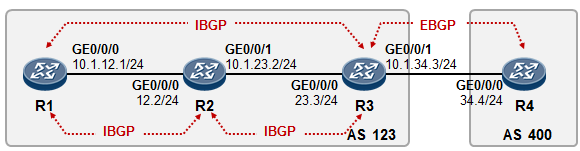

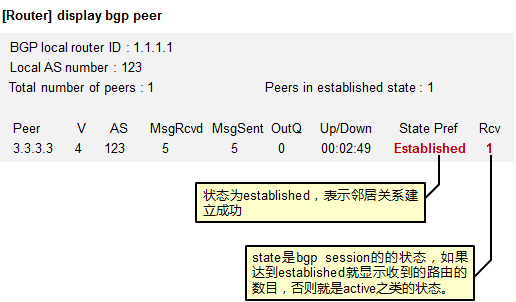

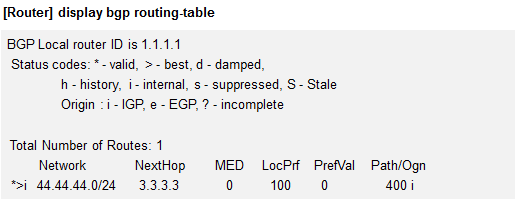

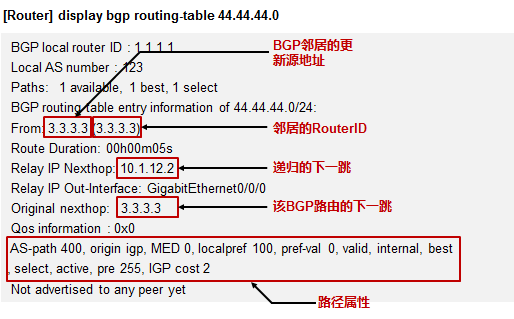

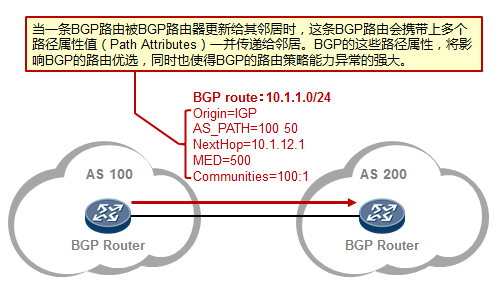

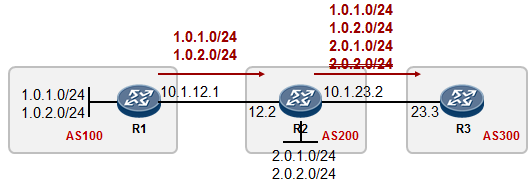

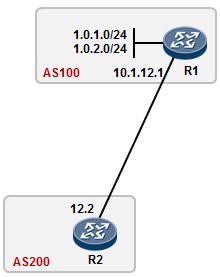

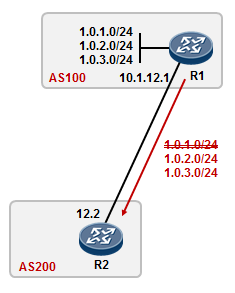

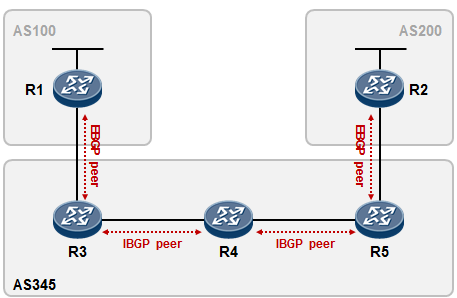

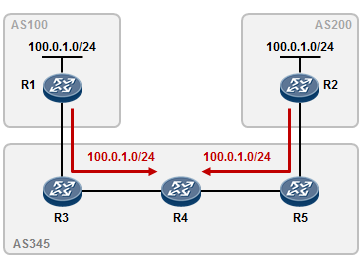

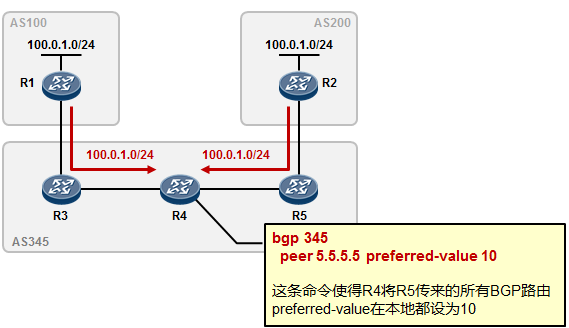

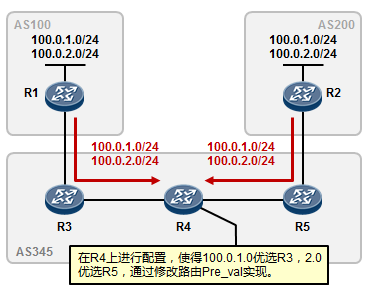

5.3 BGP 222

-

BGP基本概念 222

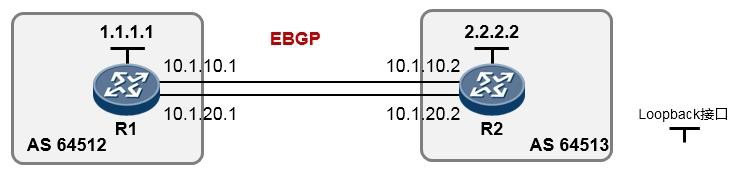

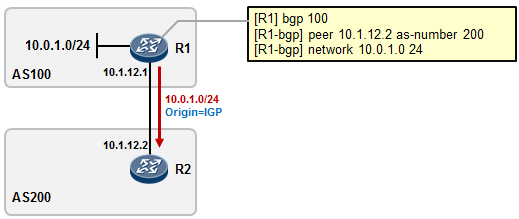

- BGP入门实验 230

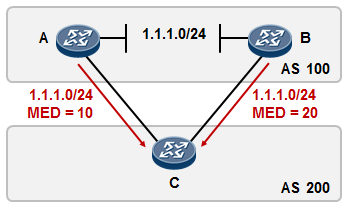

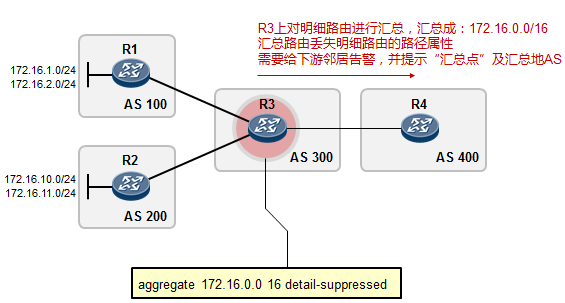

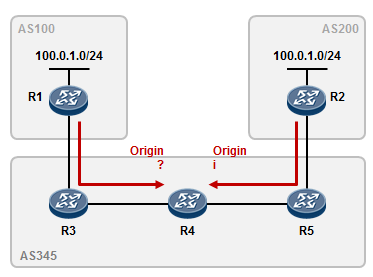

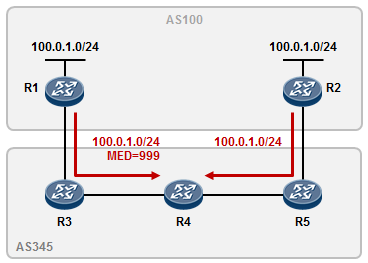

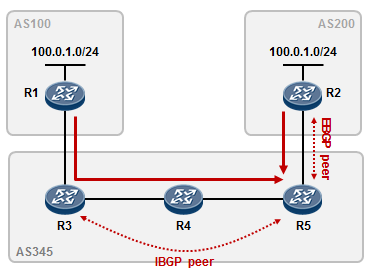

- BGP路径属性 238

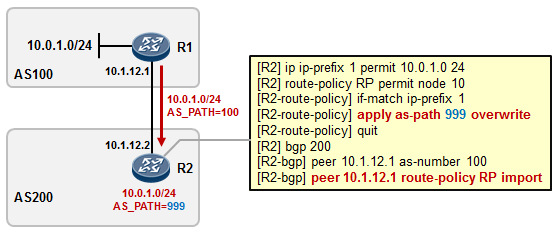

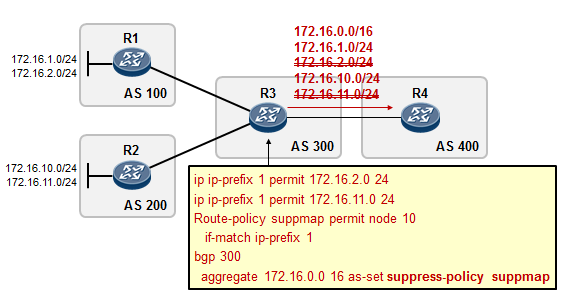

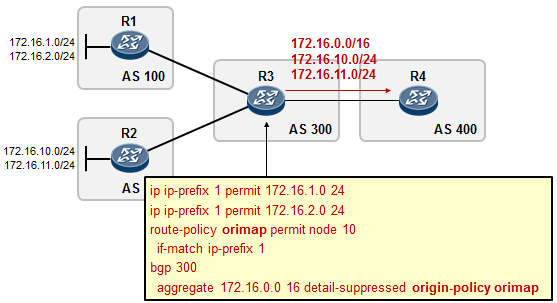

- BGP路由策略 253

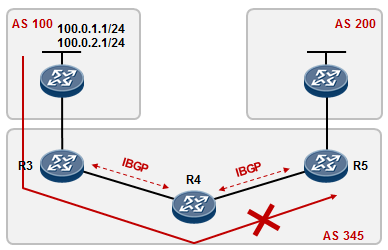

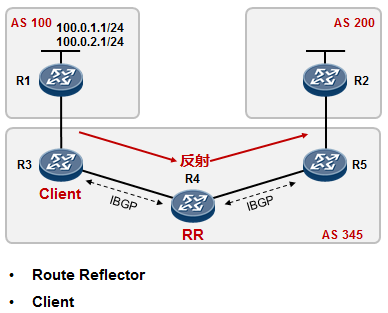

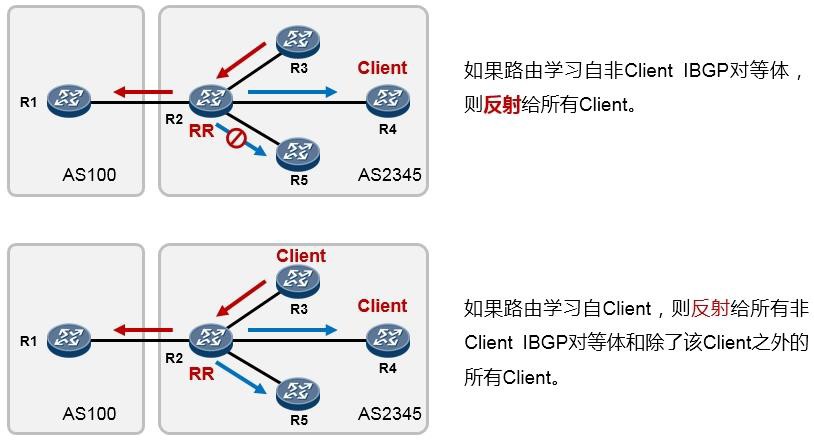

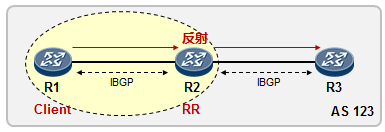

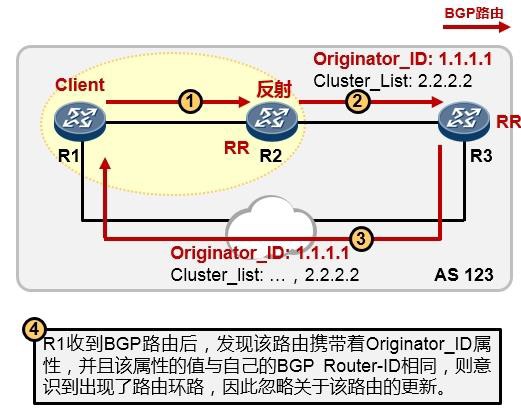

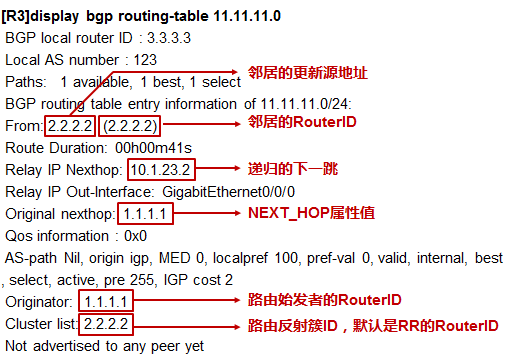

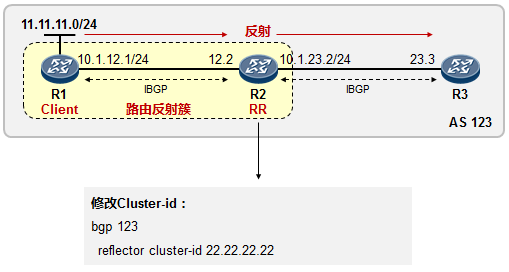

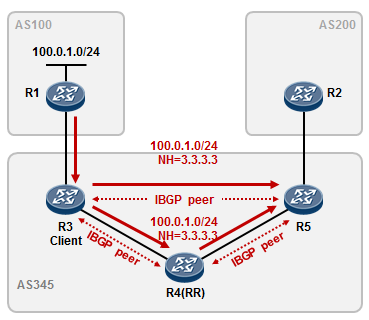

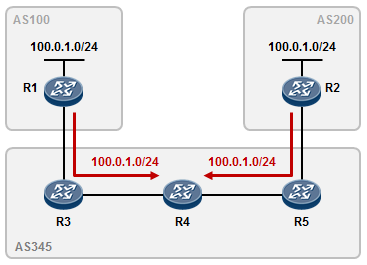

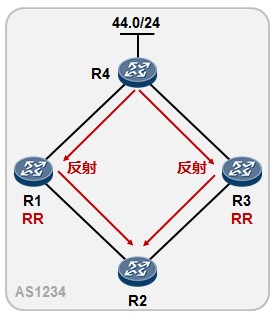

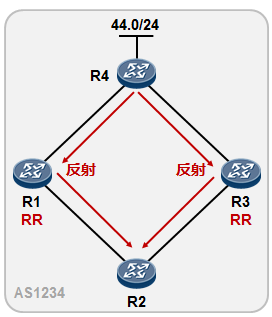

- BGP路由反射器 275

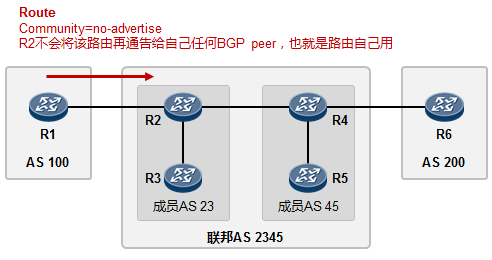

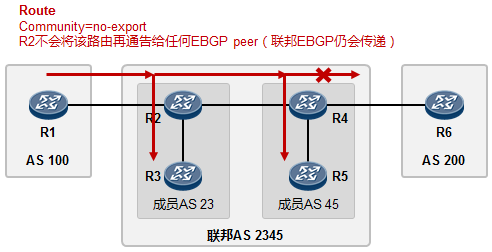

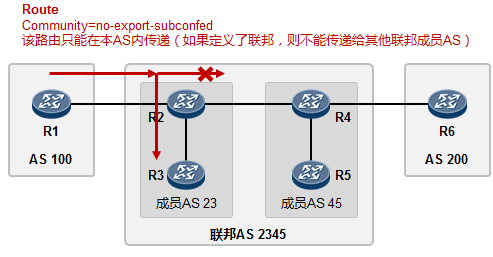

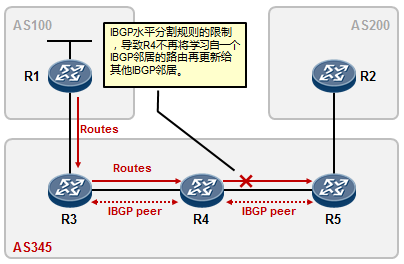

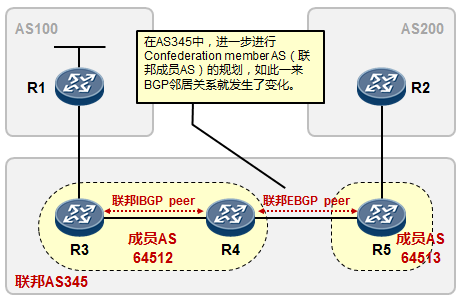

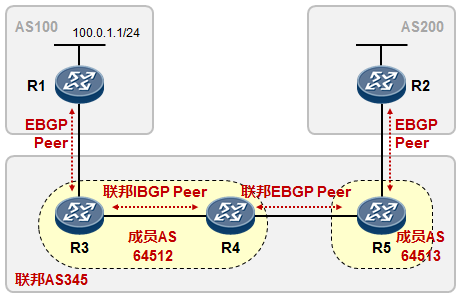

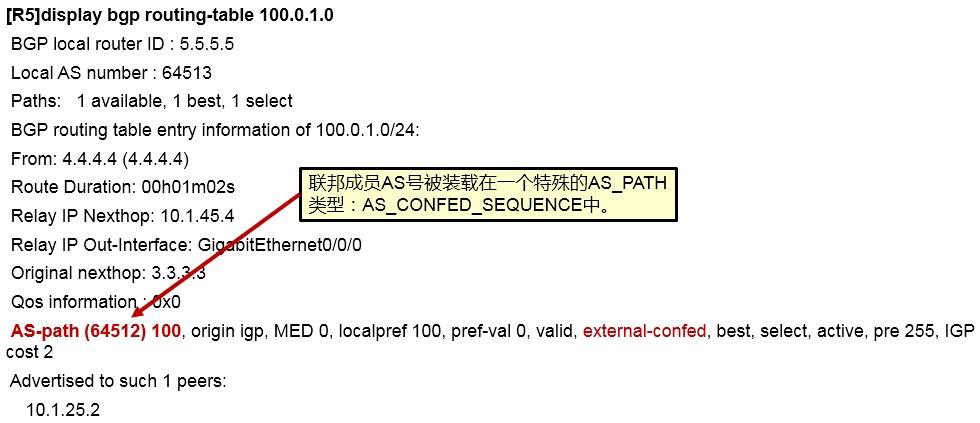

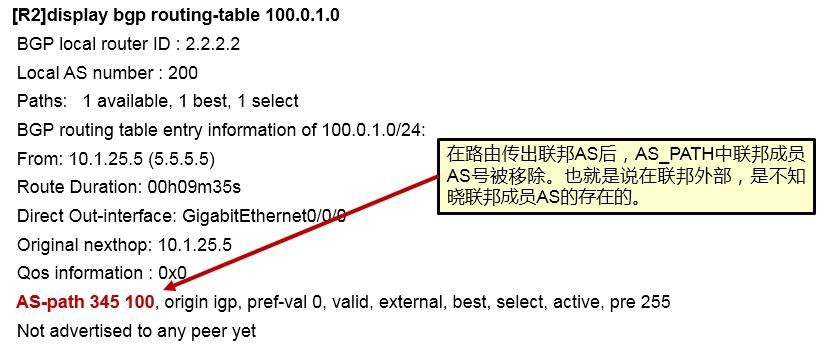

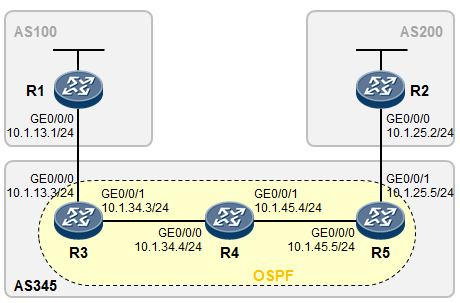

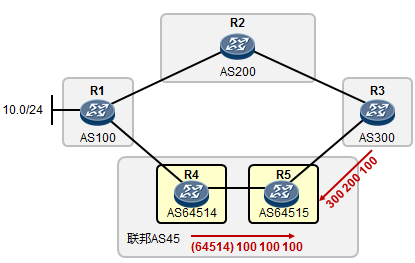

- BGP联邦 285

- BGP选路规则详解 289

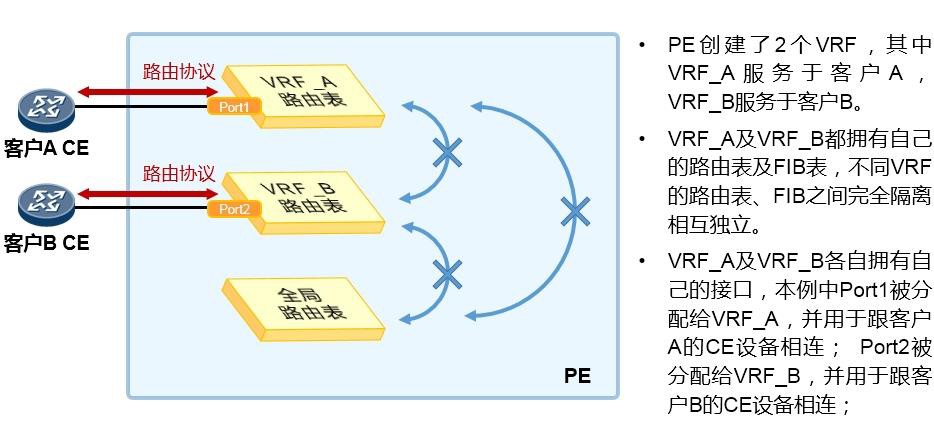

- 虚拟路由转发实例 313

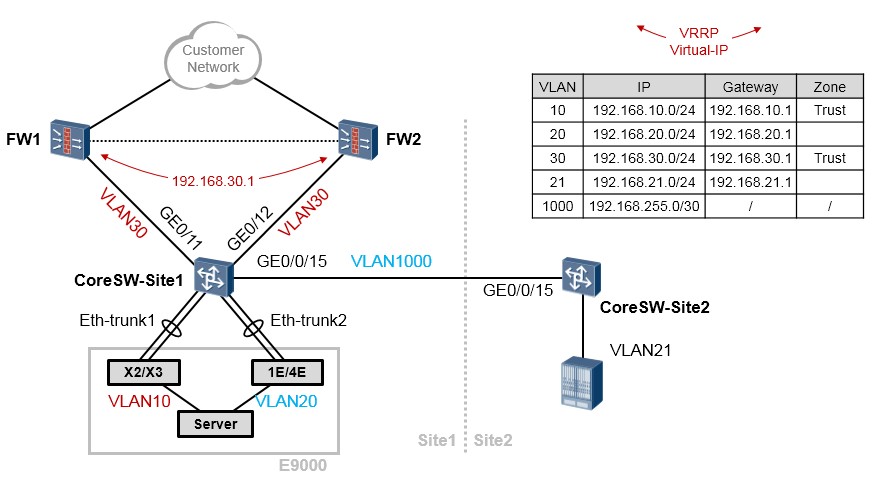

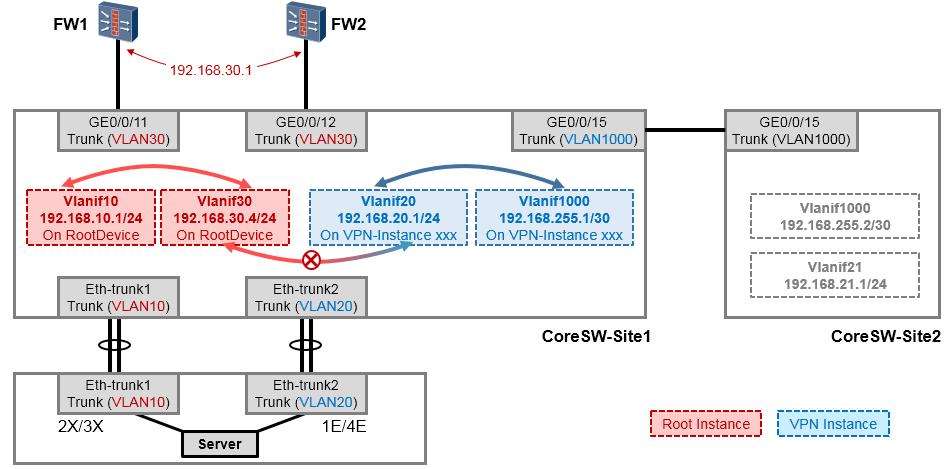

- VPN-Instance部署案例 313

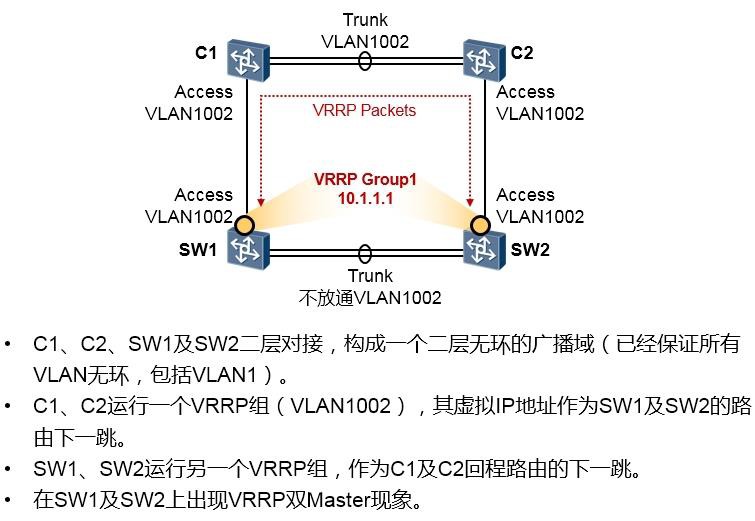

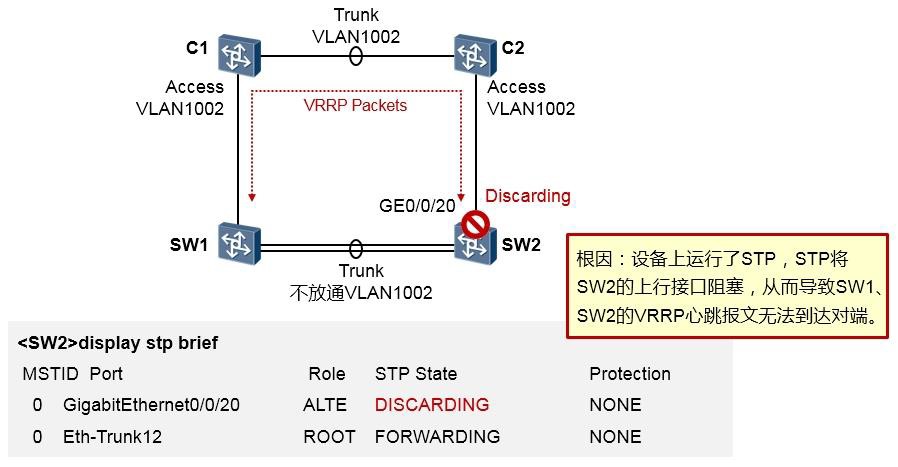

- 冗余可靠 317

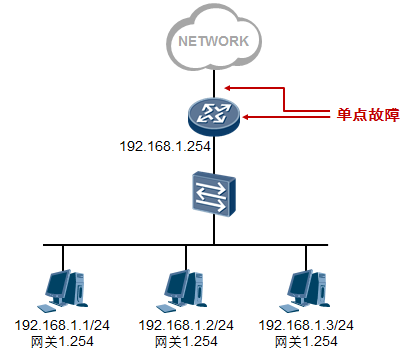

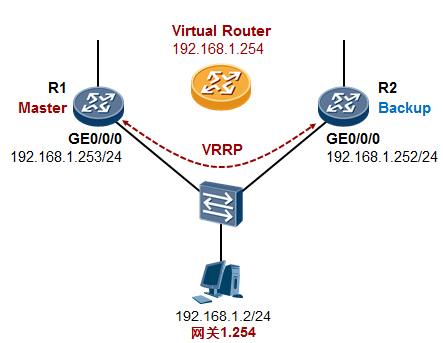

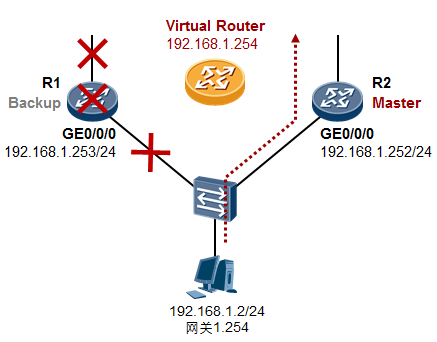

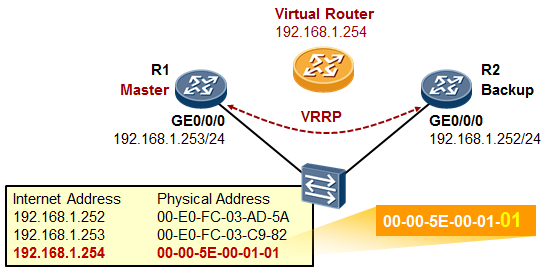

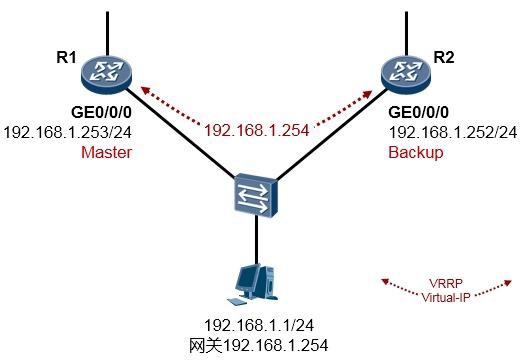

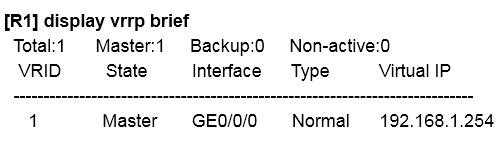

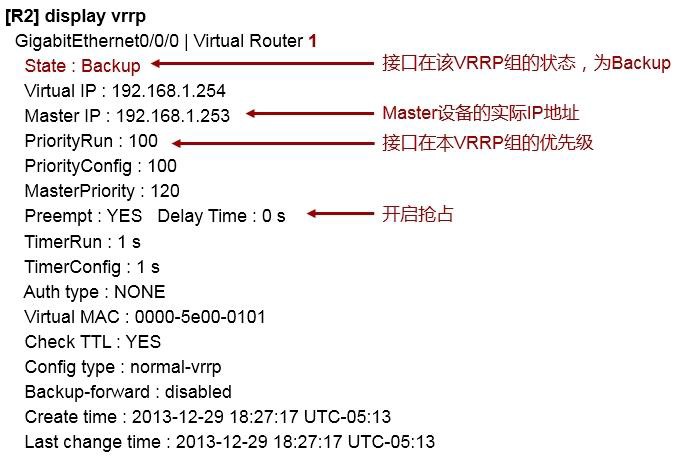

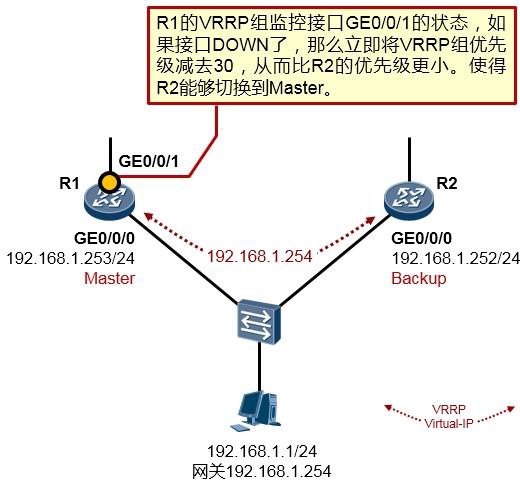

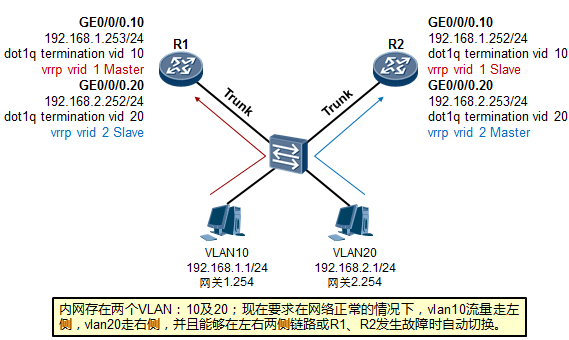

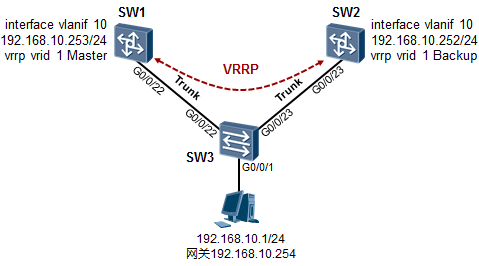

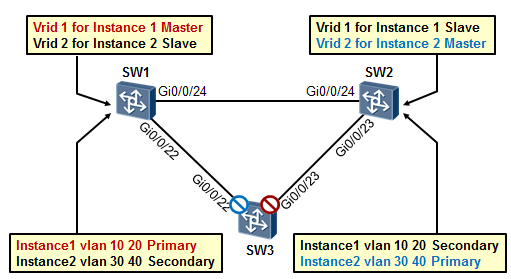

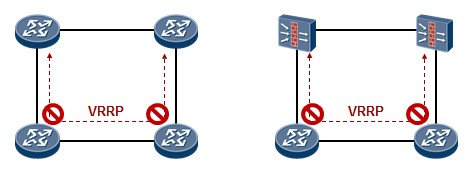

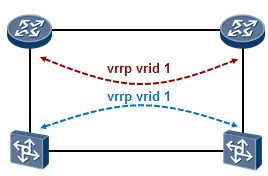

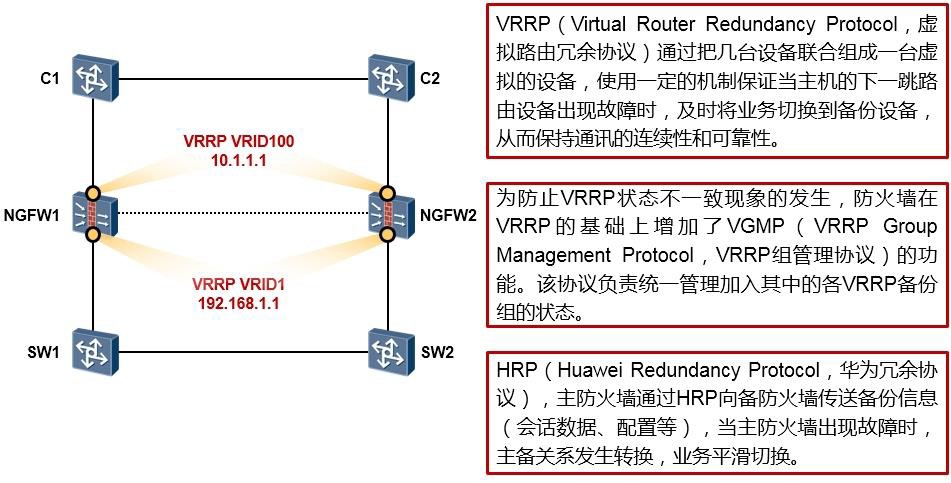

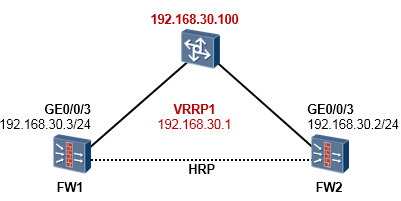

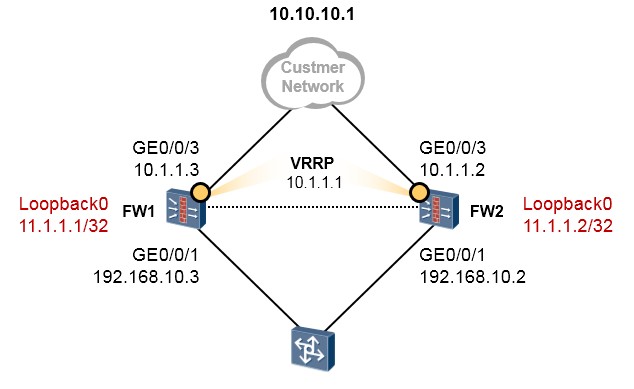

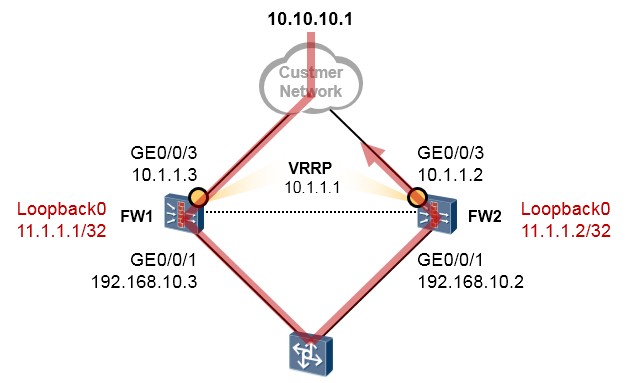

- VRRP 317

- VRRP概述 317

- VRRP术语 319

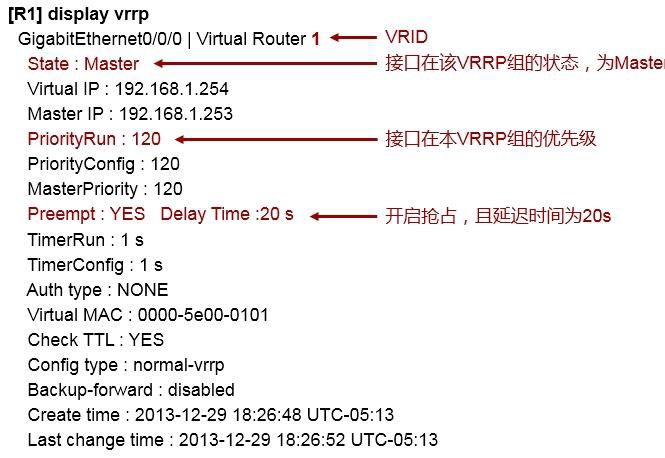

- VRRP的基础配置 320

- VRRP常见问题 330

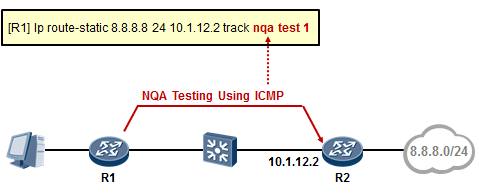

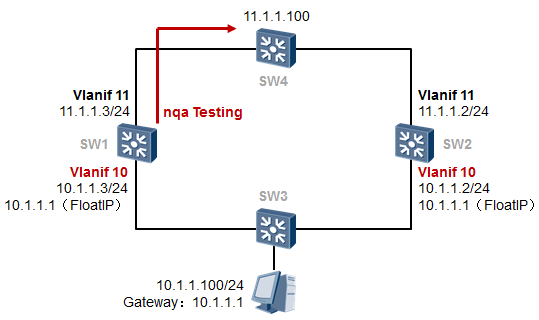

- VRRP与NQA的联动 331

- 网络安全 333

-

7.1 ACL 333

- ACL概述 333

- ACL的分类 334

- ACL的配置 335

- ACL配置实例(路由器) 336

- ACL配置示例(交换机) 337

-

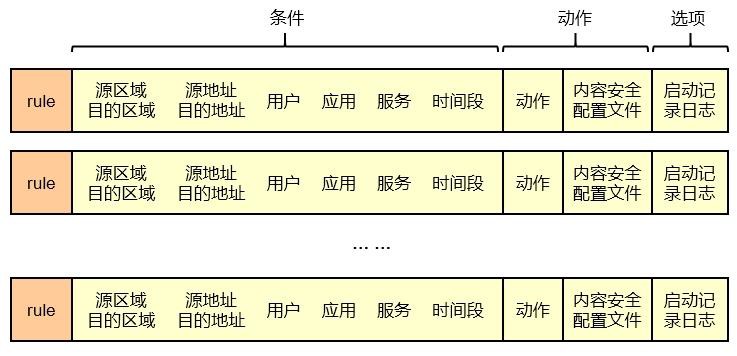

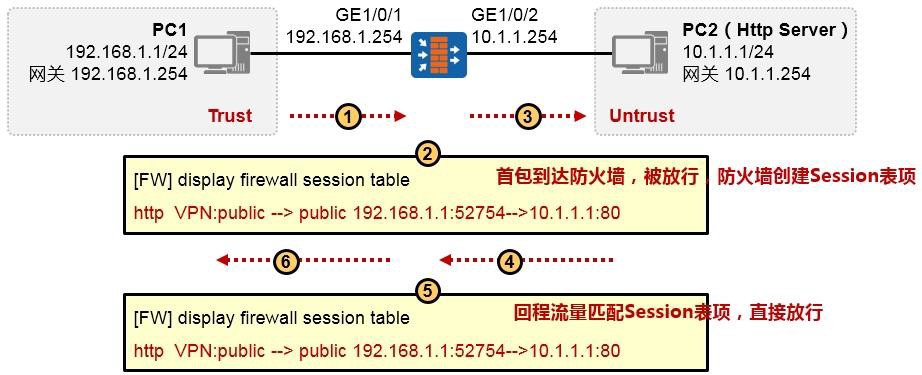

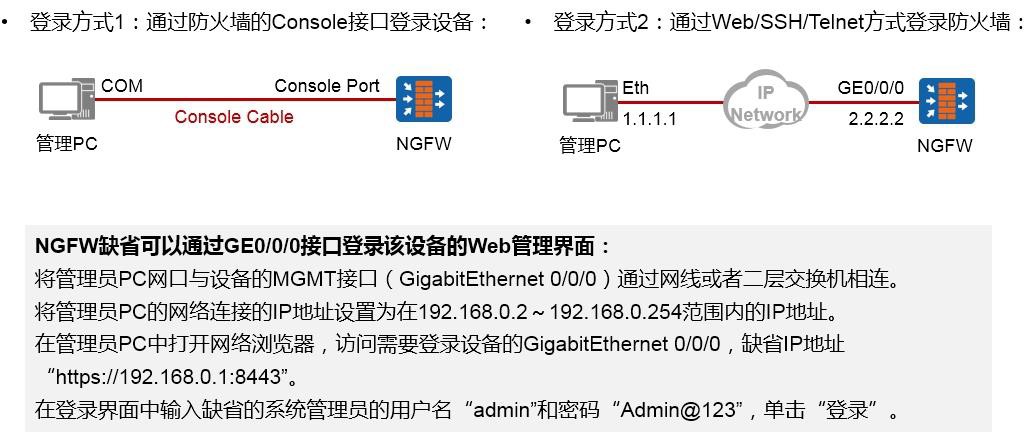

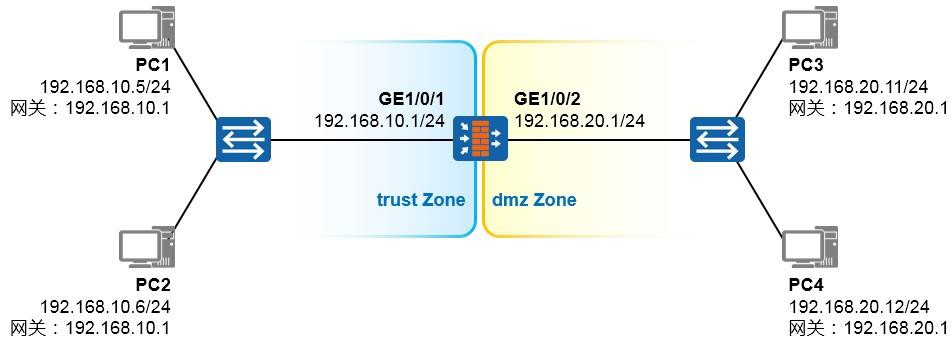

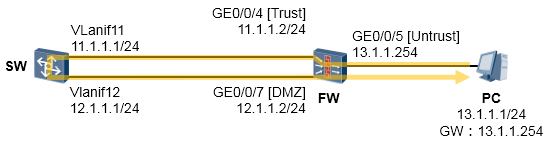

防火墙基础 338

- 防火墙概述 338

- 防火墙的基础知识 339

-

防火墙的基础配置 346

7.3 NAT 360

-

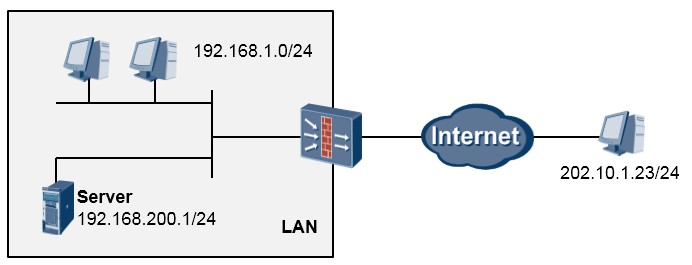

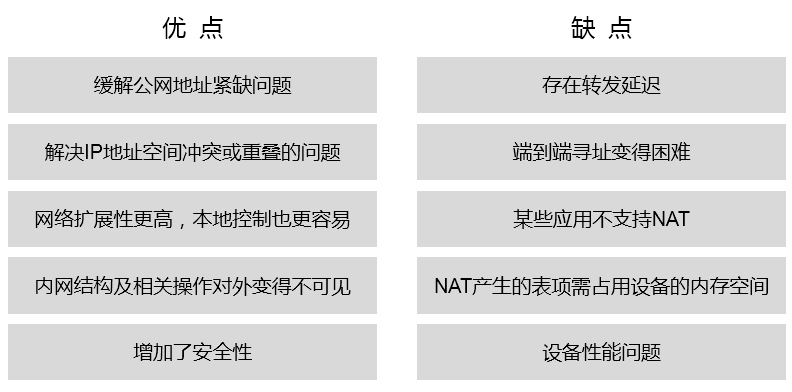

NAT概述 360

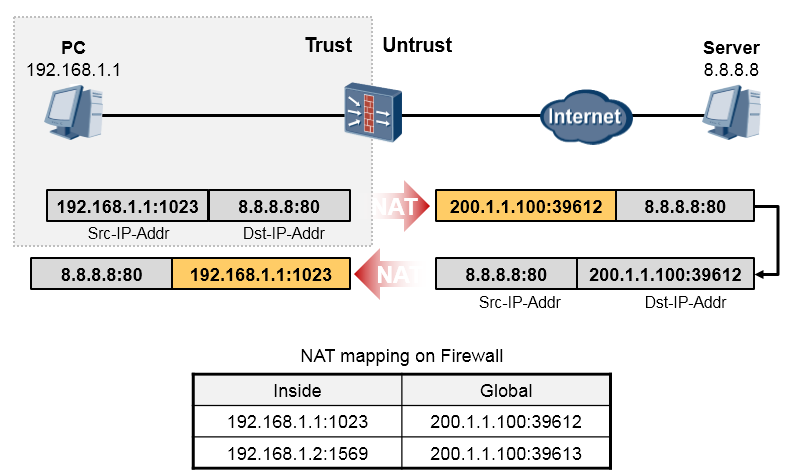

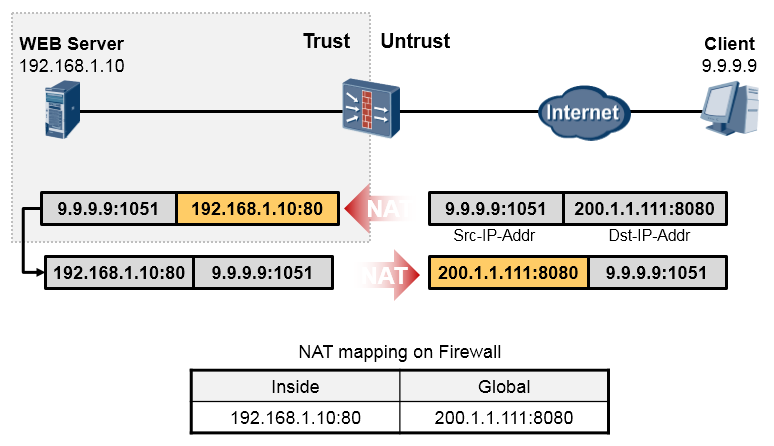

- NAT类型详解 361

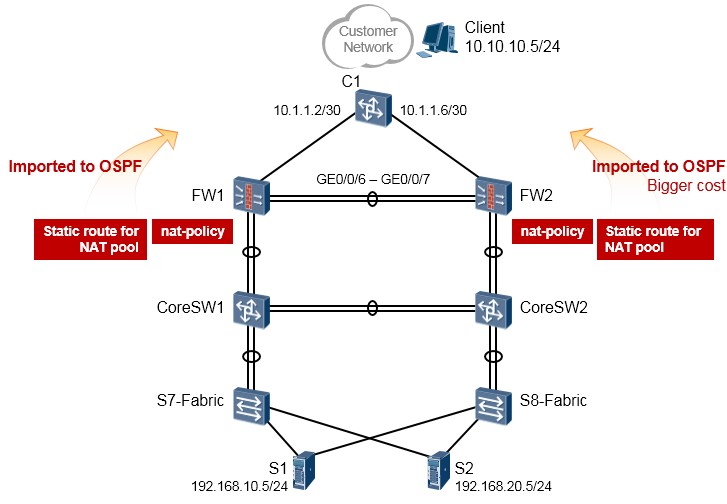

- NAT在防火墙(NGFW)上的部署 364

- NAT在路由器上的部署 372

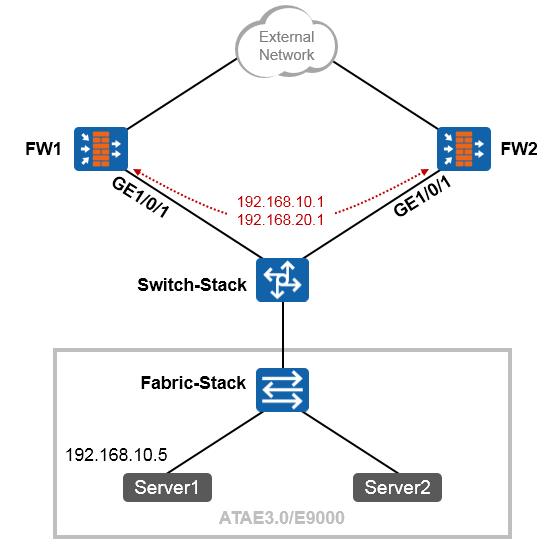

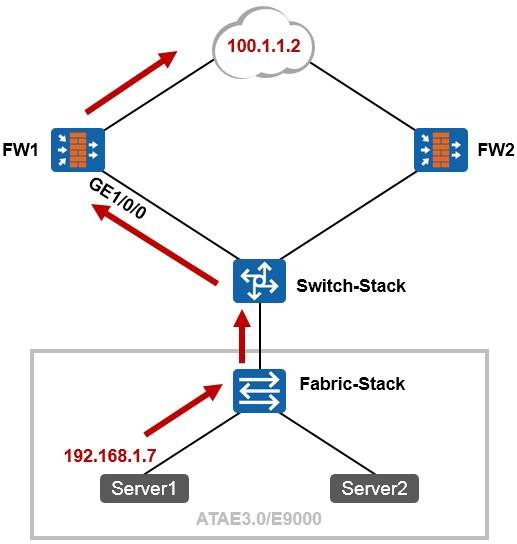

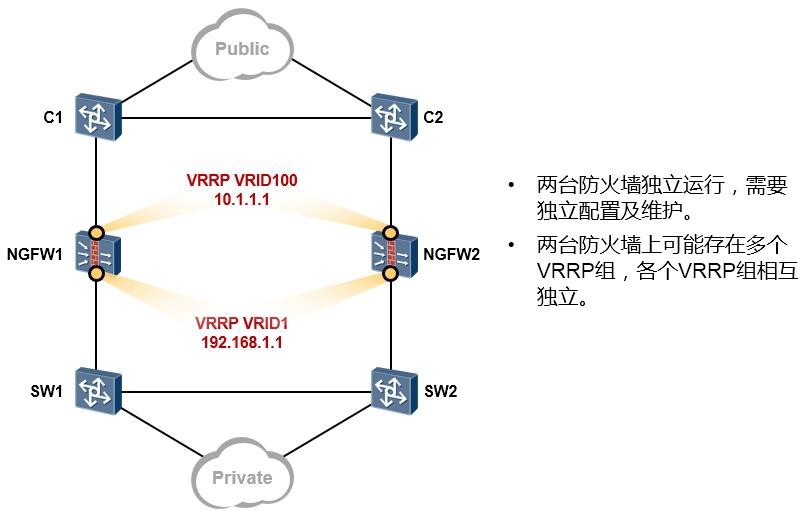

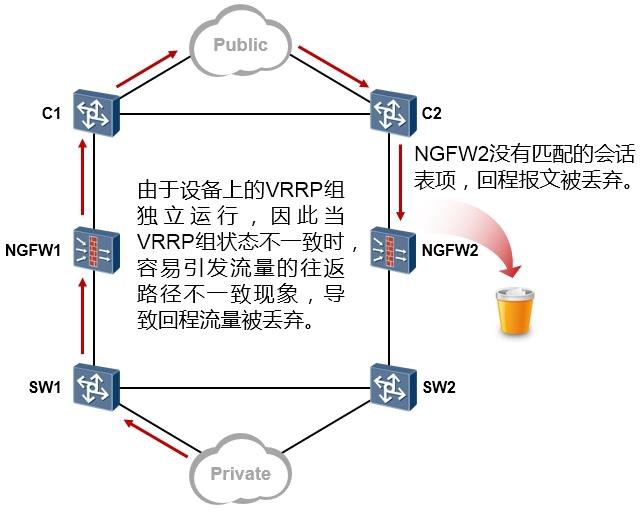

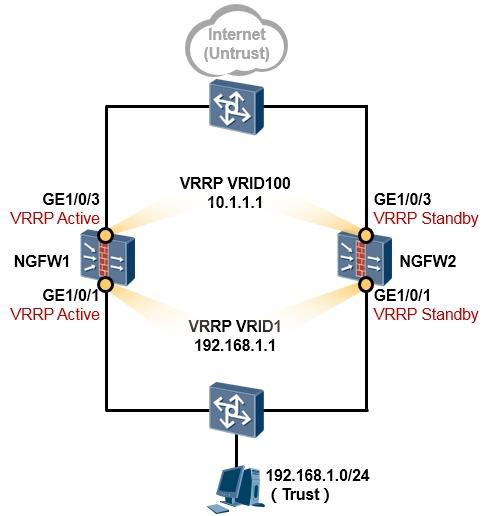

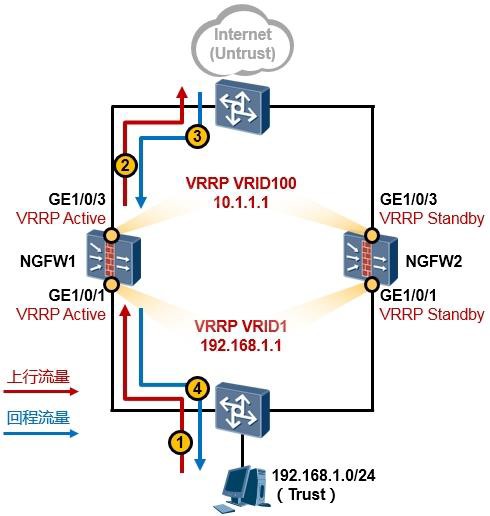

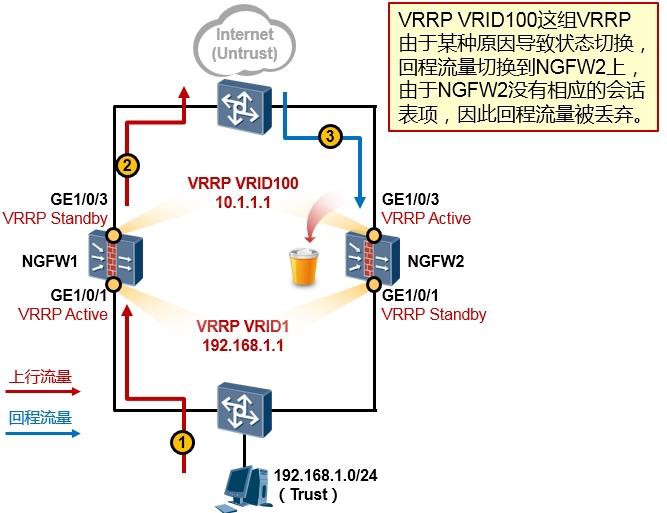

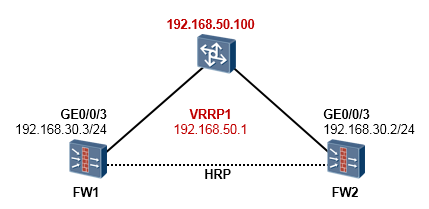

- 防火墙双机热备 375

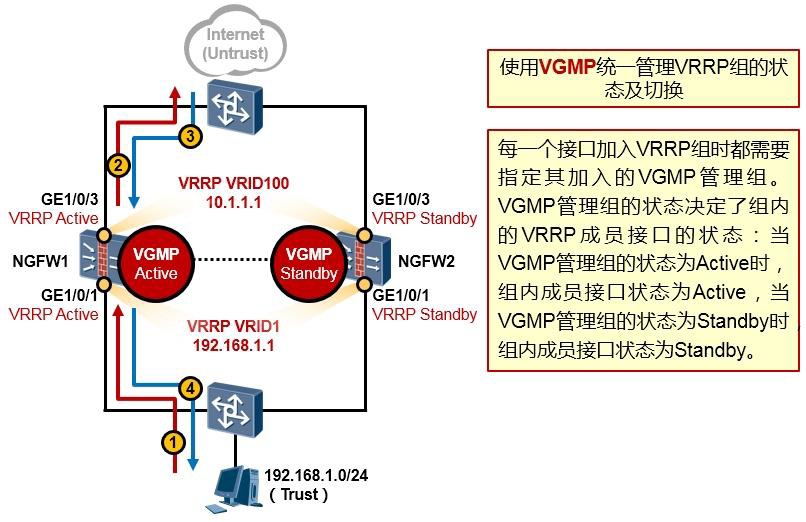

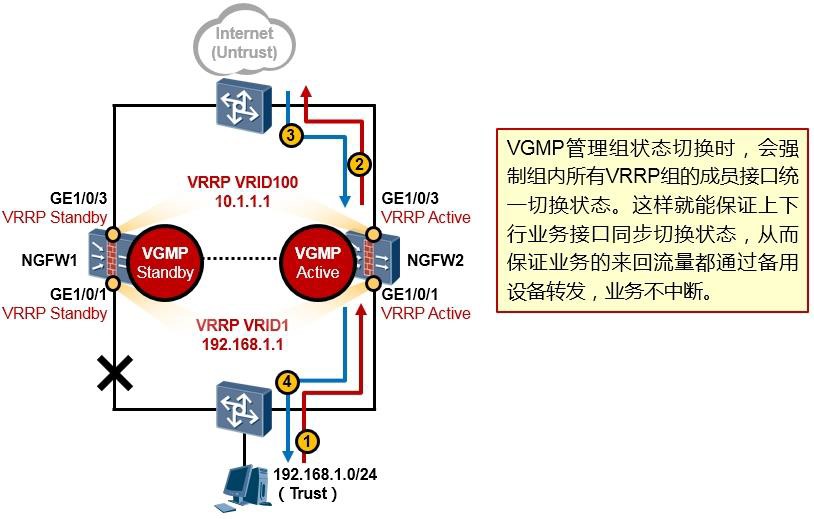

- 防火墙双机热备概述 375

- 防火墙双机热备基础 377

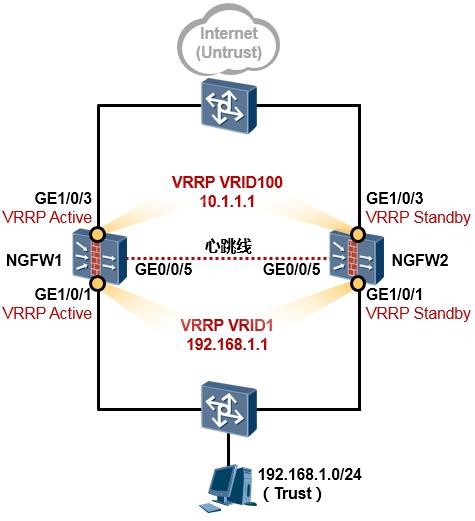

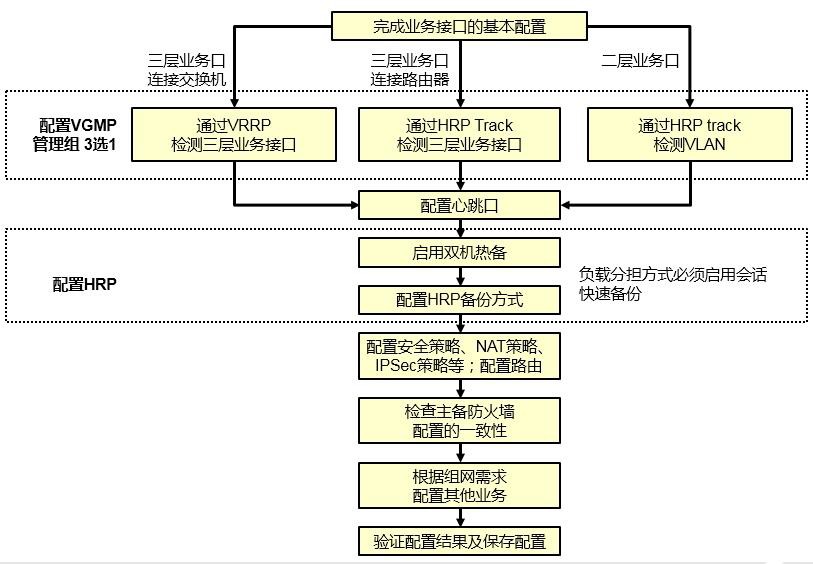

- 防火墙双机配置步骤 383

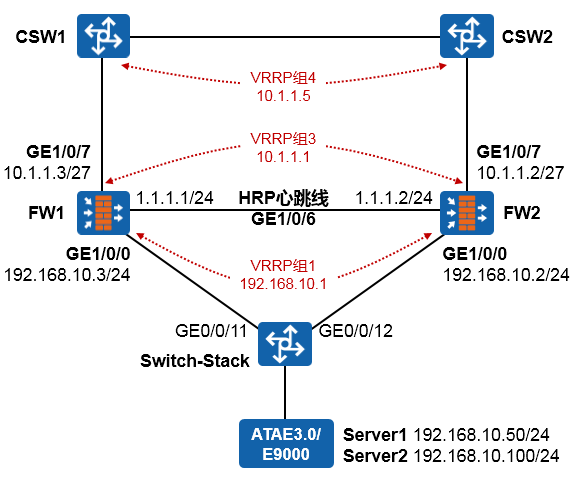

- 配置案例1:防火墙双机主备配置(上下行连接交换机并在物理接口部署VRRP) 383

- 与防火墙双机热备相关的其他命令 390

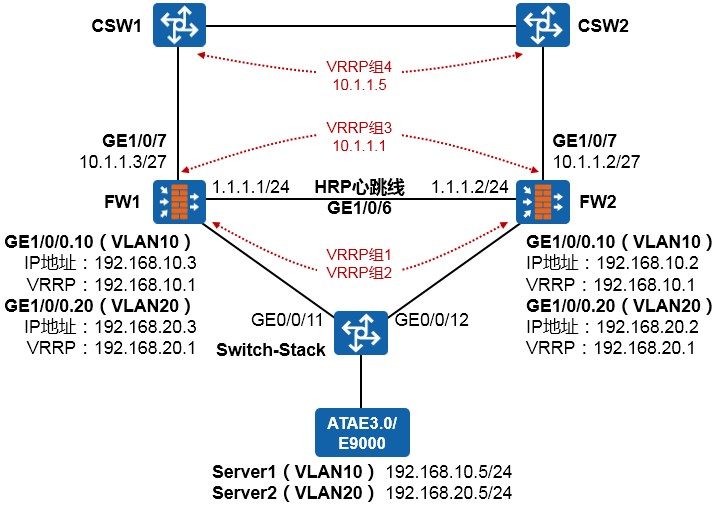

- 配置案例2:防火墙双机主备配置(上下行连接交换机并在下行子接口部署VRRP) 391

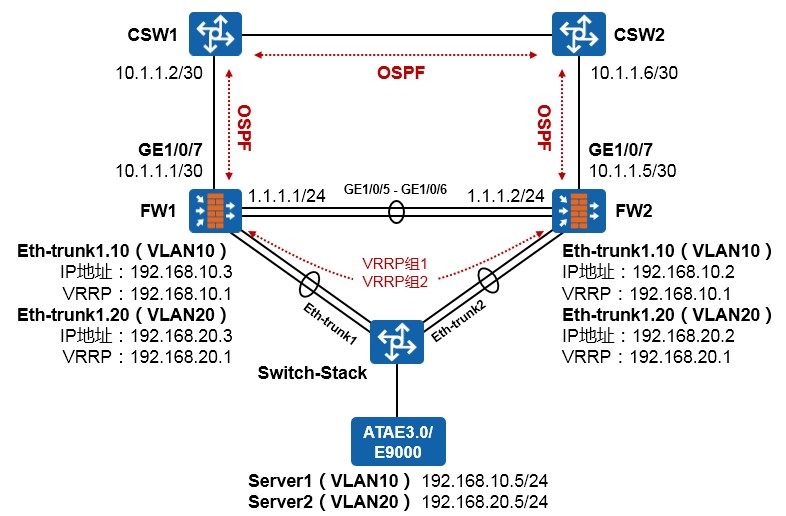

- 配置案例3:防火墙双机主备配置(上下行连接交换机并在下行Eth-trunk子接口部署VRRP) 395

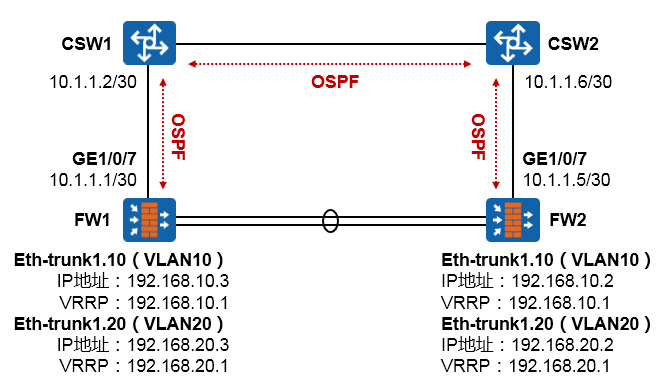

- 配置案例4:防火墙双机主备配置(下行连接内部交换机并在Eth-trunk子接口部署VRRP、上行连接外部交换机并运行OSPF) 401

- 防火墙双机配置注意事项 410

- 防火墙常见问题 411

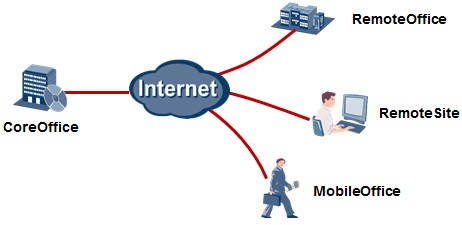

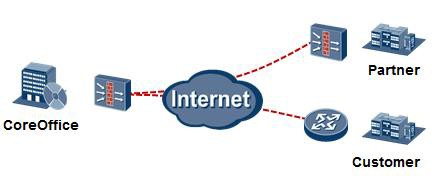

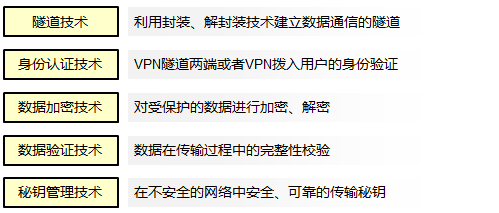

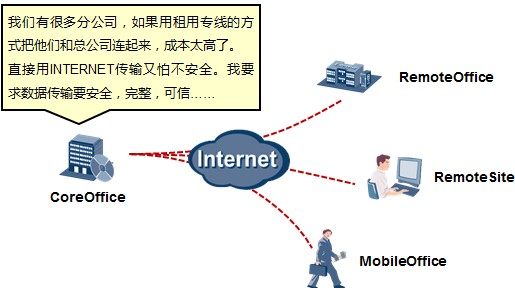

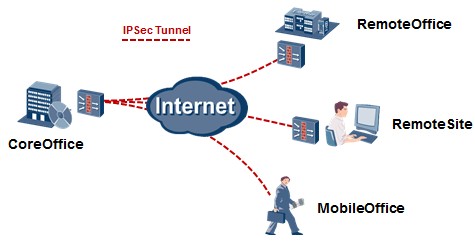

7.6 VPN 415

7.6.1 VPN基础知识 415

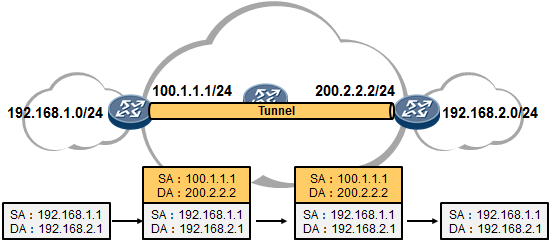

7.6.2 GRE 420

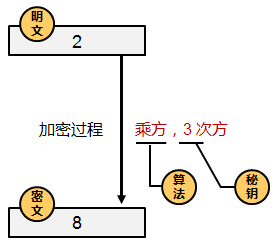

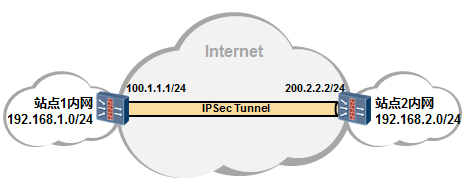

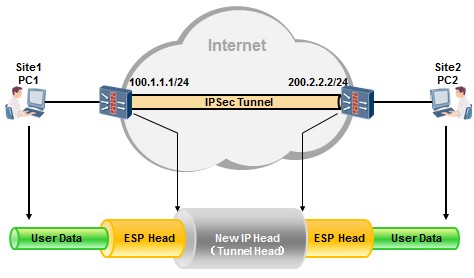

7.6.3 IPSecVPN 423

-

-

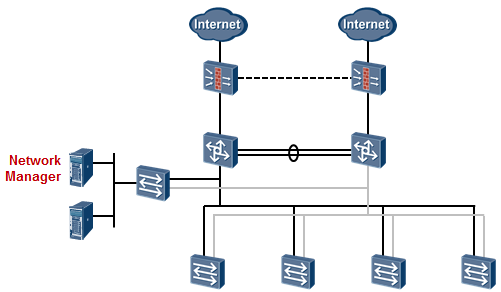

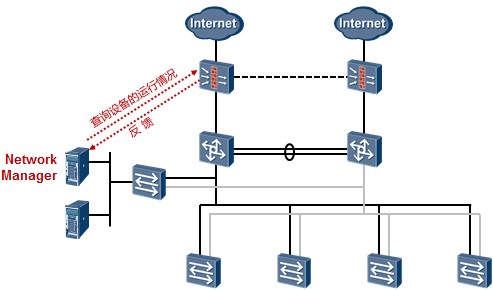

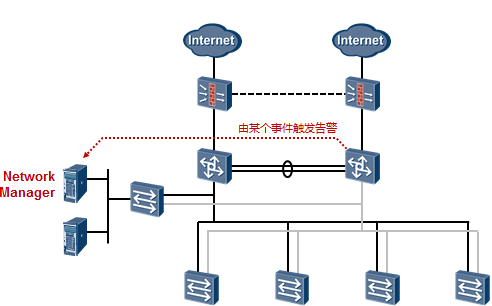

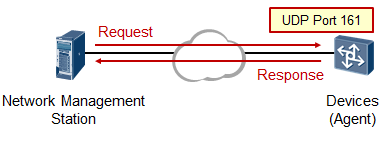

网络管理 483

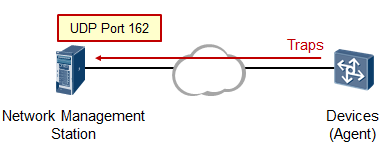

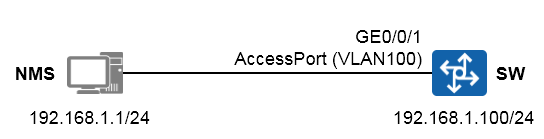

- SNMP 483

- SNMPv3的基础配置 487

- NTP的基础配置 489

-

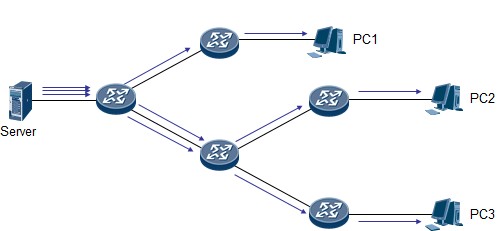

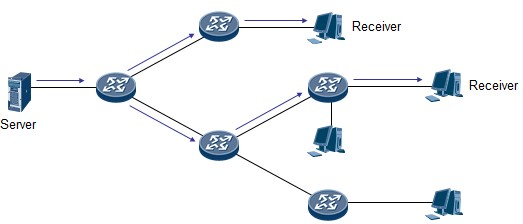

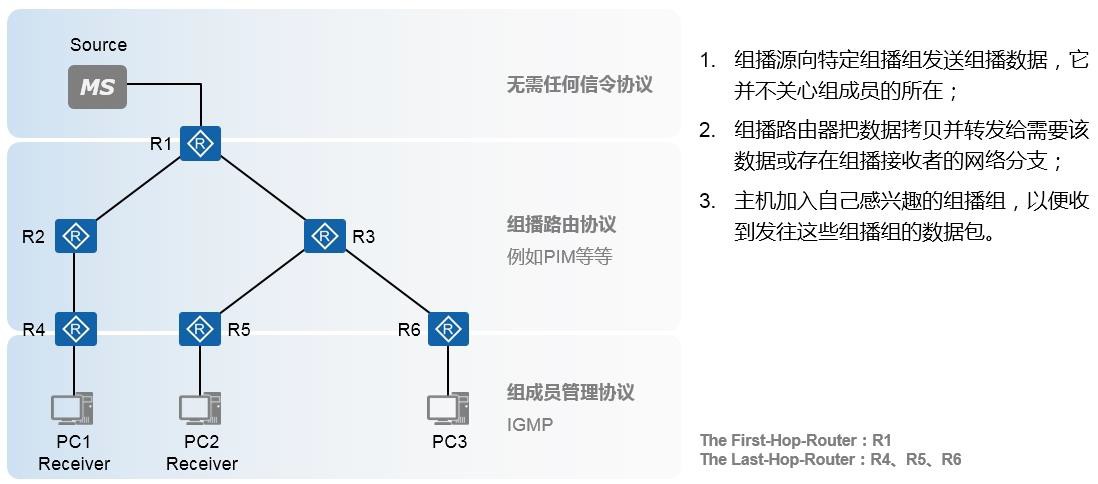

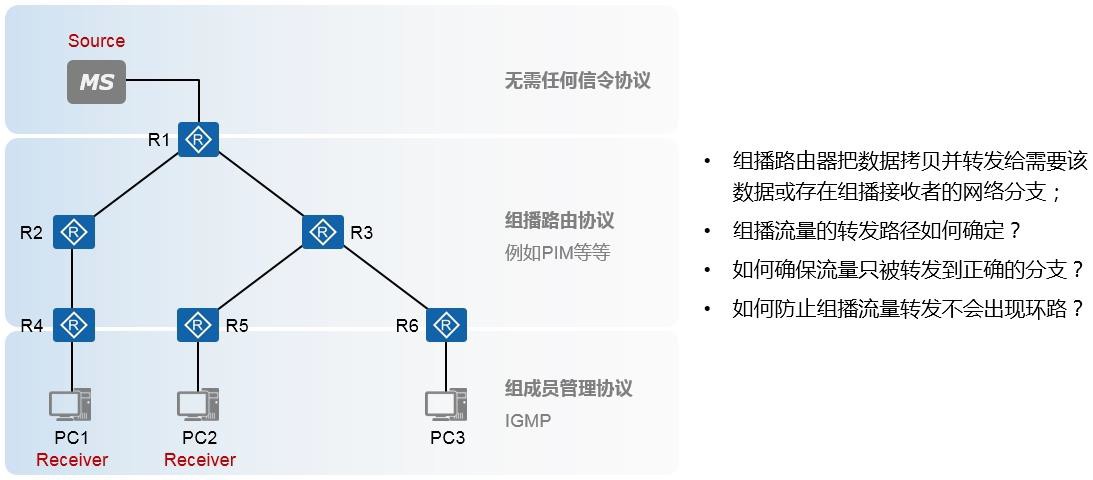

组播技术 490

- 组播基础 490

- 组播概述 490

- 组播模型 492

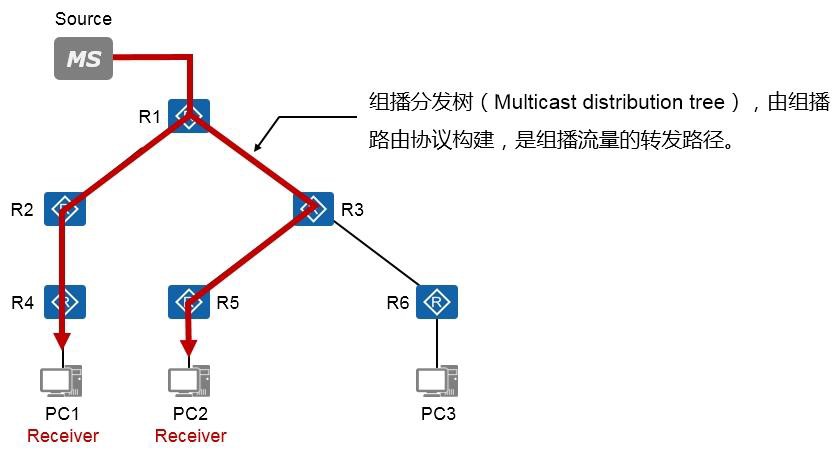

- 组播分发树 493

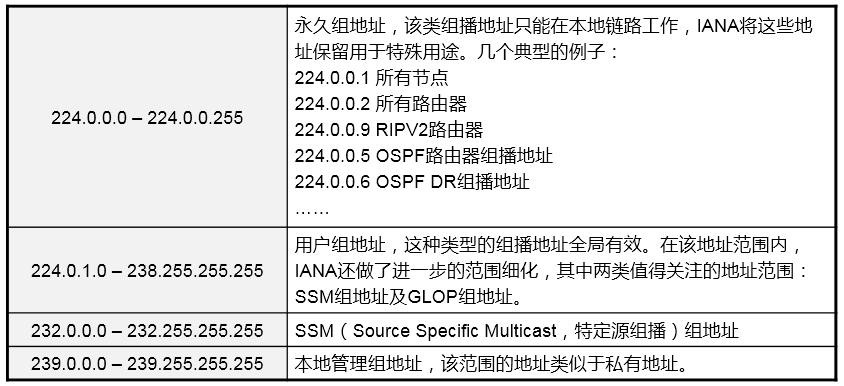

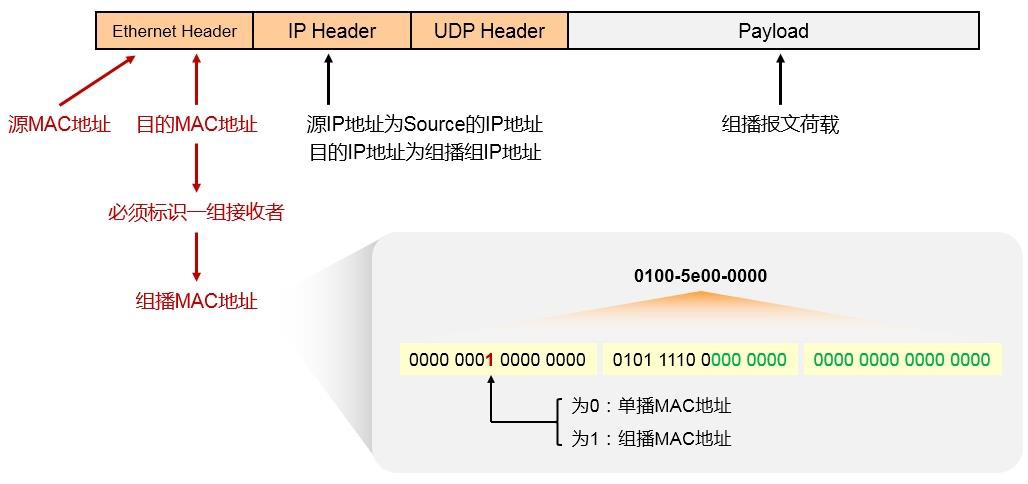

- 组播地址 493

-

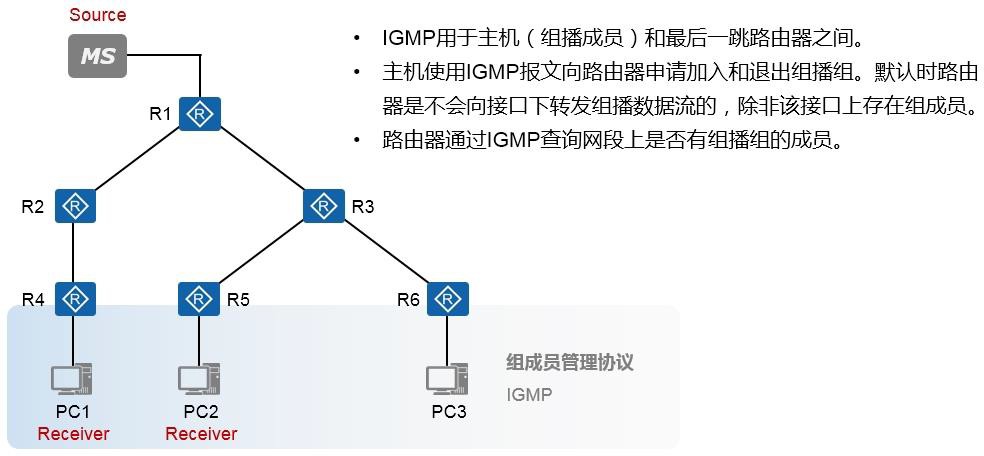

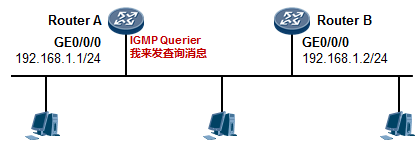

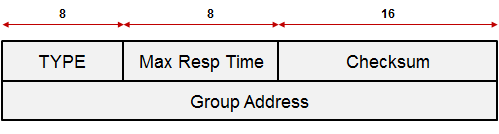

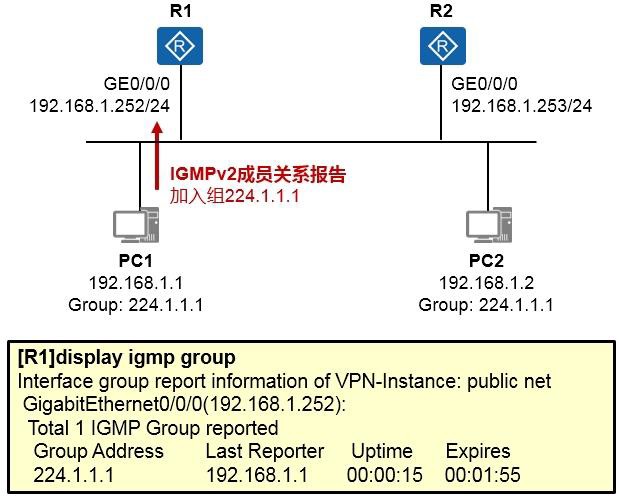

IGMP 496

-

IGMP概述 496

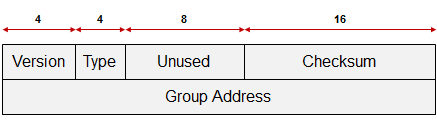

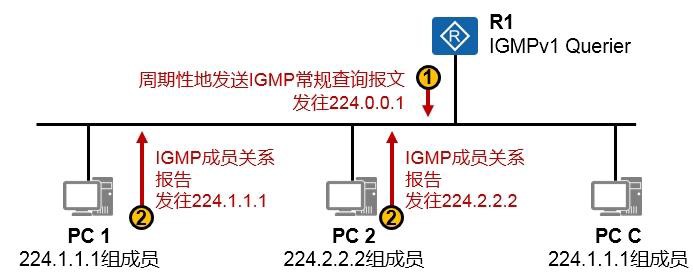

9.2.2 IGMPv1(RFC1112) 497

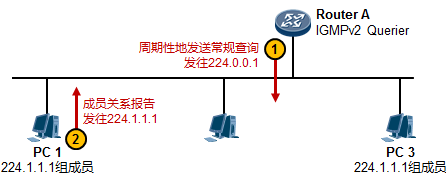

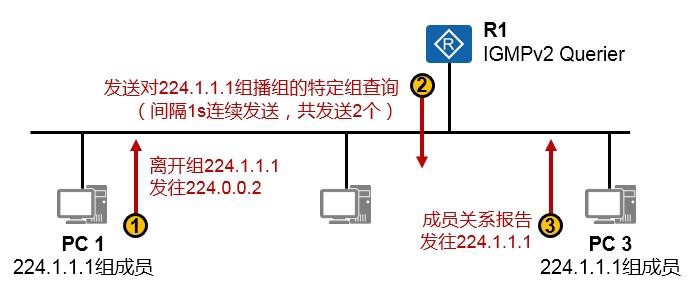

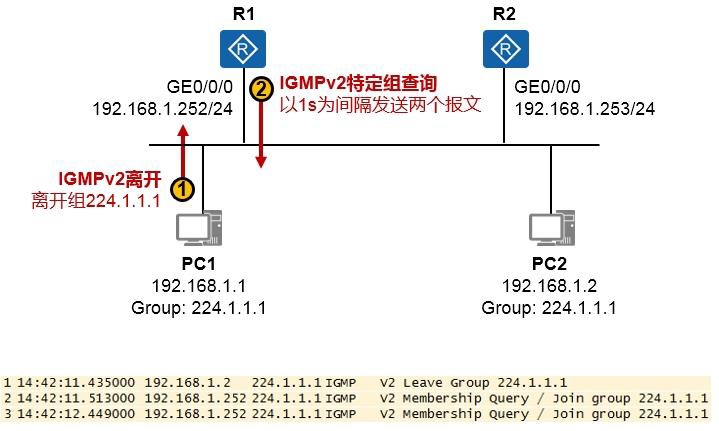

9.2.3 IGMPv2(RFC2236) 499

9.2.4 IGMP配置及实现 503

-

-

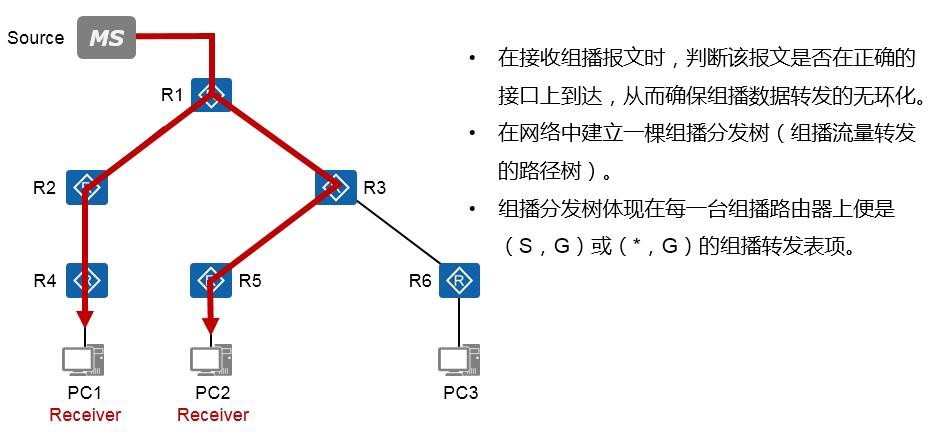

组播路由协议概述 507

- 关于组播路由协议 507

- 组播路由表项 508

-

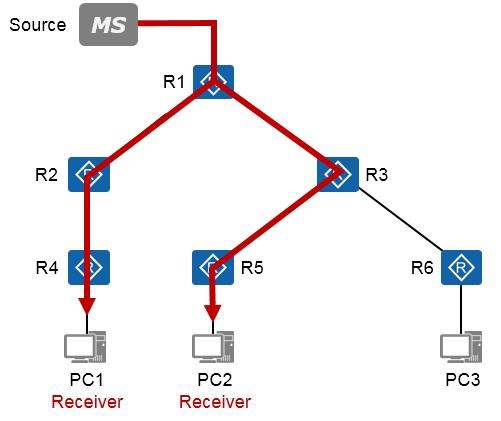

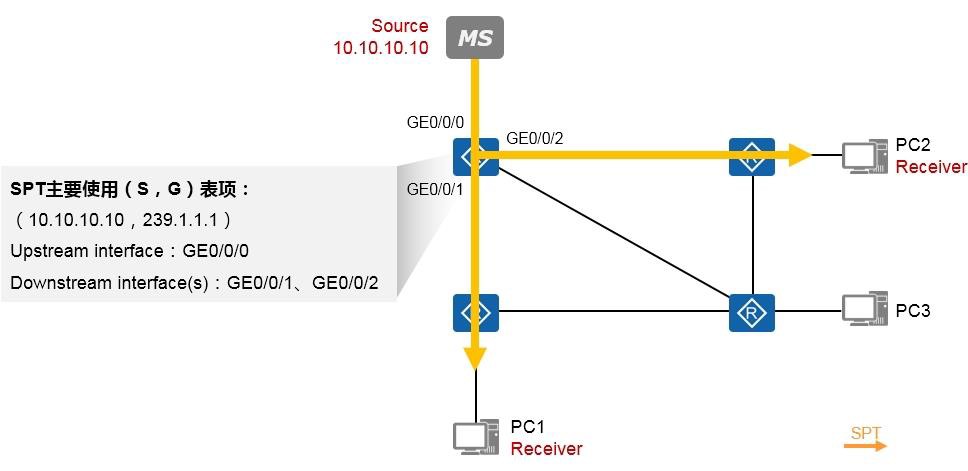

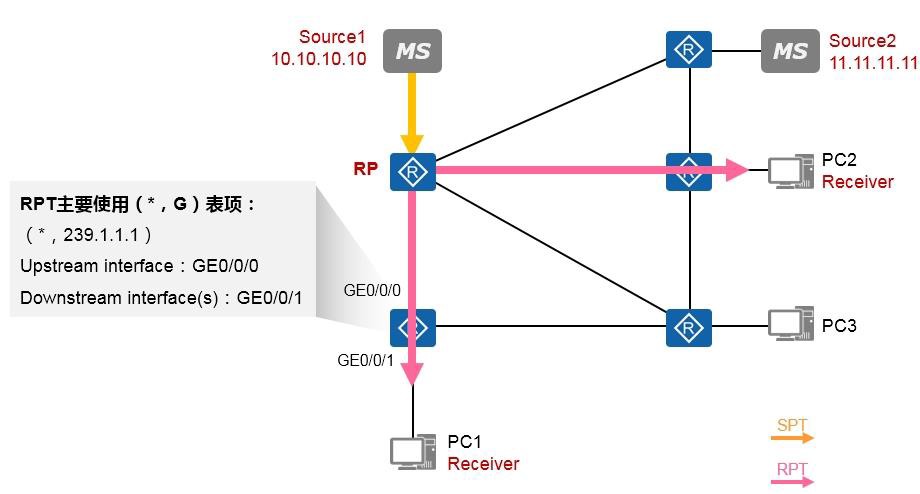

组播分发树 509

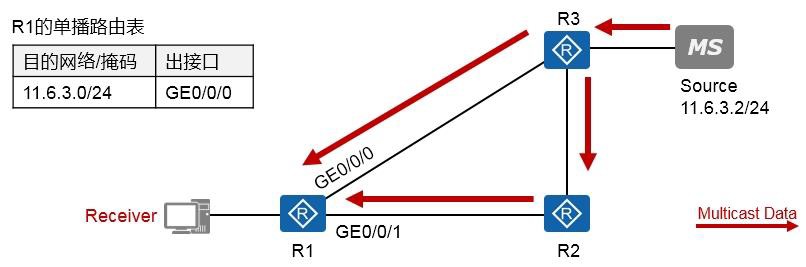

9.3.4 RPF 510

-

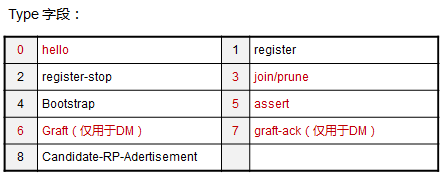

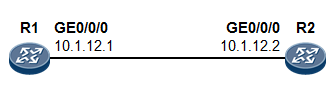

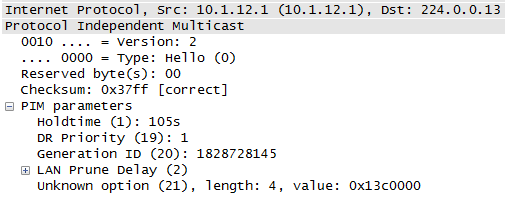

PIM概述 511

- PIM-DM 512

- 协议概述 512

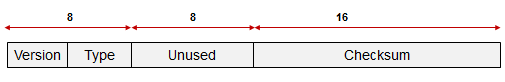

- 协议报文 512

- 邻居关系 513

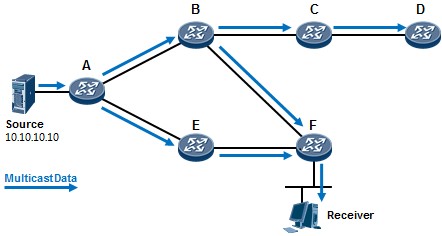

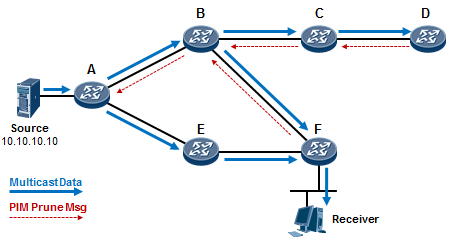

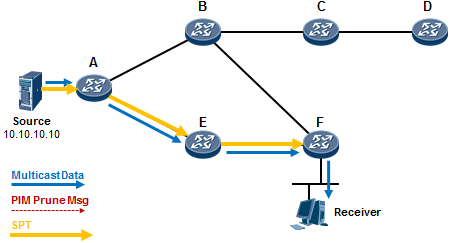

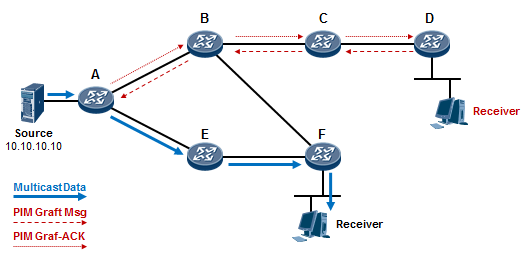

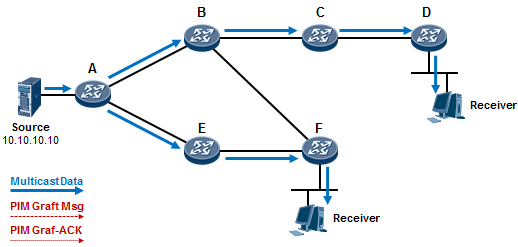

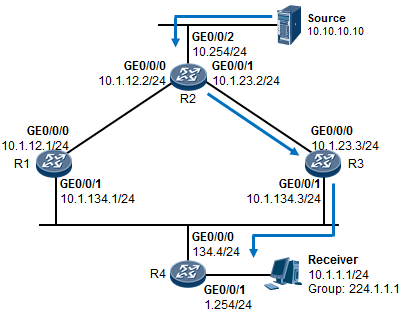

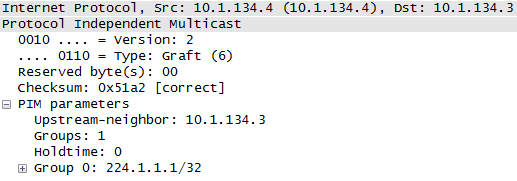

- 扩散(Flood)、剪枝(Prune)及嫁接(Graft) 514

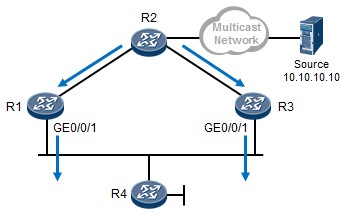

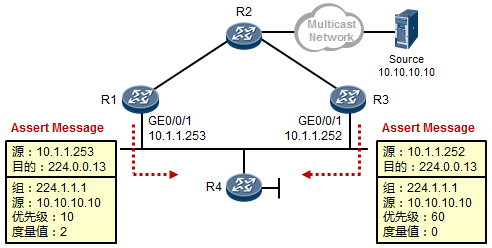

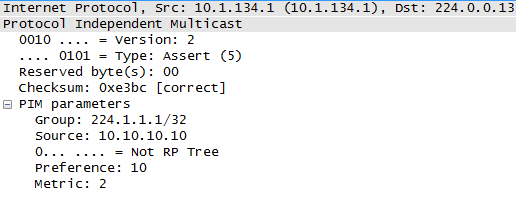

- Assert断言机制 518

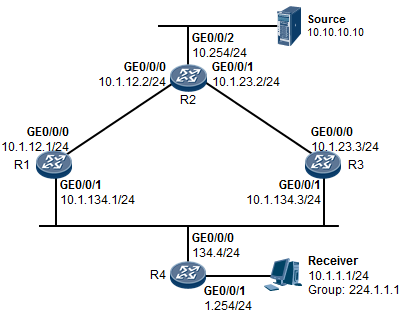

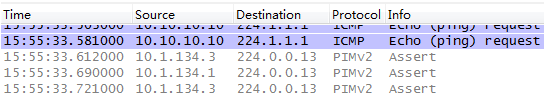

- 配置示例 519

- PIM-SM 526

- 基础知识 526

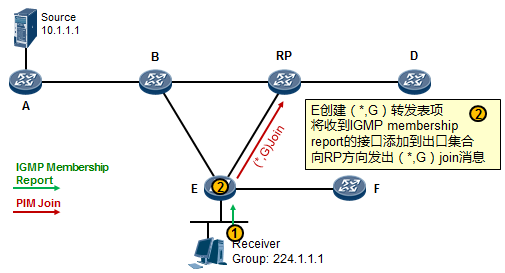

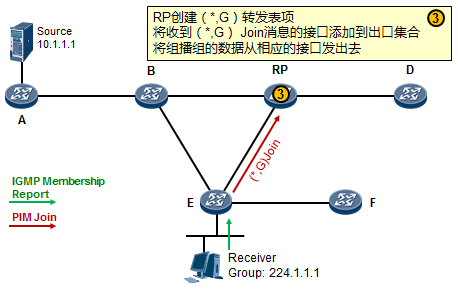

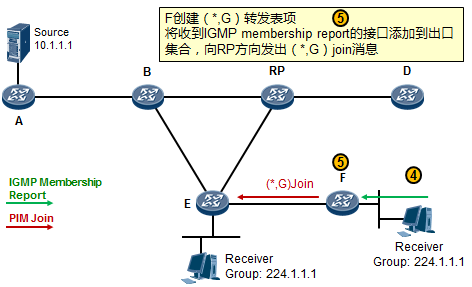

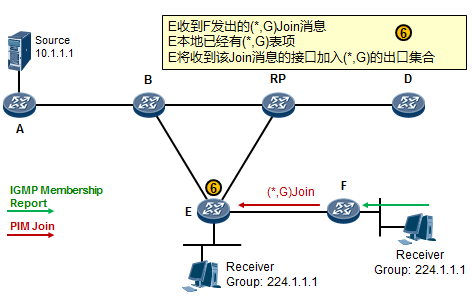

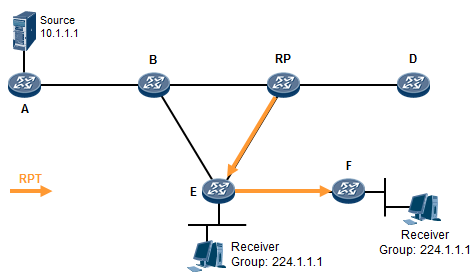

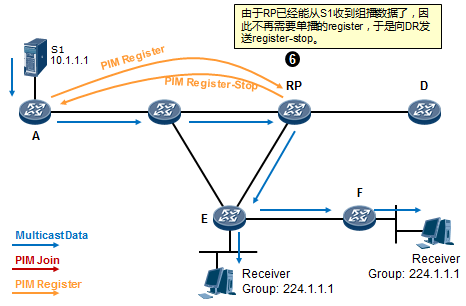

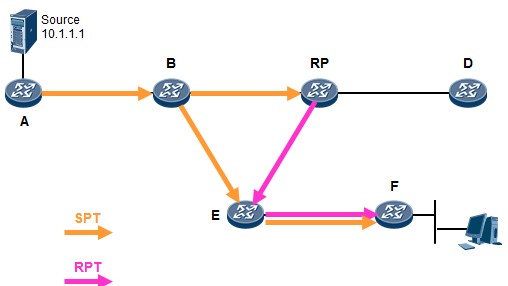

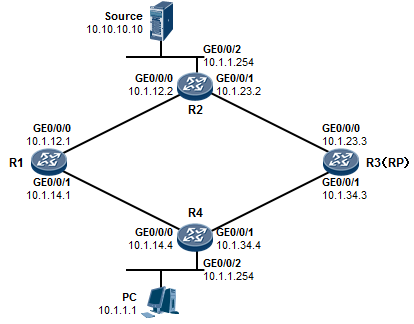

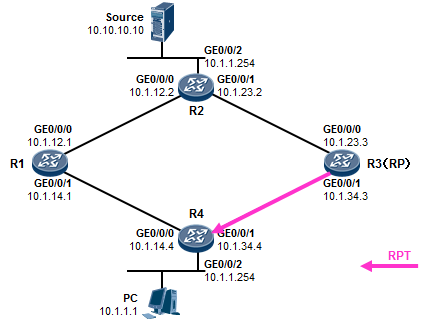

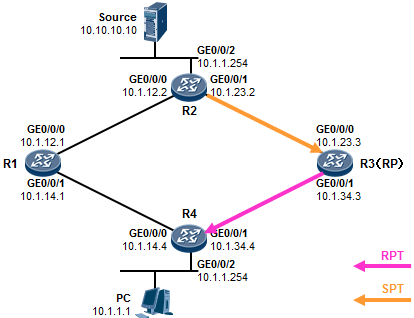

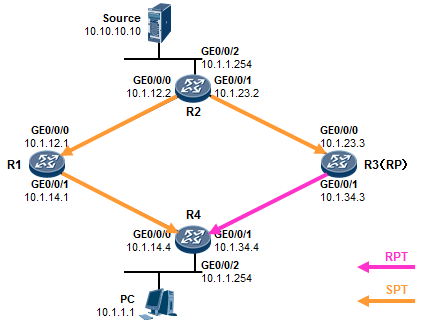

- 工作机制1:共享树加入 527

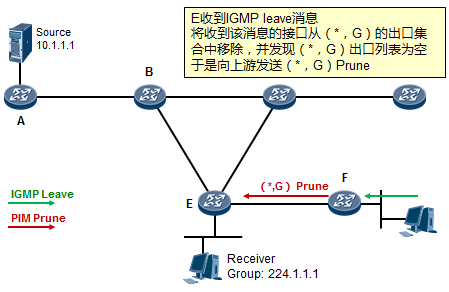

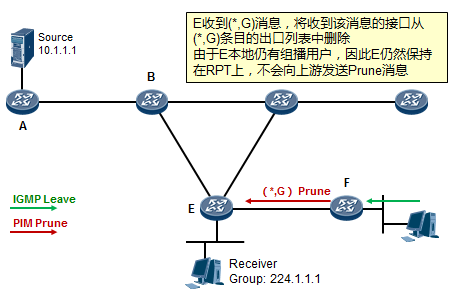

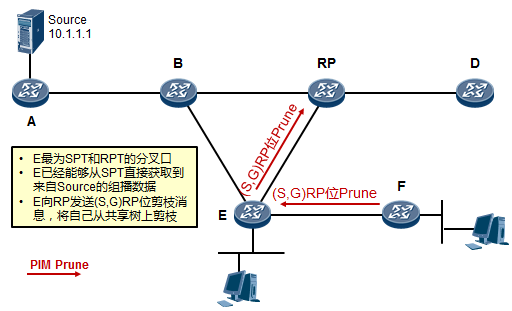

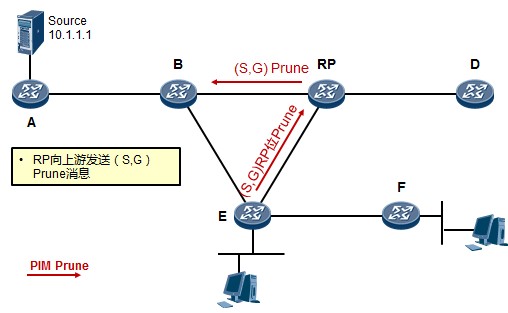

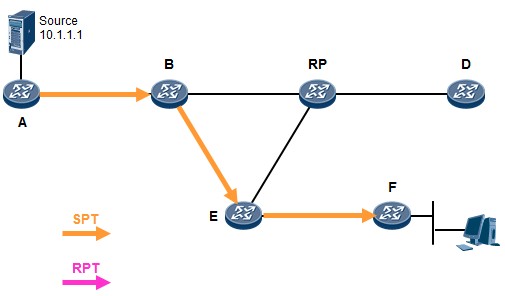

- 工作机制2:共享树剪枝 529

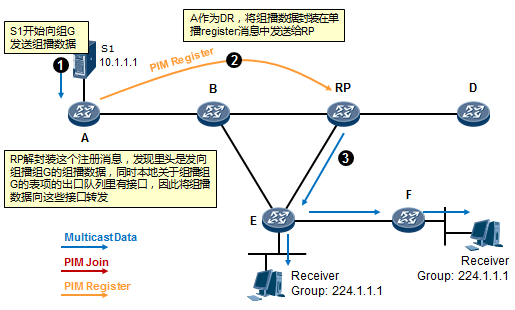

- 工作机制3:源注册 531

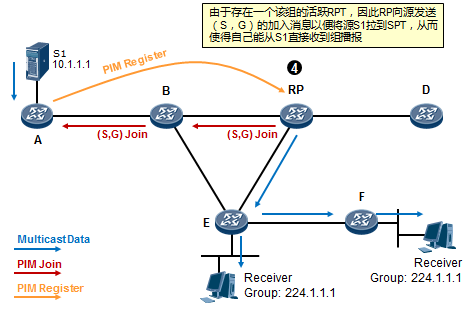

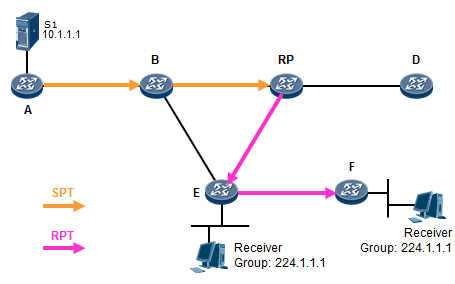

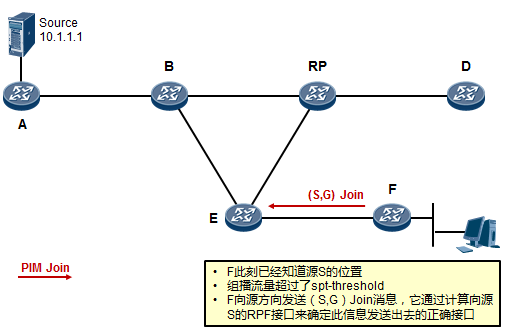

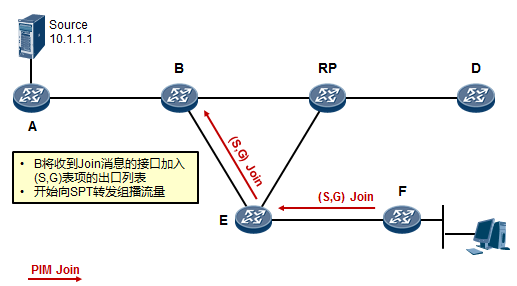

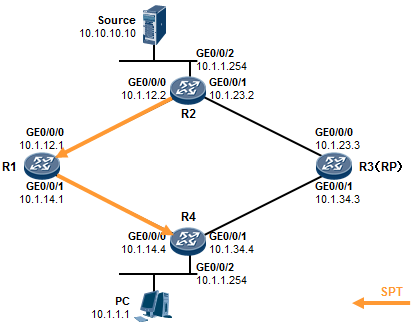

- 工作机制4:RPT到SPT的切换 534

- PIM-SM DR指定路由器 537

- 配置示例 538

- IPv6基础 548

10.1 IPv6 基础 548

10.1.1 概述 548

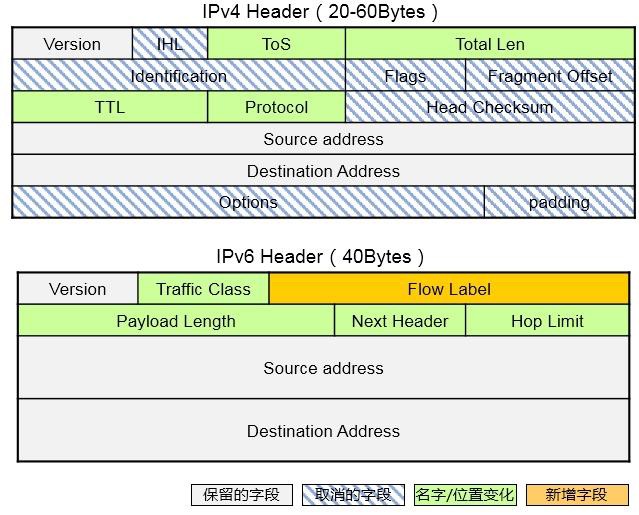

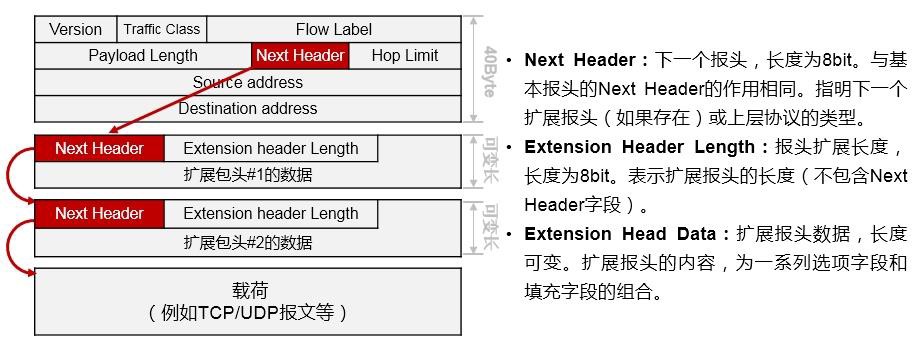

10.1.2 报文格式 549

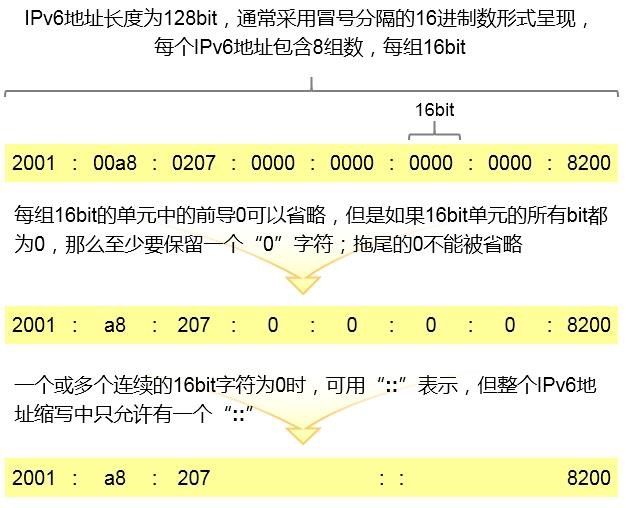

- IPv6编址 551

- IPv6地址 551

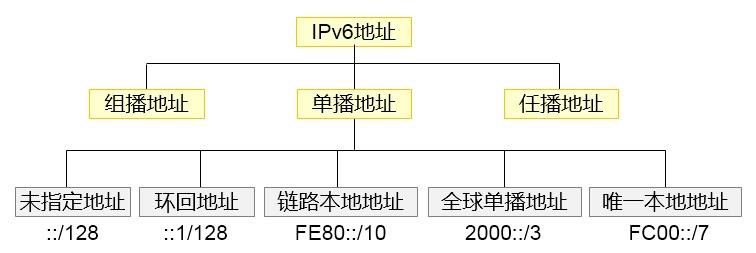

- 地址类型 552

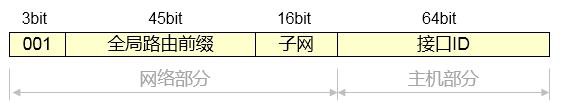

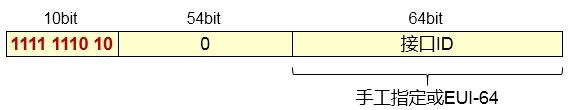

- 单播地址 553

- 接口ID 555

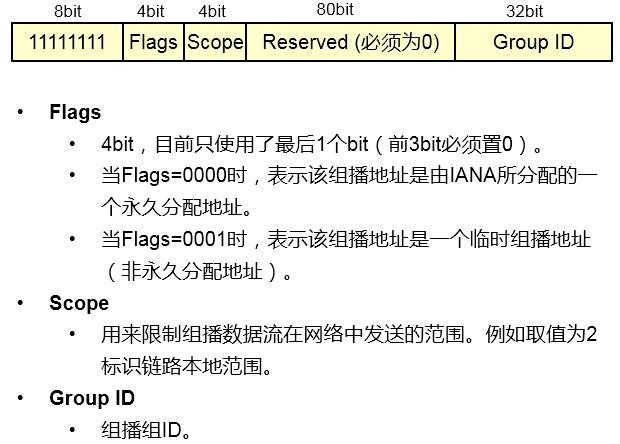

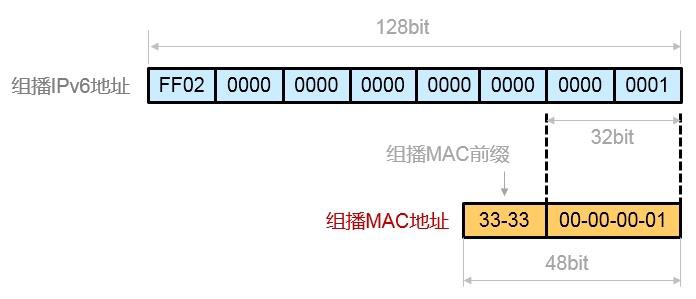

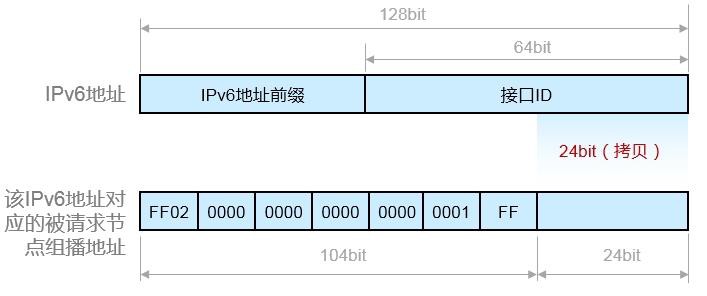

- 组播地址 556

- 基础配置 558

- 基础配置命令 558

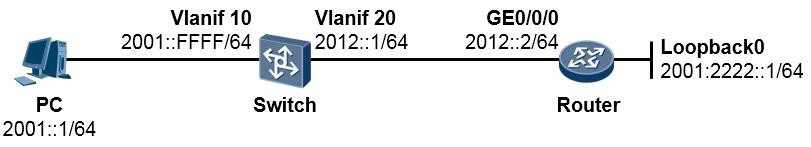

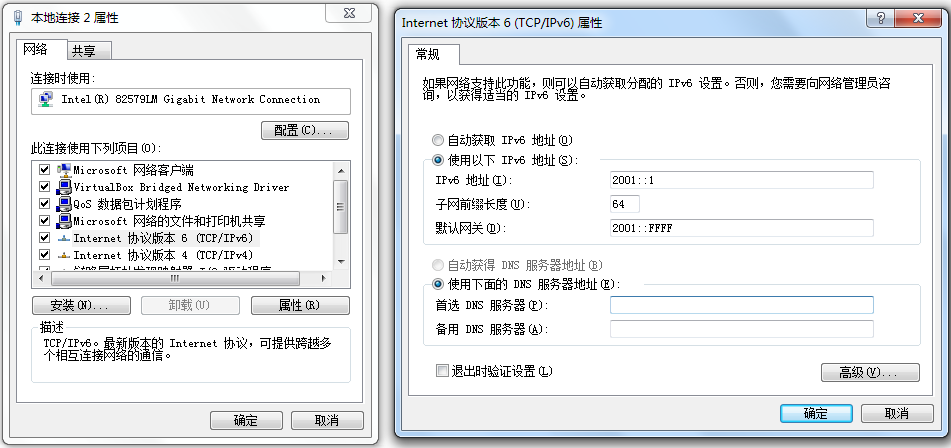

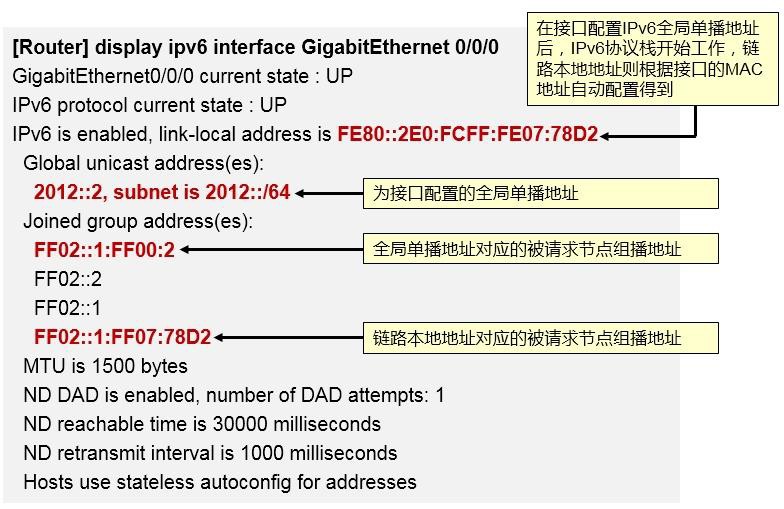

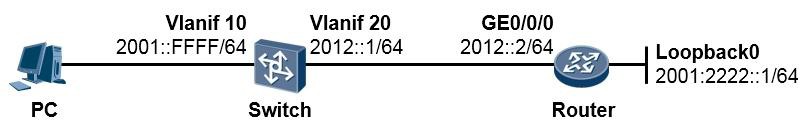

- 实验1:IPv6入门实验 559

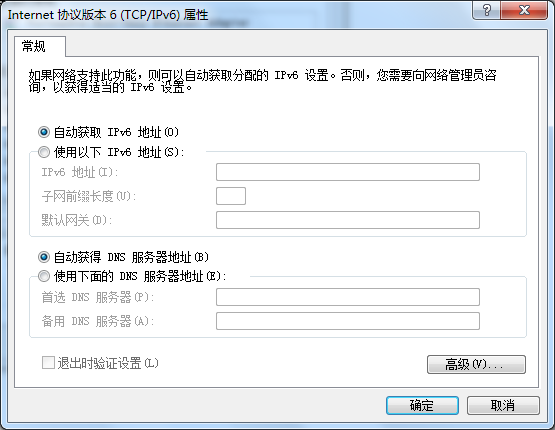

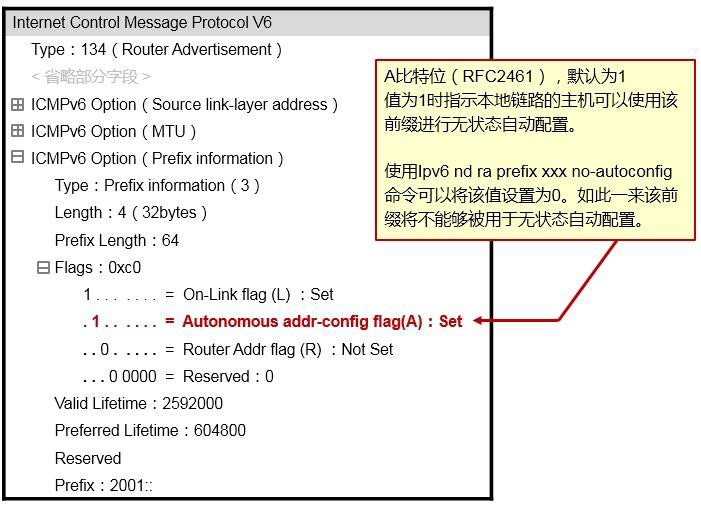

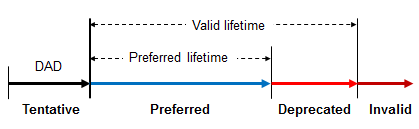

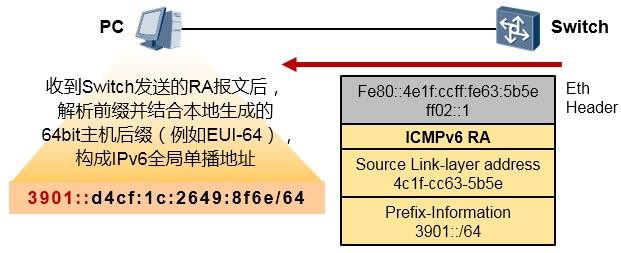

- 实验2:无状态地址自动配置 562

-

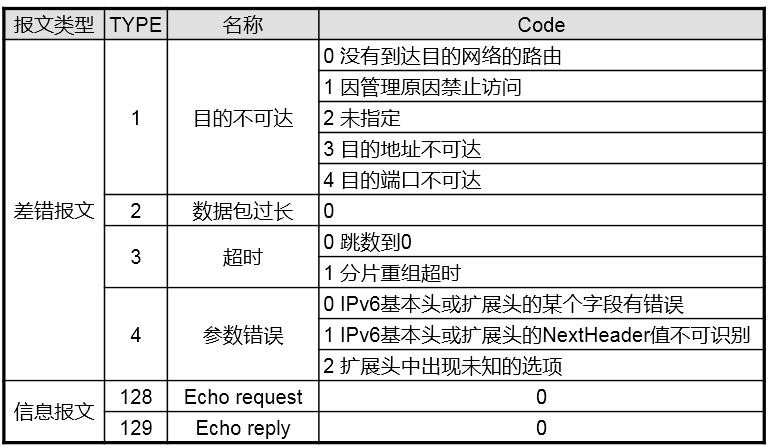

ICMPv6 564

-

ICMPv6概述 564

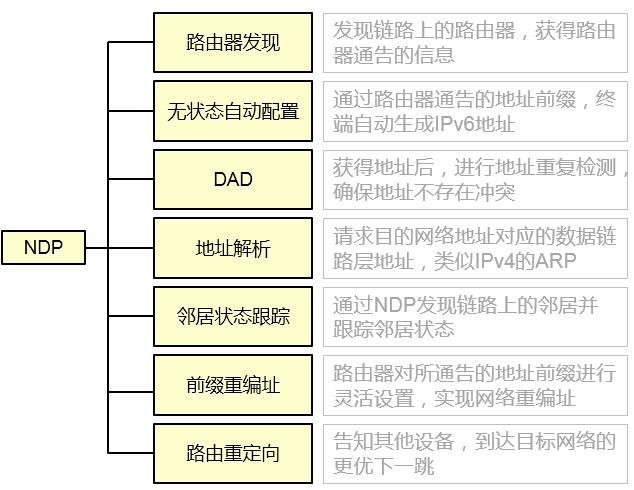

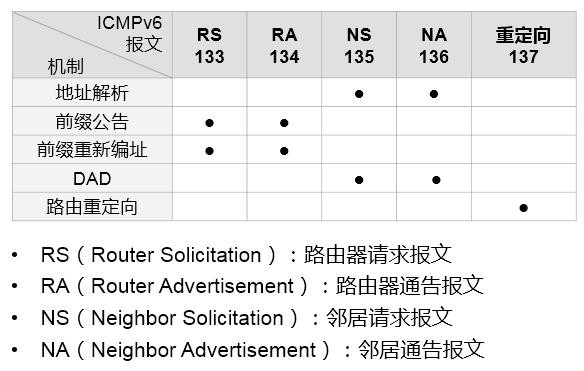

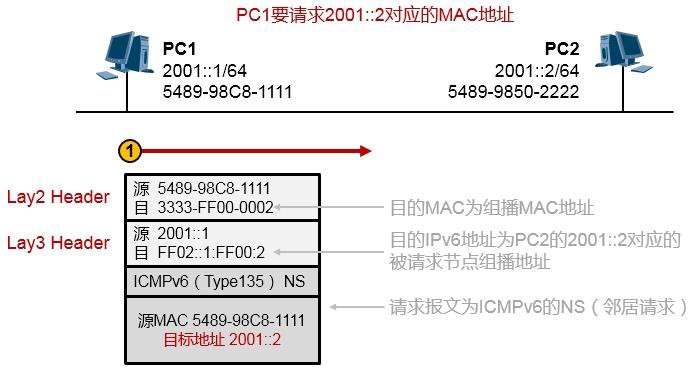

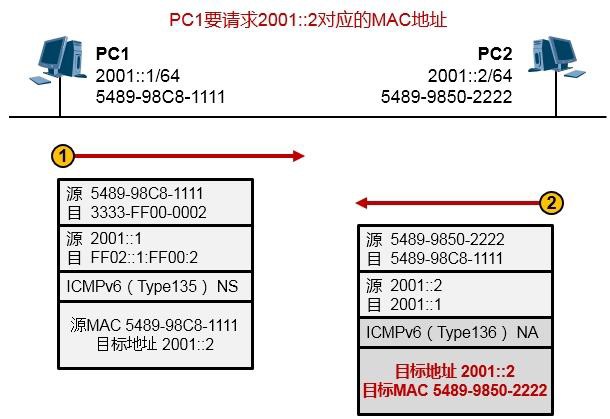

10.4.2 NDP 565

-

-

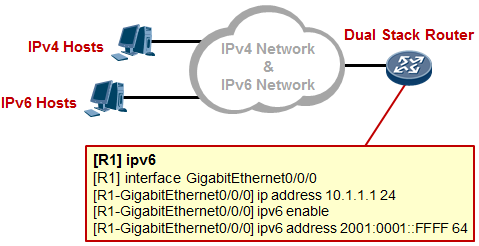

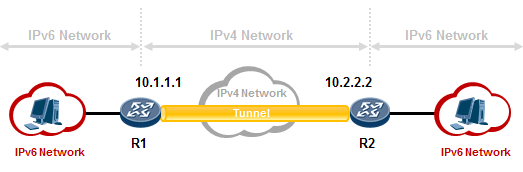

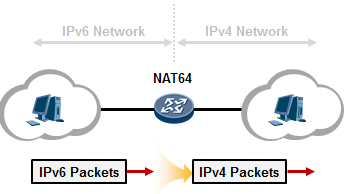

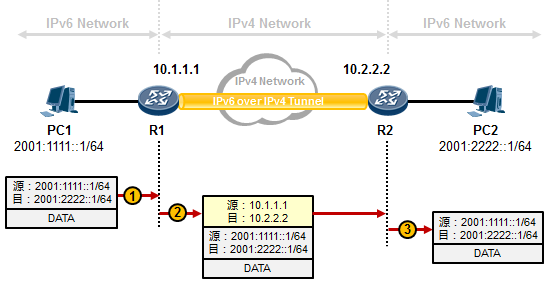

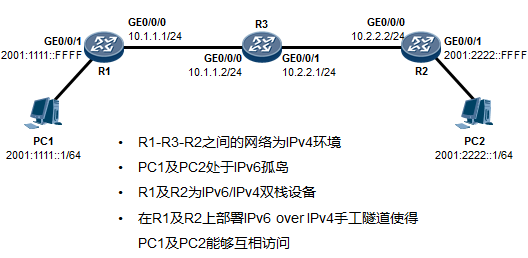

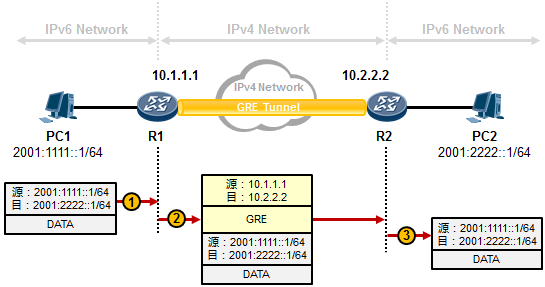

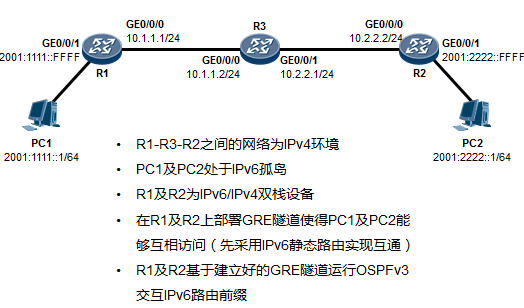

IPv6过渡技术 575

10.5.1 概述 575

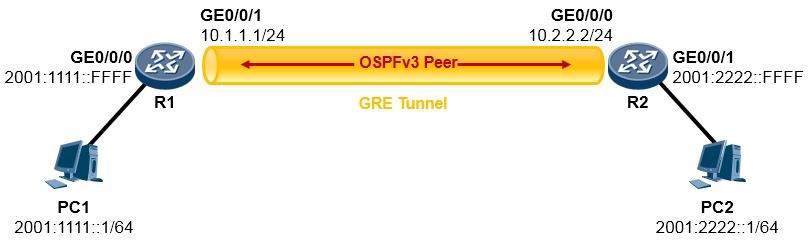

- IPv6 Over IPv4手工隧道 577

- GRE隧道 580

-

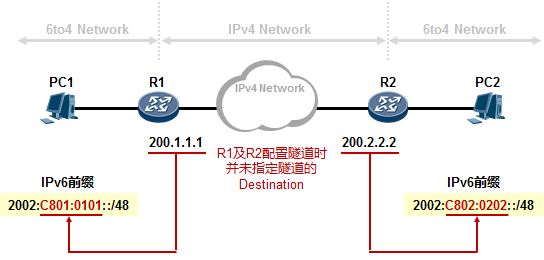

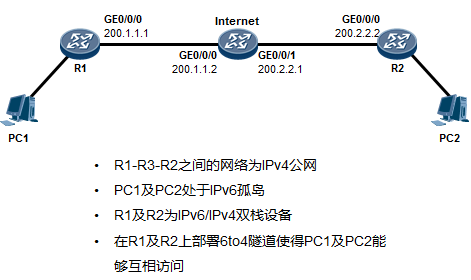

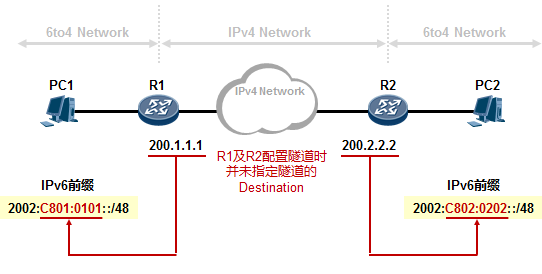

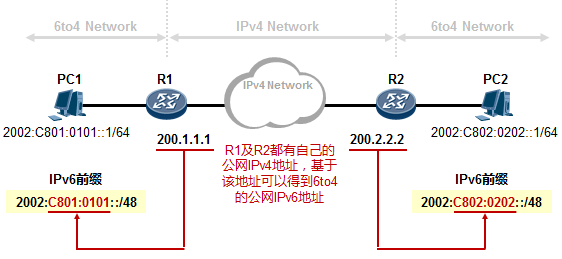

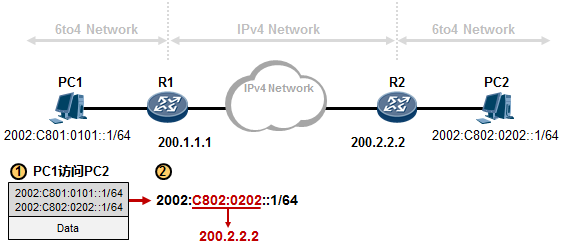

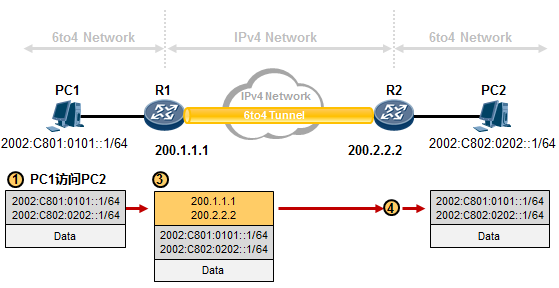

6to4自动隧道 584

10.5.5 NAT64概述 589

-

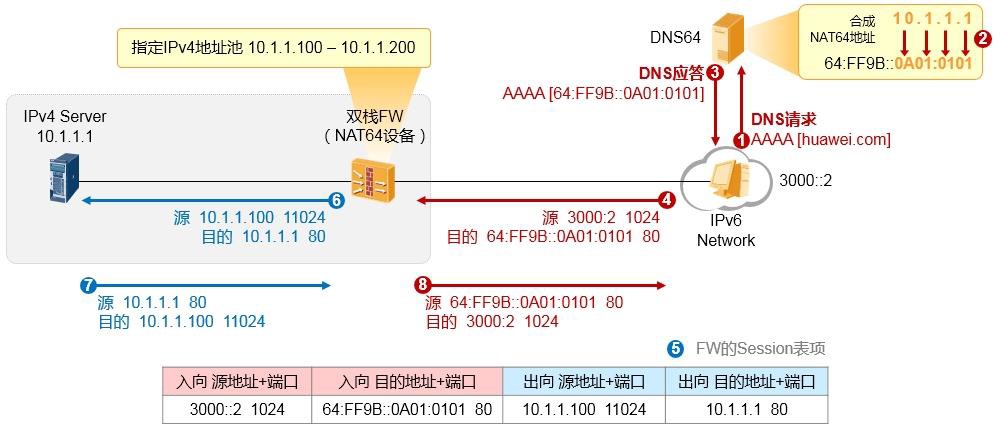

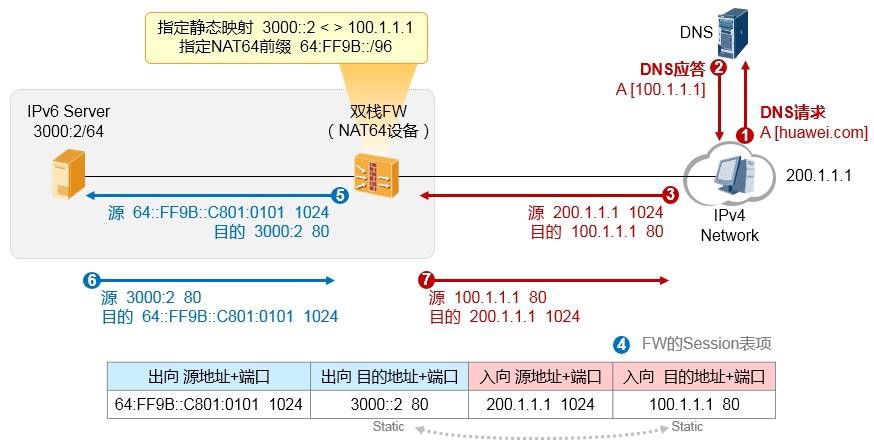

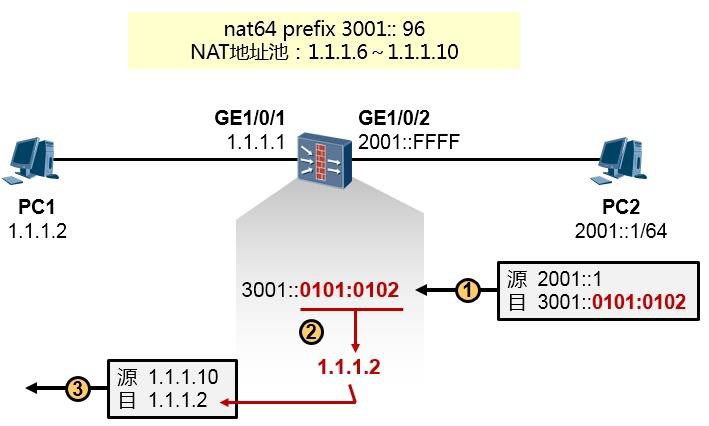

NAT64(IPv6节点主动访问IPv4服务器) 591

- NAT64(IPv4节点主动访问IPv6服务器) 593

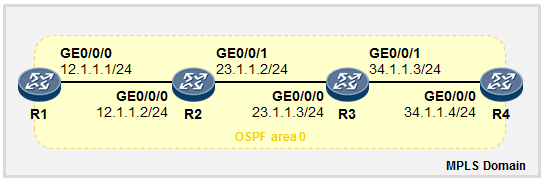

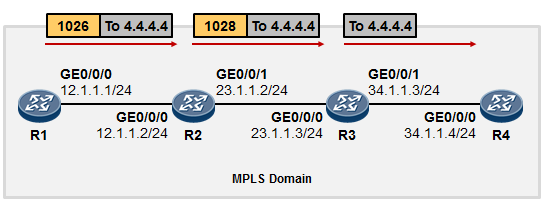

- MPLS与MPLS VPN 595

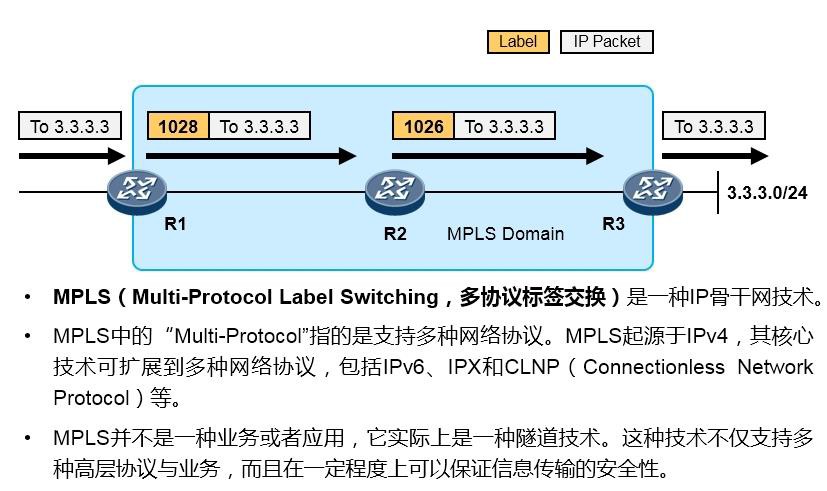

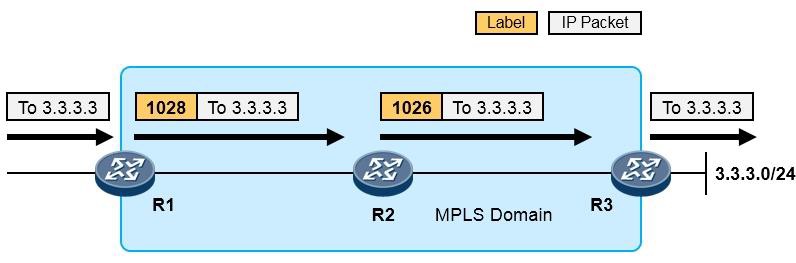

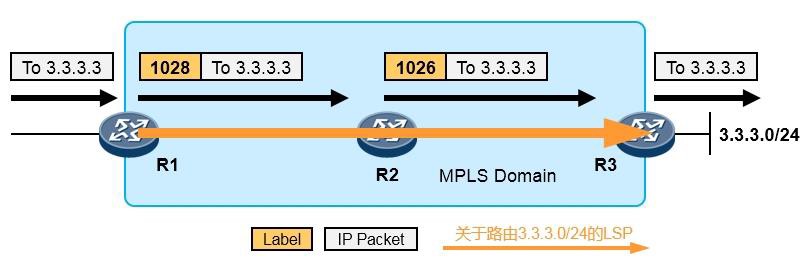

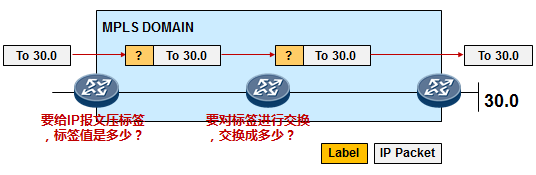

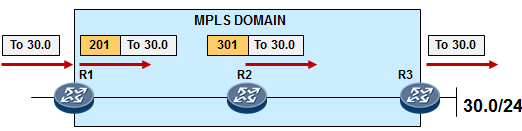

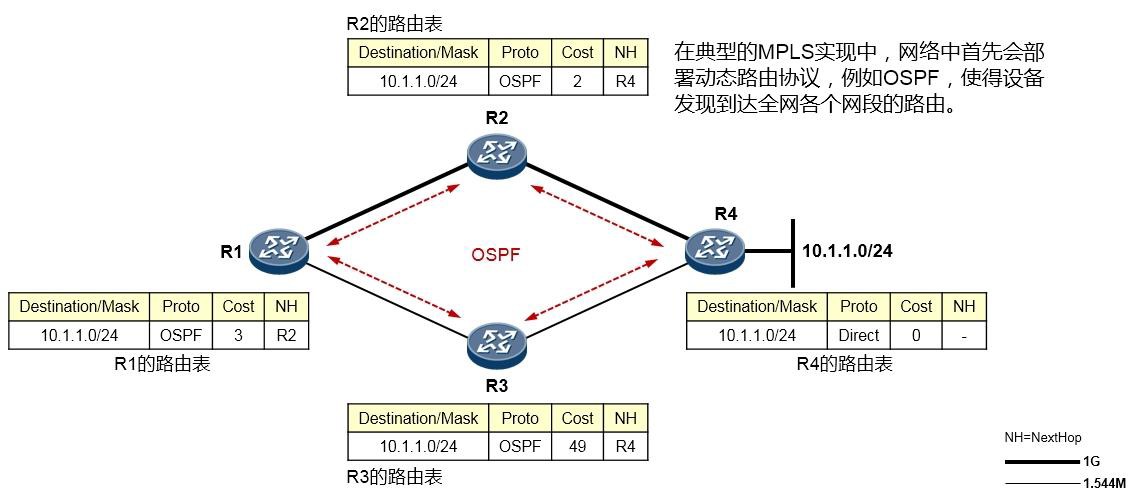

- MPLS基础 595

- MPLS概述 595

- MPLS术语 597

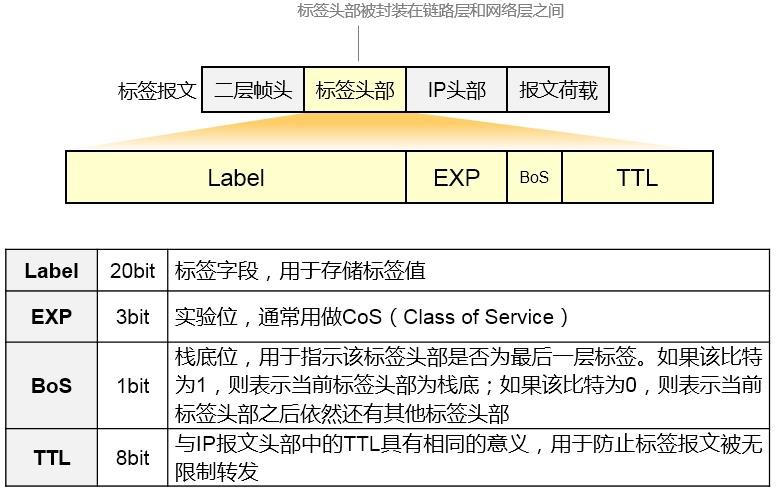

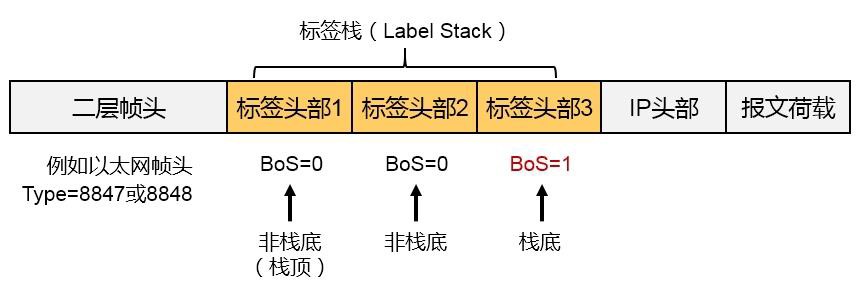

- MPLS标签 599

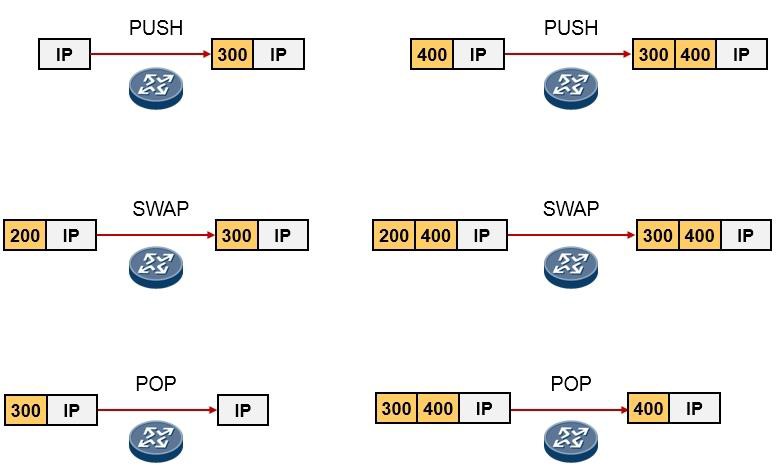

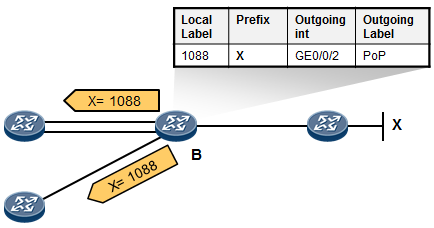

- MPLS标签操作 600

-

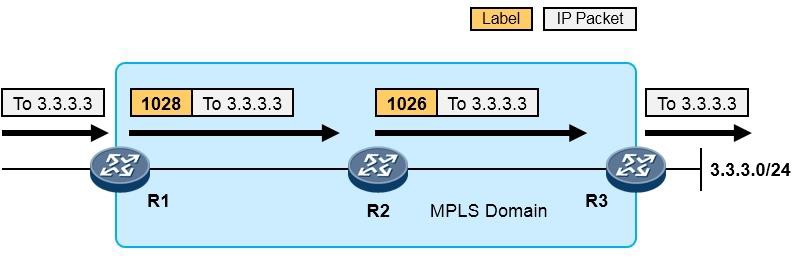

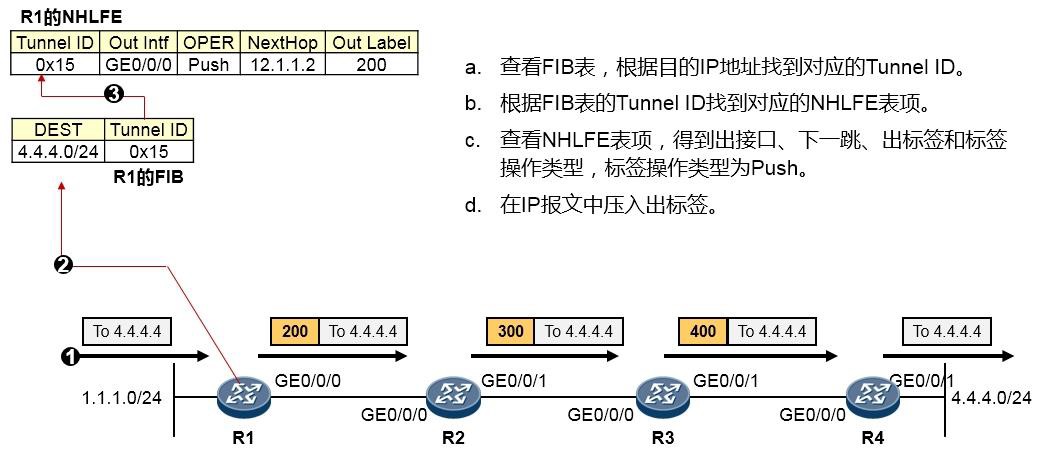

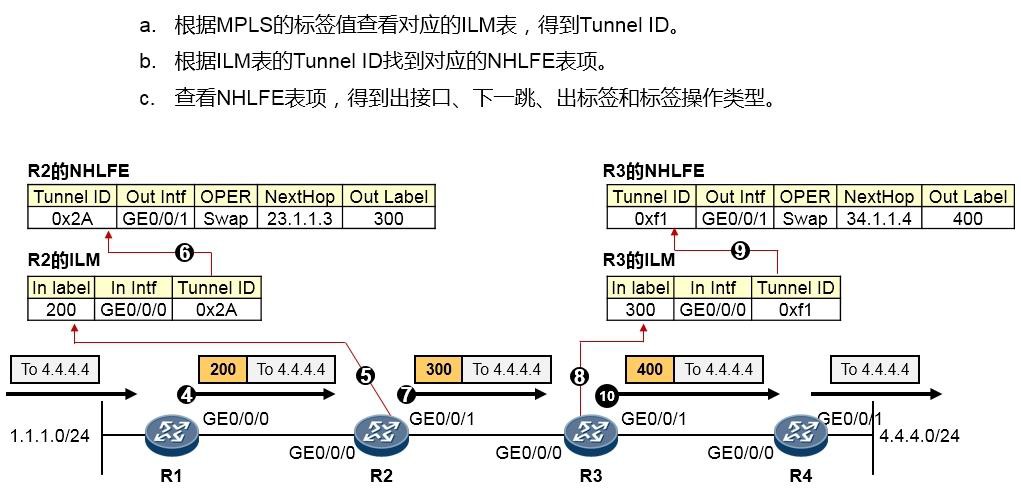

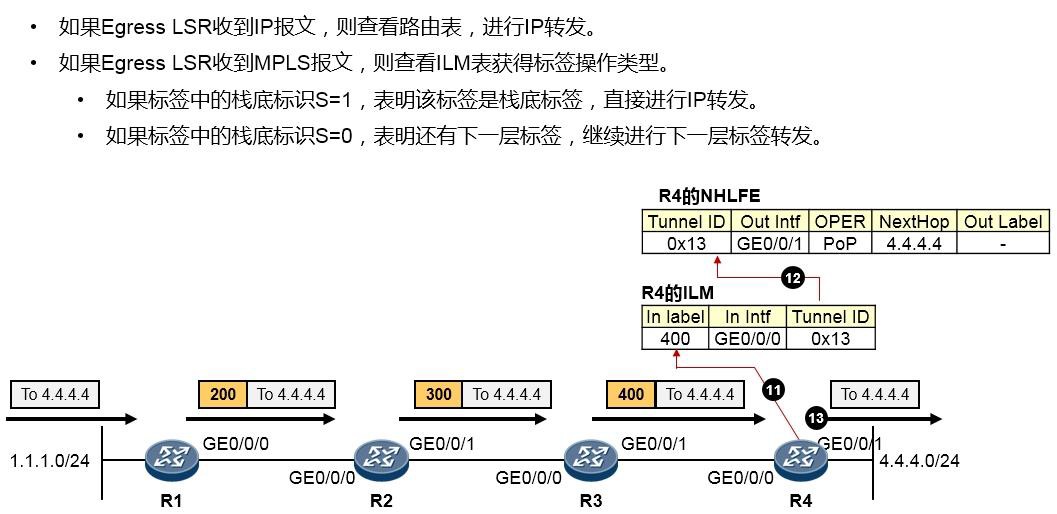

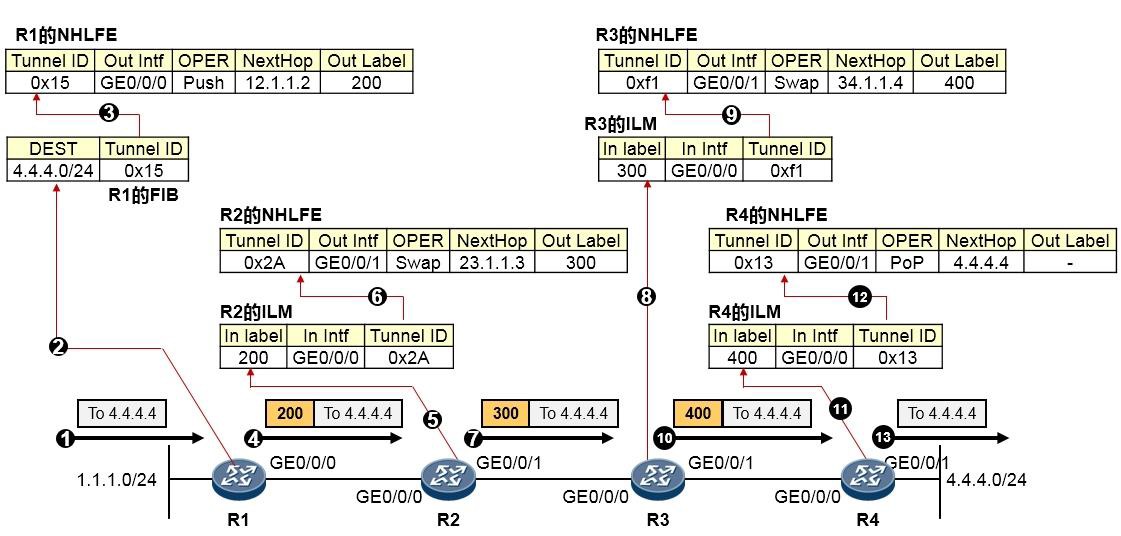

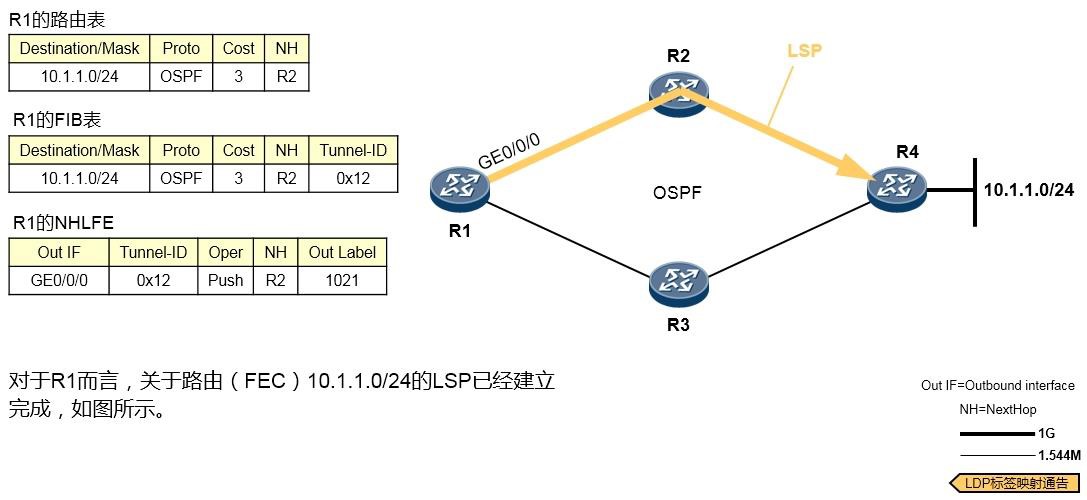

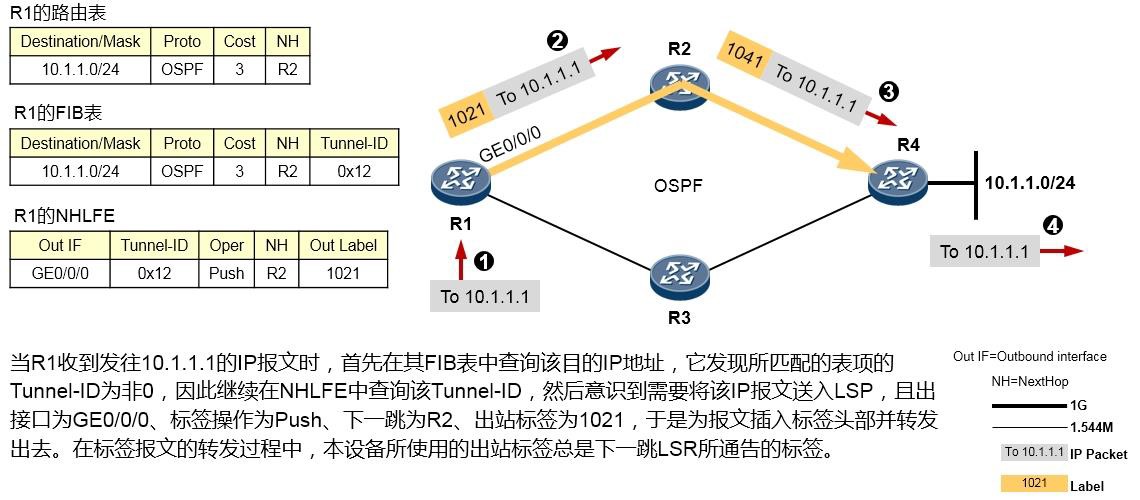

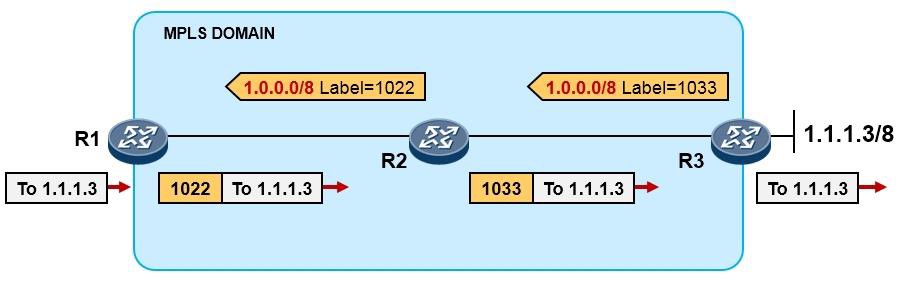

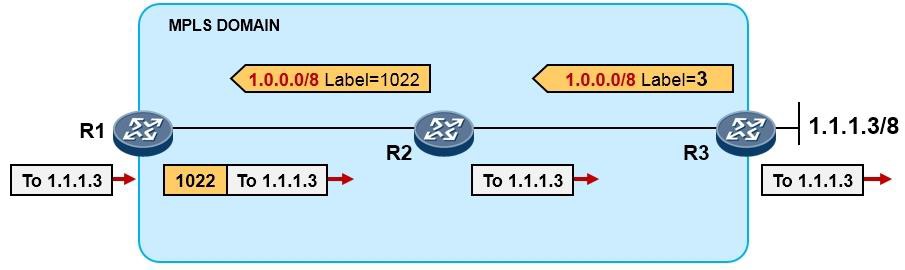

MPLS转发过程详解 601

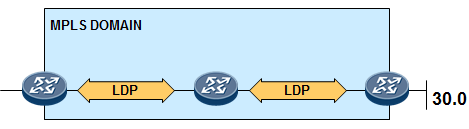

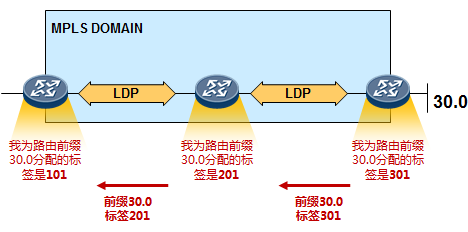

11.2 LDP 604

-

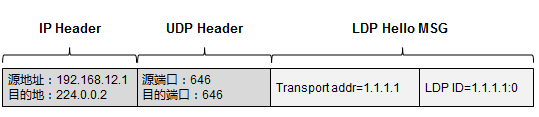

LDP概述 604

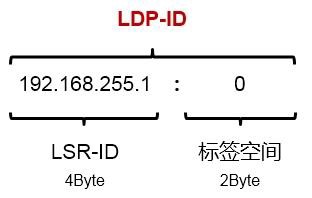

- LDP ID 606

- 标签空间 606

- 传输地址 607

-

LDP的基本工作过程 607

11.2.6 PHP 611

-

MPLS的基础配置 613

- 基础命令 613

- 基础实验 614

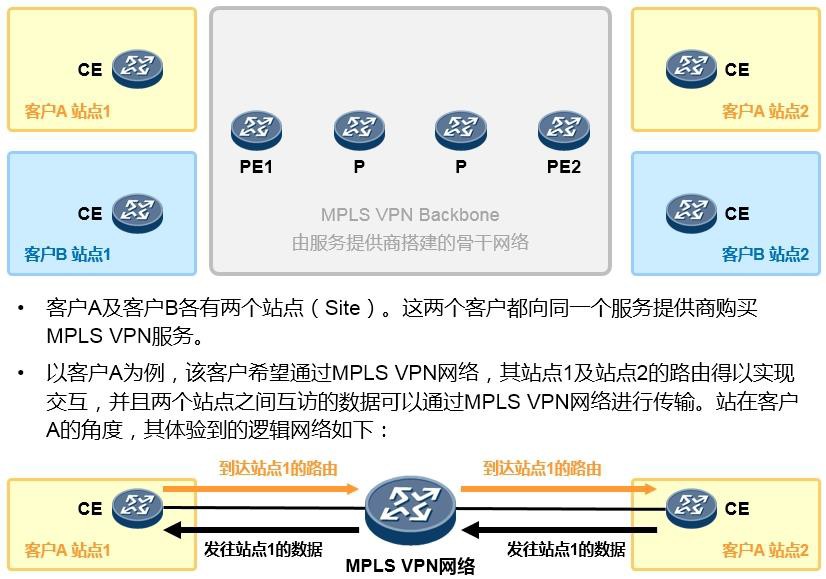

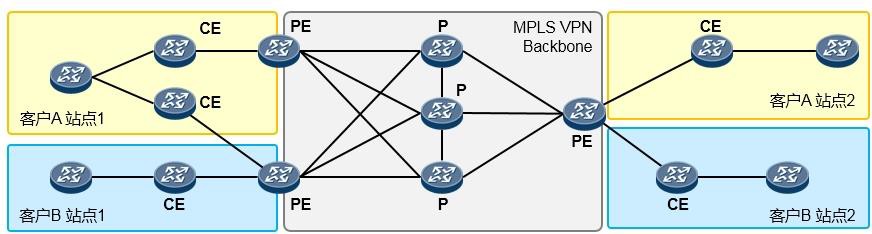

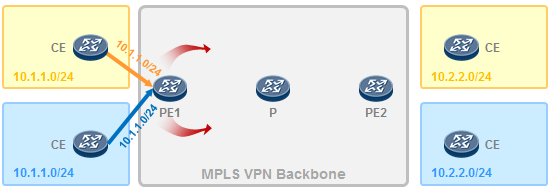

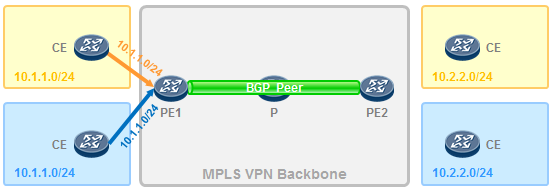

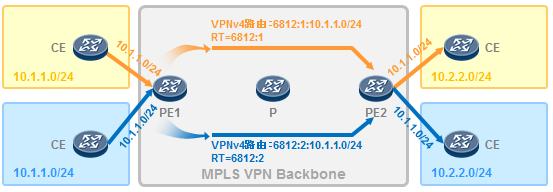

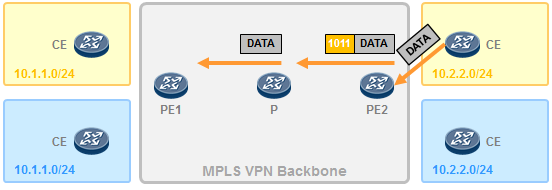

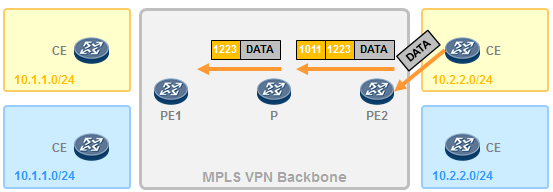

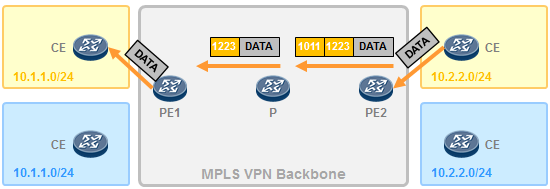

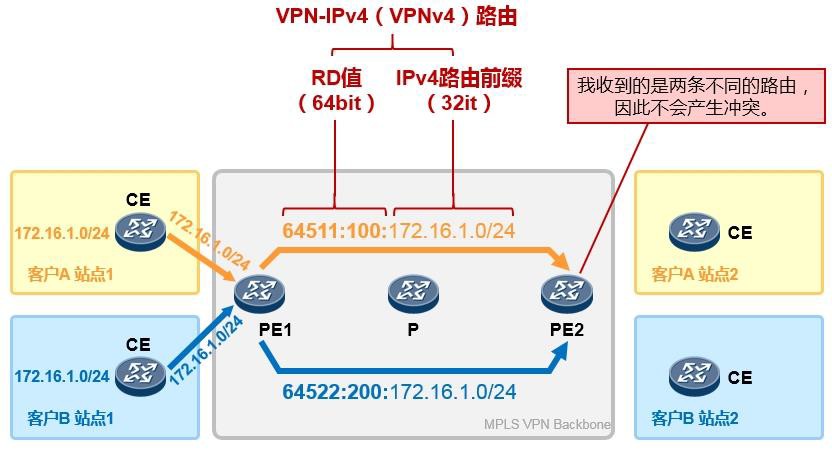

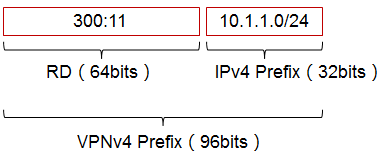

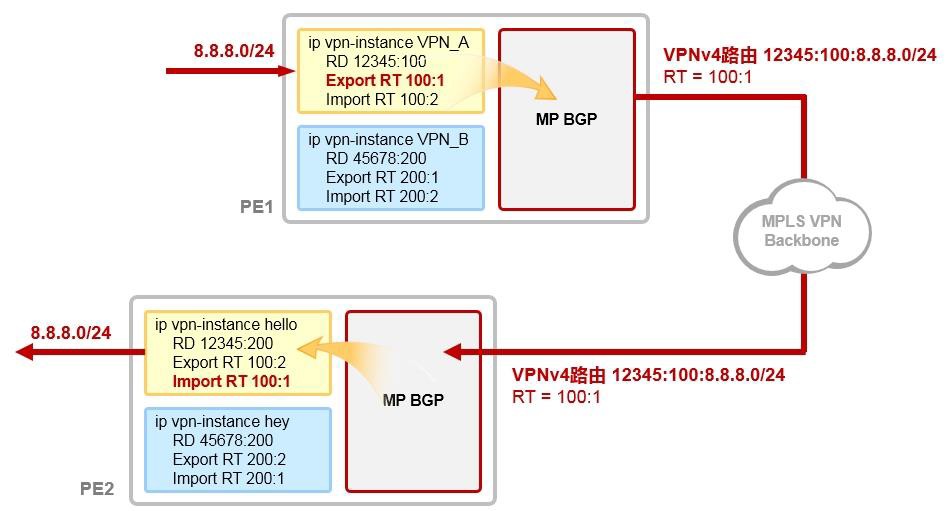

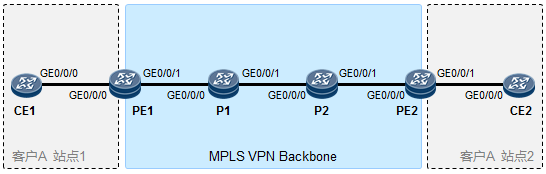

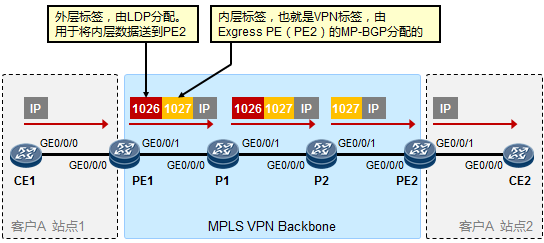

- MPLS VPN 619

- MPLS VPN的架构 620

- MPLS VPN初体验 621

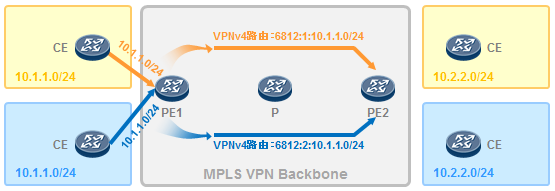

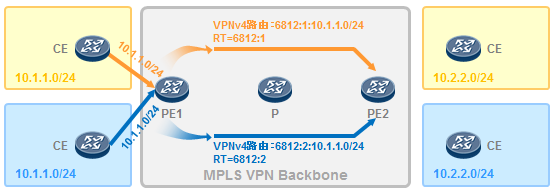

-

VPN实例 625

11.4.4 RD 627

11.4.5 RT 628

11.4.6 基础实验 629

- 组播基础 490

-

服务质量 640

12.1 流量分类与标记 640

12.1.1 修改流量的DSCP 640

-

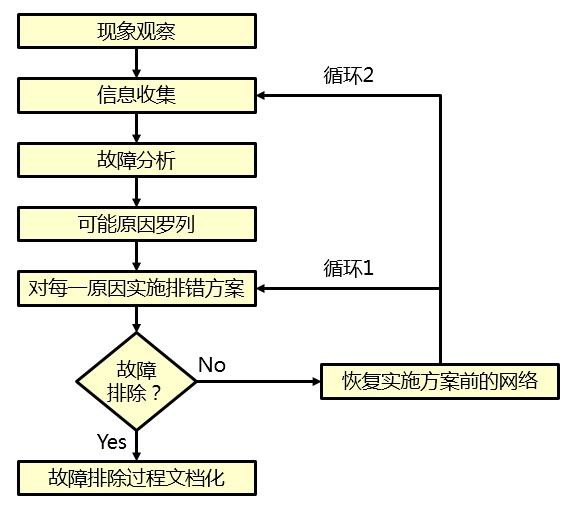

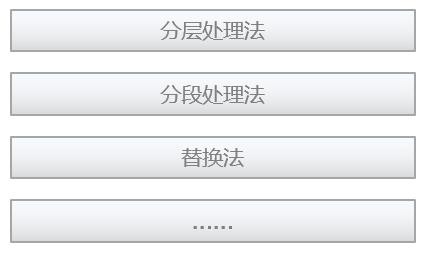

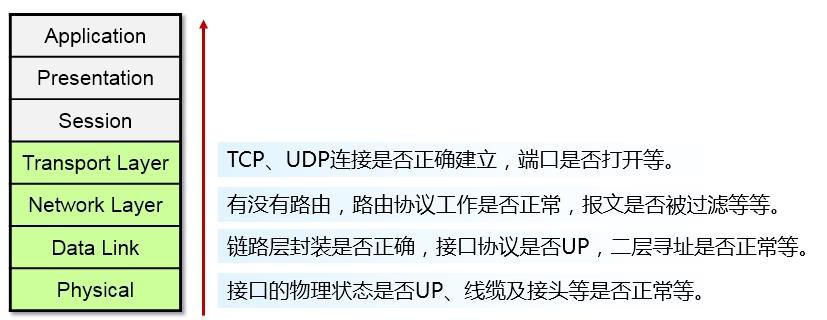

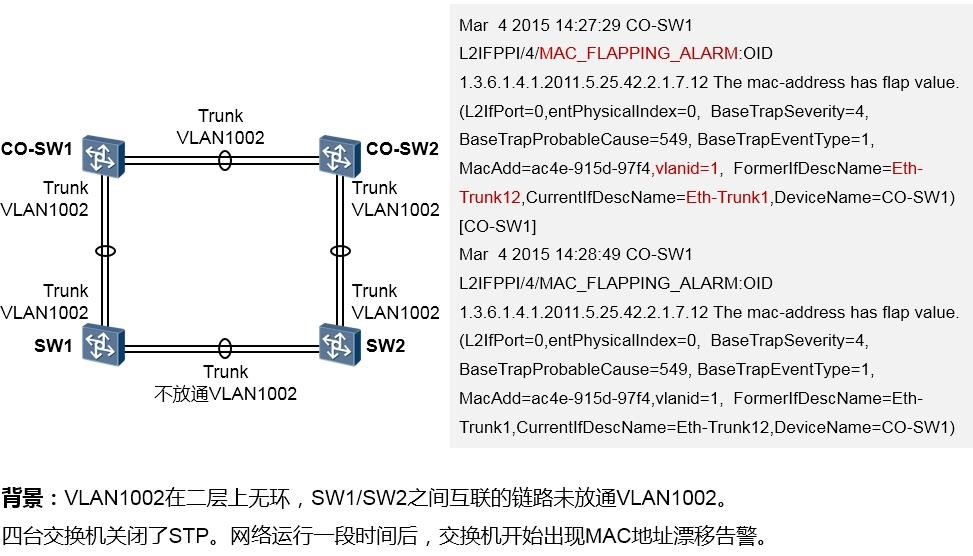

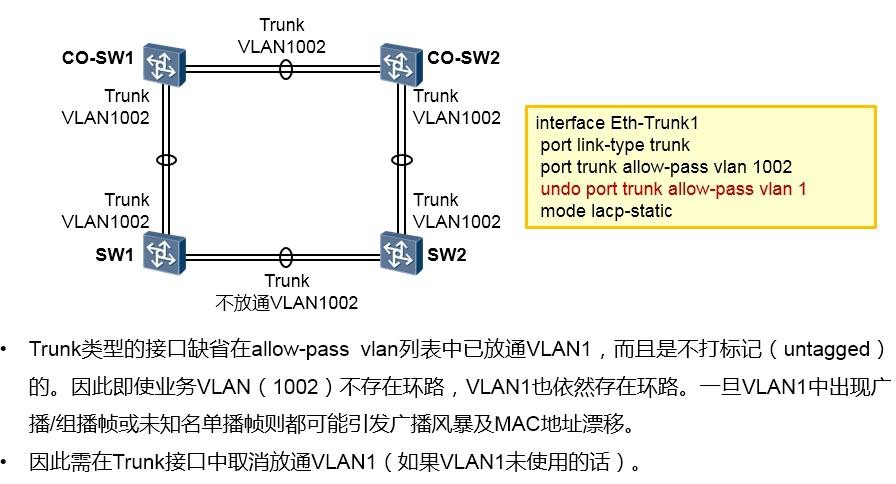

故障处理 641

- 网络故障处理概述 641

-

网络故障处理案例 645

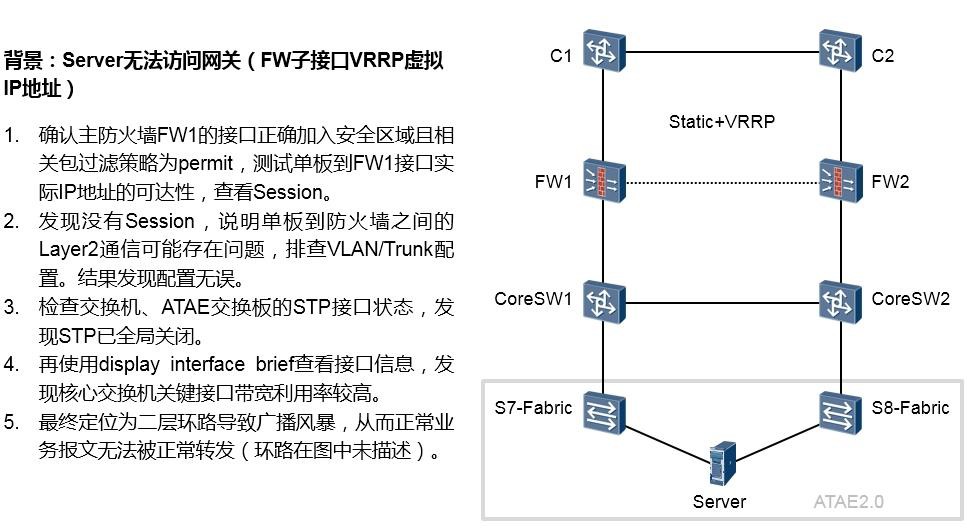

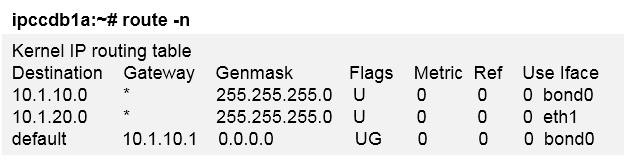

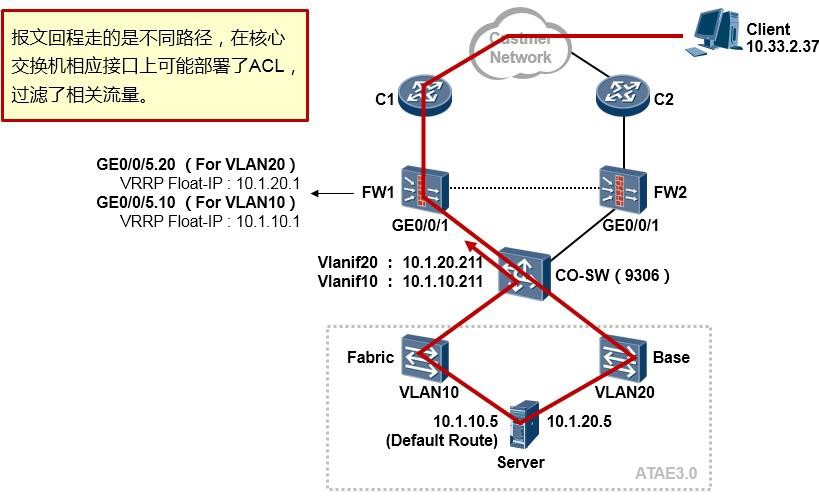

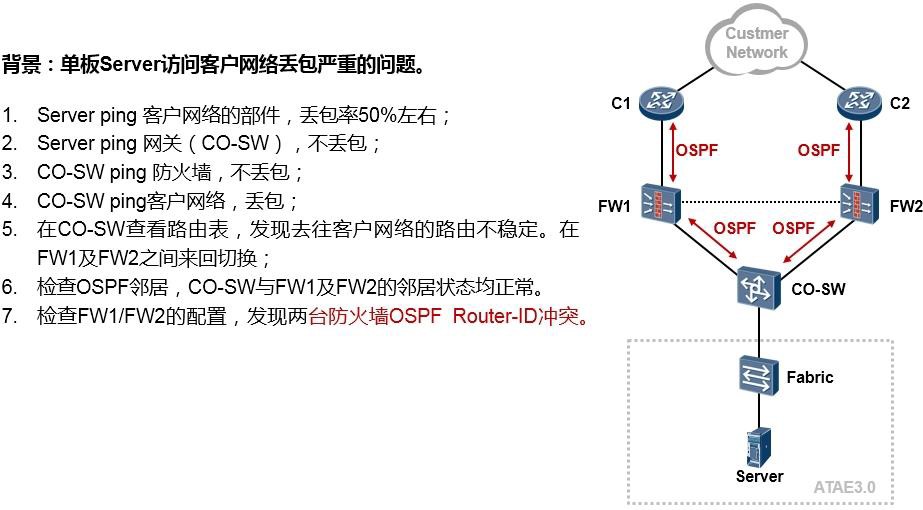

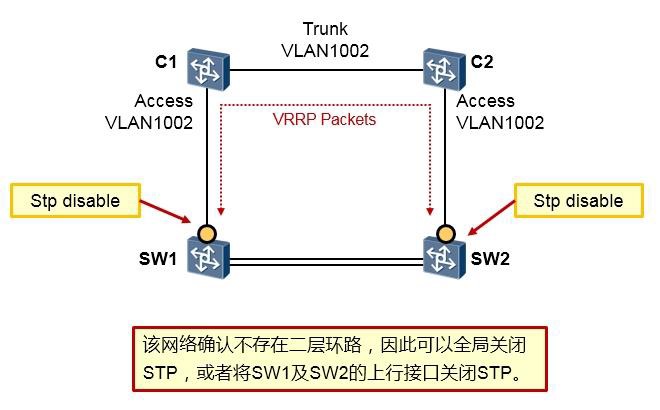

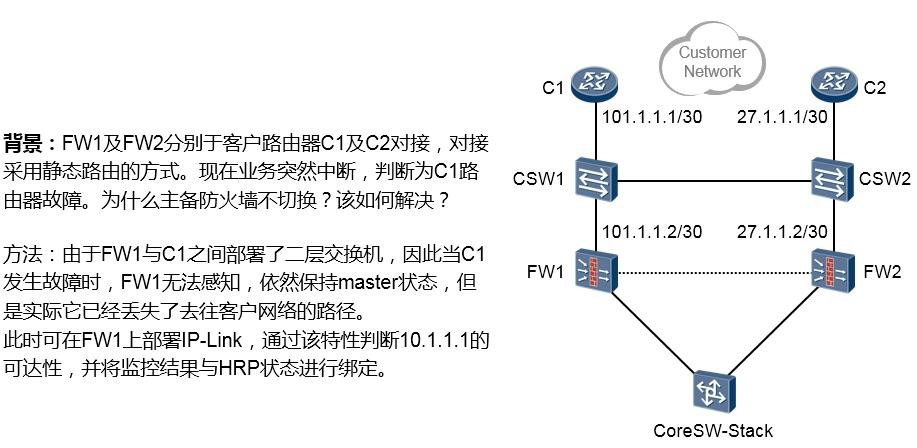

13.2.1 案例1:某局点单板无法访问客户网络设备 645

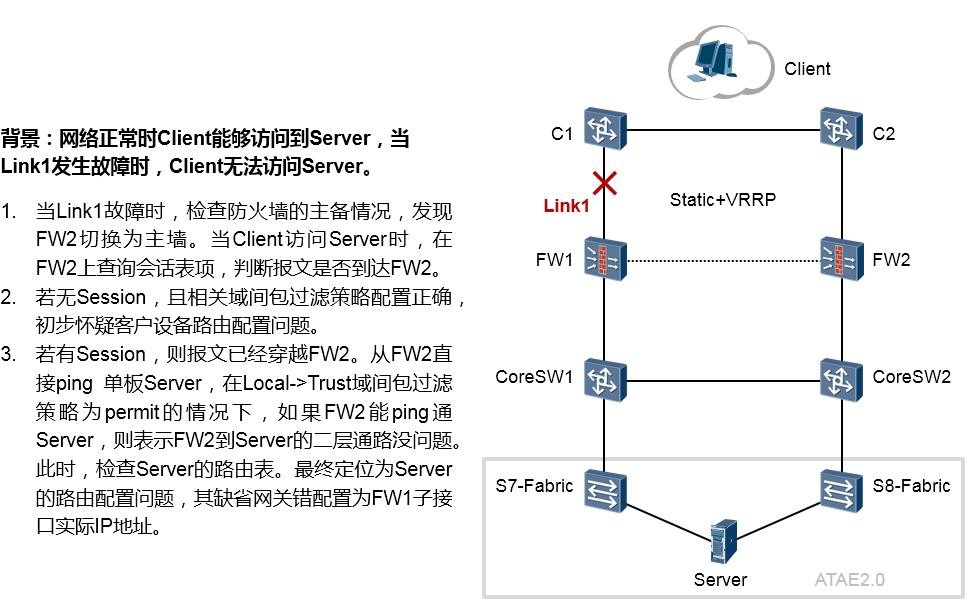

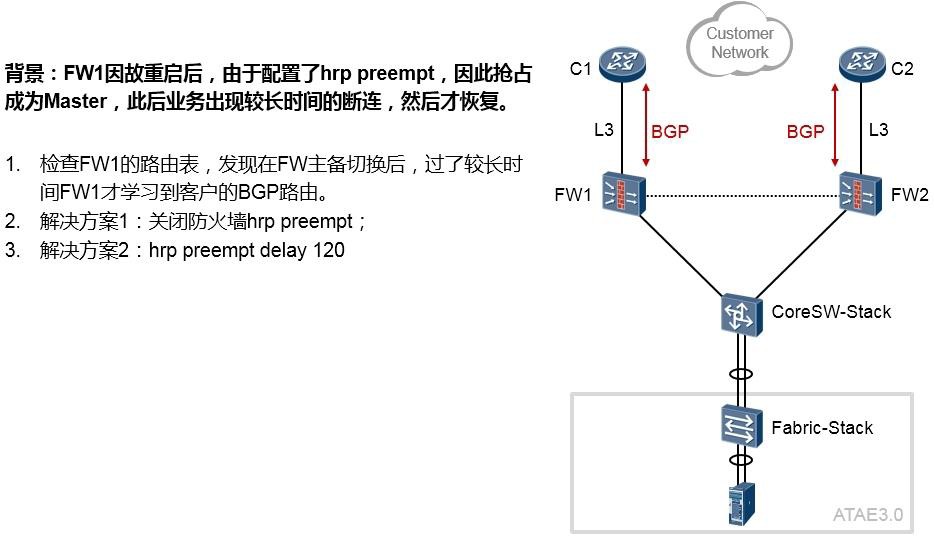

13.2.2 案例2 647

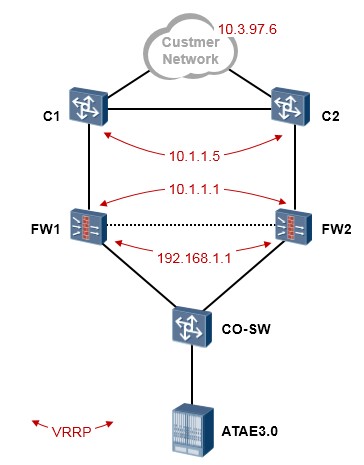

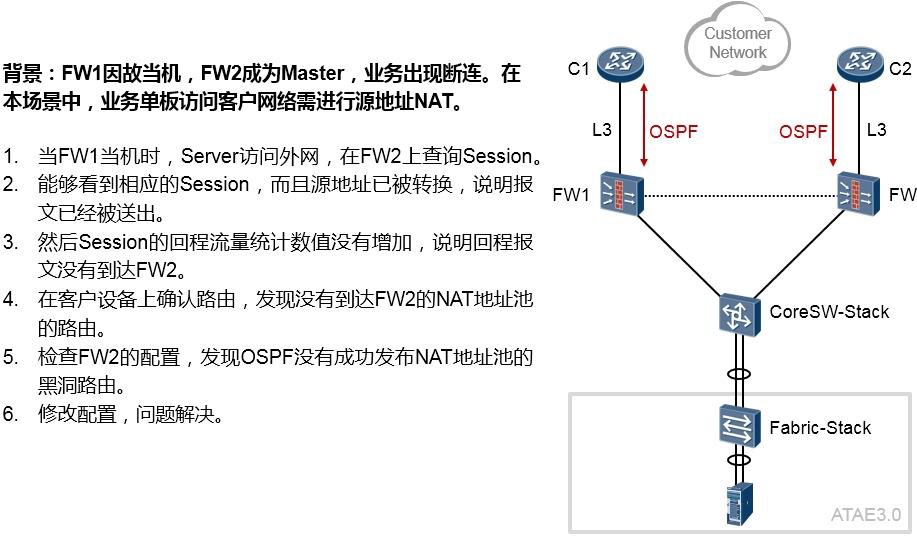

13.2.3 案例3 648

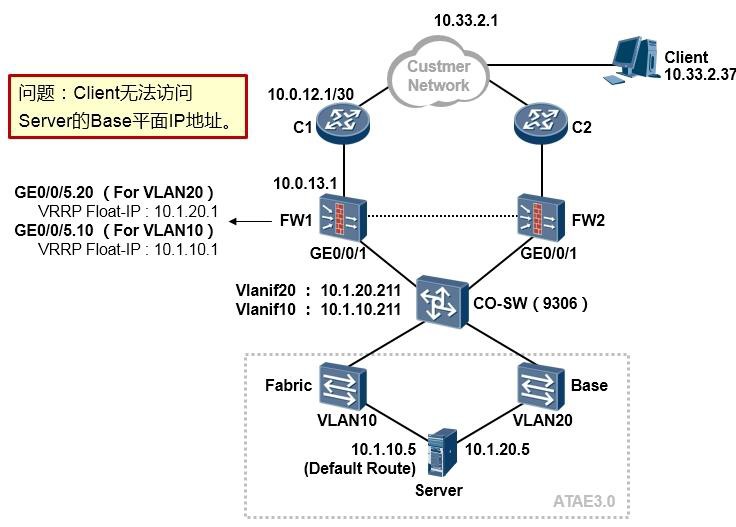

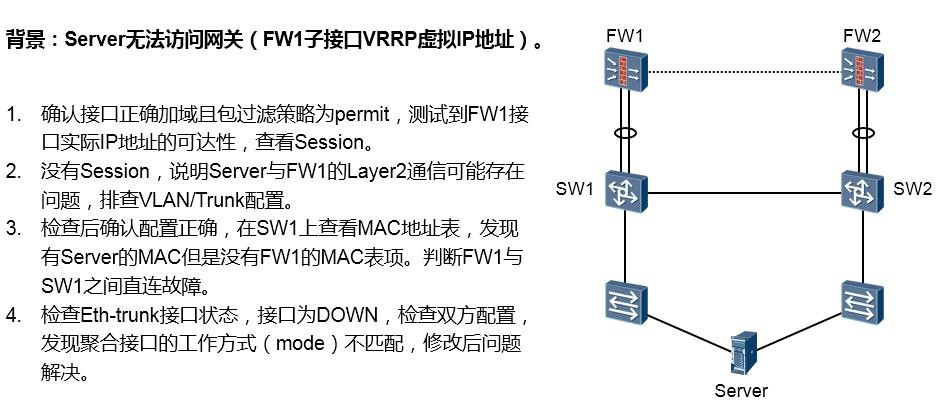

13.2.4 案例4 649

13.2.5 案例5 650

13.2.6 案例6 652

13.2.7 案例7 652

13.2.8 案例8 653

13.2.9 案例9 654

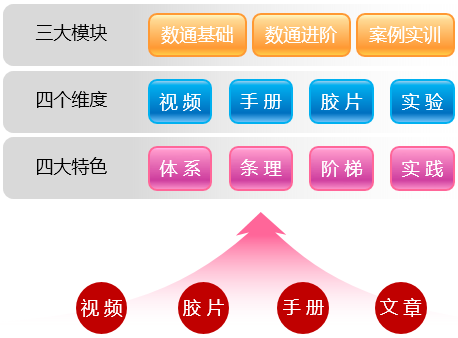

数据通信与网络 知识地图¶

一个理想的知识体系沉淀(知识库),应该是体系化、系统化的,对知识的呈现应该是有条理的、连续的、模块化的,而且能够将理论与实践相结合,落地到实际业务中,能够直接为业务输出价值。知识的开发过程中,必须站在使用者的角度思考,无法被使用的沉淀是没有价值的。而且理想的知识库应该是低获取门槛, 甚至零获取门槛的,应该是开放的。知识库中的知识应该善用互联网渠道、善用多媒体技术,知识开发更要专注知识的有效和高效传递。

《数据通信与网络 知识地图》是笔者在数据通信领域的知识沉淀,该知识地图从零基础开始,循序渐进、体系化地讲述关于数通的各个知识模块。四个内容阵列——培训视频、配套PPT、技术文档(手册)以及实验案例构成了知识地图的整体框架,搭配华为实验模拟平台(华为官方数通模拟器eNSP),将理论与实践紧密结合。除此之外,为了方便大家集中查阅,笔者还将知识地图中所有的原创技术文章整合成一本数通知识宝典——《数通知识宝典》,也就是您正在阅读的这份文档。

学习过程中,可以先看视频,再阅读配套PPT和知识宝典、产品文档,然后使用模拟环境进行实验——通过本知识地图,任何一个零基础的人都能够迅速地掌握各种数通技术及协议,并且应用到实际业务中。即使是以项目为触发的按需学习,也能在地图中快速定位到所需的技术或协议并获取相关的知识内容。

关于本知识地图的最新版本,请在华为3MS Hi社区搜索:“数据通信与网络 知识地图”,或者访问本人3MS

HI社区的个人主页。

朱 仕 耿 261992 (2015-10-08)

网络基础¶

- 利用 TCP/IP 模型理解数据通信过程

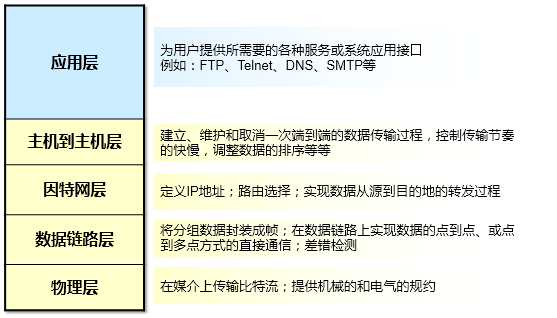

回顾TCP/IP模型¶

什么是数据网络(Data Network)?简单地说,数据网络就是一个由各种设备搭建起来的一张网,常见的设备有:路由器、交换机、防火墙、负载均衡器、IDS/IPS、VPN服务器等等。数据网络最基本的功能就是实现不同节点之间的数据互通,也就是数据通信。

TCP/IP模型是当今IP网络的基础(也被称为DoD模型,上图我贴出的并不是标准的TCP/IP模型,为了方便下文的阐述,这里给出的是一个TCP/IP模型与OSI模型的对等模型),它将整个数据通信的任务划分成不同的功能层次(Layer),每一个层次有其所定义的功能,以及对应的协议。打个比方,对于一家公司而言,一笔业务需要各个部门相互协同工作才能完成,部门与部门之间既相互独立,但是又需要相互配合,可以借用这种思路来理解TCP/IP参考模型。分层参考模型的设计是非常经典的理念:

- 层次化的模型设计将网络的通信过程划分为更小、更简单的部件,因此有助于各个部件的独立开发、设计和故障排除;

- 层与层之间相互独立,又互相依赖,每一层都有该层的功能、以及定义的协议标准。层与层之间相

互配合,共同完成数据通信的过程;

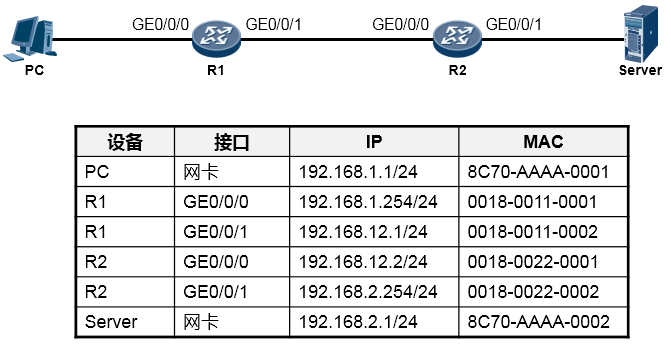

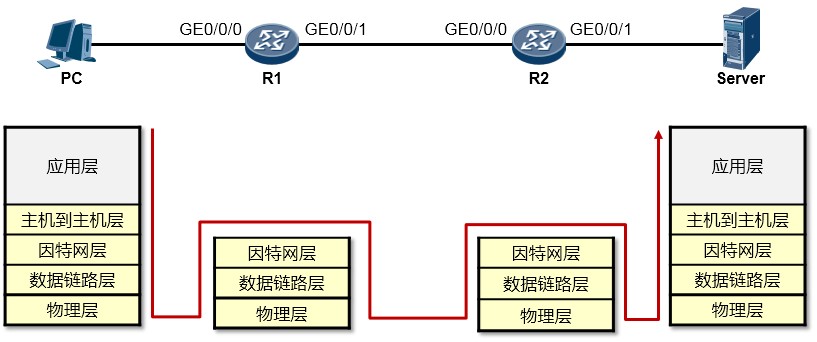

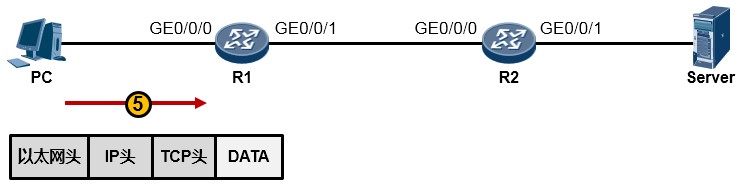

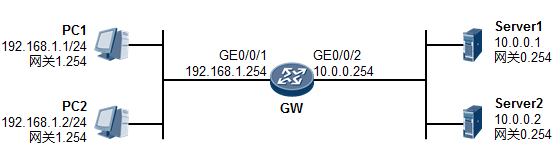

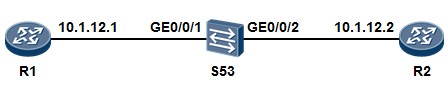

理解数据通信过程¶

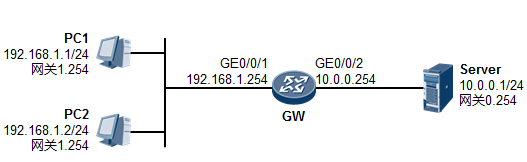

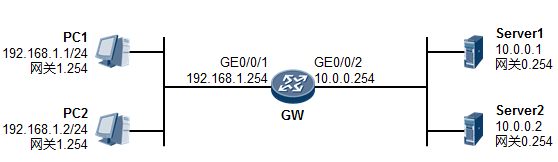

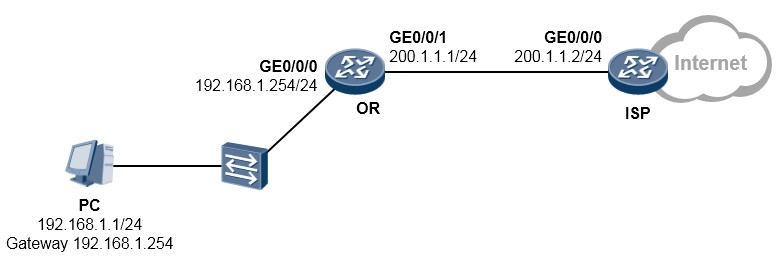

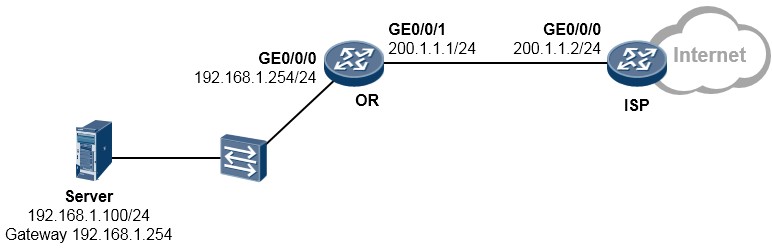

根据上图所示的网络拓扑(Topology),我们来分析一下PC访问Server的WEB服务的详细通信过程。在阐述过程中,我们聚焦的重点是利用TCP/IP参考模型理解数据通信过程,因此可能会忽略部分技术细节,例如DNS、TCP三次握手等,这些技术细节这里暂不做讨论。现在你要换一种视野来看待这个

“世界”了,想象一下上图所示的终端以及路由器都是一个个的“TCP/IP通信模型”,事实上,整个过程在宏观层面体现如下:

我们一步一步的来分析:

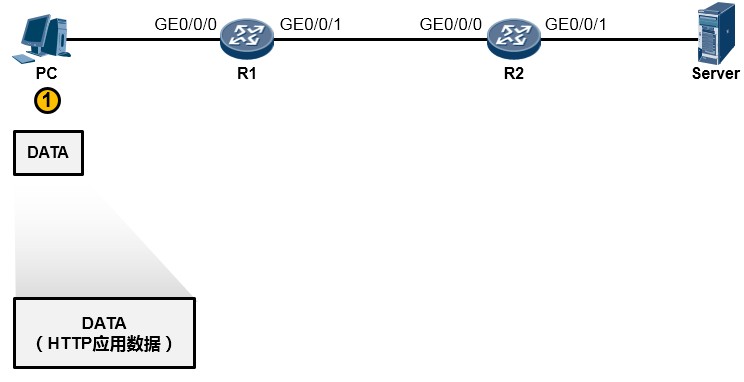

- PC的用户在WEB浏览器中访问Server的WEB服务(这里我们暂且不去关注HTTP交互、DNS交互等细节,重点看通信过程),PC的这次操作将触发HTTP应用为用户构造一个应用数据(如下图所示)。当然这个数据最终要传递到Server并“递交”到Server的HTTP应用来处理,但是HTTP不关心数据怎么传、怎么寻址、怎么做差错校验等等,这些事情交由专门的层次来完成,所以HTTP应用数据还需经过一番“折腾”才能从PC传到Server,OK GO。

-

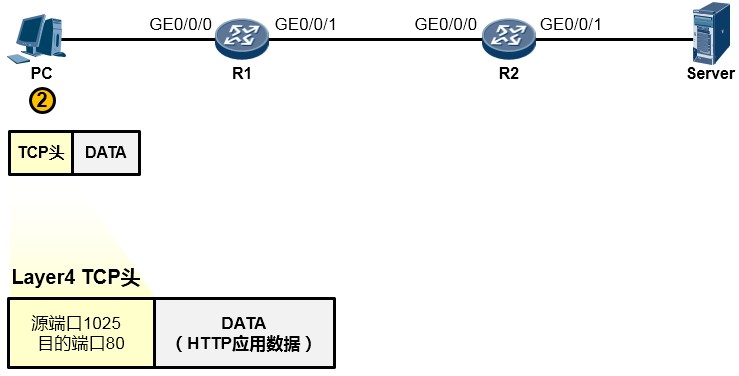

由于HTTP基于TCP,因此这个应用数据交由参考模型中的主机到主机层(第4层)进一步处理。在该层,上层HTTP应用的数据被封装一个TCP的头部(可以简单的理解为套了一个TCP的信封), 在TCP头部中我们重点关注两个字段(信封上写的东西),一个是源端口号,另一个是目的端口号, 源端口号为随机产生的端口号(是PC本地设置的、专门用于本次会话的端口),目的端口号为80

(HTTP服务对应的默认端口号是80),如下图所示。然后这个数据段(Segment)被交给下一个层处理。

-

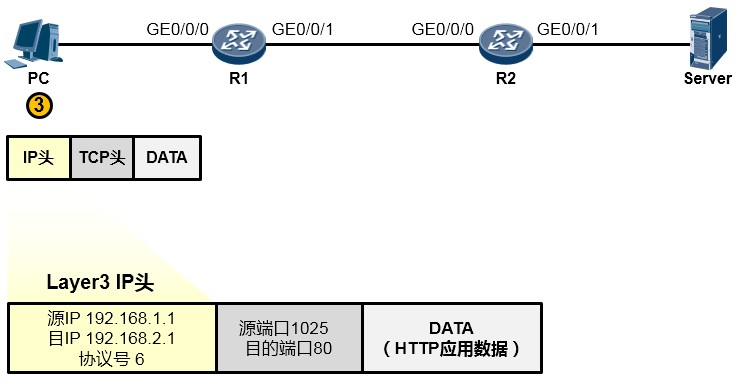

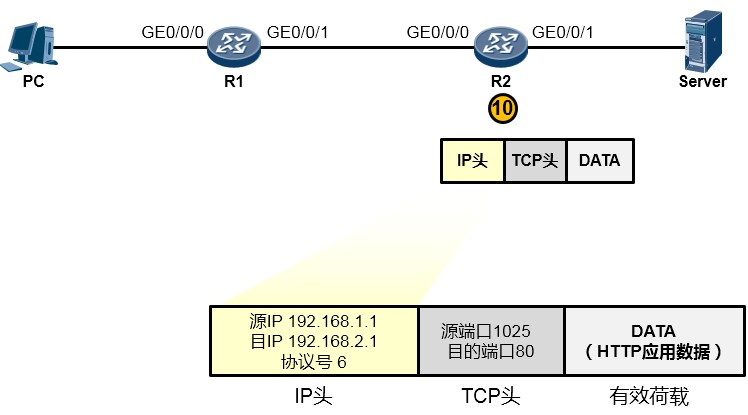

下一层是网络层,也叫因特网层(第3层),处于这个层的IP协议为这个上层下来的数据封装一个

IP头部(在之前的基础上又套了一个信封,如下图所示),以便该数据能够在IP网络中被网络设备 从源转发(路由)到目的地。在IP头当中我们重点关注源IP地址、目的IP地址、协议号这三个字段。 其中源地址填写的是PC自己的IP地址192.168.1.1,目的地址存放的是Server的IP地址192.168.2.1, 而协议号字段则存放的是值6,这个值是一个众所周知(Well-Known),也就是行业约定的值,该 值对应上层协议类型TCP,表示这个IP头后面封装的上层协议为TCP(形象点的描述是,协议字段 用于表示这个IP信封里装的是一个TCP的内容)。搞定之后,这个数据被交给下一层处理。

-

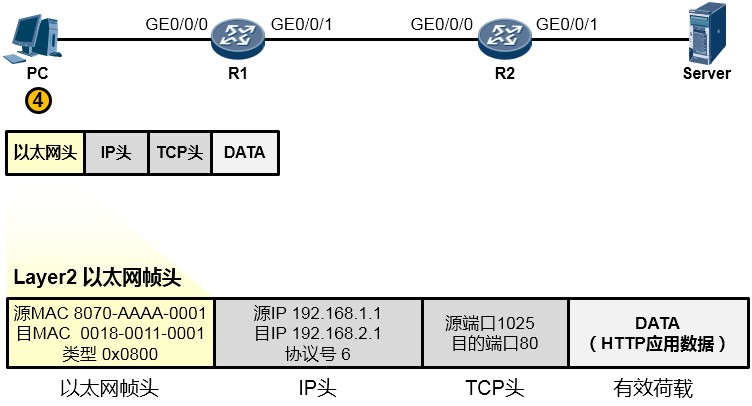

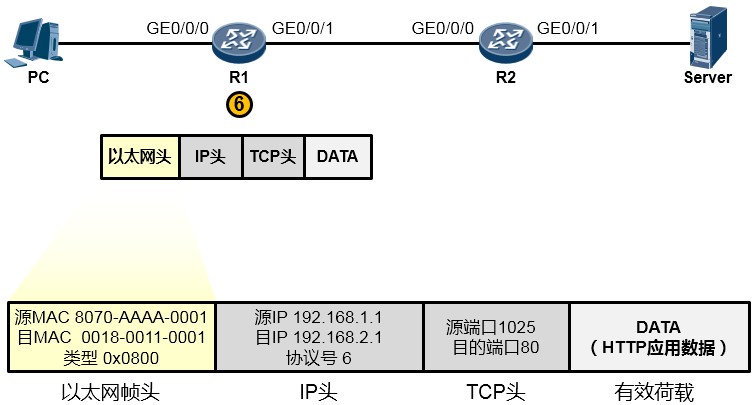

为了让这个IP数据包能够在链路上传输(从链路的一个节点传到另一节点),还要给数据包封装上一个数据链路层(第2层)的头部,以便该数据能够在链路上被顺利传输到对端。由于PC与R1之间为以太网链路,因此上层来的IP数据包被封装一个以太网的数据帧头(再增加一个信封)。这个帧头中写入的源MAC地址为PC 的网卡MAC, 那么目的MAC呢? PC 知道, 数据的目的地是

192.168.2.1这个IP,而本机IP是192.168.1.1/24,显然,目的地与自己并不在同一个IP网段,因此需要求助于自己的默认网关,让网关来帮助自己将数据包转发出去。那首先得把数据转发到网关吧?因此目的MAC地址填写的就是网关192.168.1.254对应的MAC地址。但是初始情况下,PC可

能并不知晓192.168.1.254对应的MAC地址,所以,它会发送一个ARP广播去请求192.168.1.254的

MAC,R1的GE0/0/0口会收到这个ARP请求并且回送ARP响应报文。如此一来PC就知道了网关的

MAC,它将网关MAC 0018-0011-0001填写在以太网数据帧头部的目的MAC地址字段中。另外, 以太网数据帧头的类型字段写上0x0800这个值,表示这个数据帧头后面封装的是一个IP包。费了好大劲儿,这个数据帧(Frame)终于搞定了,如下图所示:

- 值得一提的是,事实上在物理链路中传输的是比特(bit)流,或者电气化的脉冲型号,只不过为了方便理解和更加直观地分析,我们往往会以IP包或者数据帧的形式来阐述通信过程。所以从物理上说,最终这个以太网数据帧变成了一堆的101110101从网线传到了路由器R1上,如下图所示:

-

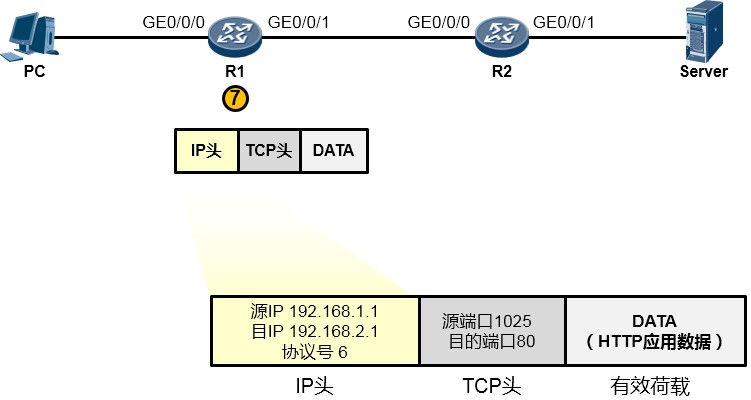

路由器R1在收到这一串的1010…后,先将他们还原成数据帧(如下图所示)。然后会采用相应的机制检查一下数据帧在传输过程中是否有损坏,如果没有损坏,那么就瞅瞅数据帧头部中的目的

MAC地址,看看目的MAC地址是不是我收到这个数据帧的GE0/0/0接口的MAC,结果发现正好是自己的MAC,那么它会很高兴,觉得这个数据帧是给它的,它查看数据帧头部的类型字段,发现是0x0800,于是它知道里头装的是一个IP包,接着它将以太网帧头剥去,或者说解封装,然后将里面的数据移交给上层的IP协议继续处理。

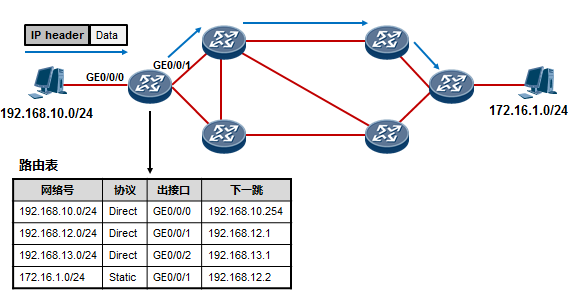

- 现在R1的IP协议栈接着处理这个报文。它会先校验一下数据在传输过程中IP报文有没有受损,如果没有,它就查看IP头中的目的IP地址(如下图所示),结果发现目的IP地址为192.168.2.1,并不是自己的IP地址——原来这个数据包是发给别人的,于是它开始拿着目的地址192.168.2.1到自己的地图(路由表)里去查询,看看有没有到192.168.2.1这个目的地的路径,结果发现有,并且这个路由条目指示它把数据包从从GE0/0/1口送出去,并交给192.168.12.2这个下一跳IP地址。于是它不再继续拆开IP头看里头的东东了,而是乖乖的将IP数据包往下交还给数据链路层去处理。

-

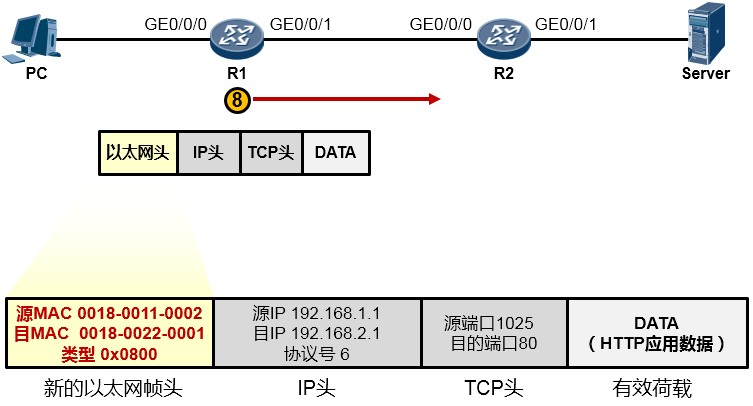

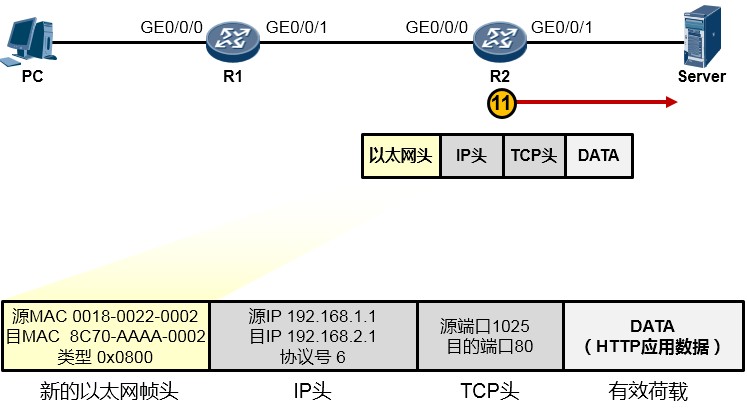

现在数据链路层继续处理上层下来的IP包,它为这个IP包封装上一个新的以太网帧头,帧头中源

MAC地址为R1的GE0/0/1口的MAC:0018-0011-0002,目的MAC是这个数据包即将交给的下一跳路由器192.168.12.2对应的MAC,当然初始情况下R1是不知道这个MAC的,因此又是一轮ARP请求广播及回应过程并最终拿到这个MAC:0018-0022-0001,于是它将这个值填写在目的MAC字段中。完成了新的数据帧封装后(如下图所示),R1把这个数据帧变成1010101…通过电气信号传递给R2。

- R2收到这些10101…后,同样的,还是先将其还原成帧,然后查看帧头,发现目的MAC填写的就是自己接口的MAC,并且帧头中类型字段写的是0x0800(指示上层协议是IP,也就是数据帧头内封装的是一个IP包),于是将数据帧头剥去,将里头的IP数据包交给IP协议去处理。

-

而IP协议在处理过程中发现,目的IP地址并非本路由器的IP(如下图所示),于是它知道这个数据包不是发送给自己的,它拿着目的IP地址192.168.2.1在自己路由表中查询,结果发现,R2的

GE0/0/1口就连接着192.168.2.0/24网络,原来家门口就是了,于是它将这个IP包交还给下层协议去处理。

-

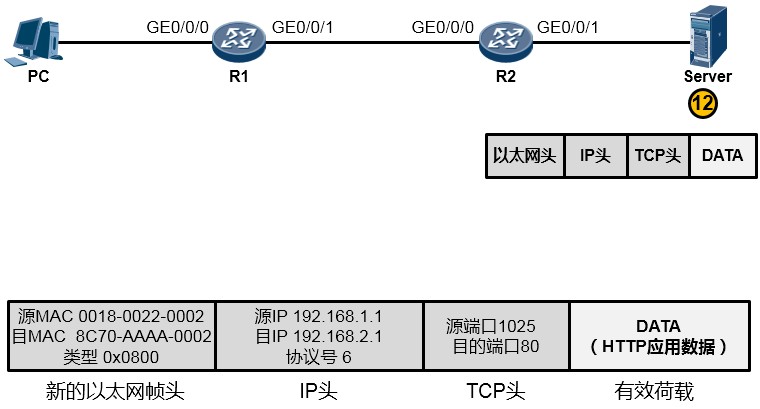

接下来又是重新封装成帧,R2为这个IP包封装一个新的数据帧头部,帧头中,源MAC为R2的

GE0/0/1口的MAC,目的MAC为192.168.2.1这个IP地址对应的MAC,如果ARP表里有192.168.2.1 对应的MAC,则直接将MAC地址写入目的MAC中,如果没有,则发ARP请求报文去请求该地址。另外类型字段依然填写0x0800。最终,R2将这个数据帧传给了Server,如下图所示:

- 好不容易,终于数据帧到达了Server(如下图所示)。Server首先将这些比特流还原成帧,然后做校验看看帧是否损坏,如果没有,则查看数据帧的目的MAC,结果发现就是自己的网卡MAC,于是查看类型字段,发现是0x0800,知道这里头装的是一个IP包,于是将帧头剥去,将内层的IP数据包交给IP协议去处理。IP协议层收到这个数据包之后,首先查看IP包是否损坏,如果没有,则查看目的IP地址,发现目的IP地址是192.168.2.1——正是自己的网卡IP,于是它知道,这个IP包是发给自己的,因此继续查看IP包头中的协议字段,发现协议字段填写的是6这个值,原来这个IP包头后面封装的是一个TCP的数据,于是将IP包头剥去,将里头的TCP数据交给上层的TCP协议处理。而TCP在处理这个数据的时候,查看TCP头部的目的端口号,发现目的端口号是80,而Server本地的TCP 80端口是开放的,开放给HTTP应用了,因此它将TCP头部剥去,将里头的载荷交给HTTP 应用。终于,从PC发送出来的HTTP应用数据到达了目的地——Server的HTTP应用的手中。

- IP 地址的概念及 IP 子网划分

什么是IP地址¶

-

IP地址在网络中用于标识一个节点(例如一台主机,或者一个网络设备的接口)。

- 在IP网络中,数据包的寻址是基于IP地址来进行的,因此IP地址就像是现实生活中的地址一样。

-

IP协议定义了IP数据报文的格式,也定义了数据报文寻址的方式。目前我们在业务环境中常见的IP

主要是两个版本:IPv4及IPv6,而现阶段网络主体仍然是IPv4,但是在可预见的未来,会逐渐向

IPv6过渡。本章只介绍IPv4。

-

一个IPv4地址有32bit。当然,我们不可能用二进制来书写IPv4地址,那是低效的,我们通常采用十进制格式来书写IP地址,但是计算机在进行IP地址的相关计算工作时,无疑是通过二进制的形式来进行。因此掌握十进制到二进制的数制转换是必备的技能。

- IPv4地址通常采用“点分十进制”表示,以适应人类的读写习惯,例如192.168.1.1。

十进制与二进制的转换¶

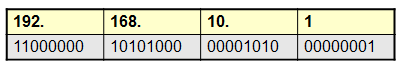

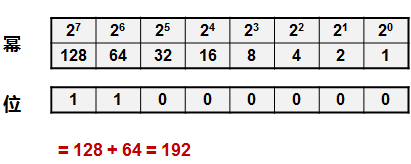

“点分十进制”IP地址表现形式能够帮助我们更好的使用网络,但网络设备在对IP进行计算时使用的是二进制的操作方式,例如:

以下是192这个数字,对应的二进制算法,这里就不再赘述了,这是基本技能。

IP地址的分类¶

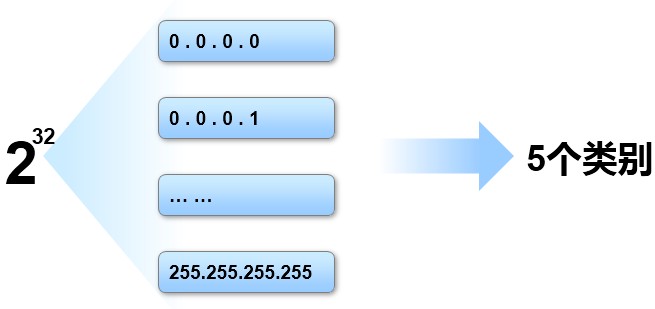

IPv4地址的长度为32bit,如上图所示,IPv4地址的空间从0.0.0.0 一直到 255.255.255.255,这么庞大的空间,如果不加以区分和规划,势必不便于统筹管理。因此我们对整个IPv4地址空间进行类别上的划分,一共分为5类:

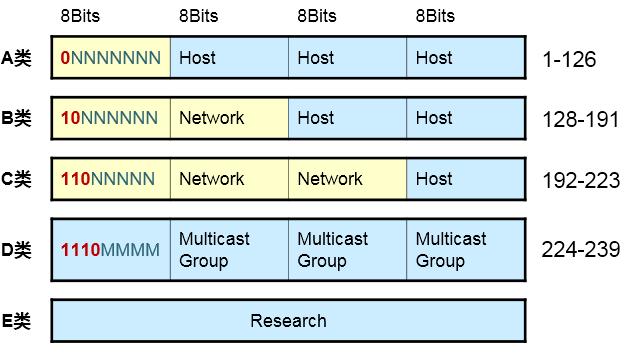

地址的类别上的区分主要体现在第一个八位组(一个IP地址拥有4个八位组)上:

-

第一个八位组首位恒定为0,那么我们就得到一个区间:0.0.0.0一直到127.255.255.255。这是A类地址,其中127.0.0.0/8作为本地回环使用,例如你ping 127.0.0.1实际上ping的是本机。所以如果看到一个IP地址,它的首个八位组掉落在1-126区间内,那么这是一个A类地址。

2) 第一个八位组的最高两位恒定为二进制的10,就得到一个区间:128.0.0.0-191.255.255.255,这是

B类地址。

3) 第一个八位组的最高三位恒定为110,就得到一个区间:192.0.0.0 – 223.255.255.255,这是C类地址。

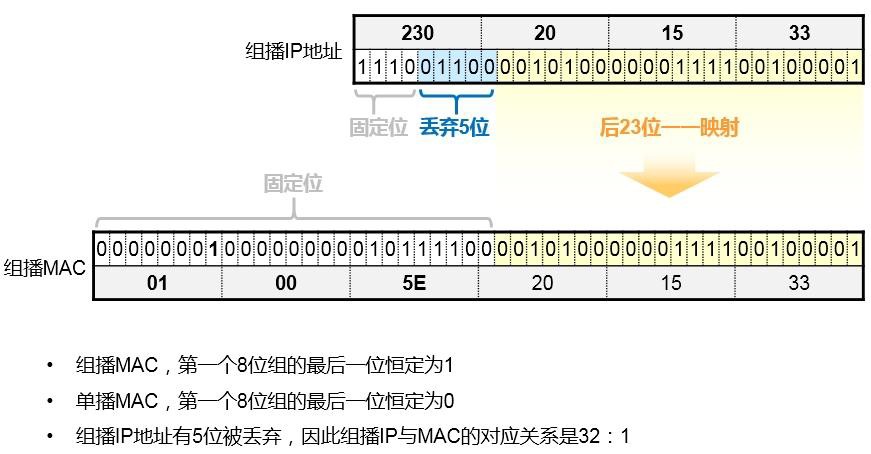

4) 第一个八位组的最高四位恒定为1110,就得到一个区间:224.0.0.0 – 239.255.255.255,这是D类地址,这个类别的地址专门用于组播。笔者安排了专门的章节介绍组播的概念和应用。

5) 剩下的是E类地址,这类地址保留作为研究使用。

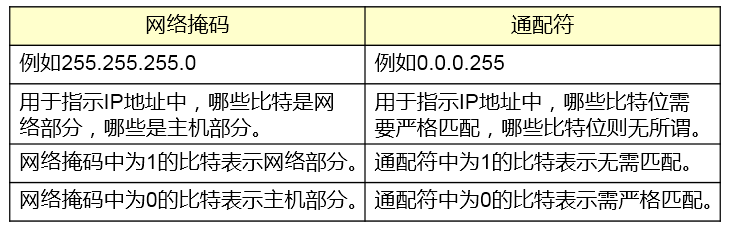

网络掩码(Network Mask)¶

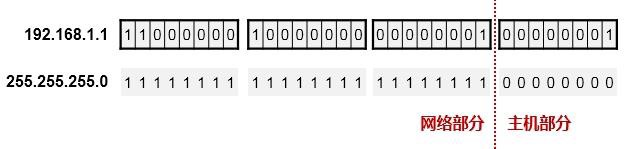

一个IP地址包含两部分:网络部分以及主机部分。网络部分用于表示这个IP地址所处的“空间”,对于一台路由器而言,当它在为数据包寻址时,通常只关心IP地址的网络部分。那么如何区分一个IP地址中的网络与主机部分呢——网络掩码(Network Mask,简称netmask)用于和IP地址进行对应,从而标识出IP地址中的网络与主机部分。

- 网络掩码为32bit,与IPv4地址的位数是一样的。

- 网络掩码在二进制的表示上是一堆连续的1,后面接连续的0。

-

网络掩码值为1的bit对应IP地址中的网络位;为0的bit对应IP地址中的主机位,以此来识别一个IP 地址中的网络与主机位,如下图:

网络掩码值为1的bit对应IP地址中的网络位;为0的bit对应IP地址中的主机位,以此来识别一个IP 地址中的网络与主机位,如下图:为了方便书写,我们往往使用掩码长度的方式来表示一个IP地址+ 掩码组合,例如192.168.1.1

255.255.255.0 等同于192.168.1.1/24。因为255.255.255.0写成二进制的话,从左往右数就是24个1, 所以我们也说,它的掩码长度为24。

默认情况下,A类IP地址的首个八位组为网络位,其他位为主机位,因此A类地址的默认掩码就是

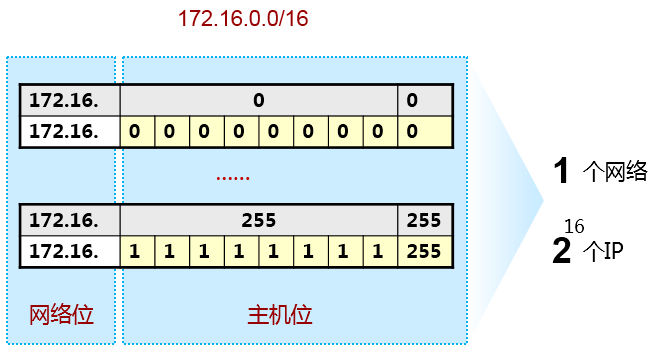

255.0.0.0,或者说掩码长度为/8。B类IP地址前两个八位组为网络位,后两个八位组为主机位,因此B 类地址的默认掩码就是255.255.0.0或者掩码长度/16。C类地址的前三个八位组为网络位,最后一个八位组是主机位,因此C类地址的默认掩码就是255.255.255.0,或者掩码长度为/24。从这里可以看出, 如果申请到一个A类地址段123.0.0.0/8,那么这是一个相当庞大的地址空间,因为这个空间有2的24次方个IP地址。相对的,一个B类的IP网络地址空间默认有2的16次方个IP地址,而每个C类地址段所拥有的主机数量则更少。

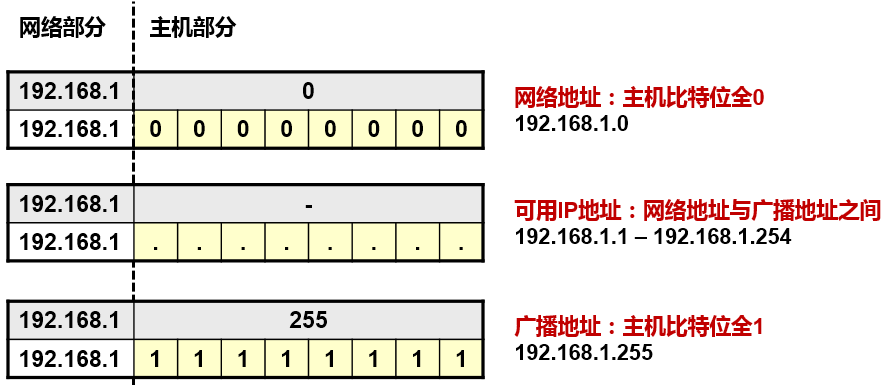

IP地址类型¶

-

网络地址:用于标识一个网络,相当于一个“面”的概念。网络地址是一个IP地址中主机位为全0 的地址。例如192.168.10.0/24,该地址标识了一个网络,在这个网络中,存在多个IP地址,可用于分配给各种设备,例如192.168.10.1、192.168.10.2、…、192.168.10.254,这些地址都属于

192.168.10.0/24网络。网络地址不能够被分配给主机。

-

**广播地址:**用于向网络中的所有节点发送数据的特殊地址。广播地址即主机部分的各比特位全部为

1的地址。例如192.168.10.255/24,该地址是192.168.10.0/24这个网络的广播地址。

3) **节点地址:**可分配给网络中的设备的地址。例如192.168.10.1/24至192.168.1.254/24。网络地址及广播地址是不能够直接被分配给某个设备(的网卡)或者网络设备(的接口)的,因为它们有特殊用途。

例:192.168.1.0 这个C类地址对应的网络地址、广播地址及可分配IP地址分别是?

-

为什么要划分子网¶

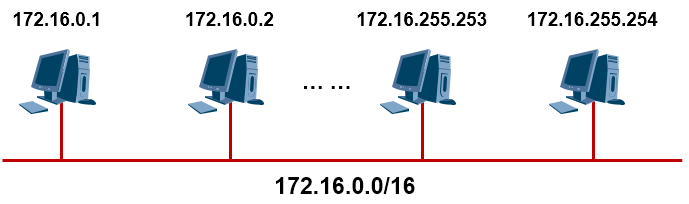

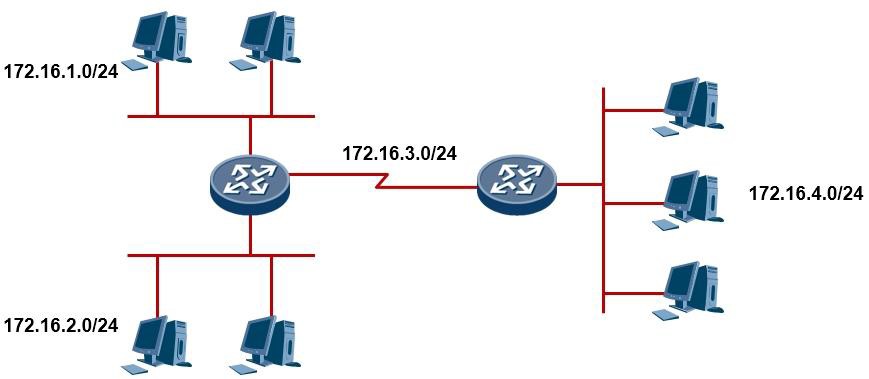

假设你有一个B类地址段172.16.0.0/16,由于B类地址的默认掩码是255.255.0.0,这就意味着这个网络内有2的16次方个IP地址,而可分配给设备使用的IP地址就有2的16次方-2这么多个,为什么要减去2? 因为广播地址及网络地址是不能分配给设备使用的。

设想一下,如果一个网络中真有这么多台PC,这么多个IP地址处于同一个网段中、同一个广播域中, 如上图所示,那么一旦网络中发生广播,影响可就大了。再者,在实际的业务环境中,我们往往会给一个业务单元(例如一个公司内的各个部门),划分一个独立的IP网段,不同的业务单元不同的IP网段, 那么如果有10个业务单元,每个业务单元才几十近百台设备,一个业务单元就耗费一个B类地址段,这就会造成IP地址的浪费。

因此,我们提出子网划分的概念,子网划分所使用的思维是VLSM(Variable Length Subnet Mask,可变长子网掩码),事实上是拿网络掩码变戏法。在下图中有五个网段,需要五个IP地址段,如果只有一个B类地址(172.16.0.0/16)可用,那么通过子网划分,可以将这个B类地址划分成一个个小一点的子网。这样一来,一个庞大的网络就可以被分割成小的单元,另外IP地址的使用也更为科学更为合理。

如何划分子网¶

现在假设我们有一个B类地址段172.16.0.0/16,默认情况下,这个B类地址的掩码为255.255.0.0,前两个八位组是网络位,后两个八位组是主机位。那么这个单一的网络中,有2的16次方个IP地址,如上图所示,非常庞大。

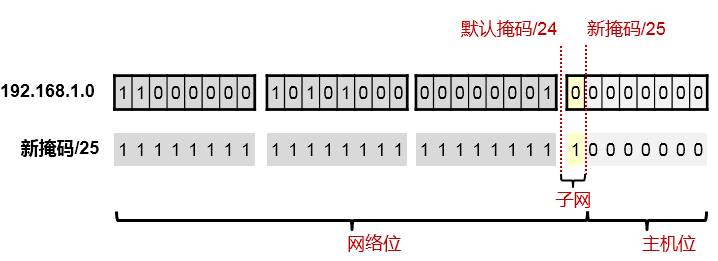

现在,在原有网络位的基础上,再向主机位借一个bit作为网络位的补充,网络位就扩充到了17bit,相对的主机位就变成了15bit。那么借过来的这一位,就是子网位了,如上图所示。由于我们借了这一位, 因此网络掩码就从默认的255.255.0.0变成了255.255.128.0或者说从/16变成了/17。

于是从原来的只有172.16.0.0/16的一个大网段,变成现在拥有172.16.0.0/17及172.16..128.0/17这两个小一点的网段,这就是子网划分。务必要关注网络掩码在这个过程中发挥的作用。

子网划分例子一¶

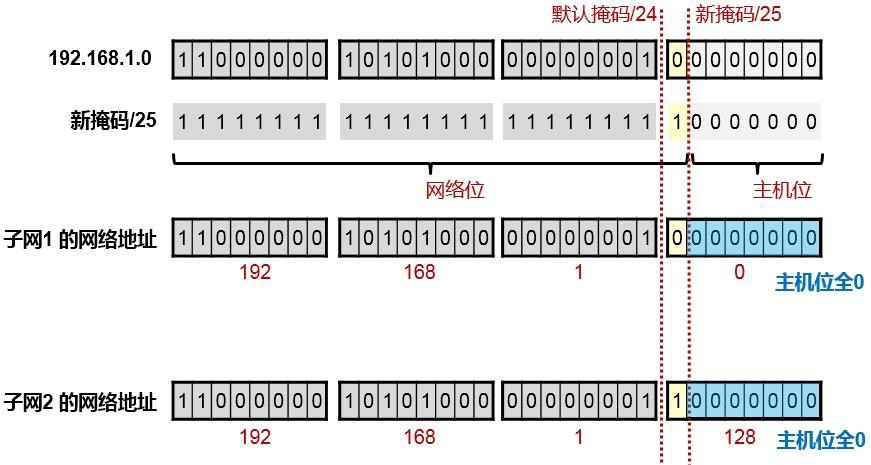

现在有一个IP地址:192.168.1.0,这是一个C类地址,默认的掩码是/24,我要对它做子网划分,向主机位借一位作为子网位,也就是掩码长度变成/25,那么我能得到几个子网?每个子网的网络地址是多少?每个子网的广播地址是多少?每个子网的可用IP地址范围是多少?

步骤如下:

判断类别,找默认掩码:¶

首先这是一个C类地址,因此默认的掩码长度为/24,你可以划一条竖线帮助计算。线的左边为网络位,右边为主机位,如上图所示。

变更掩码,找子网:¶

在原有的/24掩码基础上,向主机位借一位,掩码变成/25。借出来的这一位就是子网位,如上图所示,我们只要将虚线往右移动一格就行。这个子网位的值要么为0,要么为1,也就是存在两种可能性,这就创造了两个子网(2的1次方),子网位为0时,得到的子网地址是192.168.1.0/25,子网位为1时,得到另一个子网的网络地址192.168.1.128/25,如下图所示:

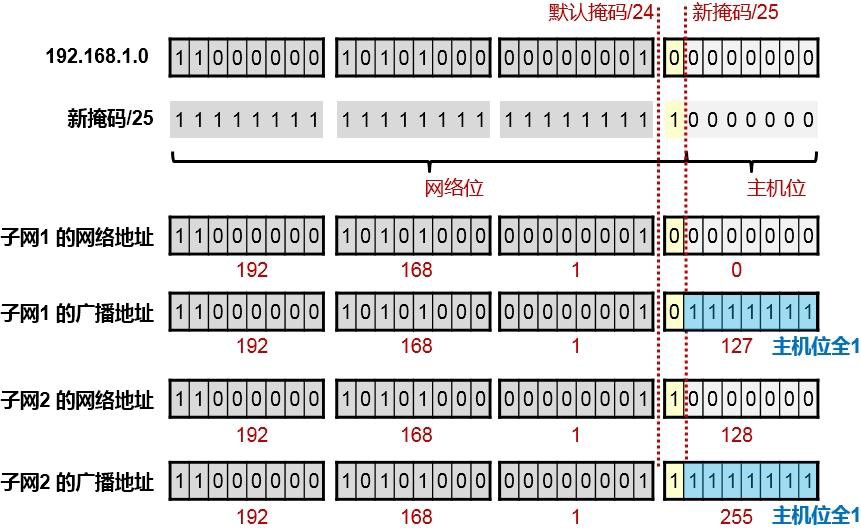

得出广播地址:¶

上面分别列出了子网1及子网2的广播地址,其实很简单,就是把各个子网的主机位全部置1即可。因此子网192.168.1.0/25 的广播地址为192.168.1.127 ;子网192.168.1.128/25 的广播地址为192.168.1.255;

得出每个子网的可用IP地址数量:¶

经过上面的计算,得出了子网1及子网2的网络地址和广播地址,那么每个子网可用的IP地址也就出来了,因为可用IP地址实际上就是该子网的网络地址与广播地址之间夹着的那些个IP地址。所以实际上我们对192.168.1.0/24这个C类地址段,用了一个变长后的子网掩码长度:/25,也就是向主机位借1位后产生出了2个子网,每个子网有126个可用IP地址。这里有个公式:

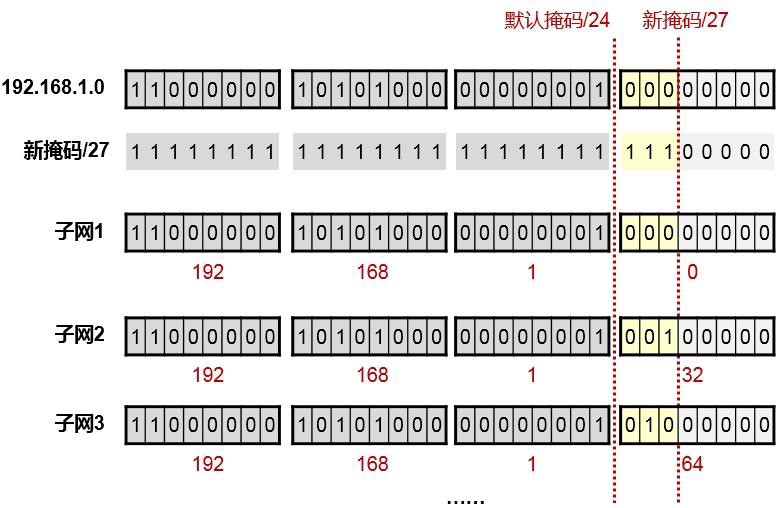

子网划分例子二¶

假设现在有一个IP地址:192.168.1.64/27,想把这个地址配置在一台PC上,是否可行?

由于该地址的默认掩码长度为/24,而新掩码长度为/27,因此网络位向主机位借了3位,产生了8个子网,每个子网内包含的所有IP地址数量为32,也就是2的5次方(5是剩余的主机位数)。

现在开始把每个子网罗列一下,结果发现192.168.1.64/27这个IP地址,其实是其中一个子网的网络地址,既然是网络地址,当然是不能分配给PC用的了。

- VRP 基础

Versatile Routing Platform 通用路由平台,简称VRP,是华为数据通信产品的通用操作系统平台,它以IP 业务为核心,采用组件化的体系结构,在实现丰富功能及特性的同时,提供基于应用的可裁剪能力和可扩展能力。VRP其实就是运行在华为数通产品上的操作系统,就像Windows系统对于PC,iOS系统对于苹果终端。我们调试VRP系统的数通设备最常用的方法就是通过命令行界面(CLI):

下面我们初步了解一下VRP的命令行界面:

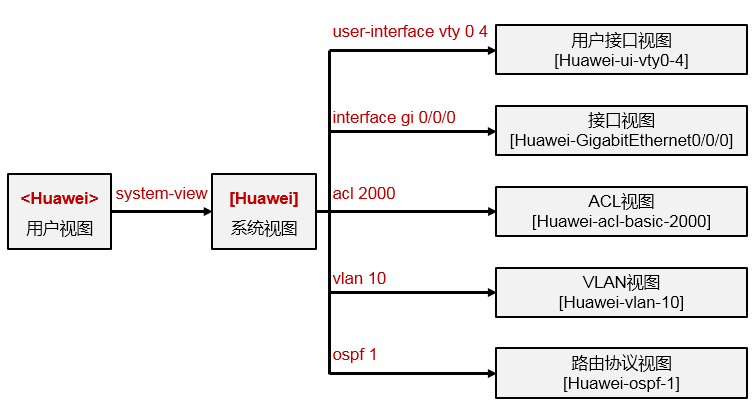

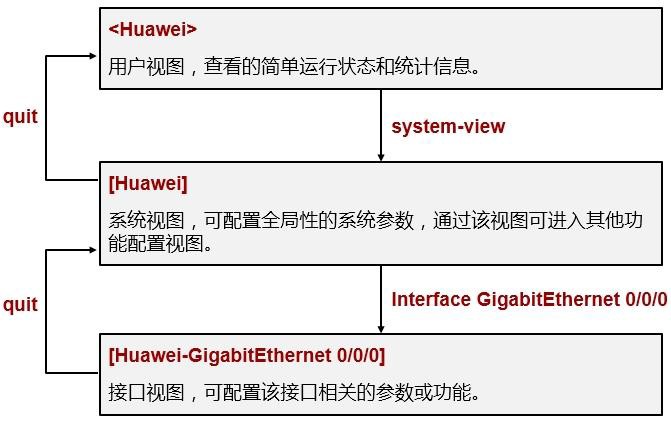

命令视图(View)的概念¶

VRP的命令行界面定义了各种命令视图(View),要对特定协议或者功能进行配置就需要进入到相应

的视图。视图的定义使得命令行的配置更模块化,也更严谨、更层次化。例如一台路由器有多个接口, 如果要修改某个接口的IP地址,那么就需要进入该接口的配置视图,然后进行配置,而在这个接口的配置视图中执行的相关命令,只会影响该接口。因此VRP规定,在适当的视图下执行适当的命令。

刚登陆设备时在命令行界面你可能会看到“\<Quidway>”或者“\<Huawei>”这样的提示符,“\<>”尖括号提示你当前所处的视图是“用户视图”,而“Quidway”或“Huawei”是该设备的名称,当然设备名称是可以修改的。在不同的视图下我们会看到不同的提示符。例如上图所列举的几种视图以及进入该视图使用的命令。从当前视图进入到下一级视图需要使用相应的命令,从当前视图退回到上一级视图可使用“quit”命令:

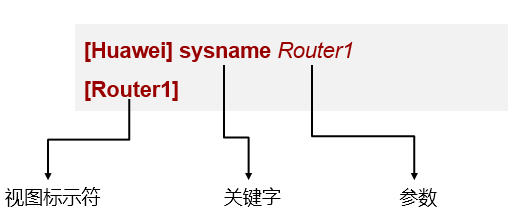

基本命令结构¶

在命令行界面中,通过输入特定的命令及参数来完成对设备的调试,例如上面的例子, sysname

Router1,这条命令中“sysname”是关键字,而“Router1”是参数,这条命令的意思就是将该设备的名称修改为Router1,命令输入完毕后按回车,就会发现系统的提示符发生了改变,变成了“[Router1]”。这条命令需要在系统视图下完成,如果在用户视图下尝试输入这条命令,则会报错。

使用命令行的帮助功能¶

命令提示:¶

在设备的配置过程中,由于命令较多,出现记忆模糊的情况非常正常,VRP的命令后界面为我们贴心地提供了命令提示功能,当一条命令中某个关键字只记得开头的几个字母时,可在键入开头字母后紧接着键入“?”问号,例如“ip rou?”,注意在问号前面没有空格,系统即会自动弹出提示信息,提示当前“rou”这三个字母开头的关键字有哪些:

还有一些情况,可能是当前关键字输入完毕后,忘记了下一个关键字或者参数该输入什么,那么就

可以在当前关键字输入完毕后键入空格,然后再输入一个“?”,系统会自动弹出可选择的关键字或参数的提示信息:

命令补齐:¶

输入命令时,关键字无需完整输入,例如要输入“system-view”,可先输入“sys”,然后按tab 键,系统会自动补齐sys开头的关键字,如果sys开头有多个关键字,可以多次按tab键切换到自己想输入的那一个:

在命令弄熟悉之后,其实可以采用简化的命令书写方式,例如“interface gigabitEthernet 0/0/0”

等同于“int g 0/0/0”,采用后者来配置设备,工作效率大大提升,当然逼格也跟着瞬间提升了好几个档次。

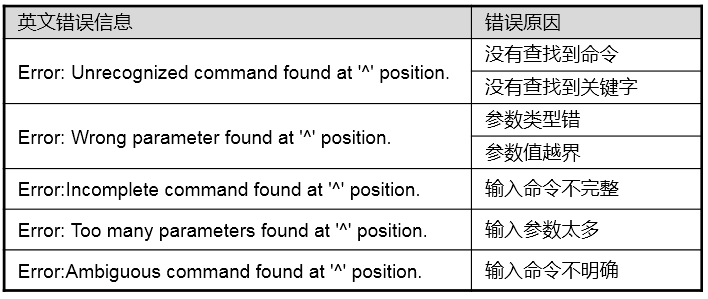

语法检查¶

CLI的语法检查功能帮助我们发现命令中的错误:

[Huawei]a

其他的提示如下:

基础配置命令¶

修改设备名称:¶

配置设备的接口:¶

这里GigabitEthernet0/0/0指的是千兆接口GE0/0/0,其中GigabitEthernet表示千兆以太网接口,另

外,后面的三个数字分别是“槽位号/子卡号/接口序号”,具体的含义如下: 槽位号:表示该接口所属单板所在的槽位号。

子卡号:表示该接口所属的子卡号。

接口序号:表示接口在板卡上的编排顺序号。

管理及维护设备配置:¶

\<SW1> save 在设备上的每一个配置操作,都会记录在设备的当前配置“current-configuration”之中,也就是当 前运行中的配置,这个配置文件是保存在动态内存中的。可以使用**display current-configuration** 命令查看当前运行中的配置。

设备重启之后current-configuration将会丢失。因此为了保证设备重启后不丢失当前已经完成的配置,则要在配置变更后,将current-configuration保存到saved-configuration,也就是保存到启动配置文件,这样的话,设备重启后将会读取已保存到硬盘中的启动配置文件,然后将其加载到当前配置中运行。使用**save**命令来将current-configuration保存到启动配置文件,**save**关键字如果不指定可选参数configuration-file(文件名),则配置文件将保存为“vrpcfg.zip”。“vrpcfg.zip”是系统缺省命名的配置文件,初始状态是空配置。

另外,如果要清除已保存的启动配置文件,使得下次设备重启后能恢复出厂配置,可使用如下命令:

\<SW1> reset saved-configuration

如果要备份已保存的启动配置文件,可使用如下命令:

\<SW1> copy flash:/vrpcfg.zip flash:/cfgbackup.zip

- 使用 Console 接口管理设备

一般来说,网络设备(例如路由器、交换机、防火墙等)在设备面板上都会有一个用于配置和管理的专用接口 – Console口(或CON口),通过这个接口,并使用专用的线缆将该设备与PC(网络管理员所使用的电脑)进行连接,即可实现对设备的配置及管理。

对设备上线前的初次配置及管理,往往采用此种方式。我们通过以下四个步骤来了解一下如何使用Console 口对设备进行管理及配置:

- 认识设备的Console口。

- 准备好相关线缆。

- 搭建配置环境。

- 通过终端管理软件登陆设备。

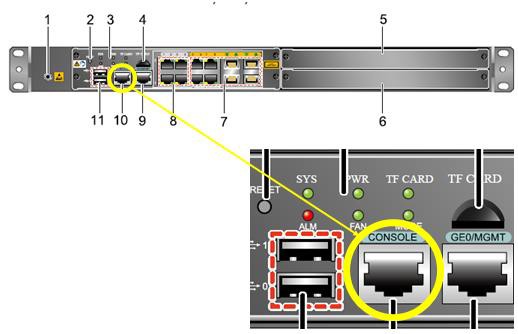

认识设备的Console口¶

华为网络设备面板上的Console口都有做相关标记,比较容易识别,如下图(以防火墙E1000E为例)。

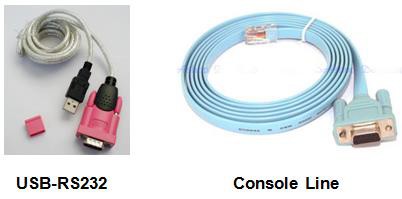

准备好相关线缆¶

Console线缆(上图右侧的线缆)一端为RJ45水晶头,一端为串口接头。RJ45接头用于连接网络设备的Console口,线缆另一端的串口用于连接PC,现在大部分台式PC在主机箱后都有串口可以直接连接

Console线缆。只要将被配置设备与PC按照上述方式进行连接,就完成了配置环境的搭建。环境完成后,在PC上使用终端管理软件即可通过网络设备的Console接口、使用命令行的方式对设备进行管理。

但是大部分笔记本电脑上并没有串口,因此如果使用没有串口的笔记本电脑调试网络设备,则需要另一根线缆来转接,这就是上图左侧所示的USB-RS232的线缆,这根线缆可以说是网络工程师必备的工具, 各大电子产品商铺均有销售(USB-RS232需要安装驱动才可使用,驱动程序安装包随线缆附送)。

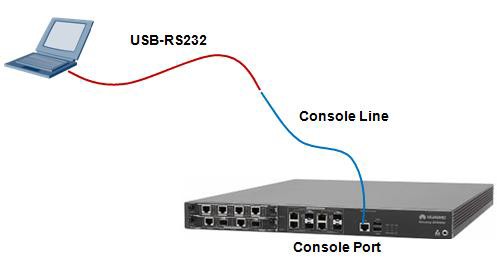

搭建配置环境¶

如果使用笔记本电脑来配置路由器、交换机或者防火墙,则可参考如上图所示的线缆连接方法。将USB-

RS232线缆的USB接口接到笔记本电脑上,同时线缆的另一头连接Console线的串口,Console线的另一端,也就是RJ45水晶头这一端则接到设备的Console口上。

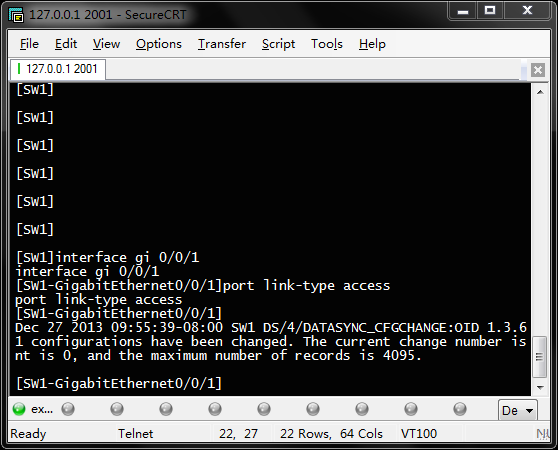

通过终端管理软件登陆设备¶

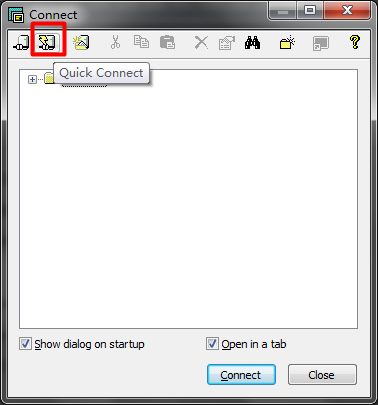

在PC上,我们需要准备好终端管理软件,用于管理和配置网络设备。常用的终端管理软件有:Windows 自带的终端管理工具(WIN7系统没有自带该工具)、SecureCRT以及Putty等。本文档以SecureCRT 为例做讲解。请自行下载SecureCRT并安装。安装完成之后,打开软件。

在自动弹出的Connect对话框中选择下图所示的按钮来创建一个连接:

在弹出的Quick Connect对话框中选择“serial”,即使用串行接口管理设备:

进一步配置如下:

注意在此处,Port的选择视个人情况而定,当用笔记本通过USB-RS232线缆接Console线管理设备时, USB-RS232线缆是需要在PC的windows系统上安装驱动程序的,安装完成的结果是在系统中会出现一个通过USB接口模拟的COM口,而该COM口的编号可在右键“我的电脑”-“计算机管理”-“设备管理”-“端口(COM和LPT)”中看到,此处显示的编号要与SecureCRT中选择的Port对应:

另外,Band Rate也就是波特率,这一项要看设备Console口的默认参数而定,我司的大部分路由、交换及防火墙设备此处设置的值都是9600。

完成后点击“Connect”即可登陆设备。当然,第一次使用Console登陆设备才需要依照上述步骤来操作,往后再次登陆,则可使用上面已创建好的连接方式快速登陆。

- eNSP 华为官方数通模拟器

eNSP(Enterprise Network Simulation Platform)是一款华为自研的、免费的、可扩展的、图形化操作的网络仿真平台,主要对企业网路由器、交换机及防火墙等设备进行软件仿真,完美呈现真实设备实景,支持大型网络模拟,让广大用户有机会在没有真实设备的情况下能够模拟演练,学习网络技术。

eNSP下载链接:点击此处。或者在http://enterprise.huawei.com/搜索eNSP即可找到eNSP软件下载页面。

eNSP的安装非常简单,安装完成后打开软件即可看到主界面。软件的操作也比较简单,需要什么设备就直接从设备栏拖动图标然后在拓扑画布上松开即可。完成拓扑的搭建和连线后,点击工具栏中的绿色播放按钮即可经设备开启。等待设备完成开启后,双击设备即可进入CLI控制台进行配置了。

eNSP不仅支持AR路由器、S57/S37交换机、USG5500防火墙等主流数通设备的模拟,还支持无线设备, 以及DNS、FTP、HTTP服务器和客户端模拟等,更加支持模拟器与物理网卡的桥接,使得实验的扩展性

得到极大的提升。目前,华为数通认证HCIE RS的TroubleShooting考试也是使用NSP软件进行。接下来我们看一个例子,使用eNSP完成第一个实验。

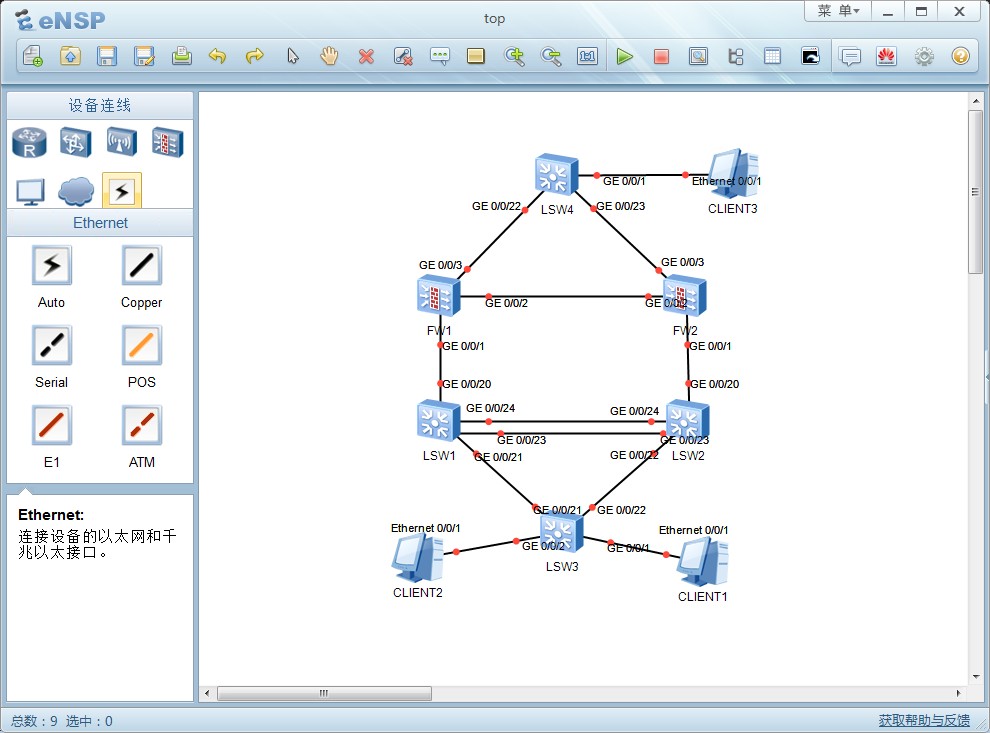

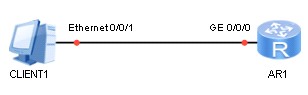

实验拓扑¶

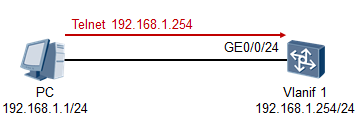

目标网络拓扑如上图所示:一台PC与一台路由器通过网线直连。

现在我们要在eNSP中搭建这个实验环境,并且完成PC和路由器的配置,使得PC能够访问路由器(能够ping通路由器)。为PC配置的地址是192.168.1.1/24,网关地址是192.168.1.254;为路由器的GE0/0/0接口配置的地址是192.168.1.254/24。

环境搭建¶

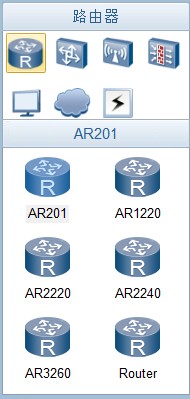

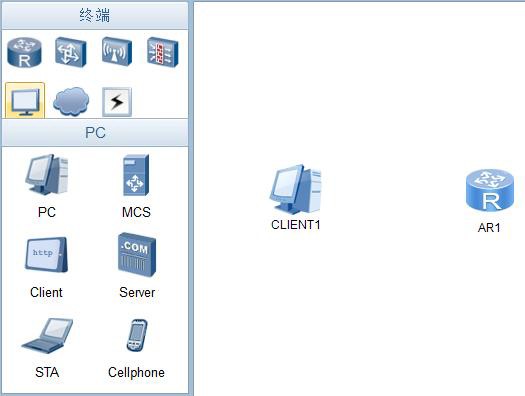

使用eNSP搭建上述环境是非常简单的。新建一个实验后,从左侧的设备列表中选择“路由器”,如下图所示:

此处有多种型号的路由器可以选择,在本实验中,我们挑选的是AR2220,因此用鼠标左键点住AR2220

的图标不放,然后拖动到画布中再松开即可:

接下来继续添加PC,点击设备列表里的“终端”类型,选择PC,然后拖放到画布上:

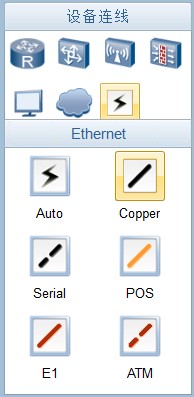

接下来完成设备的连线,在左侧设备列表中选择“设备连线”图标,在线缆列表中选择铜缆“Copper”:

点选成功后,鼠标指针会发生变化,随后在交换机和PC上分别点击并选择相应的互联接口,即可实现

设备相应端口之间的连线:

如此一来拓扑就搭建完成了,现在点击工具栏上的启动按钮:

上面的按钮点击后会将所有设备启动。如果实验拓扑比较大,建议不要使用上面的启动按钮集体启动设备,可以对设备进行逐台启动,也就是分别对设备点击右键,然后选择启动。待所有设备都启动完毕后即可开始实验。

配置实现¶

首先完成路由器的配置,双击路由器的图标即可打开命令行界面:

此时打开的便是AR1的命令行界面,在该命令行界面中完成对路由器的基本配置,如下:

接下来开始配置PC,双击Client1,在出现的配置界面中如下填写:

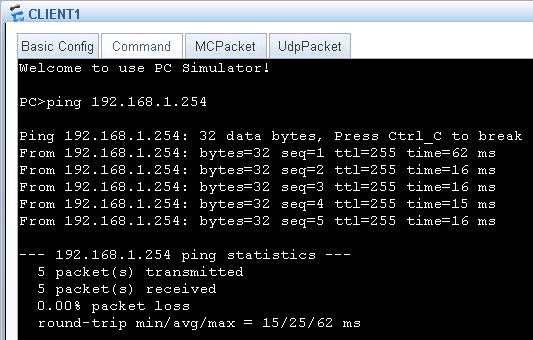

填写完成之后,点击应用即可。接下来就可以进行连通性的测试了,双击PC的图标,选择“命令行” 选项卡,然后就能看到CMD界面,在CMD界面中我们可以进行基本的ping、tracert等操作,例如测试

PC到路由器的联通性,可以ping 192.168.1.254:

从ping的回显能看到,PC现在能够ping通路由器了,到此实验就成功了。

eNSP能够保存实验拓扑及配置以便下次继续进行操作,非常的方便。如果需要保存实验环境以及拓扑中各设备的配置,则在完成实验操作后,先为实验拓扑中每台设备(PC、Client无需做这个操作)使用

**save**命令保存配置(注意,务必要先在设备的CLI界面中使用save命令保存配置):

\<huawei> save

然后再点击eNSP工具栏的“保存”按钮将拓扑及配置文件保存在指定目录即可。

交换基础¶

- 二层交换基础

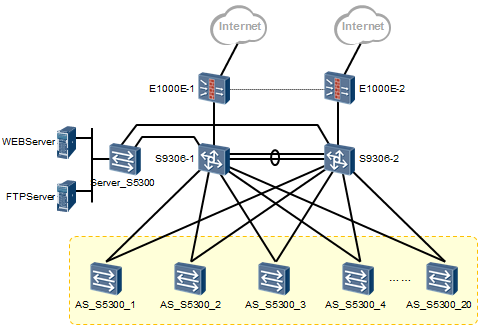

一个典型的数据网络是由路由器、交换机、防火墙、负载均衡器等网络设备构成的。其中交换机一般来说是距离终端设备(PC、服务器等)最近的网络设备,例如上图中黄色背景所标注的设备。

网络接入层(可以理解为在一个网络中,用于终端设备接入的逻辑层次)的交换机一般为二层交换机,所谓的二层交换机指的是针对数据的二层头部(以太网帧头)中的MAC地址进行寻址并转发数据的交换设备。二层交换机不具备路由功能,它工作在OSI七层模型的第二层,因此被称为二层交换机。

二层交换是以太网技术的一个非常基础的概念。那么什么是以太网二层交换(Layer 2 Switching)呢?

为了将内网中的多台PC互联起来,使得PC之间能够以最简单的方式进行通信,我们往往会用一台二层交换机来连接PC,如下图:

在上图中,PC1、PC2、PC3与PC4连接在同一台以太网二层交换机(后续简称为二层交换机)上,我们可以笼统地说,连接在这台交换机上的PC都属于同一个LAN。这些PC都拥有同一个网段的IP地址,同时也处于同一个广播域(Broadcast Domain)中,所谓的一个广播域,指的是一个广播数据所能泛洪的范围,举个简单的例子:PC1发送一个广播数据帧,交换机收到这个广播数据帧后,会为除了接收该数据帧的接口之外的其他所有接口都拷贝一份然后发送出去,接在同一交换机上的所有的PC都会收到这个广播数据帧并且都要去分析它(即使它们可能并不需要这个数据并且最终将收到的数据帧丢弃,但check数据的过程仍然会消耗设备资源),因为它们属于同一个广播域。

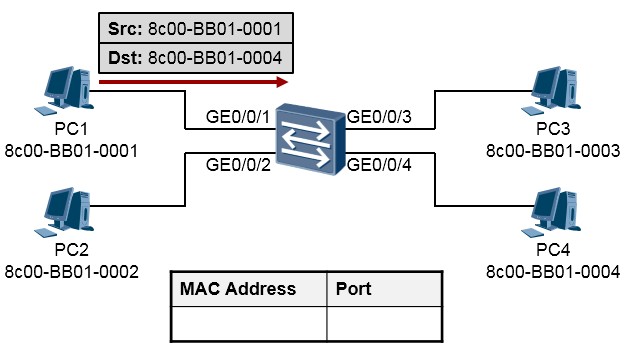

现在来分析一下,PC1发送一个数据给PC4时,都发生了什么,以此来理解二层交换的工作机制。

-

PC1构造IP数据包,IP报文头部里的源IP地址为自己的网卡IP地址,目的IP地址为PC4的IP地址。上述

IP数据包为了能够在以太网环境中传输,还需要封装一个以太网的头部(帧头)。在以太网头部中源

(Source,Src)MAC地址为8c00-BB01-0001,目的(Destination,Dst)MAC地址为8c00-BB01-0004, 如下图所示。

下图只描述了数据帧的帧头(源、目的MAC地址字段),对于IP包头以及数据载荷部分不在图中描述。

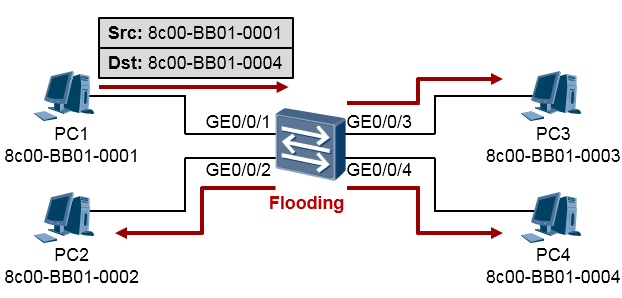

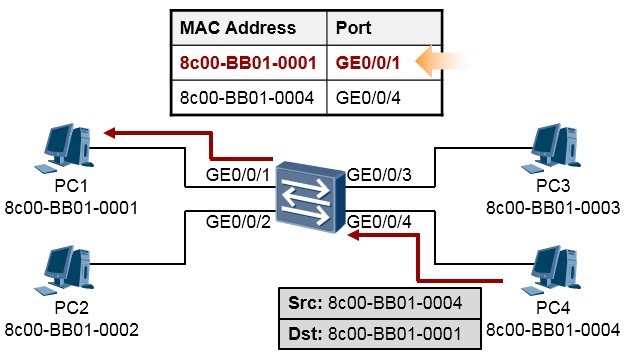

- 这个数据帧被发送到了PC1所连接的交换机上。我们知道路由器都维护了一张路由表,用于指导数据转发,而交换机在做二层交换的时候依据的是**MAC地址表(MAC Address Table)。MAC地址表中包含的表项指示出MAC地址与交换机某个接口的对应关系。在初始情况下,交换机的MAC地址表是空的。当交换机收到PC1发送出来的这个数据帧时,它首先在自己的MAC地址表中查询该帧的目的MAC地址, 由于此时在MAC地址表中,并没有8c00-BB01-0004这个地址的条目,因此交换机将对这个数据帧进行**泛洪Flooding,所谓泛洪就是将这个数据帧从除了收到它的接口之外的其他所有接口都发一份拷贝。这样做的目的事实上是:“哥不知道你在哪,哥索性就全都发一份,碰碰运气”。如下图所示:

-

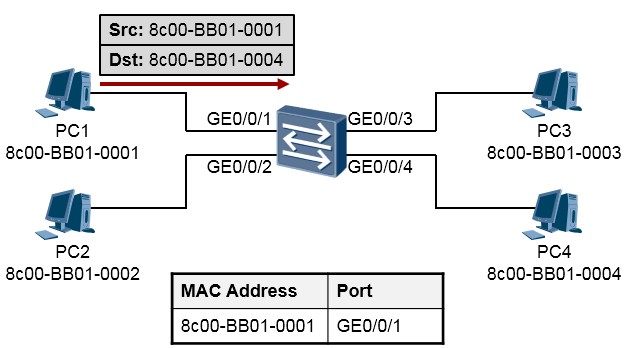

接下来,交换机将该数据帧的源MAC地址(也就是PC1的MAC地址)学习到MAC地址表中,与接口

GE0/0/1进行关联。这样,交换机就学习到了一个MAC地址条目。通过该条目,交换机知道8c00-BB01-

0001这个MAC地址,连接在GE0/0/1接口,如下图所示:

-

由于交换机的泛洪行为,导致连接在该台交换机上的其他PC都会收到这个数据帧,除了PC4之外的其他PC在收到这个数据帧之后,将bit流还原成帧并查看帧头部的目的MAC,发现该MAC与本机的MAC 并不一致,因此判断这个数据帧并非发送给自己,于是丢弃之。而PC4在收到这个数据帧并查看目的

MAC发现,这个数据帧的目的MAC与自己的MAC是相同的,因此判断这个数据帧是发送给自己的,于是进行CRC校验(校验数据帧的完整性),校验成功后将以太网头部解封装,将内层的IP数据将给IP协议栈处理。然后,进一步查看IP头部,发现IP头部中的目的IP地址就是本机的IP,于是将IP头部解封装, 将内层的载荷交给上层协议处理。如此一来PC1发送给PC4的数据就完成了传输。

-

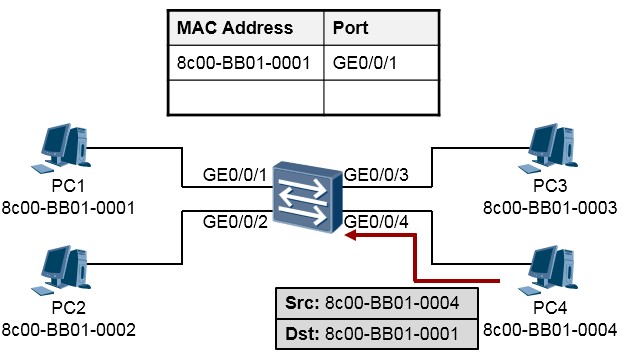

现在,PC4要回送数据给PC1,数据的构造如下图所示:

-

交换机在收到这个数据帧后,首先在自己的MAC地址表中查询目的MAC地址8c00-BB01-0001,发现有一个匹配的表项,而且该表项指示这个MAC地址连接在GE0/0/1接口上,于是交换机将这个数据帧从

GE0/0/1接口发送出去。同时交换机还会将数据帧的源MAC地址8c00-BB01-0004学习到自己的MAC地址表中,并与接口GE0/0/4进行关联,如下图所示:

-

这个数据帧最终被PC1接收到,这就完成了一个在以太网环境中的数据交互过程。

小结一下:所谓的以太网环境中的二层交换,就是指的当一台交换机收到一个数据帧时,分析数据帧头部的目的MAC地址,在MAC地址表中查询这个MAC地址,如果有匹配项,则将数据帧从该匹配项所关联的接口转发出去;如果没有匹配项,则将数据帧进行泛洪。所以:以太网二层交换是基于数据帧的帧头中的目的

MAC地址进行查询的,并且是在MAC地址表中进行查询。所以掌握MAC地址表的查询及阅读是非常有必要的,在华为交换机上,可使用**display mac-address**命令可看到MAC地址表。MAC地址表是交换机能够正常工作的非常基础的数据表。

-

VLAN 及 Trunk

- VLAN 的基本概念

对于一台二层交换机来说,缺省时整机的所有接口属于一个广播域。这意味着,只要连接到这个交换机的

PC都配置在同一个IP子网内,即可直接进行互相访问,而且更重要的一点是,处于同一个广播域内的某个节点只要发送一个广播数据帧,在这个广播域内的所有其他节点都会收到这个数据帧,并且耗费资源来处

理(即使它可能并不需要这个数据帧)。当这个广播域变得特别大(交换机上连接的用户数量特别多)时网络就非常有可能被大量的广播消耗掉大量资源。

另一方面,实际的网络中经常存在这样的需求:连接在同一个交换机上的用户有可能是不同的业务单元或者部门的,用户希望对它们进行隔离,或者以独立的网络单元进行管理。

基于上述需求,引入了VLAN的概念,所谓VLAN,也即Virtual LAN,是一个虚拟的、逻辑的LAN,通过VLAN

技术,可以在交换机上,根据接口等信息进行VLAN的划分,从而实现设备的隔离。

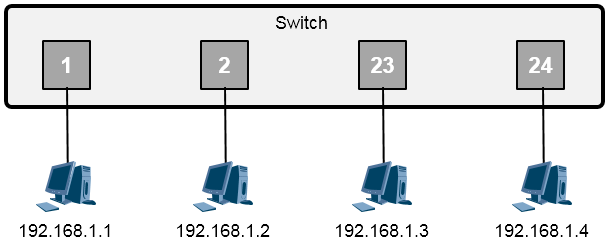

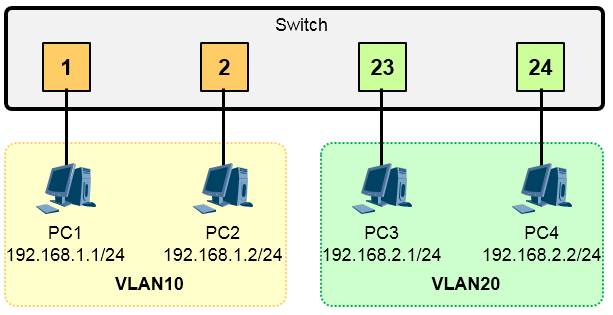

在上图中,用户在交换机上创建了2个VLAN,然后将相应的接口添加到指定的VLAN中——将接口1、2添加到了VLAN10,将接口23、24添加到了VLAN20。这样一来,接口1、2所连接的PC就加入了VLAN10,它俩处于同一个LAN、同一个广播域内,这些PC只要配置同一个网段的IP地址,就能够直接进行互访了(我们将这种通信称为二层互通)。而接口23、24处于VLAN20,即处于另一个LAN、另一个广播域。属于VLAN20 的PC之间能够直接进行互访。不同的VLAN之间,用户是被隔离的(除非借助路由设备,此时,这种这种通信行为就是三层通信了),当然,一个VLAN内的广播数据帧并不会被泛洪到另一个VLAN,因为它们属于不同的广播域。

有了VLAN技术,网络设计将更加灵活。VLAN是一个虚拟的LAN,不受地理环境的限制。我们可以根据实际的业务需要,灵活地进行VLAN的规划,例如将不同的业务部门规划到不同的VLAN中。另外,VLAN还可以跨交换机实现,因此VLAN的成员,例如业务PC,所处的位置就非常灵活了。

下面做一个小结:¶

- 一个VLAN中所有设备都在同一广播域内,不同的VLAN为不同的广播域;

- 相同的VLAN内的用户可以直接进行通信,这种通信被称为二层通信,而不同的VLAN之间互相隔离, 广播数据不能跨越VLAN传播,因此不同VLAN之间的设备一般无法直接互访,需通过具备三层路由功能的设备(例如路由器、三层交换机或防火墙等)实现相互通信;

- 一个VLAN一般使用一个逻辑子网(或者说一个IP子网);

- VLAN中成员多基于交换机的接口分配,此时划分VLAN就是将交换机的接口分配到特定的VLAN中;另外,华为交换机也支持基于IP地址划分VLAN等其他VLAN划分方式。

- VLAN工作于OSI参考模型的第二层;

- VLAN是交换机的一个非常基本的工作机制。

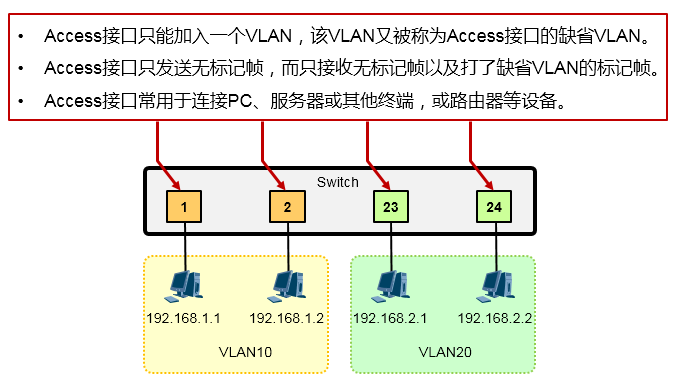

- Access 类型的接口

交换机的物理接口缺省都是二层接口,所谓的二层接口,简单的说就是不能直接配置IP地址、不能隔绝广播、无法直接处理IP数据包三层头部的接口,这种接口只能根据数据帧的头部信息进行帧处理。在华为的交换机上,二层接口的链路类型(Link type)有:Access、Trunk和hybrid三种,以S9300交换机为例,其接口缺省为hybrid类型。

VLAN是二层交换机的一个底层技术,二层交换机工作的方方面面都可能与VLAN有关系,包括接口的工作。我们需要根据实际需要,将交换机的接口设置为适当的类型。

Access类型的接口只能加入一个VLAN,这种类型的接口一般用于连接PC、服务器等终端设备,或者连接路由器、防火墙等设备,如下图所示。Access接口只能发送不带标记的数据帧(也就是untagged帧),通常也只接收untagged帧。

- Trunk 类型的接口

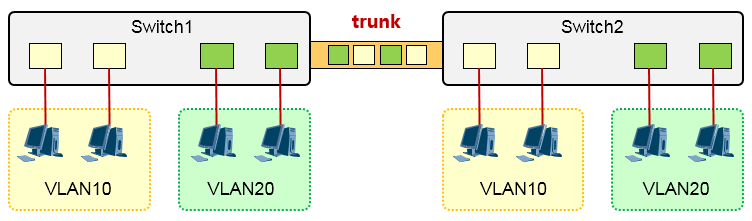

在一台交换机上,可以创建多个VLAN以便对应不同的业务,然后基于交换机的接口,将不同的接口划分给不同的VLAN。

如果分别在两台交换机上部署了VLAN,并且做了统一性的VLAN规划,这时两台交换机对接的时候就需要谨慎,因为这两台交换机之间互联的链路需要承载多个VLAN的数据,如果某个特定VLAN的数据从一台交换机发送出来,经过交换机之间的链路到达另一台交换机,后者如何判定这个数据到底应该放入哪一个

VLAN呢?这里就需要一种“标记”手段。在将数据送出这个互联接口前,给数据做上相应的标记(Tag) 来标记这个数据是从哪一个VLAN跑出来的(如上图所示),这样,对端交换机在收到这个数据之后,就能够根据前者对数据所做的标记来识别数据究竟是属于哪一个VLAN的。此时,我们称两台交换机之间的互联链路为一段干道链路。这里提到的“标记”手段,常被称为干道协议,一个众所周知的公有标准是802.1q, 或者叫Dot1q,由于是公有标准,因此所有的交换机厂商都遵循该标准。

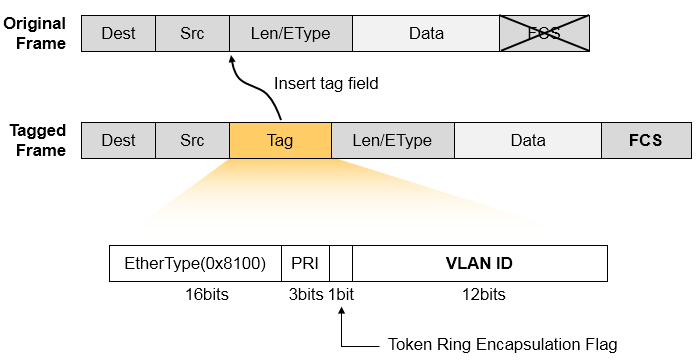

Dot1q针对数据帧的处理方式很简单,就是在原始的以太网数据帧头中插入一个Dot1q的字段,同时重新做

CRC校验。在插入的Dot1q字段中,就有VLAN-ID字段用来指示这个数据帧所属的VLAN,我们将没有携带Dot1q Tag的数据帧称为原始以太网数据帧或无标记帧(Untagged Frame),将携带了Dot1q Tag字段的数据帧称为标记帧(Tagged Frame),如下图所示:

- 接口类型小结

以太网交换机的二层接口类型¶

华为交换机的二层接口支持三种链路类型(Link type),当接口工作在二层模式时,必须使用这三种类型中的一种:

Access:¶

Access接口常用于连接PC、服务器或其他终端,或路由器等设备。Access接口只能加入一个VLAN, 一旦加入特定VLAN后,该接口所连接的设备也就加入了该VLAN。

Trunk:¶

Trunk接口一般用于交换机之间连接的端口,trunk口可以加入多个VLAN,可以接收和发送多个

VLAN的Tagged帧。当交换机的接口连接的对端设备(例如路由器或防火墙)的接口部署了以太网子接口,那么在这种场景下,交换机的接口也需配置为trunk类型(或者Hybrid类型)。

Hybrid:¶

可以用于交换机之间连接,也可以用于接用户的计算机,hybrid口可以属于多个VLAN,可以接收和发送多个VLAN的Tagged帧。可根据需求灵活设置特定VLAN的数据帧在发送时是否打标记

(Trunk接口只能设置一个VLAN在发送数据帧时不打标记,而hybrid接口则可设置多个VLAN在发送数据帧时不打标记)。

接下来,我们看看各种类型的接口在收、发数据帧时的特点。

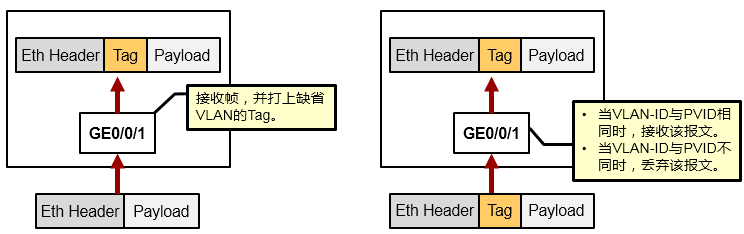

Access口接收帧¶

- 如果该帧是Untagged帧,则接收帧并打上接口的PVID(也就是该Access接口的default vlan或缺省VLAN);

- 如果该帧是Tagged帧,则当其VLAN-ID与接口PVID相同时,接收该帧,否则丢弃。

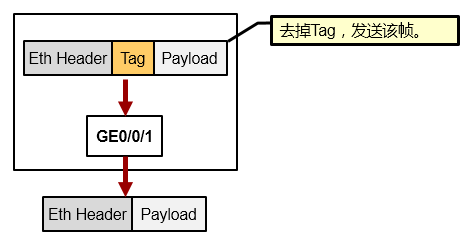

Access口发送帧¶

在发送数据帧时,剥离其Tag,发出的帧为原始以太网帧,也就是Untagged帧。

由于Access接口通常用于连接终端设备,而终端设备通常是只能够识别Untagged帧的,因此Access接口在发送数据帧时,始终是不会携带标记的。

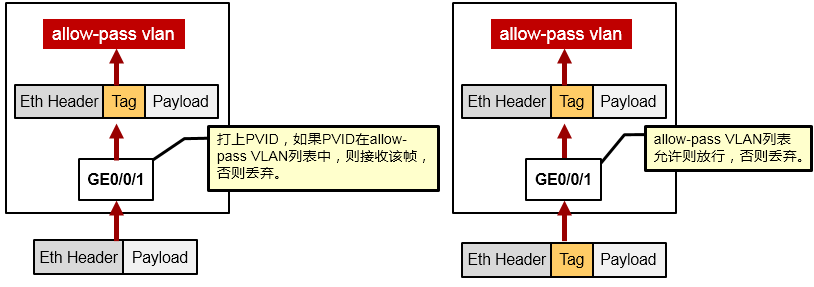

Trunk口接收帧¶

若收到的数据帧是Untagged帧,则为数据帧打上接口PVID的标记,然后,如果PVID在接口允许通行

(Allow-pass)的VLAN列表里,则接收该帧,若PVID不在允许通行的VLAN列表里,则丢弃。缺省时,Trunk接口的PVID为1,而且VLAN1缺省已经在允许通行的VLAN列表中。

若收到的数据帧是Tagged帧,且其VLAN-ID在接口允许通行的VLAN列表里,则接收该帧。否则丢弃。

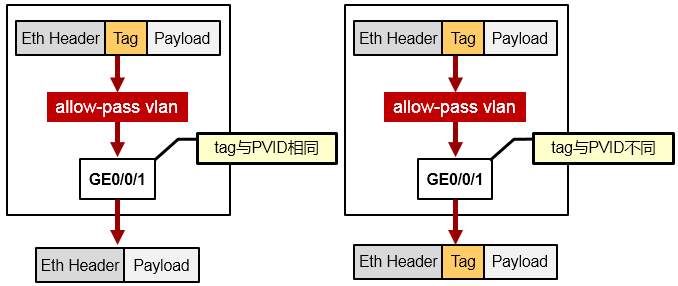

Trunk口发送帧¶

若该帧的VLAN-ID与接口PVID相同,且该VLAN在允许通行的VLAN列表中,则去掉Tag,发送数据帧。若该帧的VLAN-ID与接口PVID不同,且该VLAN在允许通行的VLAN列表中,则保持原有Tag,发送该

Tagged帧,而如果数据帧的VLAN-ID不在允许通行的VLAN列表中,则禁止从该接口发出。

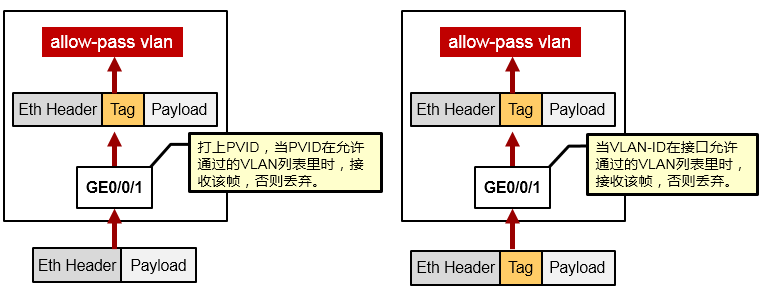

Hybrid口接收帧¶

若数据帧是Untagged帧,则将其打上PVID的Tag,然后,若PVID在接口允许通行的VLAN列表里则接收,否则丢弃。

若数据帧是Tagged帧,且其VLAN-ID在接口允许通行的VLAN列表里则接收该帧,否则丢弃。

Hybrid口发送帧¶

当该帧的VLAN-ID是接口允许通行的VLAN时,发送该帧,此时可以通过命令设置发送时是否携带Tag。

- VLAN 及 Trunk 的基础配置

VLAN相关的基础配置命令¶

在交换机上创建VLAN10并进入VLAN10的配置视图:

(可选)在特定的VLAN视图下添加VLAN描述:

[Quidway-vlan10] description TechVLAN

将特定的接口配置为access类型,并加入特定VLAN。下面以将GE0/0/1配置为access类型并加入

VLAN10为例:

将特定接口配置为trunk类型,然后配置trunk接口允许通行的VLAN:

(可选)配置Trunk接口的PVID。PVID所对应VLAN的流量从trunk接口发送出去时不会打Tag(也就是以Untagged帧发送),另外,如果Trunk接口收到Untagged帧,也认为是属于PVID所对应的VLAN。缺省时PVID是1。以下将GE0/0/24接口(该接口已经被配置为Trunk类型)的PVID修改为99:

[Quidway-gigabitEthernet0/0/24] port trunk pvid vlan 99

VLAN基础配置示例¶

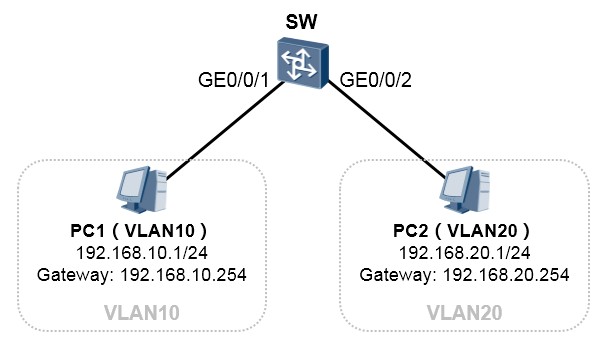

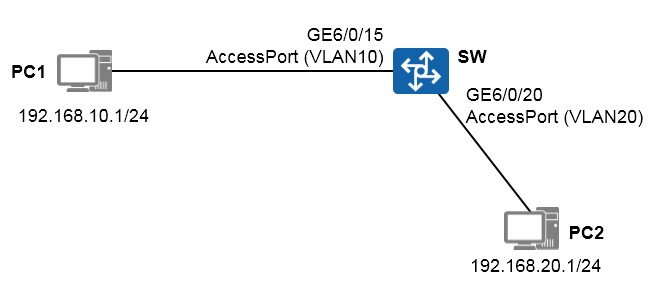

在交换机上创建VLAN10及VLAN20,将PC1(所在接口)划入VLAN10,将PC2划入VLAN20。

SW1的配置如下:

完成配置后,在SW1上可进行相应的查看:

另外,使用**display port vlan**命令也能查看每个接口的link type以及所加入的VLAN等信息。

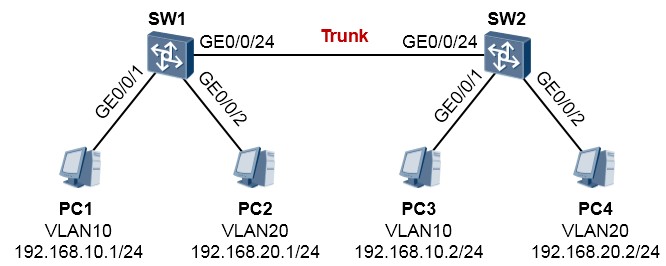

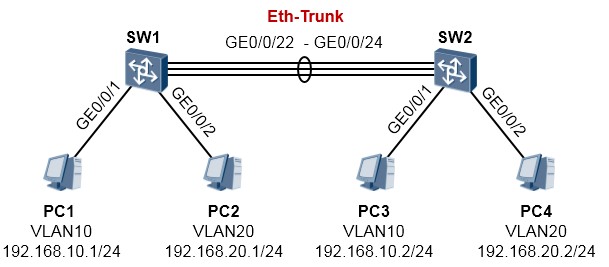

VLAN及Trunk基础实验¶

在SW1、SW2上创建VLAN10及VLAN20,将交换机连接PC的接口配置为Access类型并添加到如图所示的VLAN。然后,将两台交换机互联的接口配置为Trunk类型,并放通相应的VLAN,使得相同VLAN 内的PC能够直接通信。

SW1的配置如下:

SW2的配置如下:

完成上述配置后,同一个VLAN内的用户就能够互相通信了,例如PC1可以ping通PC3,而PC2也能够

ping通PC4。但是不同的VLAN之间是无法互访的。

- Hybrid 接口的配置

Hybrid是一种特殊的二层接口类型。与trunk类型的接口类似,hybrid类型的接口也能够承载多个VLAN的数据帧,而且它能够灵活的设置接口在发送数据帧时,是否携带tag。另一方面,hybrid类型的接口还能用于部署基于IP地址的VLAN划分。下面我们将针对几种使用场景,讲讲hrbrid接口的配置。

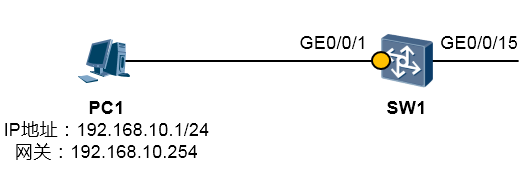

Hybrid接口用于连接终端PC¶

在上图中,PC1连接在SW1的GE0/0/1接口上,现在将SW1的GE0/0/1接口做如下配置:

以上命令将GE0/0/1接口配置为hybrid类型,以S5300交换机为例,接口缺省即为该类型,而且缺省将

VLAN1设置为PVID(缺省VLAN),并且接口已经放通VLAN1(缺省就配置了**port hybrid untagged vlan 1**)。因此在这个场景中,如果为SW1的Vlanif1配置一个192.168.10.0/24网段的IP地址,则PC1 与SW1即可实现互通。此时PC1被认为属于VLAN1。

如果我们期望将PC1规划在VLAN10中,那么配置修改如下:

上面配置中**port hybrid pvid vlan 10**命令用于将接口的PVID修改为10,这样当该接口收到PC1发送出

来的untagged帧时,就会认为这些帧来自于VLAN10;而**port hybrid untagged vlan 10**命令则用于将该接口加入VLAN10,使得PC1所发送的数据帧能够进入GE0/0/1接口(被该接口接收)从而进入交换机,另外,这条命令还使得交换机在从GE0/0/1接口向外发送VLAN10的数据帧时,以untagged的方式发送。因此完成上述配置后,PC1被认为属于VLAN10,并且能够ping通SW1的vlanif10接口IP地址:

192.168.10.3。

值得注意的是,在PC1发送的数据帧进入交换机SW1之后,如果SW1将数据帧透传处理,那么该帧从

GE0/0/15发出时,是否携带tag,则要根据GE0/0/15接口的配置而定。

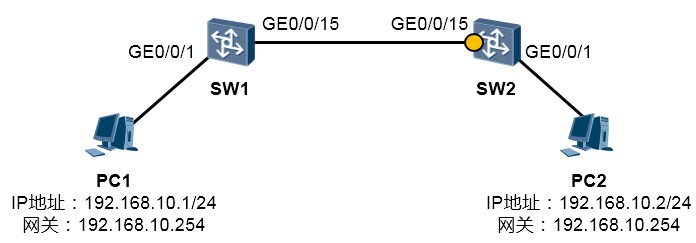

Hybric接口用于连接交换机¶

在上图中,SW1及SW2分别连接着PC1及PC2,我们将两台交换机的GE0/0/1配置为access类型,并且都加入VLAN10。现在SW1的GE0/0/15被配置为trunk类型,并且放通了VLAN10:

现在,来看看如果SW2的GE0/0/15接口采用hybrid类型该如何配置(纯粹为了讲解hybrid的配置而举例,

通常我们会为链路两端的接口配置相同的类型)。

由于对端接口(SW1的GE0/0/15)以tagged的方式发送VLAN10的数据帧,因此SW2的GE0/0/15接口也必须将VLAN10以tagged的方式处理:

**port hybrid tagged vlan 10**命令用于将GE0/0/15接口加入VLAN10,并且该VLAN的帧以Tagged方式

通过接口。

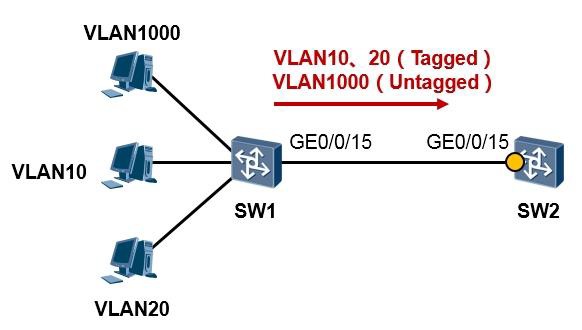

现在考虑另一种情况,如下图所示:

SW1左侧连接着VLAN10、20以及1000,现在SW1的GE0/0/15做了如下配置:

也即SW1在通过GE0/0/15往外发送数据帧时,对于VLAN10及VLAN20采用tagged帧的方式发送,而对

于VLAN1000则采用untagged帧的方式发送,那么如果SW2采用hybrid接口与其对接,此时该接口的配置应该如下:

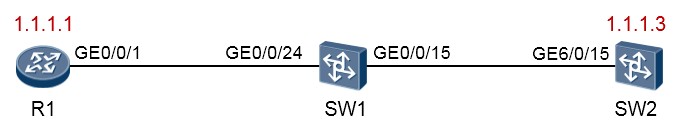

基于IP地址识别VLAN的功能¶

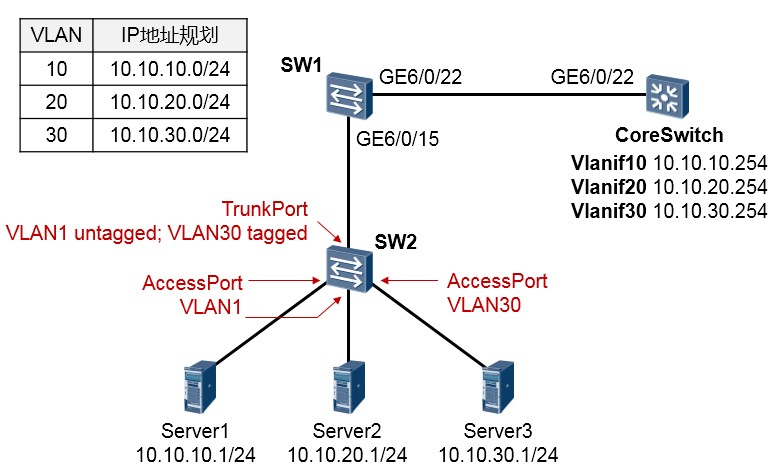

通常我们在划分VLAN时,是采用基于接口划分VLAN的方式,也就是通过命令,将交换机的接口加入某个特定的VLAN。某局点遇到个较为“特殊”的需求:在下图所示的网络中,SW2下挂着三台服务器, 其中SW2连接Server1、Server2的接口是Access类型接口,而且接口加入了VLAN1;连接Server3的接口也是Access类型,但是加入了VLAN30。而SW2上联SW1的上行口则是Trunk类型接口,该接口放通了VLAN1及VLAN30,并且PVID为1。

如此一来,SW1将会在GE6/0/15接口上收到三种类型的流量,分别是源地址为10.10.10.0/24网段的无标记帧、源地址为10.10.20.0/24网段的无标记帧,以及VLAN30的标记帧。现在需求是,根据规划,将上述各个网段在核心交换机CoreSwitch上对应到不同的VLAN,并且实现服务器之间的相互通信。由于某种原因,SW2是无法被直接管理的,因此只能在SW1及CoreSwitch上完成配置。

实际的需求是,在SW1上完成相应的配置,使得其在GE6/0/15接口上收到源地址为10.10.10.0/24网段的数据时,将其识别为VLAN10的数据,收到源地址为10.10.20.0/24的数据时,将其识别为VLAN20的数据,而VLAN30的数据需为标记帧。因此需在SW1上部署基于IP地址的VLAN划分。当然,这个接口在发送VLAN10及VLAN20的数据帧时,不能打标记,而在发送VLAN30的数据帧时,则需要打标记。

SW1的配置如下:

CoreSwitch的配置如下:

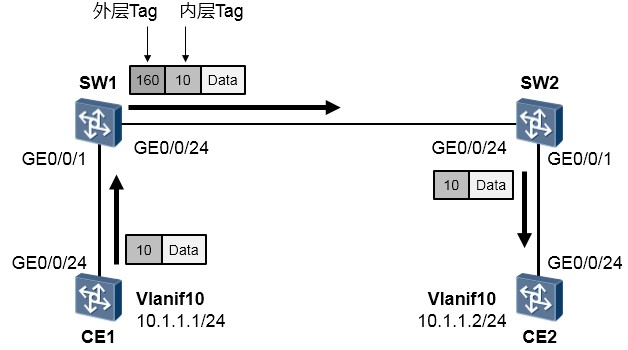

- QinQ

在上图中,CE1及CE2两台交换机都部署了VLAN10。两台交换机分别接入了SW1及SW2。SW1及SW2是两台公网交换机,且连接着其他设备,为了保证CE1及CE2能够在VLAN10中实现二层通信,而且不与其他设备产生冲突,公网为该业务分配了外层VLAN160。

在SW1及SW2上部署QinQ使得CE1能够访问CE2。图中的交换机以S5700 V2R1C00版本为例。

SW1的配置如下:

SW2的配置如下:

CE1的配置如下:

CE2的配置如下:

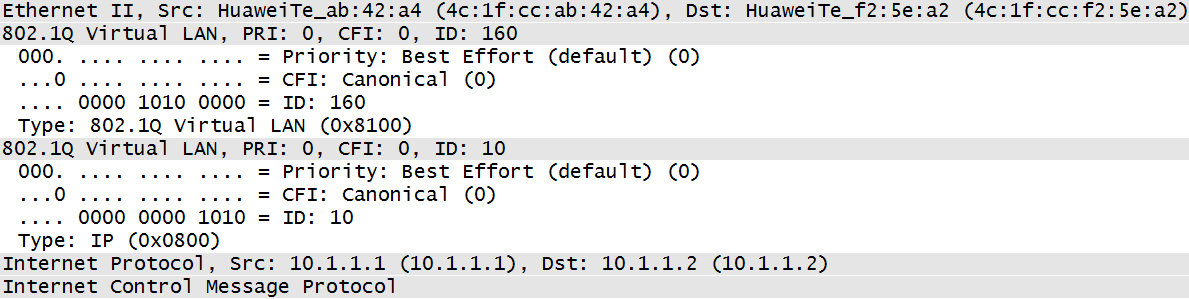

完成上述配置后,从CE1即可ping通10.1.1.2。在SW1及SW2之间可捕获如下ICMP Request报文:

留意到该报文携带两层VLAN-Tag,其中外层VLAN-ID为160,而内层为10。

在不同的网络规划或不同厂商设备的QinQ报文中,VLAN-Tag的TPID字段可能被设置为不同的值。为了和现有网络规划兼容,设备提供了QinQ报文外层VLAN-Tag的TPID值可修改的功能。用户通过配置TPID的值, 使得发送到公网中的QinQ报文携带的TPID值与当前网络配置相同,从而实现与现有网络的兼容。

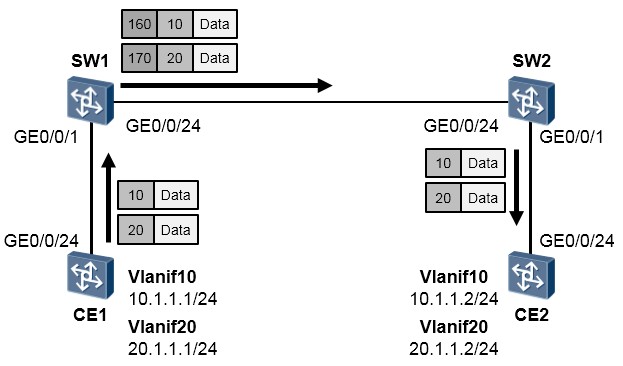

再看另一个例子,拓扑如下图所示。网络中的需求是,CE1发往SW1的数据帧中,携带VLAN-Tag 10的流量增加一层VLAN-Tag,外层VLAN-Tag为160;携带VLAN-Tag 20的流量增加一层VLAN-Tag,外层VLAN-

Tag为170。

SW1的配置如下:

SW2的配置如下:

CE1的配置如下:

CE2的配置如下:

- 二层接口、三层接口、以及 PVID、VLAN-ID 等概念杂谈

- 二层接口,可以简单理解为只具备二层交换能力的接口,例如二层交换机的物理接口,或者三层交换机的物理接口(一般而言,这些接口缺省时为二层模式,某些款型具备切换为三层模式的能力)。

- 二层接口不能直接配置IP地址,并且不直接终结广播帧(目的MAC地址为广播MAC地址FFFF- FFFF-FFFF的数据帧)。二层接口收到广播帧后,会将其从同属一个广播域(VLAN)的所有其他接口泛洪出去。

- 三层接口维护IP地址与MAC地址。

- 三层接口会终结广播帧,三层接口在收到广播帧后,不会进行泛洪处理。

- 二层接口在收到单播帧后,会在MAC地址表中查询该数据帧的目的MAC地址,然后依据表项指引进行转发,如果没有任何表项匹配,则进行泛洪。三层接口在收到单播帧后,首先判断其目的MAC 地址是否为本地MAC地址,如果是,则将数据帧解封装,并解析出报文目的IP地址,然后进行路由查询及转发。因此二层接口与三层接口在数据处理行为上也存在明显差异。

- 二层接口有几种类型(这里说的是以太网二层接口):access、trunk、hybrid。三层接口则没有上述类型。

-

三层接口有物理形态的,也有逻辑形态的,典型的物理接口如路由器的三层物理端口;逻辑接口如

VLANIF,以及以太网子接口,例如GE0/0/1.1。等等。VLANIF与其关联的VLAN的VLAN-ID对应,

- 三层接口维护IP地址与MAC地址。

- 二层接口不能直接配置IP地址,并且不直接终结广播帧(目的MAC地址为广播MAC地址FFFF- FFFF-FFFF的数据帧)。二层接口收到广播帧后,会将其从同属一个广播域(VLAN)的所有其他接口泛洪出去。

此外:

而以太网子接口,通常也会绑定相应的VLAN-ID,从而与相应的VLAN对接。这两种典型的三层接口均可以直接配置IP地址。

-

在以太网二层交换网络里,VLAN是一个非常基础的东西。每个VLAN都是一个逻辑的广播域,每个VLAN都使用对应的ID进行标识,这是VLAN-ID。

-

接口缺省VLAN标识,即PVID(Port Default VLAN ID),指的是二层接口上的缺省VLAN-ID(每个二层接口上有且只有一个VLAN-ID作为PVID),也就是说,PVID必定是某一个具体VLAN的VLAN-ID。PVID的作用是,当这个二层接口收到了流量,并且该流量不携带任何802.1Q Tag

(VLAN-ID信息),该接口便认为这些流量属于PVID对应的VLAN。当然,PVID还会影响接口发送数据帧,这里不再赘述。缺省情况下,所有接口的PVID均为VLAN1。

- 对于Access接口,缺省VLAN就是它允许通过的VLAN,修改接口允许通过的VLAN即可更改接口的缺省VLAN。

- 对于Trunk接口和Hybrid接口,一个接口可以允许多个VLAN通过,但是只能有一个缺省VLAN, 修改接口允许通过的VLAN不会更改接口的缺省VLAN。

- 三层接口未必一定对应VLAN-ID。例如路由器的三层物理接口,这种类型的接口无需配置VLAN-ID。

-

在三层交换机上(路由器或防火墙等设备,也有支持VLANIF的款型),每个VLAN都有对应的

VLANIF,VLANIF指的是VLAN对应的逻辑三层接口,这个三层接口在VLAN被创建后,可以直接赋予IP地址,且具备路由转发能力。一个VLAN对应一个VLANIF,VLAN与VLANIF的标识相同。

VLAN内的终端设备,可以与该VLAN对应的VLANIF直接进行二层通信。

- 对于Access接口,缺省VLAN就是它允许通过的VLAN,修改接口允许通过的VLAN即可更改接口的缺省VLAN。

-

-

二层防环技术

- STP

STP技术背景¶

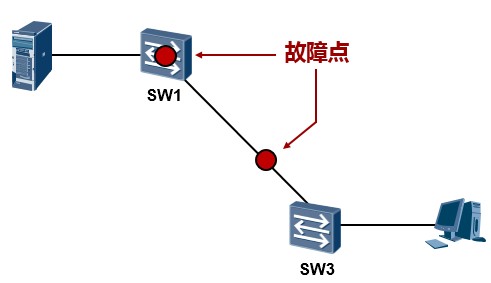

在上图所示的网络中,接入层交换机SW3单链路上联到汇聚交换机SW1,这是存在单链路故障的,这个网络的可靠性也是比较差的。如果SW3的上联链路发生故障,SW3(以及下联用户)就断网了。网络中存在的另一个单点故障问题,就是SW1如果宕机,SW3也就断网了。为了使得网络更加健壮、更具有冗余性, 我们可以考虑将拓扑修改为如下图所示:接入层交换机SW3采用双链路上联到两台汇聚设备,构成一个物理链路冗余的二层环境,解决了单链路及单设备故障问题。

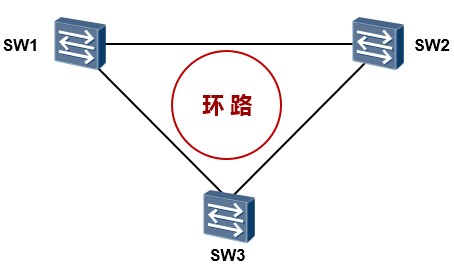

但是这却带来了另一个大问题:网络中存在二层环路(所谓的二层环路指的是由二层链路构成的环路)。这个三角形的二层环路会为网络带来重大问题。我们已经知道交换机的工作机制:当其收到组播、广播数据帧时,会直接在VLAN内进行泛洪,另外,如果收到目的MAC地址未知的单播数据帧时,同样会进行泛洪,这么一来,当网络中出现二层环路时,就可能会导致广播风暴、多帧复制、MAC地址漂移等等多种问题,从而给网络带来巨大影响。即使不是人为搭建冗余的物理环境而导致的环路,网络也有可能因为种种原因出现二层环路引发的故障,例如由于人为的误接线缆等。那么有没有什么办法解决环路的问题呢?解决方案有许多,实际上以太网中的二层环路问题是一个不小的课题,业界有许多非常经典的解决方案应对这个问题,数据设备厂商为了应对二层环路问题也都纷纷提出了自己的技术或方法论,但是这里不得不提到的是**生成树(Spanning-tree,简称STP)协议**,这是一个经典的、公有的协议,专门用于应对以太网二层环路问题。

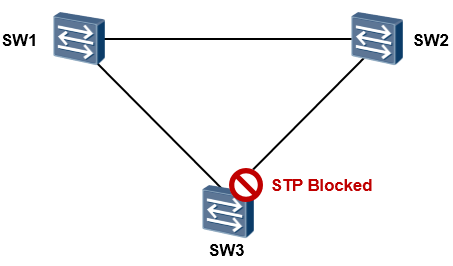

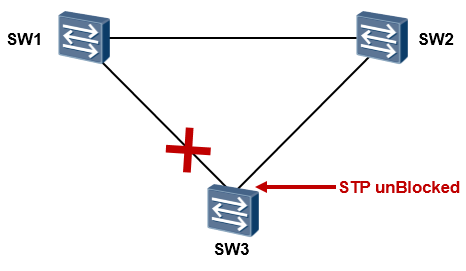

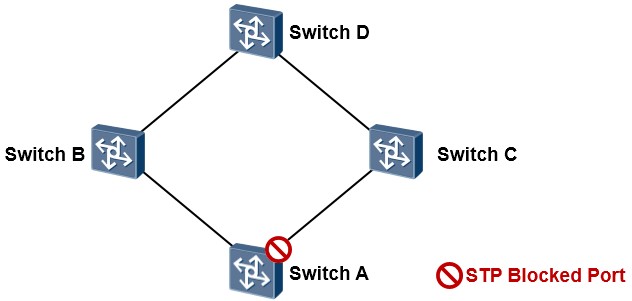

通过STP,在逻辑上将特定接口进行阻塞(Block),从而实现保持物理上的冗余环境同时、二层环境中又可打破环路。例如在下图中,网络是存在环路的,在三台交换机上运行生成树协议后,STP经过一定的计算, 最终决定阻塞掉一个接口,从而打破环路。

当拓扑发生变更的时候,如下图所示,STP能够探测到这些变化,并且及时自动的调整接口状态,从而适应网络拓扑的变化,实现链路冗余。

STP需要运行在网络中的所有交换机上以防止网络出现环路。一旦开启STP,交换机之间就会进行STP报文的交互,而STP的工作及计算正是依赖于这些报文的交互,STP操作的结果是将网络中的特定接口阻塞,从而达到消灭环路的目的,但是具体是什么接口被阻塞,可不是随便定的,STP一套自己的计算方法。本章我们主要介绍的是STP的802.1D标准。这个标准实际上已经非常古老而且基本不再使用了,但是却依然是入门生成树技术的必经之路,后续的更新实际上都是基于这个协议,因此掌握它是非常有必要的。接下来我们先了解一下802.1D标准的STP。

STP基本概念¶

简单地说STP采用四个步骤来解决二层环路问题:¶

- 在交换网络中选举一个根桥(Root Bridge,简称RB);

- 在每个非根桥上选举一个根端口(Root Port,简称RP);

- 在每个段中选举一个指定端口(Designated Port,简称DP);

- 阻塞非指定端口(Non-Designated Port,简称NDP)。

说明:这里的桥(Bridge),其实就是指交换机,由于交换机是由早期的网桥发展而来,因此在一些场合下,我们依然

沿用“ 网桥“或者“ 桥“来称呼交换机。

关键字段及比较原则¶

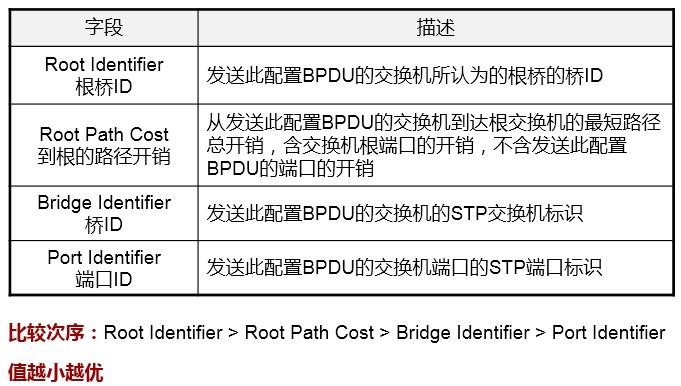

运行STP的交换机之间会交互一些非常重要的协议报文,该报文称为网桥协议数据单元(Bridge Protocol Data Unit,简称BPDU)。STP之所以能够正常工作并构建一个无环的网络,是依赖于BPDU 报文的泛洪。要理解STP的工作过程,非常重要的一点就是要理解BPDU中各字段的含义,因为这些都是STP赖以工作的根本。BPDU报文包含的所有字段在后文中有所涉及,这里我们先关注几个重点字段

(此处介绍的是BPDU中的一种关键类型:配置BPDU):

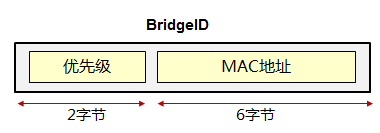

桥ID(Bridge Identifier)¶

在STP中,每一台交换机都有一个唯一的标识符,这个标识符就是桥ID,桥ID长度为8个字节,由两部分组成:2个字节的桥优先级和6个字节的桥MAC地址,其中优先级默认为32768,可以手工更改。而桥MAC地址为网桥的背板MAC(可以简单地理解为系统MAC)。交换机发送的BPDU报文中,桥ID字段存放的就是自己的桥ID,而根桥ID字段存放的就是网络中根桥的桥ID。

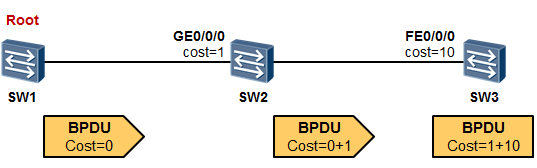

根路径开销(Root Path Cost)¶

根路径开销是一个用于度量接口到根桥的开销的值,交换机的接口到根桥的路径开销越小则被阻塞的可能性也就越小。

根桥发送出来的BPDU中,根路径开销字段值都为0。当非根桥在某个接口上收到这个BPDU再进

行STP计算的时候,会把该BPDU中所包含的根路径开销累加上收到该BPDU的接口的STP Cost, 从而得到从该接口到达根的总路径开销。

STP接口Cost与接口的带宽有关,接口带宽越高,则接口的STP Cost越小。

在上面的例子中,SW1是网络中的根桥,因此它发送BPDU报文中Root Path Cost字段为0,SW2 在GE0/0/0收到这个BPDU后就可以进行相应的计算,它从GE0/0/0到达根桥的Root Path Cost等于自己接口的Cost加上所收到的BPDU报文中的Root Path Cost,结果就是1,随后SW2将这个

BPDU转发给SW3,注意此时BPDU中的Root Path Cost被修改为1。SW3在收到这个BPDU并进行Root Path Cost计算的时候,Root Path Cost就等于自己FE0/0/0接口的Cost加上BPDU报文中的Root Path Cost,也就是11。

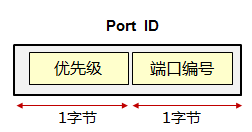

端口ID(Port ID)¶

端口ID(2字节)包含两部分:端口优先级(1字节)以及端口编号(1字节)。缺省时优先级值为

128,该值可以通过命令修改,取值范围是0-255,值越小越优。

说明:在本文中,交换机的端口指的就是交换机的接口,在描述交换机时,笔者可能同时使用端口或接口一词。

生成树构造一个无环路拓扑时,总是使用相同的4步来判定(下面的信息都是BPDU中的字段):¶

Step1:最小的根桥ID

Step2:最小的根路径开销

Step3:最小的桥ID

Step4:最小的端口ID

STP操作¶

在交换网络中选举一个根桥¶

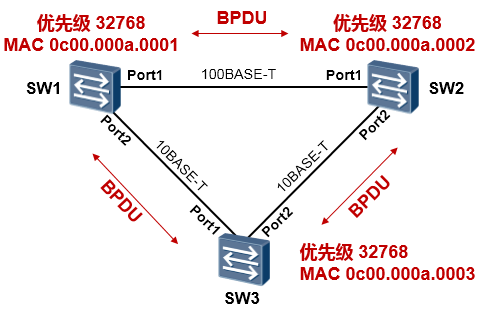

以上图所示的网络为例,我们在交换机上都开启了STP,初始情况下,所有的交换机都认为自己就是网络中的根桥,于是都向网络中泛洪配置BPDU,在各自发送的配置BPDU中,都声称自己是根桥。经过

PK之后,拥有最小桥ID的交换机胜出,成为这个交换网络真正的根桥。

根桥的选举过程:首先比较桥优先级,优先级值最小的交换机胜出,如果优先级相等,则再比较桥MAC 地址,也是优选最小的值。所以在上图所示的例子中,SW1胜出成为根桥。

根桥是STP计算得出的无环的拓扑(可以形象地理解为一棵树)的树根,STP后续的计算都是以这个树根作为参考点的。当然,在实际的项目中,我们通常是不会通过MAC地址的比较让交换机自己去选根桥的,为了网络的稳定和可控,一般会将核心交换设备配置为网络的根桥——将其桥优先级调节为最小值,从而确保其成为根桥。

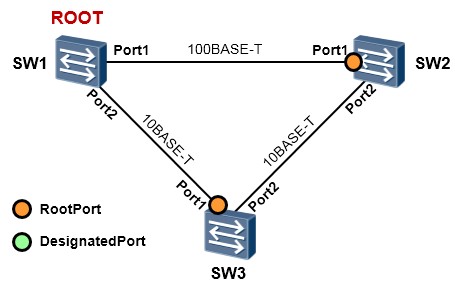

在每个非根桥上选举一个根端口¶

在选举出根桥后,根桥仍然持续向网络中发送配置BPDU,而非根桥将持续不断地收到根桥发送的配置

BPDU。STP计算过程的第二步是在每个非根桥上选择一个根端口,根端口是每台交换机上收到最优

BPDU的端口。

一台非根桥可能会有多个端口连接到交换网络,每个非根桥上必须选举一个根端口,而且只会选举一个根端口。当存在多个端口时,交换机在这些端口上都会收到配置BPDU,交换机会比较这些配置BPDU,然后选择比较结果最优的接口作为根端口,按照如下顺序比较:1)比较配置BPDU中的根桥ID字段, 选择值小的;2)如果前者相等,则将配置BPDU中的根路径开销值读取出来,与收到该BPDU的接口的

Cost相加,比较相加后的值,选择值最小的;3)如果前者还相等,则比较配置BPDU中的桥ID字段;

4)如果前者还相等,则比较端口ID字段。

例如在上图中,SW3有两个接口接入到这个交换网络中:Port1及Port2,现在SW3要在两者之间选举一个根端口。SW3会从Port1和Port2都收到配置BPDU报文(从Port1收到的是SW1直接发送过来的,从

Port2收到的是根桥SW1发往SW2,然后由SW2转发过来的),在报文中都有携带“桥ID、根路径开销、桥ID、端口ID”等关键字段,那么SW2就会进行Port1及Port2的PK,PK什么呢?先PK这两个端口到达根桥的根路径开销,优选值更小的,如果相等,则PK这两个接口收到的BPDU中的桥ID,也是优选值更小的,如果连这个也相等呢,那就进一步PK这两个接口收到的BPDU中的端口ID。很明显,这里Port1 到根的根路径开销更小,而从Port2到根呢,除了自己接口的开销还要累加上SW2的Port1的开销。所以

SW3上,Port1成为了根端口。

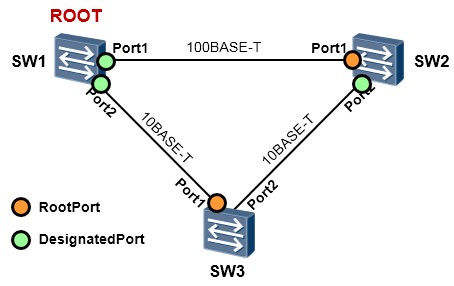

为每个段选举一个指定端口(Designated Port)¶

非根桥选举出根端口后,会将根端口上收到的配置BPDU进行计算:为本交换机上的其他端口各计算一份配置BPDU,而这些接口也会从网络中收到配置BPDU,此时交换机会比较这两份配置BPDU,如果前者更优,则该端口成为指定端口,如果后者更优,则该端口成为非指定端口并且将被阻塞。

交换机根据根端口上收到的最优配置BPDU后为其他端口计算配置BPDU的过程如下:

- 配置BPDU中的根桥ID替换为根端口的配置BPDU的根桥ID;

- 根路径开销替换为根端口配置BPDU的根路径开销加上根端口的开销;

- 桥ID替换为自身设备的桥ID;

- 端口ID替换为自身端口ID。

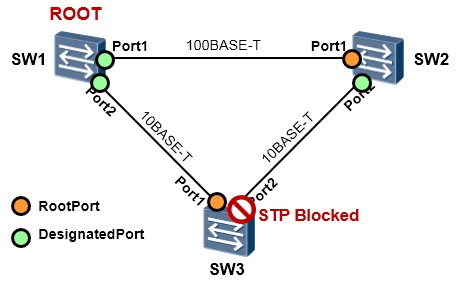

阻塞非指定端口(Non-Designated Port)¶

最后,非指定端口被阻塞,环路就打破了。

STP报文¶

STP的BPDU有两种类型:配置BPDU(Configuration BPDU)及TCN BPDU(Topology Change BPDU)。两种BPDU各有各的用途。

配置BPDU¶

在网络刚开始运行的阶段,所有交换机都会从所有端口发送配置BPDU,大家都认为自己是根桥,随着配置BPDU泛洪和收集、计算,根据配置BPDU中所含信息,大家PK出来个结果,根桥被选举出来了。在此之后根桥以默认2S为周期发送配置BPDU,所有的非根交换机从自己的根端口收到配置BPDU,再 从自己的指定端口计算BPDU发出去。这就有点像我们从根桥倒一盆水下来,水在重力的牵引下顺着这颗无环的树从上往下不断的往下流。另外,被阻塞的非指定端口会源源不断的收到链路上的配置BPDU 并一直侦听之,当其在一定时间内没有再收到配置BPDU,则认为链路出现了故障,开始进入新的收敛阶段。

下表是配置BPDU的报文格式:¶

| 字节 | 字段 | 描述 |

|---|---|---|

| 2 | 协议 | 代表上层协议(BPDU),该值总为0 |

| 1 | 版本 | (对于802.1D,该字段总为0) |

| 1 | TYPE | “配置BPDU”为0x00、“TCN BPDU”为0x80 |

| 1 | 标志 | LSB最低有效位表示TC标志;MSB最高有效位表示TCA标志 |

| 8 | 根ID | 根网桥的桥ID |

|---|---|---|

| 4 | 路径开销 | 到达根桥的STP cost |

| 8 | 桥ID | BPDU发送桥的ID |

| 2 | 端口ID | BPDU发送网桥的端口ID(优先级+端口号) |

| 2 | 消息寿命 Message age | 从根网桥发出BPDU之后的秒数(这个BPDU存活了多长时间了),每经 过一个网桥都减1,所以它本质上是到达根桥的跳数。 |

| 2 | 最大寿命 Max age | 当一段时间未收到任何BPDU,生存期到达MAX age时,网桥认为该端口 连接的链路发生故障。也可以理解为这个BPDU的最大寿命, |

| 2 | HELLO时间 | 根网桥连续发送的BPDU之间的时间间隔。 |

| 2 | 转发延迟 | 在监听和学习状态所停留的时间间隔。 |

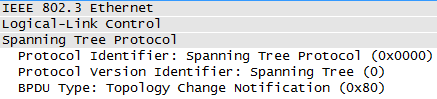

TCN BPDU¶

TCN BPDU¶

当网络拓扑发生变化的时候,最先意识到变化的交换机(假设该交换机不是根桥)会从根端口发送TCN BPDU(Topology Change Notofication BPDU,拓扑变更通知BPDU,该BPDU报文中TYPE字段=0x80), 也就是朝着根桥的方向发送TCN BPDU,这个报文会一跳一跳地传递到根交换机。上联的交换机在收到了该交换机发送上来的TCN BPDU后,除了向它自己的上一级交换机继续发送TCN BPDU外,还需回送一个TCA BPDU(FLAG字段中TCA位为1的配置BPDU)的确认信息给该交换机。当根桥接收到

TCN后意识到了拓扑变化,遂向所有网桥发送TC BPDU(FLAG字段中TC位为1的配置BPDU)。 交换机们收到根桥发出来的TC BPDU后,会立即删除自己的MAC地址表,以便适应新的网络拓扑。

STP的计时器¶

STP有三个非常重要的计时器:

- Hello Timer:根桥周期性发送配置BPDU的时间间隔,缺省为2s。

- 转发延迟计时器(Forward Delay Timer):接口从Listening转换到Learning状态,或者从Learning转换到Forwarding状态过程中所需等待的时间,缺省为15s。

- 最大生存时间(Max Age Timer):在丢弃配置BPDU之前,交换机用来存储配置BPDU的时间,缺省

为20s。如果一个被阻塞的接口(非指定端口)在收到一个配置BPDU后,20s内没有再次收到配置BPDU,则切换到Listening状态。

网络中的生成树拓扑依附于根桥的计时器,根桥将配置BPDU中的计时器时间间隔传递给所有交换机。对于

802.1D标准的STP而言,端口从Blocking到Forwarding通常要30-50s(30s是15+15,也就是两个转发延迟时间,50s即20+15+15)。

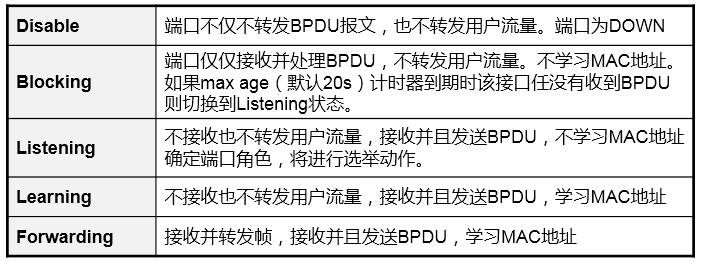

STP端口状态¶

关于为什么要定义这么多的端口状态,其实很好理解,拿Learning来说,为什么不让端口一旦被选举为指定端口后立即进入转发状态呢?设想一下,端口激活后,交换机在该端口是没有学习到任何的MAC地址表项的,如果没有设计Learning状态的话,端口将直接进入转发状态,那么就有可能引发短暂的数据泛洪(交换机收到目的MAC地址未知的数据帧时会进行泛洪)。

下图是每个状态的切换关系图:

STP的基础配置¶

基础配置¶

指定生成树协议类型(STP/RSTP/MSTP):

配置交换机优先级:

配置该交换机成为主根桥:

配置该交换机成为次根桥:

启用生成树:

配置端口STP优先级:

配置端口路径开销:

基础实验¶

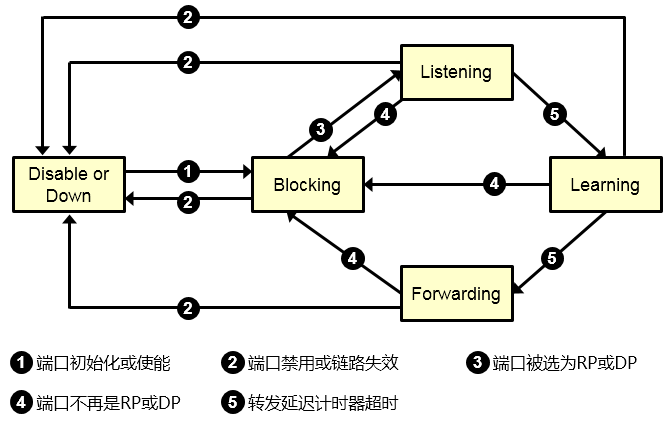

在上图所示的网络中,在SW1、SW2及SW3上运行STP,并将SW1指定为主根桥,SW2指定为次根桥, 最终需使得SW3的GE0/0/22接口被阻塞。

从拓扑我们能非常直观的看出,在物理上这是一个冗余的环境,并且存在二层环路。一旦在这个网络中出现流量,那么流量就很有可能在环路中被不断泛洪从而导致广播风暴。当出现广播风暴时,我们能从设备的指示灯上观察到非常直观的现象:设备的指示灯会出现非常规律的“齐闪”。另外,交换机的接口带宽利用率可能会攀升到一个比较高的值,而且如果广播风暴比较严重,交换机的CPU利用率也可能会飙高,从而影响到其工作。

SW1的配置如下:

SW2的配置如下:

SW3的配置如下:

在完成上述配置后,STP开始工作,并开始选举根桥,三台交换机中,STP桥ID(桥优先级和桥MAC)

最小的交换机将成为本交换网络的根桥。当然,所有的交换机默认的桥优先级为32768,这样一来拥有最小背板MAC的交换机将成为网络的根桥,这显然带有一定的随机性,在实际的网络部署中,我们往往会手工指定一台设备成为根桥,从而保证生成树计算的稳定性。例如在这个例子中,手工指定SW1 成为网络的主根桥,SW2成为网络的次根桥:

SW1上增加的配置如下:

[SW1] stp root primary

SW2上增加的配置如下:

[SW2] stp root secondary

现在,我们再看看实验效果,在SW1上查看STP的全局信息:

从输出的信息我们得知,本交换机的桥ID为 0:4c1f-cc06-71d8,其中0为交换机的桥优先级,这显然

是我们的命令**stp root primary**的作用,交换机的优先级被配置为0——最小值也是最优的值。4c1f- cc06-71d8是本机的MAC地址。而上述输出的信息中,根桥的MAC也是4c1f-cc06-71d8,这就表明,本交换机就是网络的根桥。再来查看下SW1的生成树接口状态:

使用上述命令,可以查看STP的相关简化信息,从上面的输出可以看出,SW1的两个接口都是指定接口(DESI),并且都是Forwarding转发状态。

再去SW2上看看:

| [SW2] display stp -------[CIST Global Info][Mode STP]------- | ||

|---|---|---|

| CIST Bridge | :4096 .4c1f-cc34-71cd | #本机的桥ID |

| Config Times | :Hello 2s MaxAge 20s FwDly 15s MaxHop 20 | |

| Active Times CIST Root/ERPC | :Hello 2s MaxAge 20s FwDly 15s MaxHop 20 :0 .4c1f-cc06-71d8 / 1 | #根桥的桥ID,也就是SW1 |

| CIST RegRoot/IRPC | :4096 .4c1f-cc34-71cd / 0 | |

| CIST RootPortId | :128.24 | |

| BPDU-Protection | :Disabled | |

| CIST Root Type | :Secondary root |

SW2为次根桥,它将在检测到SW1出现故障后,替代它成为网络的根桥。

我想,你已经能想到SW3上哪一个端口将被Blocked了:

SW3的GE0/0/22口现在是Discarding状态,被阻塞了。这是因为这个接口到达根桥SW1的开销最大。

如果此时希望SW3被阻塞的不是GE0/0/22口,而是GE0/0/21口呢?一种可选的办法是,将GE0/0/21 的接口开销调大,使得从这个接口上收到配置BPDU后,累加的根路径开销比GE0/0/22口的累加值要大, 也就是使得这个接口距离根桥SW1的“开销”更大、“更远”。

SW3增加配置如下:

完成上述配置后,检查一下SW3的接口角色和状态:

| [SW3] display stp brief | ||||

|---|---|---|---|---|

| MSTID | Port | Role | STP State | Protection |

| 0 | GigabitEthernet0/0/21 | ALTE | DISCARDING | NONE |

| 0 | GigabitEthernet0/0/22 | ROOT | DISCARDING | NONE |

- STP 的特性及优化

STP及BPDU取消使能¶

[Switch-GigabitEthernet0/0/1] stp disable 上述命令用于在接口上关闭STP。如果交换机在全局使能了STP,则所有接口也将激活STP。使用上述命令,将会关闭某个特定接口的STP,这样一来这个接口将不再参与STP计算,此后,使用**display stp interface** 命令会看到该接口的STP被禁用,使用**display stp brief**命令则不会看到这个接口出现在STP接口列表中。

当交换机的一个接口连接着一台路由器(的路由接口)或者其他不可能产生二层环路的设备时,在交换机的这个接口上运行STP实际上是没有意义的,因此可以考虑将该接口的STP关闭。

[Switch-GigabitEthernet0/0/2] bpdu disable

接口级命令**bpdu enable**用来配置接口上送BPDU报文,接口对目的MAC地址属于BPDU MAC的报文上送

CPU处理,BPDU MAC可以通过**display bpdu mac-address**命令查看,而**bpdu disable**命令将使接口把收到的BPDU报文丢弃。

值得注意的是,如果错误的配置**bpdu disable**将会导致STP计算的错误从而导致环路,因此该命令要格外留意。S5300 V100R005C01SPC100版本的交换机默认在STP全局激活的情况下接口的bpdu是disable的

(S5300的其他软件版本则要看版本的描述),需要注意这一点。

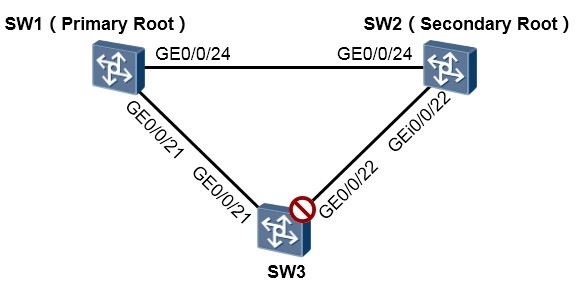

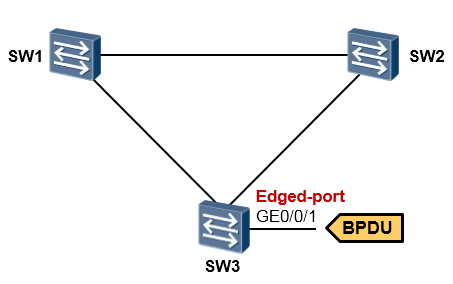

边缘端口(Edged-port)¶

基本概念¶

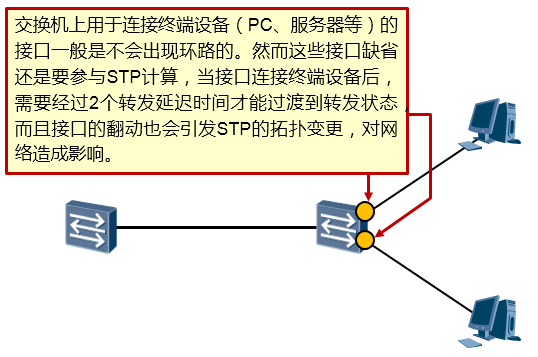

我们知道在运行了STP的交换机上,一个端口在UP之后,需要经过Listening、Learning两个状态才能够最终进入Forwarding状态开始转发数据帧(当然前提是该端口不能是非指定端口),这里就耗费了两个15s的延迟时间。这实际上是非常低效的。

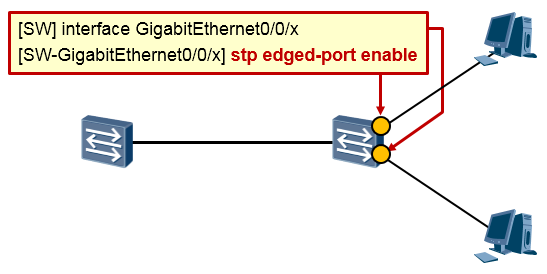

交换机连接终端设备(例如PC、服务器等)的端口一般是不会产生二层环路的,其实并不需要上述状态的切换过程,可直接进入转发状态,提高工作效率。将交换机连接终端设备的端口配置为边缘端口

(Edge-port)即可解决上述问题。边缘端口不参与生成树的计算,它可以在UP后立即进入转发状态。另外,边缘端口的UP/DOWN不会触发STP拓扑变更而发生TC报文。

在没有配置BPDU保护(将在后续的内容中介绍)的情况下,边缘端口一旦收到BPDU,就丧失了边缘

端口属性,成为了普通的STP端口。

配置实现¶

运行了STP的交换机,在其连接终端设备的接口上都可以开启该特性。

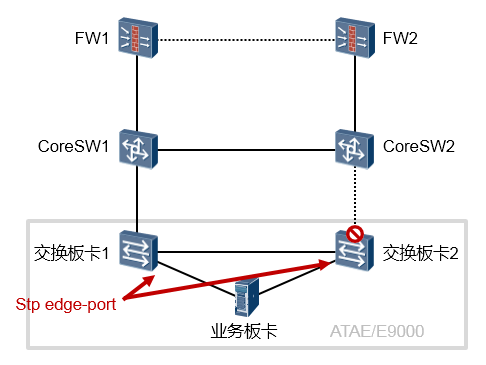

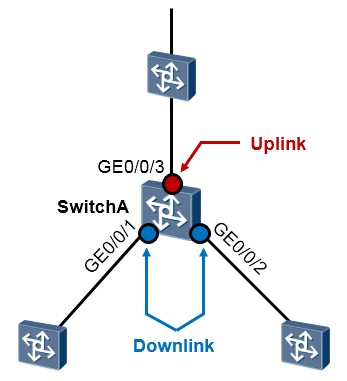

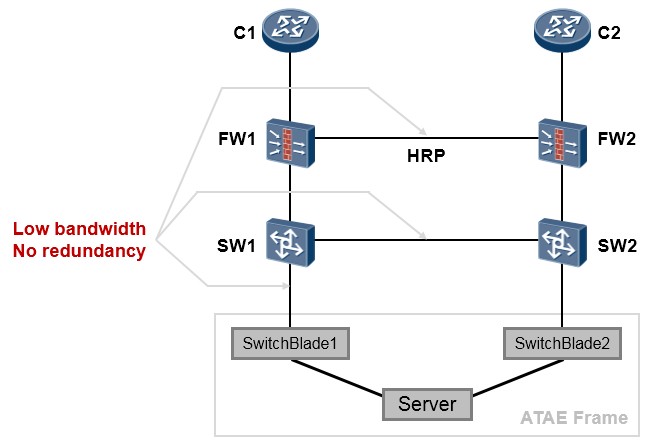

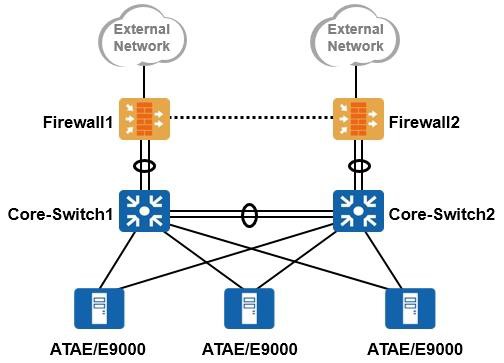

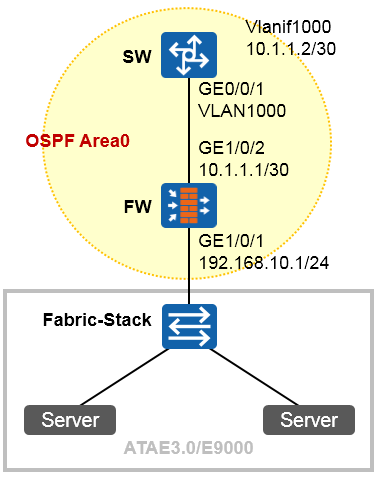

在实际的项目中,如果网络中采用ATAE/E9000设备,如下图所示,那么我们会将ATAE/E9000的交换板连接业务板的内部接口配置为边缘端口,因为这些端口用于连接刀片服务器的网卡(网卡工作在三层模式),如图中所示。

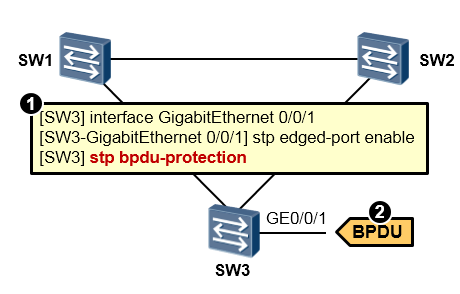

BPDU保护(Protection)¶

技术背景¶

边缘端口一般用于直接和用户终端相连,正常情况下,边缘端口不会收到BPDU报文(因为连接的是终端,而不是交换设备)。但是如果攻击者伪造BPDU恶意攻击交换机那就会存在安全隐患(或者接口误接了交换机,那么就有可能产生环路),当边缘端口接收到BPDU时,设备会自动将边缘端口设置为非边缘端口,并重新进行生成树计算,这个过程就有可能引起网络的震荡。

通过使能BPDU保护可以防止伪造BPDU恶意攻击。

基本概念¶

交换机上启动BPDU保护功能后,如果边缘端口收到BPDU报文,设备将关闭(shutdown)这些端口, 同时通知网管系统。缺省情况下,交换机的BPDU保护功能并未开启。

配置实现¶

在上图所示的场景中,我们在SW3上将GE0/0/1 配置为边缘端口,随后在SW3上开启了BPDU-

Protection特性。当SW3的GE0/0/1口收到BPDU报文时,交换机将产生如下提示信息,并将GE0/0/1口shutdown:

此时在SW3上查看接口的STP信息如下:

要恢复被shutdown的BPDU受保护边缘端口,可使用手工在接口下执行**undo shutdown**命令的方式, 或者采用自动恢复的方式,即在系统视图下执行命令**error-down auto-recovery cause cause-item interval** interval-value,激活接口管理状态自动恢复为Up的功能,并设置接口自动恢复为Up的延时时间,使被关闭的端口经过延时时间后能够自动恢复。对于参数interval,取值范围是30~86400,单位是秒,配置时需要注意两点:

- 取值越小表示接口的管理状态自动恢复为Up的延迟时间越短,接口Up/Down状态震荡频率越高。

- 取值越大表示接口的管理状态自动恢复为Up的延迟时间越长,接口流量中断时间越长。

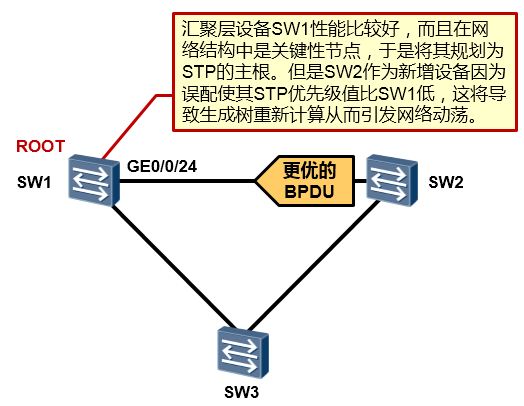

根保护(Root Protection)¶

技术背景¶

基本概念¶

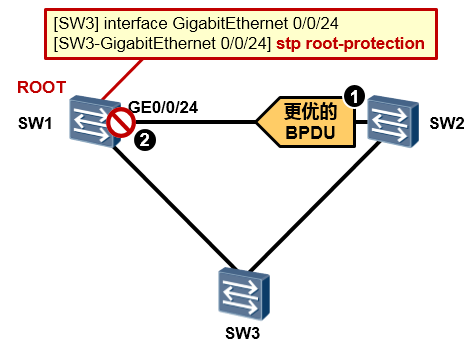

在SW1的GE0/0/24口上部署了根保护后,当该接口再收到更优的BPDU报文后,SW1将这个接口切换到Discarding状态,如此一来SW1的根桥宝座就能够坐的很稳当。

配置实现¶

在交换设备上配置根保护功能,通过维持指定端口的角色来保护根交换设备的地位。根保护是指定端口上的特性。当端口的角色是指定端口时,配置的根保护功能才生效。若在其他类型的端口上配置根保护功能,则不会生效。

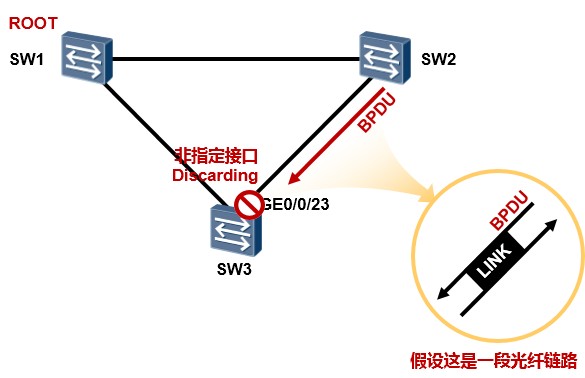

环路保护(Loop Protection)¶

技术背景¶

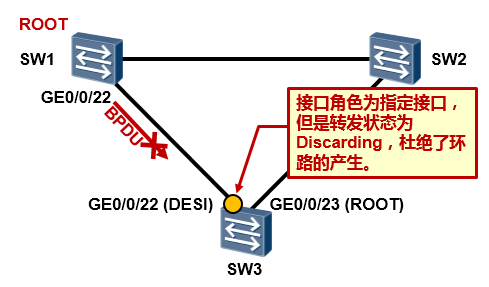

在上图所示的网络环境中,SW1为STP根桥,SW3的GE0/0/23由于被选举为非指定端口因此处于

Discarding状态,该接口虽然处于Discarding状态,但是仍然会持续侦听SW2发来的BPDU报文。

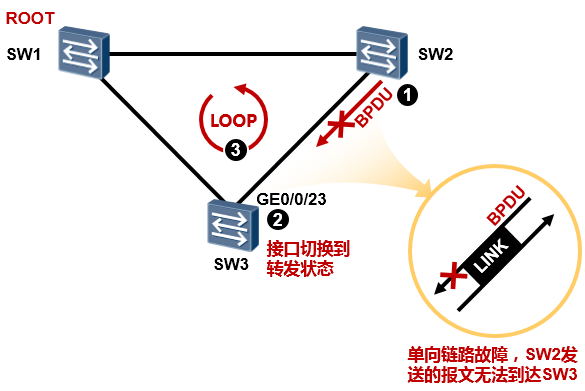

现在,SW2、SW3之间的链路突然发生了单向链路故障,SW2发送的报文无法到达SW3,这将导致SW3的GE0/0/23口无法再收到BPDU,因此它认为SW2发生了故障,于是重新进行STP计算,最终GE0/0/23 口的角色将切换成指定端口,而状态也将切换到转发状态,至此就出现了环路,因为从SW3到SW2的单向链路仍然在工作。

基本概念¶

交换机的根端口及处于Disacarding状态的接口会源源不断的收到BPDU报文,当这些端口由于链路的

单向故障导致收不到BPDU报文的时候,就会进行STP的重新计算。原来的根端口就会变成指定端口, 原来处于Discarding状态的端口会切换到Forwarding状态,从而导致环路的出现。

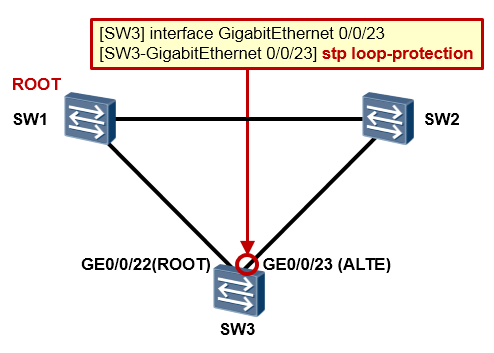

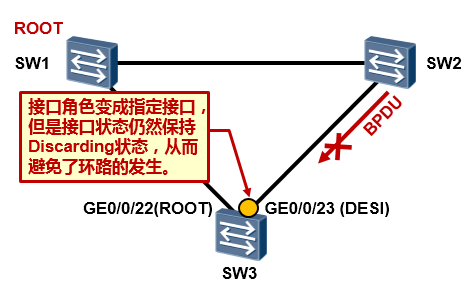

在根端口上启用了Loop Protection后,如果其端口角色发生变化,例如切换为指定端口,那么该端口将会被阻塞,也就是进入Discarding状态,直到再次收到BPDU。在阻塞端口上启用了Loop Protection后, 端口将一直处于Discarding状态,即使该端口被选举为指定端口。在STP中,此功能只能配置在根端口、替代端口及备份端口上。

配置实现1(该特性在根端口上部署)¶

LOOP Protection 部署前:¶

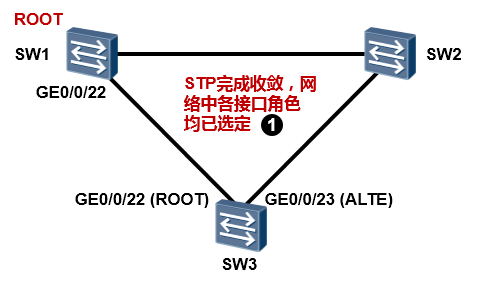

在STP完成收敛后,SW3的GE0/0/22口是根端口,GE0/0/23是替代端口处于Discarding状态。

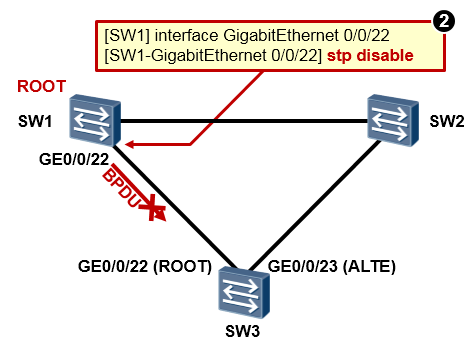

在SW1的GE0/0/22口上执行**disable stp**,来模拟链路出现单向故障的情况,如此一来SW3将无法再从GE0/0/22口收到ROOT SW1发送过来的BPDU了。

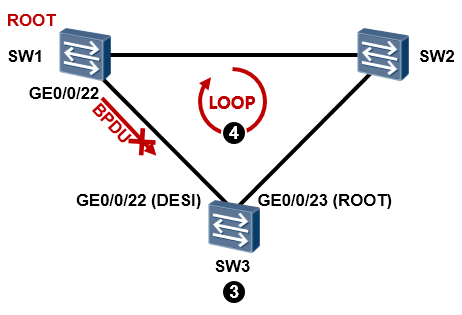

STP再次完成收敛后,SW3的GE0/0/23口被选举成为根端口,而GE0/0/22口成为指定端口,如此一来,环路就产生了。

LOOP Protection 部署后¶

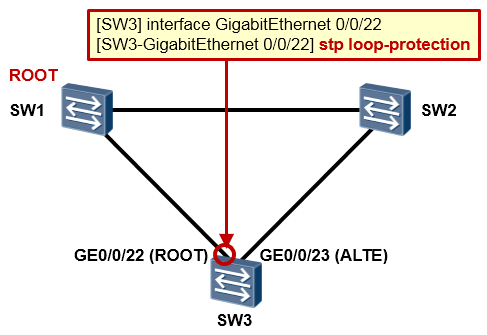

现在我们在SW3的GE0/0/22口上部署loop protection特性。

SW3重新进行STP的计算,GE0/0/23口成为根端口,GE0/0/22口成为指定端口,但是由于GE0/0/22口上部署了Loop Protection,因此该接口虽然角色为指定端口,状态却会保持在Discarding状态, 从而避免了环路的出现。

配置实现2(该特性在替代端口上部署)¶

另外一个示例是,LoopProtection部署在替代端口上,如上图所示。

那么当SW2及SW3之间出现单向链路故障时,SW3将无法从GE0/0/23口再收到BPDU,于是SW3重新进行STP计算,此时GE0/0/23口成为了指定端口,但是由于配置了Loop Protection特性,因此该接口会保持在Discarding状态,从而避免了环路的产生。

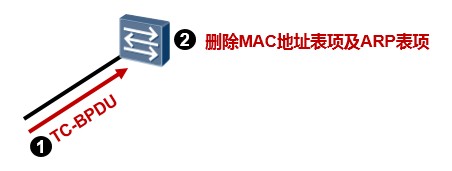

TC Protection¶

设备在收到TC-BPDU后会执行MAC地址表项及ARP表项的删除操作,如果有攻击者伪造大量的TC-

BPDU报文对交换机进行攻击,交换机将频繁的进行上述表项的删除及刷新操作从而造成极大的负担,

给网络的稳定带来很大的隐患。

在交换机上开启TC-Protection后,交换机会在收到TC-BPDU后删除上述表项的同时启动周期为10s的定时器,在此周期内,如果交换机再次收到TC-BPDU报文,则最多可以进行1次删除上述表项的操作, 从而实现对交换机的保护。

- MSTP

背景¶

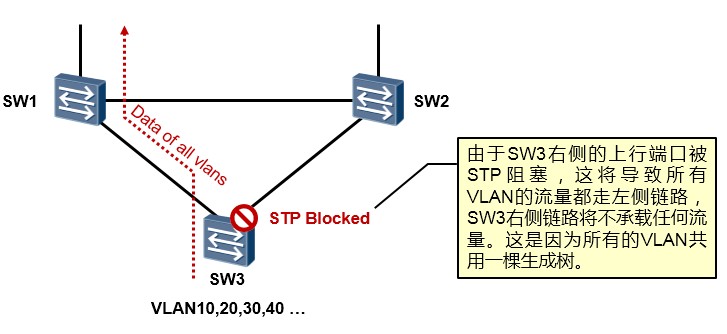

古老的STP 802.1D标准是所有VLAN共用一棵生成树,也就是说,不管交换网络中存在多少个VLAN,STP 计算的结果都是一棵生成树,拿上图来说,STP最终将如图所示的接口阻塞掉,这就造成所有VLAN的流量均走SW3的左侧链路,而右侧链路无法得到有效的利用。

于是后来业界又出现了perVLAN的生成树协议,也就是一个VLAN一棵生成树,如此一来,每个VLAN都有其自己独立的生成树,基于不同的VLAN,我们可以进行不同的优先级、接口开销的配置从而实现阻塞不同的端口,这样就能够实现不同的VLAN流量分流的目的。但是这种方案也是有一定弊端的,由于网络中的交换机需要为每一个VLAN单独进行生成树计算,因此当VLAN数量较多时,生成树的数量也是非常多的,网络的每一次震荡都将触发交换机们的重新计算,这是相当耗资源的。

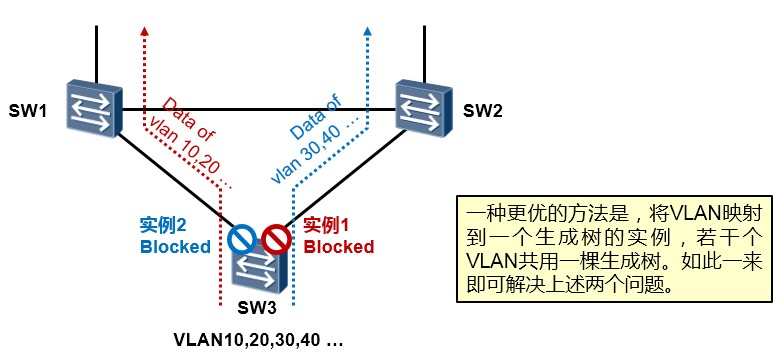

这就提到了接下去要介绍的**MSTP(Multiple Spanning Tree Protocol)**,MSTP协议是IEEE 802.1S标准。所谓MSTP也就是多生成树实例,通过将多个VLAN映射到一个生成树实例(Instance),从而基于实例来计算生成树,同属于一个实例的VLAN享有同一棵生成树,不同的实例对应不同的生成树,这样,既可实现数据分流,又能够极大程度的减小交换机的计算负担。

在上图所示的网络中,我们将VLAN10、VLAN20映射到MSTP实例1,将VLAN30、VLAN40映射到MSTP实例2(要求为三台交换机配置完全相同的VLAN与实例的映射关系),然后将SW1配置为实例1的主根、将

SW2配置为实例1的次根;将SW2配置为实例2的主根、将SW1配置为实例2的次根,如此一来,网络中就会针对实例1及实例2分别产生一棵生成树,而且阻塞不同的接口。那么VLAN10及VLAN20的流量即会从

SW3的左侧链路转发,而VLAN30及VLAN40会从右侧链路转发,流量即可实现负载分担。

基本术语¶

| 缩写 | 全称 | 描述 |

|---|---|---|

| MST Region | Multiple Spanning Tree Region | 一个域包含域名(Configuration Name)、修订级 别(Revision Level)、格式选择器(Configuration Identifier Format Selector)、VLAN与实例的映射关系(mapping of VIDs to spanning trees)等信息。 |

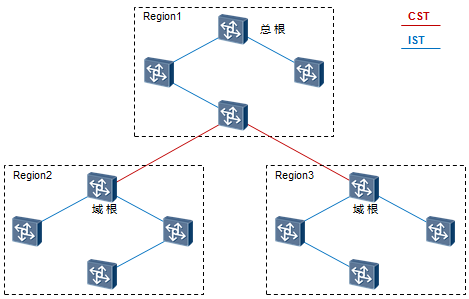

| MSTI | Multiple Spanning Tree Instance | MSTP的非实例0的其他实例 |

| CST | Common Spanning Tree 公共生成树 | 是连接交换网络内所有MST域的一棵生成树。如 果把每个MST域看作是一个节点,CST就是这些节点通过STP或RSTP协议计算生成的一棵生成树。 |

| IST | Internal Spanning Tree 内部生成树 | 内部生成树IST(Internal Spanning Tree)是各 MST域内的一棵生成树。 IST是一个特殊的MSTI,MSTI的ID为0,通常称为 MSTI0。IST是CIST在MST域内的一个片段。 |

| CIST | Common Internal Spanning Tree 公共内部生成树 | 连接一个交换网络内所有交换设备的单生成树。 所有MST域的IST加上CST就构成一棵完整的生成树,即CIST。 |

|---|---|---|

| CIST Root | CIST Root 总根 | 总根是一个全局概念,对于所有互连的运行 STP/RSTP/MSTP的交换机只能有一个总根,也即是CIST的根 |

| 域根 | Regional Root | 分为IST(Internal Spanning Tree)域根和MSTI 域根 |

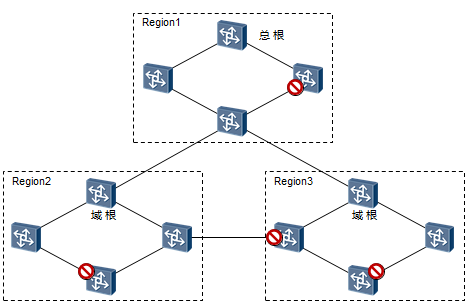

域¶

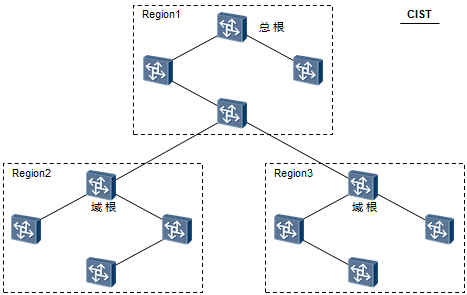

对于一个大型的交换网络,我们可以根据实际需要进行MSTP域的规划,当然如果网络规模有限,全网用一个域也是很平常的。一个“域”由同属一个域的交换机组成。例如在上图中,网络中存在三个MSTP域。

域包含域名(Region Name)、修订级别(Revision Level)、格式选择器(Configuration Identifier Format

Selector)、VLAN与实例的映射关系(mapping of VIDs to spanning trees)等内容,其中域名、格式选择器和修订级别在BPDU报文中都有相关字段,而VLAN与实例的映射关系在BPDU报文中表现摘要信息

(Configuration Digest),该摘要是根据映射关系计算得到的一个16字节签名。只有上述四者都一样且相互连接的交换机才认为在同一个域内。

同一个域内所有交换机都有相同的MST域配置。缺省时,域名就是交换机的桥MAC地址,修订级别等于0, 格式选择器等于0,所有的VLAN都映射到实例0上。

需强调的是:同一个域内的交换机,VLAN的映射必须完全一致。

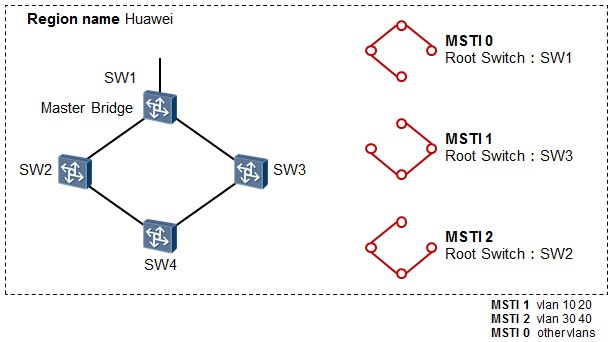

实例¶

单独拿一个域来说,如上图所示,域名为Huawei,这个域包含四台交换机,域内存在多个VLAN,一共有三个MSTP实例,实例与VLAN的映射关系如下:

- MSTI 1:vlan 10 20

- MSTI 2:vlan 30 40

-

MSTI 0:其他(默认所有的VLAN都映射到实例0)

所谓“实例”就是多个VLAN的一个集合。在MSTP中,各个实例拓扑的计算是独立的,一个MSTP实例单独计算一棵生成树,在这些实例上就可以实现负载均衡。使用的时候可以把多个相同拓扑结构的VLAN映射到同一个实例中,这些VLAN在端口上的转发状态将取决于对应实例在MSTP里的转发状态。

端口角色¶

外部路径开销和内部路径开销¶

外部路径开销是相对于CIST而言的,同一个域内外部路径开销是相同的;内部路径开销是域内相对于某个实例而言的,同一端口对于不同实例对应不同的内部路径开销。

域边缘端口¶

域边缘端口是指位于MST域的边缘并连接其它MST域或SST的端口。

在进行MSTP计算的时候,域边缘端口在MSTI上的角色和CIST实例的角色保持一致,即如果边缘端口在CIST实例上的角色是Master端口(连接域到总根的端口),则它在域内所有MST实例上的角色也是

Master端口。

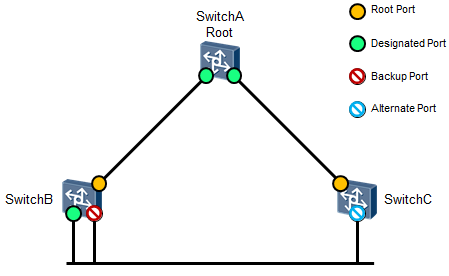

Alternate端口¶

从发送BPDU来看,Alternate端口就是由于学习到其它交换机的发送的BPDU而被阻塞的端口。从转发用户流量来看,Alternate端口提供了从指定交换机到根交换机的一条备份路径。

Alternate端口是根端口的备份端口,如果根端口被阻塞后,Alternate端口将成为新的根端口。

Backup端口¶

当同一台交换机的两个端口互相连接时就存在一个环路,此时交换机会将其中一个端口阻塞,Backup 端口就是被阻塞的那个端口。

从发送BPDU来看,Backup端口就是由于学习到自己发送的BPDU而被阻塞的端口。从转发用户流量来

看,Backup端口,作为指定端口的备份,提供了一条从根交换机到叶节点的备份通路。

Master端口¶

Master端口是MST域和总根相连的所有路径中最短路径上的端口,它是交换机上连接MST域到总根的端口。Master端口是域中的报文去往总根的必经之路。

Master端口是特殊域边缘端口,Master端口在IST/CIST上的角色是Root Port,在其它各实例上的角色都是Master。

基础配置:MSTP单实例部署¶

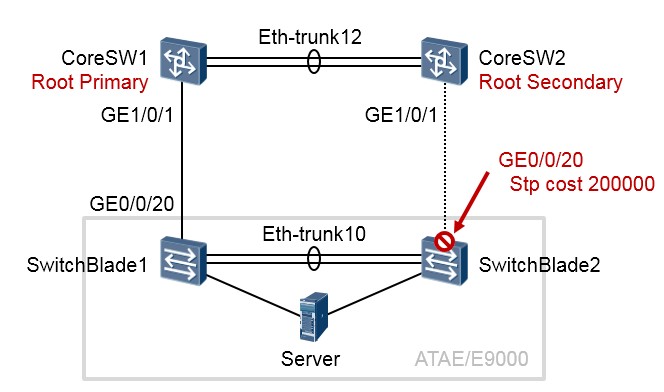

上图所示的拓扑是典型的电信软件数据网络组网场景, CoreSW1及CoreSW2 是两台核心交换机,

SwitchBlade1及SwitchBlade2是ATAE/E9000机框的两块交换板,您可以把它们也当做普通的交换机。这四台设备构成了一个口字型的二层环路。现在我们在四台设备上部署MSTP来消除环路,所有的交换机都加入相同的MSTP域,并且都使用一个实例,也就是实例0,缺省时所有的VLAN都映射到实例0。

我们将CoreSW1规划为主根桥,CoreSW2规划为次根桥,并且将SwitchBlade2上联核心交换机CoreSW2的接口的STP cost调节成一个非常大的值,从而使得该接口被MSTP阻塞,网络中存在的二层环路就此打破。另外,为了优化STP的运行,在所有交换机上开启TC保护及BPDU保护功能。参考配置如下:

CoreSW1:

CoreSW2:

ATAE/E9000交换板1:

ATAE/E9000交换板2:

对于CoreSW1而言,由于它是根桥,因此该设备所有接口的STP角色应该都是指定接口(Designated Port,

简写为DESI),而且所有的接口状态都是Forwarding:

| \<CoreSW1>display stp brief | ||||

|---|---|---|---|---|

| MSTID | Port | Role | STP State | Protection |

| 0 | GigabitEthernet1/0/1 | DESI | FORWARDING | NONE |

| 0 | Eth-Trunk12 | DESI | FORWARDING | NONE |

对于CoreSW2,其Eth-trunk12连接着根桥SW1,这个接口应该是根端口(Root Port,简写为ROOT),GE1/0/1

接口应该是指定端口,而且所有的接口状态都是Forwarding:

对于SwitchBlade1,其直连主根的接口GE0/0/20应该为根端口,Eth-trunk10端口为指定端口,而且所有的接口状态都是Forwarding:

对于SwitchBlade2,其Eth-trunk10接口应该为根端口,而GE0/0/20端口将处于Discarding状态,从而被阻塞,如此一来网络中不再存在二层环路:

| [SwitchBlade2] display stp brief | ||||

|---|---|---|---|---|

| MSTID | Port | Role | STP State | Protection |

| 0 | GigabitEthernet0/0/20 | ALTE | DISCARDING | NONE |

| 0 | Eth-Trunk10 | ROOT | FORWARDING | NONE |

常见问题¶

1. 由于实例与VLAN的映射不一致导致MSTP状态异常¶

SW1及SW2运行MSTP,SW1作为汇聚交换机,其上有VLAN:10、20、30、40;SW2作为接入层交

换机,其上只有VLAN10。

SW1的配置如下:

SW2的配置如下:

配置完成后,发现SW2的生成树状态异常,它认为自己是实例1的根。原因在于两台交换机的MSTP实

例1的VLAN映射不一致,导致SW2忽略SW1传递过来的关于实例1的信息,因此认为自己是根。将SW2 的配置修改如下:

即可,注意SW2上不需要创建VLAN 20 30 40(如果该交换机没有连接这几个VLAN的用户),也就是

说即使SW2没有创建VLAN 20 30 40也是能够按照上述配置,将VLAN 10 20 30 40映射到实例1。

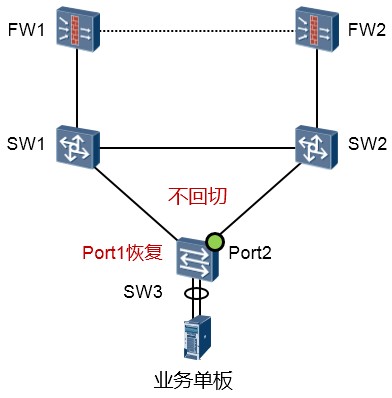

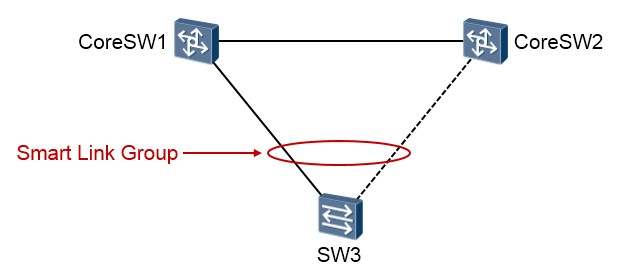

- Smart Link 及 Monitor Link

技术背景¶

在一个交换网络中,为了提高网络的可靠性,我们会设计冗余的物理环境,然而冗余的物理环境会带来二层环路的问题,在此前的章节中已经介绍了STP生成树协议,利用STP确实可以解决环路的问题,但STP首先需要在参与到拓扑的每一台交换机上都进行配置,并且采用兼容的STP协议类型,再者需要依赖BPDU的泛洪才能够正常工作。另外,STP的计算也是比较缓慢的,这使得当拓扑发生变更时,STP的收敛可能需要数秒的时间,而这在某些业务场景中是不可接受的,例如对延迟非常敏感的业务。实际上,对于现代园区网而言,STP虽然曾经是二层交换网络的典型应用,但是正在被逐步取代。

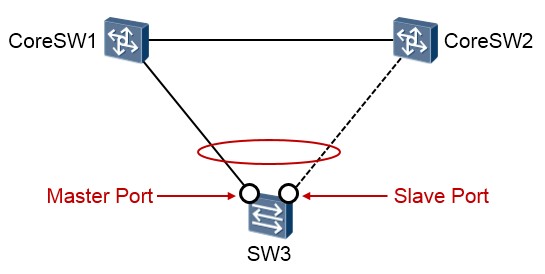

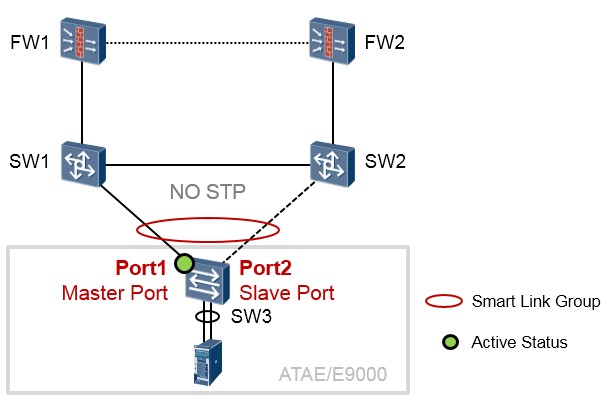

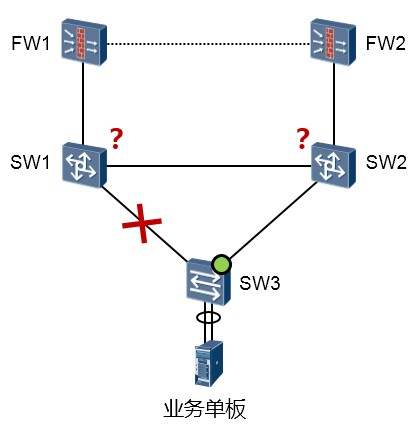

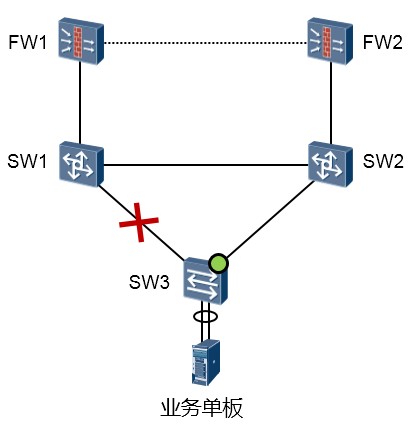

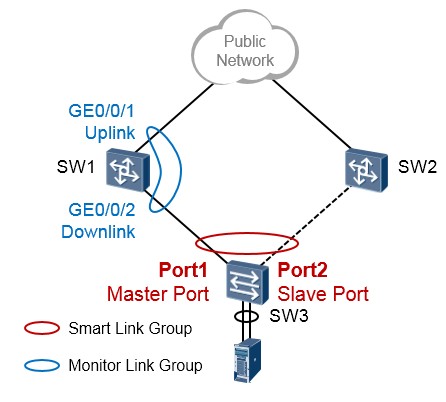

Smart Link是一种为双上行组网量身定做的解决方案。什么叫双上行组网呢?说的好像很流弊似的,其实非常简单,拿上面的拓扑来说,SW3有两根链路上联到核心交换机,这就是双上行组网。Smart Link在这种组网中,被部署在SW3上。Smart Link具有如下特点:

- 在双向行的设备上部署,当网络正常时,这两根上行链路其中一根处于活跃状态,而另一根链路处于备份状态从而被阻塞。如此一来环路就会被打破。

- 当主用链路发生故障后,流量会在**毫秒级**的时间内迅速切换到备用链路上,保证了数据的正常转发。

- 配置简单,便于用户操作。

- 无需协议交互报文,因此大大提升的收敛的速度和可靠性。

- Smart Link是华为私有特性。

基础术语¶

Smart Link Group¶

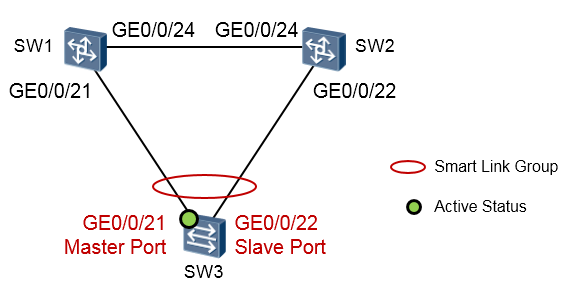

Smart Link Group¶

Smart Link组,也称为灵活链路组,一个Smart Link组包含两个成员接口,一个主接口(Master Port) 一个从接口(Slave Port)。正常情况下,只有一个接口(主接口或从接口)处于活跃(Active)状态, 另一个接口处于非活跃(Inactive)状态被阻塞。

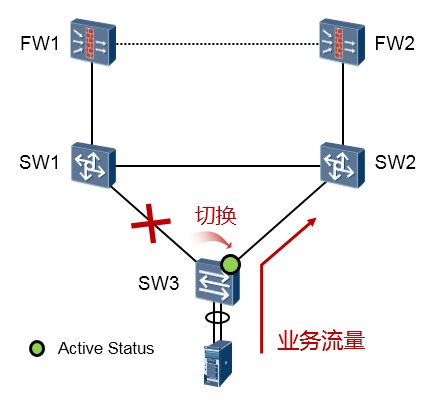

当处于活跃状态的接口出现链路故障时(这里的链路故障包括接口down、OAM单通等),Smart Link

组会自动将该接口阻塞,并将原阻塞的、处于非活跃状态的接口切换到活跃状态,开始转发数据。

Master/Slave接口¶

主/从接口是Smart Link组中的两个接口角色,是通过命令指定的。当两个接口都正常工作时,主接口进入active状态,而从接口保持inactive。当主接口或其所在链路发生故障时,从接口切换为active。

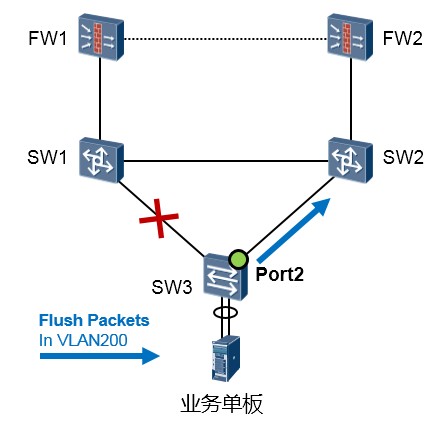

发送控制VLAN¶

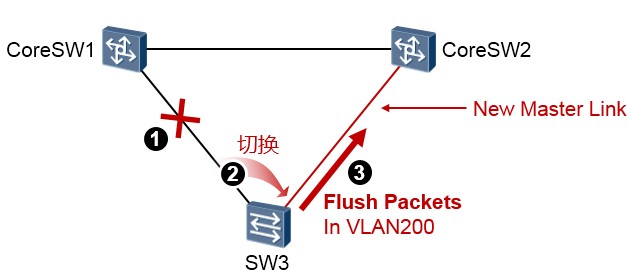

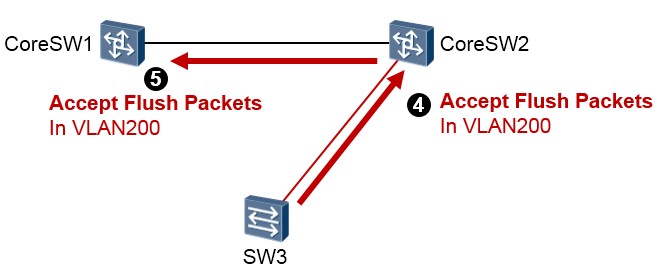

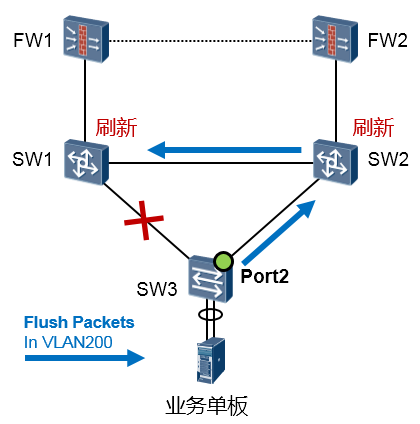

发送控制VLAN(Send Control VLAN)是Smart Link组用于泛洪flush报文的VLAN。在上图中,当SW3 交换机发生SmartLink的切换时——显然是网络拓扑发生了变化——这个变化可能对于网络中的其他设备来说(例如上游交换机CoreSW1及CoreSW2)并不一定能够“感知”,此刻对于它们而言原有的

MAC表等表项可能已经不可用了,必须尽快刷新,flush报文就是用来刷新他们的相关表项的。

如果在SW3上开启了flush报文发送功能,当发生链路切换时,设备会在新的主用链路上、在发送控制

VLAN内组播发送flush报文,以便刷新上游交换机的相关转发表项,加快网络收敛。

接收控制VLAN¶

接收控制VLAN是上游设备用于接收并处理flush报文的VLAN。如果上游设备CoreSW1及CoreSW2能够识别flush报文,并开启了flush报文接收处理功能,当发生链路切换时,上游设备会处理收到的属于接收控制VLAN的flush报文,进而执行MAC地址转发表项和ARP表项的刷新操作。要注意在SW3上配置的发送控制VLAN要和CoreSW1及CoreSW2上配置的接收控制VLAN一致。

工作机制¶

拓扑环境¶

上图展示的是一个使用了ATAE/E9000的典型组网。SW1及SW2是核心交换机,SW3是部署了堆叠的交换板卡,可以将其理解为一台交换机。此时SW3正是双链路上行,这个场景非常适合部署Smart Link。值得注意的是Smart Link是配置在SW3交换机上的,其他的交换机上无需配置。在SW3上创建一个Smart Link组,然后将Port1添加到该组中,并设置其接口角色为Master;同时将Port2口也添加到该Smart Link组中,并设置其角色为Slave。

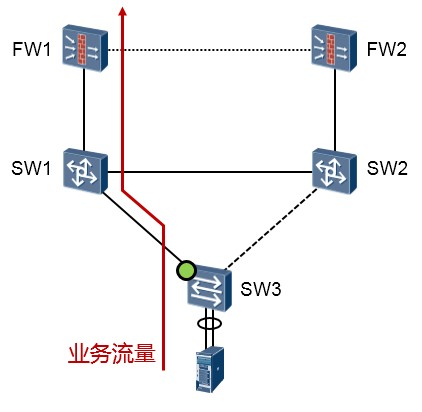

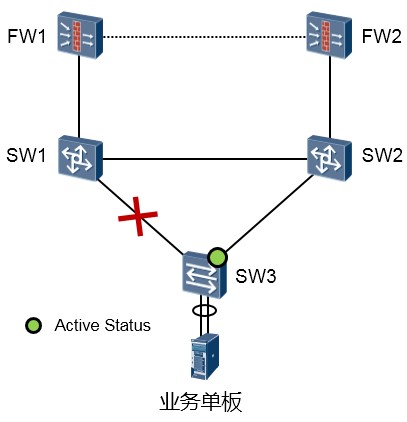

网络工作正常时¶

当网络工作正常时,也就是双上行链路都正常的情况下,Master口Port1处于活跃状态(Active),其所在的链路是主用链路(Master Link);Slave端口处于非活跃状态(Inactive),所在链路是备用链路。如此一来,SW3的Port2相当于被阻塞了,不会转发数据,因此数据沿着红色线条所表示的路径进行传输,网络中不存在环路,不会产生广播风暴。

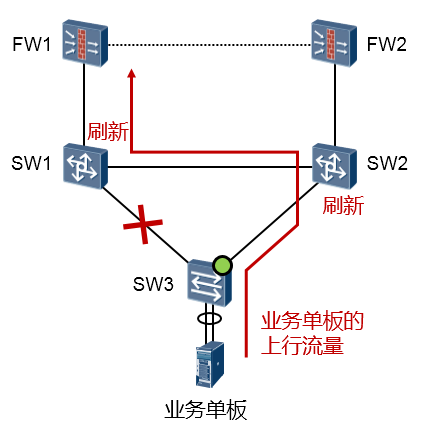

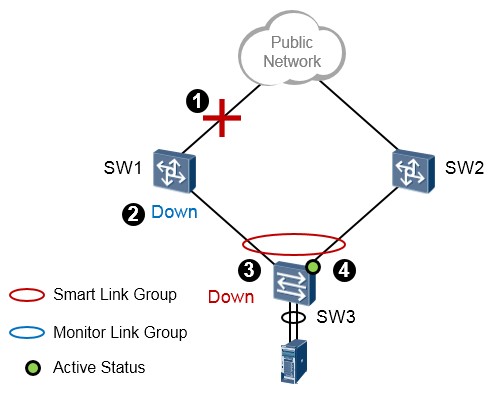

网络发生故障时¶

当SW3的Port1或者其直连的链路发生故障时,Master端口Port1切换到Inactive状态,Slave端口Port2 切换到Active状态。这个过程是以非常快的速度完成的,因为无需任何的协议报文的交互,完全由SW3 设备自己感知、完成切换,所以收敛的速度是毫秒级别。

网络拓扑变更机制¶

机制概述¶

当 Smart Link 发生链路切换时,网络中各设备上的MAC地址转发表项和ARP/ND表项可能已经不是最

新状态,为了保证报文的正确发送,需要提供一种MAC地址转发表项和ARP/ND表项的更新机制。目前更新机制有以下两种:

-

由Smart Link 设备从新的Master 链路上发送flush报文。此方式需要上行的设备都能够识别

SmartLink的flush报文并进行更新MAC地址转发表项和ARP/ND表项的处理。

- 自动通过流量刷新MAC地址转发表项和ARP/ND表项。此方式适用于和不支持Smart Link功能的设备(包括其他厂商设备)对接的情况,需要有上行的流量触发。

方式一:通过flush报文通知设备更新表项¶

这种方式适用于上游设备(如图中的SW1、SW2)支持SmartLink功能、能够识别flush报文的情况。为了实现快速链路切换,需要在SW3上开启flush报文发送功能,另外,在上游设备所有处于双上行网络的接口开启接收处理flush报文功能。

SW3发生链路切换后,会在新的主用链路上发送flush报文。Flush报文的VLAN Bitmap字段填充链路切换前组内处于转发状态的Port1口所在Smart Link组的保护VLAN ID,Control VLAN ID 字段填充Smart

Link组配置的发送控制VLAN ID。

当上游设备收到flush报文时,判断该flush报文的发送控制VLAN是否在收到报文的端口配置的接收控制

VLAN列表中。如果不在接收控制VLAN列表中,设备对该flush报文不做处理,直接转发;如果在接收控制VLAN列表中,设备将提取flush报文中的VLAN Bitmap数据,将设备在这些VLAN内学习到的MAC 及ARP表项删除。

为了保证flush报文在发送控制VLAN内正确传送,请确保双上行网络上的所有端口都允许发送控制

VLAN通过,否则,flush报文将发送或转发失败。建议以保留Tag的方式发送flush报文,若想以去掉Tag 的方式发送flush报文,需确保对端端口缺省VLAN和发送控制VLAN一致,否则将导致flush报文不在发送控制VLAN内传送。

方式二:无flush方式¶

这种方式适用于与不支持Smart Link功能的设备(包括其他厂商设备)对接的情况,需要有上行流量触发。例如上图中SW3是支持Smart Link的设备,而SW1、SW2不支持Smart Link的情况。

如果没有SW3的上行流量(这些流量可能来自SW3下联的终端)去触发SW1、SW2的MAC及ARP表项更新,那么当SW1、SW2收到目的设备为业务单板的数据时,流量就可能会发生中断。以SW2为例, 如果其关于下游业务单板的MAC地址表项的关联接口还是老旧的(还是关联到与SW1对接的接口), 那么当SW2有下行流量要转发(外部网络发往业务单板的流量)时,只有在其表项自动老化、重新学习后,流量才能被正确发送到SW3。当业务单板的上行流量通过SW3到达SW2后,后者会更新自己的

MAC表,那么当SW2再收到目的MAC为业务单板MAC地址的数据时,SW2会通过其连接SW3的接口转发出去,报文才可以经由SW3到达单板。因此这种方式相比于通过Flush报文的方式而言,效率就要低得多。

通过flush报文通知设备更新的机制无须等到表项老化后再进行更新,可以大大减少表项更新所需时间。

一般情况下,链路的整个切换过程可在毫秒级的时间内完成的,基本无流量丢失。但是要求上联的交换机都支持Smart Link功能。

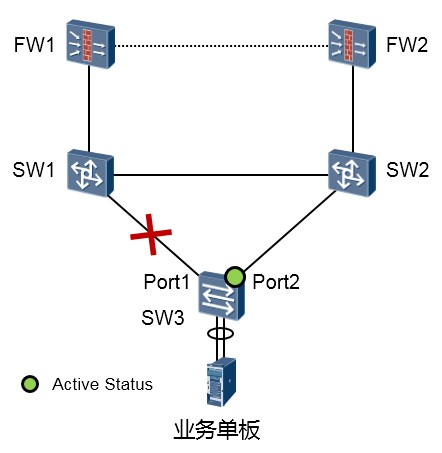

链路恢复机制¶

在上图中SW3交换机的Port1口为Smart Link组的Master接口,Port2口为Slave接口。缺省时,Port1为active 状态。现在,Port1口或其直连链路发生了故障,导致Smart Link组发生切换,Slave接口Port2处于active状态,那么当Master接口Port1恢复后,会发生什么事情呢?

Smart Link组支持两种模式:角色抢占模式和非角色抢占模式。

角色抢占模式:¶

若Smart Link组配置为角色抢占模式,当主用链路故障恢复后,Master接口将抢占为active状态,Slave

接口则进入inactive状态,如上图所示。

非角色抢占模式:¶

若Smart Link组配置为非角色抢占模式,当Master Link从故障中恢复后,Port2将继续处于active状态,

Master口Port1继续处于inactive状态,这样可以保持流量的稳定。缺省情况下就是非抢占模式。使用**smart-link manual switch**命令可手工执行链路倒换。

配置及验证¶

实验拓扑¶

内网有VLAN10及20(SW3下挂的用户,在上图中并未画出);VLAN99为Smart Link控制VLAN。在SW3上创建SMLK组, GE0/0/21为Master 口; GE0/0/22为Slave口。内网流量在网络正常时走

GE0/0/21,当GE0/0/21挂掉的时候自动切换到GE0/0/22;当GE0/0/21故障恢复的时候,能重新进入转

发状态,流量仍然从GE0/0/21进行转发。

配置及实现¶

SW3的配置如下:

[SW3] vlan batch 10 20 99

#配置接口类型为trunk并放行相关VLAN(用户VLAN及控制VLAN) [SW3] Interface gigabitethernet0/0/21

[SW3-gigabitethernet0/0/21] port link-type trunk

[SW3-gigabitethernet0/0/21] port trunk allow-pass vlan 10 20 99 [SW3] Interface gigabitethernet0/0/22

[SW3-gigabitethernet0/0/22] port link-type trunk

[SW3-gigabitethernet0/0/22] port trunk allow-pass vlan 10 20 99

#关闭接口下的STP。加入到Smart Link组的接口必须关闭STP: [SW3] Interface gigabitethernet0/0/21

[SW3-gigabitethernet0/0/21] stp disable [SW3] Interface gigabitethernet0/0/22 [SW3-gigabitethernet0/0/22] stp disable

#创建Smart Link Group1 [SW3] smart-link group 1

[SW3-smlk-group1] port gigabitethernet0/0/21 master #添加接口GE0/0/21到Smartlink组并指定为Master接口

[SW3-smlk-group1] port gigabitethernet0/0/22 slave #添加接口GE0/0/22到Smartlink组并指定为Slave接口 [SW3-smlk-group1] flush send control-vlan 99 password simple 123 #配置发送控制VLAN并设置密码 [SW3-smlk-group1] restore enable #激活回切功能,缺省时,该功能为关闭状态

SW1的配置如下:

SW2的配置如下:

| 完成上述配置后,我们来做一下验证及查看: | ||||

|---|---|---|---|---|

| [SW3] display smart-link group 1 Smart Link group 1 information : Smart Link group was enabled Wtr-time is: 30 sec. There is no Load-Balance There is no protected-vlan reference-instance DeviceID: 4c1f-cc2c-1dd9 Control-vlan ID: 99 Member Role State Flush Count Last-Flush-Time ----------------------------------------------------------------------------------------------------------------------- | ||||

| GigabitEthernet0/0/21 | Master | Active | 1 | 2014/09/02 14:02:34 UTC-08:00 |

| GigabitEthernet0/0/22 | Slave | Inactive | 0 | 0000/00/00 00:00:00 UTC+00:00 |

| 从上面的输出可以看到,GE0/0/21口目前处于active状态,而GE0/0/22口处于inactive状态。接下去看 看当SW3的GE0/0/21口发生故障时,发生的现象。手工将SW3的GE0/0/21口shutown。 | ||||

| [SW3]display smart-link group 1 Smart Link group 1 information : Smart Link group was enabled Wtr-time is: 30 sec. There is no Load-Balance There is no protected-vlan reference-instance DeviceID: 4c1f-cc2c-1dd9 Control-vlan ID: 99 Member Role State Flush Count Last-Flush-Time ----------------------------------------------------------------------------------------------------------------------- | ||||

| GigabitEthernet0/0/21 | Master | Inactive | 1 | 2014/09/02 14:02:34 UTC-08:00 |

| GigabitEthernet0/0/22 | Slave | Active | 1 | 2014/09/02 14:05:34 UTC-08:00 |

我们看到GE0/0/21口的状态变成了inactive,而GE0/0/22口的状态变成了active。同时GE0/0/22口的

Flush Count变成了1,表示在拓扑变更后,向GE0/0/22口发送过一次Flush报文。

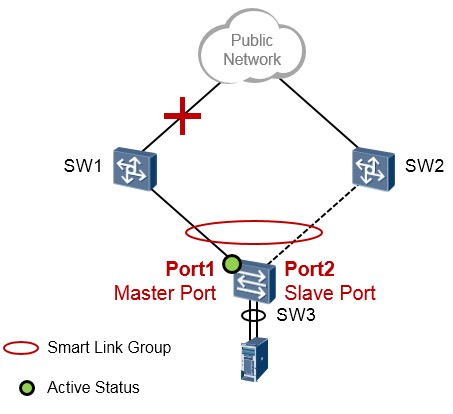

Monitor Link¶

技术背景¶

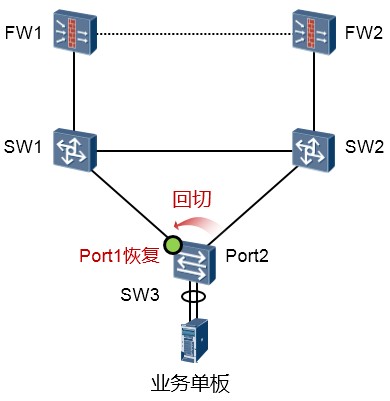

考虑上面的拓扑,由于SW3交换机是双上行的组网,非常适合部署Smart Link,因此我们将交换机的生成树关闭,并且部署Smart Link,将Port1口设置为Master接口,Port2口设置为Slave接口。当Port1口或者其直连链路发生故障时,SW3交换机能够感知并且迅速切换,但是如果SW1的上行接口发生故障,如图所示,SW3交换机是无法感知的,因此也就无法实现切换。为了解决这个问题,需要一个新的技术与Smart Link搭配使用,这就是Monitor Link。

关于Monitor Link¶

Monitor Link组也称为监控链路组,由一个或多个上行和下行接口组成。下行接口的状态随上行接口状态的变化而变化。

-

上行接口(Uplink Port)是Monitor Link组中的监控对象,是通过命令行指定的Monitor Link组的一种接口角色。如果多个接口被配置为Monitor Link组的上行接口,只要这些接口中有一个接口处于转发状态,那么Monitor Link组的状态就为UP;只有当所有上行接口都发生故障时,Monitor Link 组的状态才为Down,这时所有下行接口将都将被关闭。当Monitor Link组的上行接口未指定时,则认为上行接口故障,所有下行接口都将被关闭。

-

下行接口(Downlink Port)是Monitor Link组中的监控者,是通过命令行指定的Monitor Link组的另外一种接口角色。Monitor Link组的下行接口可以是以太网接口(电口或光口)或聚合接口(Eth-

trunk接口)。

-

当Monitor Link组的上行接口恢复正常时,Monitor Link只会开启因上行接口故障而被Monitor Link 阻塞的下行接口,不能开启通过命令shutdown手工关闭的下行接口。并且某个下行接口故障对上行接口和其他下行接口没有影响。

-

Smart Link与Monitor Link的搭配¶

在上图中,我们在SW3交换机上部署Smart Link。同时在SW1上部署Monitor Link,将SW1的GE0/0/1

设置为Uplink接口,将SW1的GE0/0/2设置为Downlink接口。

如此一来,当SW3交换机的Port1接口或者与SW1之间的互联链路发生故障,SW3交换机的Smart Link 能够实现切换。而当SW1交换机的上行接口GE0/0/1接口发生故障或者其与Public Network之间的链路发生故障的话,SW1的GE0/0/1口将会立即down掉,而这将导致SW1的GE0/0/2被Monitor Link关闭, 这样一来SW3交换机的Port1也就Down了,于是Smart Link能够进行正常的切换。如下图所示:

实验验证¶

先做一个简单的测试,在SW1验证一下Monitor Link:

完成后检查一下配置:

| Recover-timer is 3 sec. | ||||

|---|---|---|---|---|

| Member | Role | State | Last-up-time | Last-down-time |

| GigabitEthernet0/0/1 | UpLk | UP | 0000/00/00 00:00:00 UTC+00:00 | 0000/00/00 00:00:00 UTC+00:00 |

| GigabitEthernet0/0/2 | DwLk[1] | UP | 0000/00/00 00:00:00 UTC+00:00 | 0000/00/00 00:00:00 UTC+00:00 |

| 从上述输出可以看出,uplink接口GE0/0/1是UP的,因此downlink接口GE0/0/2也是UP的。接着我们把 GE0/0/1口shutdown,然后就能观察到: | ||||

| [SW1] display monitor-link group 1 Monitor Link group 1 information : Recover-timer is 3 sec. | ||||

| Member | Role | State | Last-up-time | Last-down-time |

| GigabitEthernet0/0/1 | UpLk | DOWN | 0000/00/00 00:00:00 UTC+00:00 | 2014/09/09 10:26:40 UTC-08:00 |

| GigabitEthernet0/0/2 | DwLk[1] | DOWN | 0000/00/00 00:00:00 UTC+00:00 | 2014/09/09 10:26:41 UTC-08:00 |

随着uplink接口down掉,downlink接口GE0/0/2也被自动地shutdown。

- 实现 VLAN 间的互访

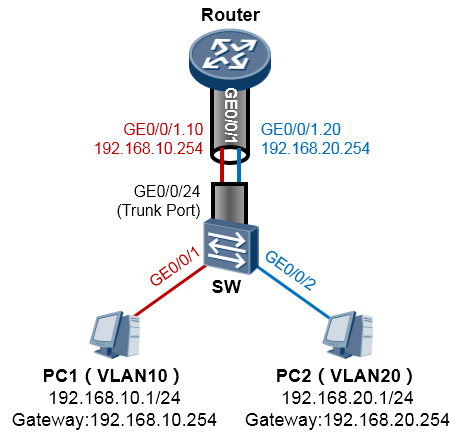

- 通过子接口实现 VLAN 间的互访

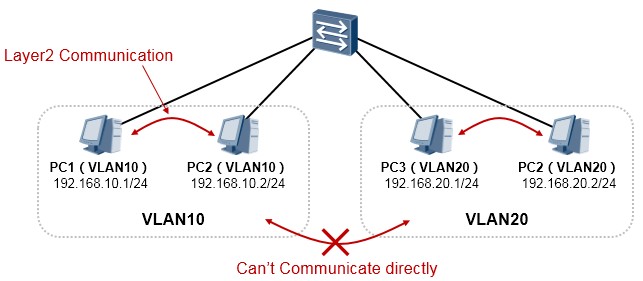

在二层交换环境下,一个VLAN就是一个广播域,相同VLAN内的节点如果配置相同网段的IP地址即可直接通信,我们将这种通信称为二层通信。不同VLAN是不同的广播域,一般也是不同的逻辑子网,而且相互隔离,无法直接互访,这样能起到隔绝广播的作用,如上图所示。

但是实际网络中往往VLAN之间有互访的需求,例如同一公司不同的部门划分在不同的VLAN,那么如果这些部门之间有数据往来的需求呢,此时二层交换机就无法实现了,需要借助三层设备(路由设备)。一个最简单的方法,就是使用路由器:

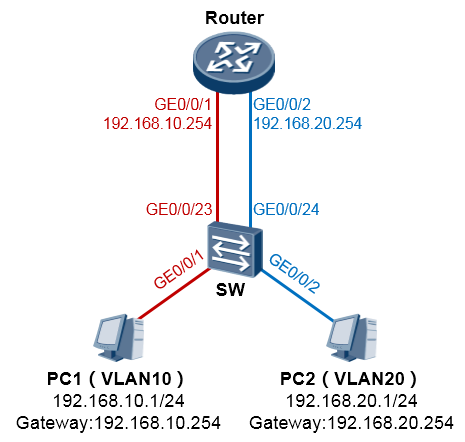

在上图中,交换机将GE0/0/1及GE0/0/23口都配置为access类型并都加入VLAN10;将GE0/0/2及GE0/0/24

都配置为access类型并都加入VLAN20。然后将路由器Router的GE0/0/1口作为VLAN10用户的网关,

GE0/0/2作为VLAN20用户的网关,从而利用路由器的路由功能实现两个VLAN之间的互访,这么做看似可行,但是一个VLAN就需要路由器拿出一个接口,那么如果内网有10个VLAN呢?路由器表示鸭梨很大。所以另一种稍微改进点的方法是,在路由器的一个物理接口上,配置逻辑的子接口(Sub-interface)来实现同样的需求,这种解决方案叫单臂路由:

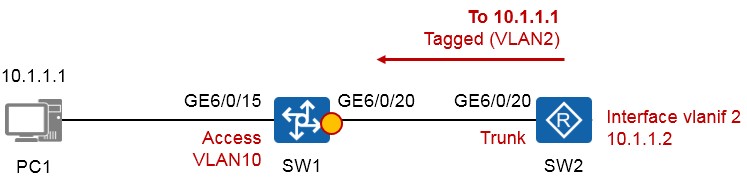

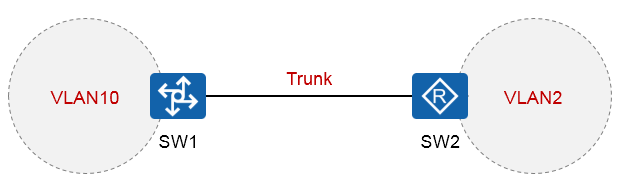

在上图中,交换机与路由器之间仅需一根物理链路即可,这段链路由于要承载多VLAN的数据,因此在交换机上就要将与路由器对接的接口(GE0/0/24)设置为Trunk类型。路由器这边呢虽然只有一个物理接口

(GE0/0/1)与交换机相连,但是我们可以基于这个物理接口创建多个子接口,子接口GE0/0/1.10对应

VLAN10,它能够识别VLAN10的标记,并且能够处理带VLAN10标记的数据帧,同理GE0/0/1.20对应

VLAN20。如此一来,在路由器上仅使用一个物理接口,即可支持多个VLAN的数据。

子接口是一个软件的、逻辑的接口,是基于物理接口创建的。路由器会把子接口当成是一个普通接口来对待。通过子接口的方式我们可以大大的节省硬件成本。具体的配置如下:

完成如上配置后,交换机连接PC的接口添加到相应的VLAN则PC即可互通。从上面这个碉堡的图可以更加形象地理解子接口的概念,其实就是相当于在一个大管道里套着两个小管道。值得注意的是一旦我们在物理接口上创建了子接口,那么后续的配置将不会再在物理接口上做,而是在子接口上进行,我们只要保证物理接口没有被shutdown即可。

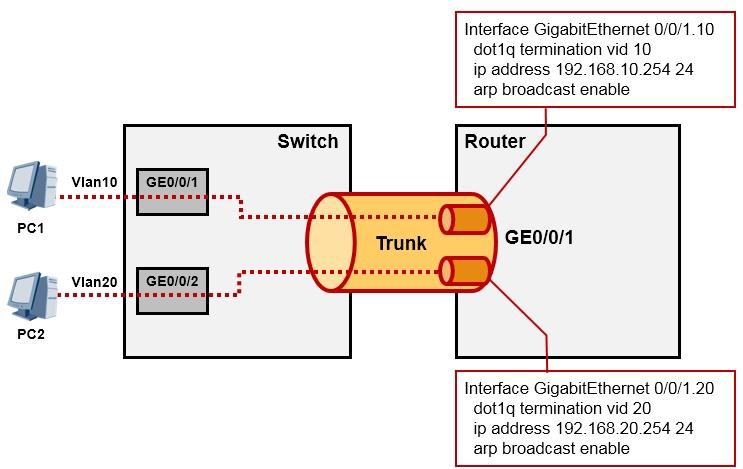

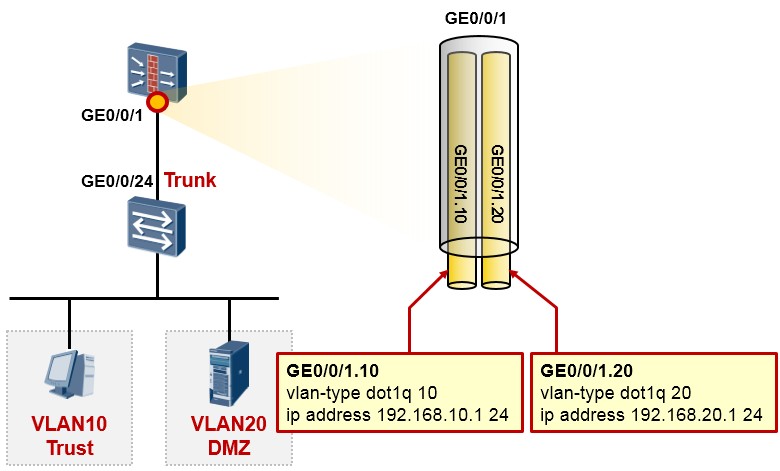

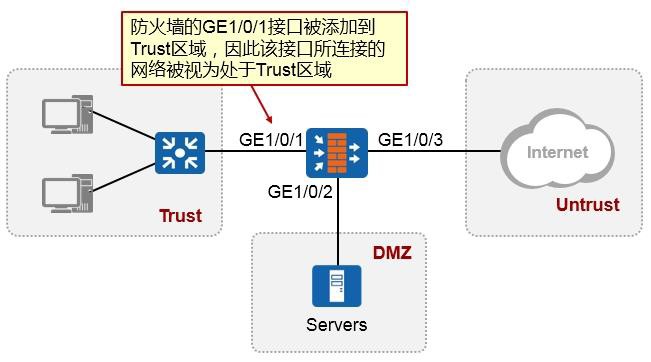

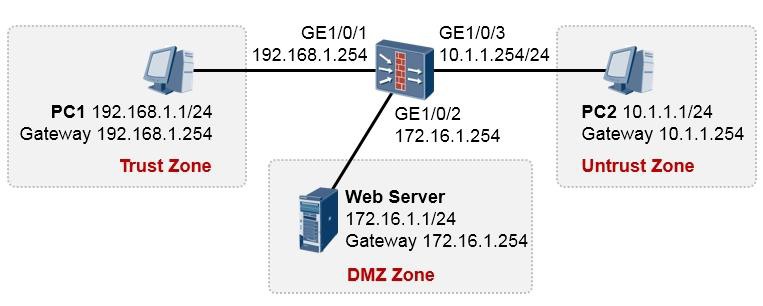

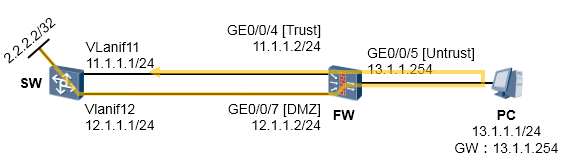

以太网子接口技术可部署在路由器上,也可以部署在防火墙上,我们来看一个例子。

上面是一个非常简单的组网场景,站点内网有两个VLAN,VLAN10及VLAN20。现在的需求是,要求VLAN10 及VLAN20能够实现互访,而且互访流量必须经过防火墙做安全检查。VLAN10内的网元非常重要,属于高安全级别的网络,而VLAN20内的网络则安全级别更低。

解决的办法:¶

上图中的交换机工作在二层模式,连接终端的接口配置为access类型并且分别加入到相应的VLAN。同时交换机连接防火墙的接口GE0/0/24配置为Trunk类型并且放通VLAN10及VLAN20。

随后在防火墙的GE0/0/1口上创建两个子接口:GE0/0/1.10及GE0/0/1.20,子接口的配置如图所示,这两个子接口分别对应VLAN10及VLAN20。最后别忘了要将子接口添加到相应的安全域中,例如VLAN10这个网络如果比较重要,则可将防火墙的GE0/0/1.10接口添加到高安全级别的区域,如Trust,而VLAN20可能需要接受来自外部的访问,因此规划在DMZ域,故将子接口GE0/0/1.20添加到DMZ区域。接下去就可以部署域间包过滤规则了。

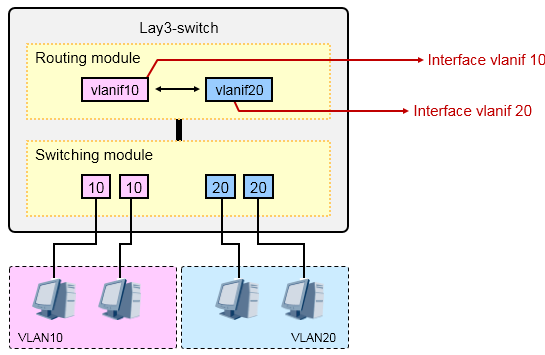

- 通过 vlan-interface 实现 VLAN 间的互访

在理解了子接口之后,再来看看三层交换机是如何实现VLAN间的数据互访的,从这里切入,开始理解并部署三层交换。我们知道二层交换机是可以实现二层交换的,它关心的是数据帧,对帧头的二层信息进行读取并且根据自己的MAC地址表进行转发。而三层交换机相当于在二层交换机的基础上,多了个路由模块,于是乎它就能支持路由功能了:支持路由选择协议、支持三层数据转发、支持IP路由查找、支持三层接口等等。

先来认识一下vlan-interface(简称vlanif),这是一个逻辑接口,也就是说这并不是一个真实的物理接口, 当我们在交换机上创建了一个VLAN之后,紧接着就可以创建一个与这个VLAN对应的vlanif,例如我们创建了VLAN10,那么VLAN10对应的vlanif就是interface vlanif 10,这个vlanif10是一个三层接口,你可以为这个

vlanif10配置IP地址,与VLAN10内的PC用户的IP地址同一网段,这样一来,VLAN10内的用户就能够将网

关指向这个vlanif,当VLAN10的PC需要访问本网段以外的网络时,它们将数据交给网关,也就是vlanif10, 再由三层交换机去做路由查找及数据转发。实际上,在这个理解过程中,我们可以拿单臂路由那个模型对类比。

所以看上面这图,在三层交换机上创建了两个VLAN:10和20,同时为两个VLAN的vlanif分配了地址作为各自VLAN的用户网关,这样一来,这台交换机的路由表里就有了两个VLAN网段的路由。那么当两VLAN之间要互访时,VLAN10的用户将数据丢给自己的网关,也就是vlanif10,数据到了vlanif10之后,三层交换机查看数据包的目的地址IP并在路由表中进行匹配,发现目的地是VLAN20的所在网段,因此将数据从VLAN20 扔出去,最终抵达目的地的VLAN20的PC。

Vlanif的基础配置:¶

实验拓扑如上图所示。PC1及PC2分别位于VLAN10及VLAN20,现在要求完成三层交换机SW的配置,使得两个VLAN的用户能够相互通信。

SW的配置如下:

[SW-vlanif10] ip address 192.168.20.254 24

完成上述配置后,PC1将自己的IP地址设置在192.168.10.0/24网段,同时将网关配置为192.168.10.254;

PC2的IP地址则配置在192.168.20.0/24,网关设置为192.168.20.254,两者就能够互相通信了。

二、三层交换机、路由器简单组网:¶

实验拓扑如上图所示。PC1及PC2分别处于VLAN10及VLAN20,它们的缺省网关都设置在三层交换机SW2 上。SW1是接入层交换机,只具备二层交换功能。SW2与路由器Router实现三层对接,用于两者对接的VLAN 是VLAN99。上述拓扑,我们可以画一个逻辑图来帮助理解:

SW1的配置如下:

SW2的配置如下:

Router的配置如下:

- 链路聚合

- 链路聚合技术背景

在一个网络中,某些关键链路承载的流量可能非常大,链路的负载可能会很高,带宽就会成为数据传输的瓶颈。如果增加带宽,那就需要增加硬件投入,例如将链路从千兆电口换成万兆光纤接口,这就不得不增加成本。另一个问题是单点故障的问题,一旦这根链路发生故障,那么不可避免的将影响到网络的可达性。如下图所示:

以太网链路聚合技术(Link Aggregation),或者称为端口捆绑、链路捆绑技术,是一种通用的以太网技术。通过该技术,我们能够将多条以太网链路进行“捆绑”,捆绑之后的这些物理链路就形成了逻辑上的一条新的链路(Eth-Trunk),这条聚合链路不仅仅在带宽上成倍的增加,还同时提供了负载均衡及链路冗余。有人可能会问,为啥要那么麻烦,交换机之间多连几根线不就完了么?多连几根线实际上就多创造了几个环路,这时由于生成树的作用,必然会阻塞掉几个端口,如此一来仍然只有一条链路在转发数据,还是达不到我们的预期。但是使用链路聚合功能,则可将这几根链路捆绑成逻辑上的一条,交换机会将捆绑后的这根聚合链路当做一条链路来对待,自然也就不存在环路的问题了。

举个非常简单的例子,上图中,两台交换机的GE0/0/1到GE0/0/2接口两两对接,如果在SW1及SW2上分别将自己的GE0/0/1到GE0/0/2接口进行捆绑,则会产生出一个聚合接口,也就是Eth-trunk接口。链路聚合技术能够部署在交换机之间、防火墙之间、交换机与防火墙之间、交换机与特定的服务器之间等等,是一种应用非常广泛的技术。华为交换机上的Eth-trunk支持两种工作方式:手工负载分担及LACP。

- 工作方式:手工负载分担(Manual load-balance)

手工负载分担方式允许在聚合组中手工加入多个成员接口,并且所有的接口均处于转发状态,分担负载的流量。在这种模式下,Eth-Trunk的创建、成员接口的加入都需要手工配置完成,没有LACP(link Aggregation Control Protocol)协议报文的参与。手工负载分担模式通常用在对端设备不支持LACP协议的情况下。

基础配置命令如下:

[Huawei-Eth-Trunk1] least active-linknumber ?

- 工作方式:LACP

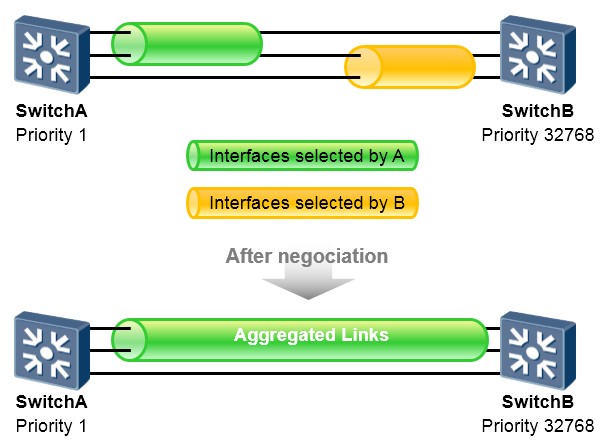

LACP方式是一种利用LACP协议进行聚合参数协商、确定活动接口和非活动接口的链路聚合方式。该模式下,需手工创建Eth-Trunk,手工加入Eth-Trunk成员接口,但是,由LACP协议协商确定活动接口和非活动接口。

LACP模式也称为M∶N模式。这种方式同时可以实现链路负载分担和链路冗余备份的双重功能。在链路聚合组中M条链路处于活动状态,这些链路负责转发数据并进行负载分担,另外N条链路处于非活动状态作为备份链路,不转发数据。当M条链路中有链路出现故障时,系统会从N条备份链路中选择优先级最高的接替出现故障的链路,同时这条替换故障链路的备份链路状态变为活动状态开始转发数据。

LACP模式与手工负载分担模式的主要区别为:LACP模式有备份链路,而手工负载分担模式所有成员接口均处于转发状态,分担负载流量。此外,LACP模式下,交换机之间会交互LACP报文。

LACP模式中有一个主动、被动端的概念。设备LACP优先级较高(值越小越优)的一端为主动端,设备LACP

优先级较低的一端为被动端。如果两端设备的LACP优先级一样时,则MAC地址小的胜出。

在上图所示的场景中,SwitchA及SwitchB之间部署了Eth-Trunk,该Eth-Trunk中包含三条直连链路,并且采用的是LACP方式。两者会交互LACP报文使得聚合链路能够协商建立。A和B会比较两者的设备LACP优先级,值最小的胜出成为主动端,这里假设A胜出。从图中我们看到A选择了上面两条链路作为活动链路,而

B选择了下面两条链路,由于A是主动端,因此最终AB之间建立起来的聚合链路中的活动链路由A来确定, 也就是上面两条链路成为活动链路。

基础配置命令(此处以S5700 V200R001C00版本为例,不同的软件版本,在配置上可能存在细微差异):¶

#创建Eth-Trunk,并将工作方式修改为LACP:

[Huawei] interface eth-trunk 1

[Huawei] mode lacp-static #缺省情况下,Eth-Trunk的工作模式为手工负载分担方式。

#添加成员接口到Eth-Trunk中(根据实际情况添加): [Huawei] interface GigabitEthernet0/0/1

[Huawei-GigabitEthernet0/0/1] eth-trunk 1 [Huawei] interface GigabitEthernet0/0/2 [Huawei-GigabitEthernet0/0/2] eth-trunk 1 [Huawei] interface GigabitEthernet0/0/3 [Huawei-GigabitEthernet0/0/3] eth-trunk 1

#(可选)配置Eth-trunk成员链路的负载分担模式:

[Huawei-Eth-Trunk1] load-balance ?

#(可选)配置设备LACP优先级: [Huawei] lacp priority ?

系统LACP优先级值越小优先级越高,缺省情况下,系统LACP优先级为32768。在两端设备中选择系统LACP优先级较小一端

作为主动端,如果系统LACP优先级相同则选择MAC地址较小的一端作为主动端。

#(可选)配置接口LACP优先级:

[Huawei-GigabitEthernet0/0/1] lacp priority ?

缺省情况下,接口的LACP优先级是32768。取值越小,表明接口的LACP优先级越高。优先级越高的接口越有可能成为活动的成员接口。

#(可选)配置活动接口数上限阈值:

[Huawei-Eth-Trunk1] max active-linknumber ?

配置链路聚合活动接口数上限阈值,缺省情况下,活动接口数上限阈值为8。

配置LACP模式活动接口数目上限阈值可以控制Eth-Trunk中活动接口的最大数M,剩余的成员接口处于备份状态。

#(可选)配置活动接口数下限阈值:

[Huawei-Eth-Trunk1] least active-linknumber ?

配置链路聚合活动接口数下限阈值,缺省情况下,活动接口数下限阈值为1。

配置LACP模式活动接口数目下限阈值可以决定Eth-Trunk中活动接口数的最小值,如果静态模式下活动接口数目小于该值,

Eth-Trunk的接口状态将变为DOWN的状态。

#(可选)使能LACP抢占并配置抢占等待时间: [Huawei-Eth-Trunk1] lacp preempt enable [Huawei-Eth-Trunk1] lacp preempt delay ?

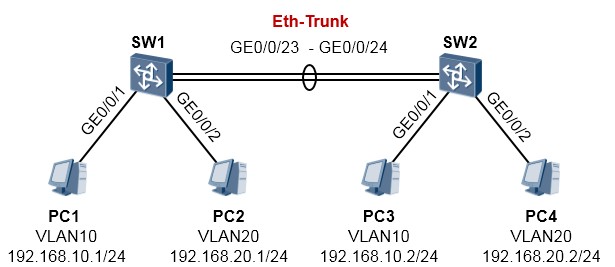

- 基础实验

实验1:手工负载分担模式¶

SW1及SW2通过GE0/0/23及24口互联,配置Eth-trunk将这两条链路进行捆绑。捆绑后的链路配置为

Trunk模式,使得两台交换机下相同VLAN内的用户能够互访,也就是PC1与PC3能够互访;PC2与PC4

也能够互访。

SW1的配置如下:

SW2的配置如下:

完成配置后,在SW1上查看一下:

| PortName | Status | Weight |

|---|---|---|

| GigabitEthernet0/0/23 | Up | 1 |

| GigabitEthernet0/0/24 | Up | 1 |

实验2:LACP方式¶

SW1及SW2的GE0/0/22到GE0/0/24口分别互联,将这三条链路捆绑为Eth-Trunk,使用LACP方式,

SW1为主动端,在该聚合链路中,两条链路为活动链路,其余一条做备份。

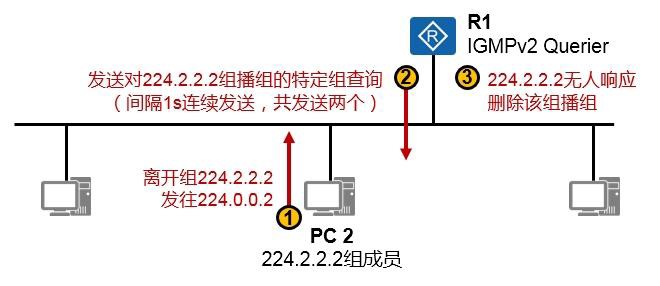

SW1的配置如下:

SW2的配置如下:

完成后检查一下配置:

| System Priority: 1 System ID: 4c1f-ccbe-289e Least Active-linknumber: 1 Max Active-linknumber: 2 Operate status: up Number Of Up Port In Trunk: 2 -------------------------------------------------------------------------------- | |||||||

|---|---|---|---|---|---|---|---|

| ActorPortName | Status | PortType | PortPri | PortNo | PortKey | PortState | Weight |

| GigabitEthernet0/0/22 | Selected | 1000TG | 32768 | 23 | 401 | 10111100 | 1 |

| GigabitEthernet0/0/23 | Selected | 1000TG | 32768 | 24 | 401 | 10111100 | 1 |

| GigabitEthernet0/0/24 | Unselect | 1000TG | 32768 | 25 | 401 | 10100000 | 1 |

| Partner: -------------------------------------------------------------------------------- | |||||||

| ActorPortName | SysPri | SystemID | PortPri | PortNo | PortKey | PortState | |

| GigabitEthernet0/0/22 | 32768 | 4c1f-cc77-6cf4 | 32768 | 23 | 401 | 10111100 | |

| GigabitEthernet0/0/23 | 32768 | 4c1f-cc77-6cf4 | 32768 | 24 | 401 | 10111100 | |

| GigabitEthernet0/0/24 | 32768 | 4c1f-cc77-6cf4 | 32768 | 25 | 401 | 10110000 |

在上述输出中,我们可以看到SW1的eth-trunk1聚合接口的状态。Operate status显示整个聚合接口的

状态为UP。而由于我们设置了max active-linknumber 2,因此三个成员接口中,仅有两个接口(两条链路)是活跃的,它们会转发数据,而剩下的接口则作为备份。我们看到GE0/0/22及GE0/0/23是Select 状态,因此它们是活跃接口,而GE0/0/24是Unselect状态,则它们是非活跃的备份接口。因为SW1是主动端设备,因此由它决定哪些接口是活跃,哪些是非活跃的。

- 交换安全

- 端口镜像

端口镜像概述¶

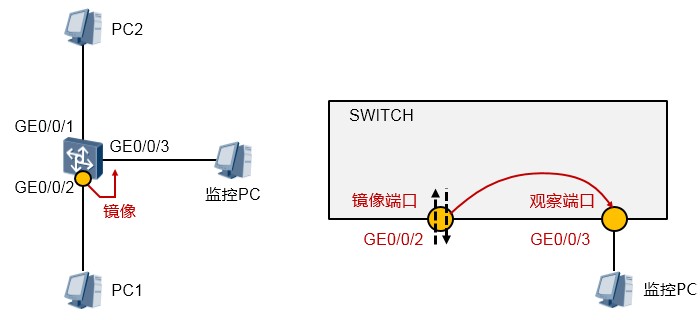

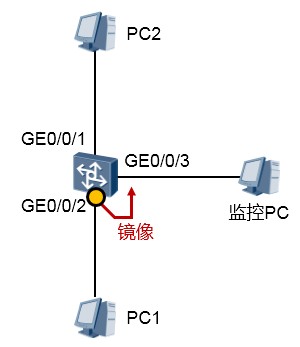

在某些场景中,我们可能需要监控交换机特定端口的入站或出站报文,或者需要针对特定的流量进行分析,例如上图中,我们期望抓取PC1收发的报文并进行分析,那么便可以在交换机的GE0/0/3口接一个监控PC,在监控PC上安装协议分析软件,然后在交换机上部署端口镜像,将GE0/0/2的入、出站流量镜像到GE0/0/3口上来,接下来我只要在监控PC上通过协议分析软件查看报文即可。

注意到,如果没有端口镜像技术,除非数据包的目的地是监控PC(所连接的端口),否则报文是不会发向该端口的。因此事实上端口镜像就是将某个特定端口的流量拷贝到某个监控端口,就这么简单。

端口镜像常用于:流量观测及统计;故障定位等。

镜像的分类:¶

-

基于端口的镜像:

端口镜像就是将被监控端口上的数据复制到指定的监控端口,对数据进行分析和监视。

-

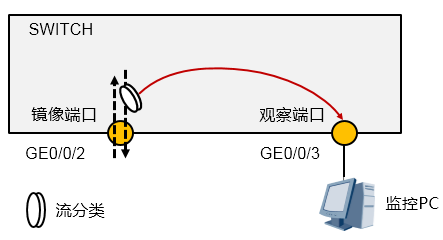

基于流的镜像:

流镜像就是将匹配访问控制列表的业务流复制到指定的监控端口,用于报文的分析和监视。

-

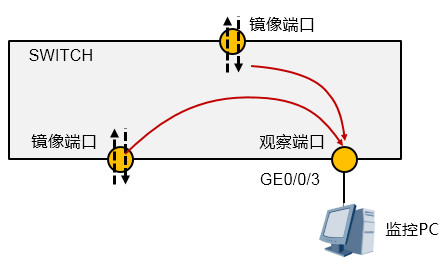

基于端口的镜像¶

端口镜像是指交换机复制一份从镜像端口流经的报文(可以指定入站或出站),并将此报文传送到指定的观察端口进行分析和监视。在端口镜像中,镜像端口流经的所有报文都将被复制到观察端口。

以太网交换机支持多对一的镜像,即将多个端口的报文复制到一个监控端口上。注意区分这里的观察端口和镜像端口。

端口镜像分为本地端口镜像和远程端口镜像:

- 本地端口镜像:本地端口镜像中,监控PC与观察端口直接相连。

-

远程端口镜像:远程端口镜像中,监控PC与观察端口所在设备之间通过二层网络或三层网络相联。

二层端口镜像(RSPAN:Remote Switched Port Analyzer):若通过二层网络互联,以S9300交换机为例,它将镜像端口的报文封装VLAN,然后通过观察端口将报文在远程镜像VLAN中进行广播。远程的设备收到报文后,比较报文的VLAN ID,如果相同,则将该报文转发到远程观察端口。

三层端口镜像(ERSPAN:Encapsulated Remote SPAN):若通过三层网络互联,以S9300交换机为例,它使用GRE报文头封装和解封装镜像报文,使得镜像报文可以穿透三层网络,从而实现镜像端口所在设备与观察端口所在设备之间通过三层网络相连时的端口镜像。

-

基于流的镜像¶

流镜像就是将流镜像端口上的特定数据复制到指定的观察端口或CPU进行分析和监视。流镜像端口是指应用了包含流镜像行为的流策略的接口,从流镜像端口流过的报文,如果匹配此接口上流策略中的流分类,则将被复制并传送到观察端口或CPU。

流镜像分为两种,即流镜像到接口和流镜像到CPU:

- 流镜像到接口,是把通过配置了流镜像的接口上的符合要求的报文复制一份,然后发送到观察端口以供分析诊断。

- 流镜像到CPU,是把通过配置了流镜像的接口上的符合要求的报文复制一份,然后发送到CPU以供分析诊断。这里的CPU指的是配置了流镜像的接口所在接口板上的CPU。

配置本地端口镜像¶

将交换机GE0/0/2端口的进、出口报文镜像到GE0/0/3。交换机配置如下:

报文分析¶

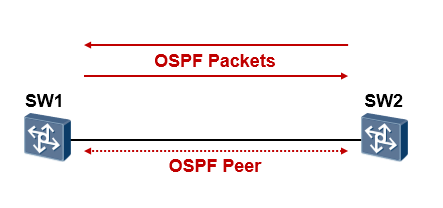

在IP网络中,有着各种各样的流量。协议或业务的正常运转得益于报文的正常交互。例如上图中SW1 及SW2运行OSPF,那么实际上在SW1、SW2之间就在源源不断的交互着OSPF的报文,使得OSPF能够正常工作。再如从SW1去telnet SW2,实际上这个行为在底层也是由相关的报文交互来完成。普通的网络用户仅需要关注能否ping通,或者跑在网络上的业务是否正常,但是作为数通工程师的我们,应该具备从报文层面理解协议或机制的素质。

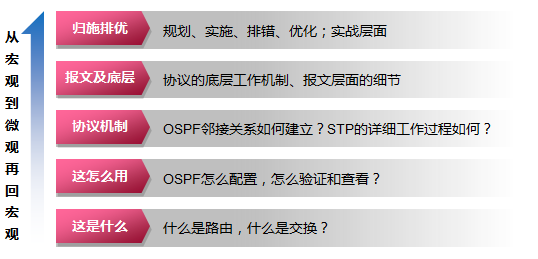

对于一个职业网络工程师,应该能够从报文层面理解IP数据,进而理解各种协议,以及利用这种技术理解对网络进行管理和排障。许多网络故障都可以通过分析包文来定位。网络工程师的成长之路:

报文分析工具¶

常用的报文分析工具有:Wireshark、Ethereal、Sniffer。

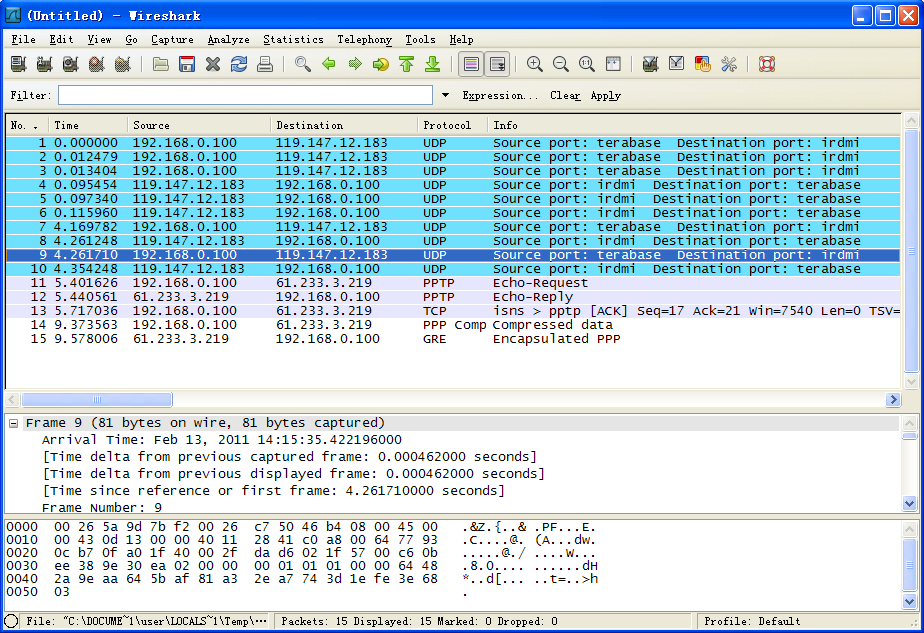

例如下图就是Wireshark软件的界面,在完成软件安装后,启动该软件,然后选择监听本地的哪个网卡, 即可开始在该网卡上侦听报文。下图中显示的就是我们抓取到的各种报文。

小练习:

按照如图所示完成PC及交换机的IP配置。在交换机上开启Telnet服务。

在PC上打开wireshark抓包工具,监控以太网卡,然后从PC telnet交换机,观察抓到的报文,telnet是明文传输的,因此能够通过抓包,将telnet输入的用户名和密码,以及telnet上交换机之后输入的各种操作都抓取下来,因此telnet协议并不安全。

温馨提醒:wireshark是非标软件,擅自安装属信息安全违规,因此如若需安装学习该软件的使用,请自行走相关流程或在私人PC上完成。

注意事项¶

- 观察端口专门用于故障定位或流量分析,不能用作普通业务口。

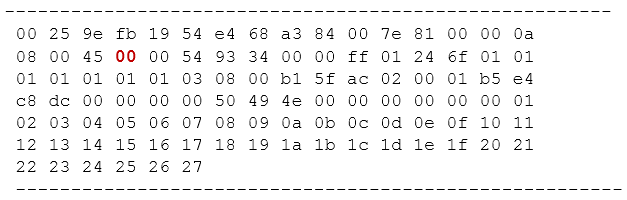

- 捕获业务报文

在实际项目中,在进行问题定位及分析时,我们可能并不具备在交换机上进行端口镜像的条件,例如管理

PC不在机房,工程师通过远程登录的方式连接到网络设备,而如果此时又需要进行报文捕获,那么就可以使用**capture-packet**命令。

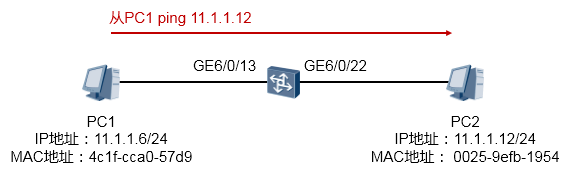

场景一:捕获交换机接口上收到的报文,并将捕获的结果输出到终端界面¶

在上图所示的场景中,我们希望在交换机上抓取接口GE6/0/13收到的报文,并将捕获的报文呈现在终端界面上,以此进行简单的判断:PC1 ping PC2所产生的ICMP报文是否通过该交换机。以S9300交换机为例,执行如下命令:[SW] capture-packet interface GigabitEthernet 6/0/13 destination terminal

交换机便会开始捕获接口GE6/0/13所接收的所有报文,并将报文呈现在终端界面上,在这个过程中, 交换机会持续在终端界面上显示捕获到的报文,直到捕获超时(缺省60s):

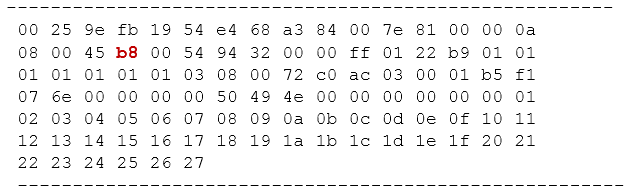

当PC1开始ping PC2时,我们就能在终端界面看到如上输出,上面截取了捕获到的两个报文。以第一个

报文为例,这实际上是一个数据帧,红色字体部分是该帧的目的MAC地址,蓝色字体部分是源MAC地址。我们可以通过这些简单的信息判断目标报文是否到达(实际上,你还能在上述输出中,看到报文的源、目的IP地址等信息)。

场景二:捕获交换机接口上收到的特定报文,并将捕获的结果输出到终端界面¶

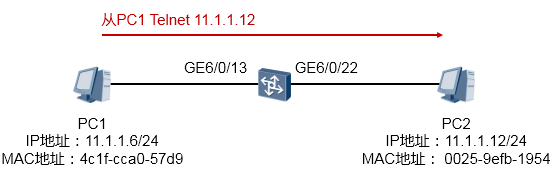

在上图所示的场景中,在交换机上进行报文捕获,只抓取PC1 Telnet PC2的报文。使用ACL3000来匹配感兴趣的流量,然后用capture-packet执行报文捕获。

执行上述命令后,当PC1 telnet PC2时,可以看到如下输出:

另外,在capture-packet interface GigabitEthernet 6/0/13 acl 3000 destination terminal命令的基¶

础上增加**file**关键字并指定文件名,例如**capture-packet interface GigabitEthernet 6/0/13 acl 3000 destination terminal file test.cap**,那么当交换机捕获到报文后,不仅会在终端界面呈现,还会将报文保存到该网络设备的存储空间中,以test.cap的名字存放,这样便可以再完成抓包后,将该文件下载到管理PC并通过抓包软件更加直观地分析捕获的报文。

再者,在**capture-packet**命令中使用**timeout**关键字,还可定义报文捕获的超时时间;使用**vlan**关键字, 可以指定捕获的vlan。该命令目前只支持捕获接口入方向报文,不支持捕获接口出方向报文。捕获的报文有速率限制,缺省值是64kbps,如果有突发流量,超过捕获报文的速率限制,可能会存在丢包现象。最后,设备不支持捕获BFD和802.1ag。

- 端口隔离

基本概述¶

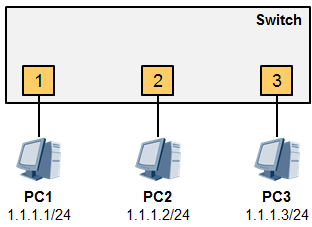

上图中,PC1、2、3同属一个VLAN(假设是VLAN10),使用相同的IP子网。默认情况下三台PC可互相访问,这是典型的二层互访。现在有这么一个需求,在不修改IP子网及VLAN规划的情况下,使得PC1-

PC2之间无法互访,而PC1与PC3可互访、PC2与PC3可互访。这就可以用到端口隔离特性。

这里需要用到端口隔离组的概念,交换机的端口可以加入到特定的隔离组中,同一端口隔离组的端口之间互相隔离,不同端口隔离组的端口之间不隔离。因此要实现上述需求,配置的思路非常简单,在交换机上将端口1、2放置在同一隔离组中,端口3不做隔离组配置或者放入另一个隔离组中,然后开启端口隔离特性即可。

实验验证¶

在上图中,PC1、PC2、PC3同属VLAN10、同属1.1.1.0/24子网,IP地址如上图所示。配置端口隔离, 使得PC1与PC2无法互访;PC1与PC3,PC2与PC3可互访。

交换机的配置如下:

完成上述配置后,检查一下:

将端口1及端口2都加入隔离组1,这样PC1及PC2就二层隔离了,也就无法互访了。但是PC1及PC2都

能够与PC3互访。**Port-isolate mode l2**这条命令是将隔离模式设置为二层隔离三层不隔离。所谓的三层不隔离指的是同一个隔离组的节点之间仍然能够通过三层进行互访,例如:

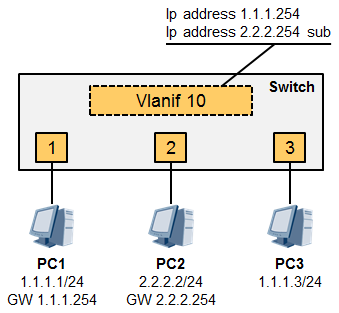

PC1的IP为1.1.1.1,网关为vlanif10的IP 1.1.1.254,PC2的IP为2.2.2.2,网关为vlanif10的IP 2.2.2.254,

Vlanif10配置了两个IP地址,也就是同一个VLAN我们用了两个IP子网。那么端口1与端口2现在虽然是二层隔离,ARP啥的无法透过来,但是PC1与PC2仍然能够借助自己的网关实现三层互访,这就是所谓的二层隔离但是三层不隔离。那么如果要彻底将端口1及端口2隔离呢?使用系统视图命令**port-isolate mode all**即可。

路由基础¶

- IP 路由基础

- 什么是 IP 路由

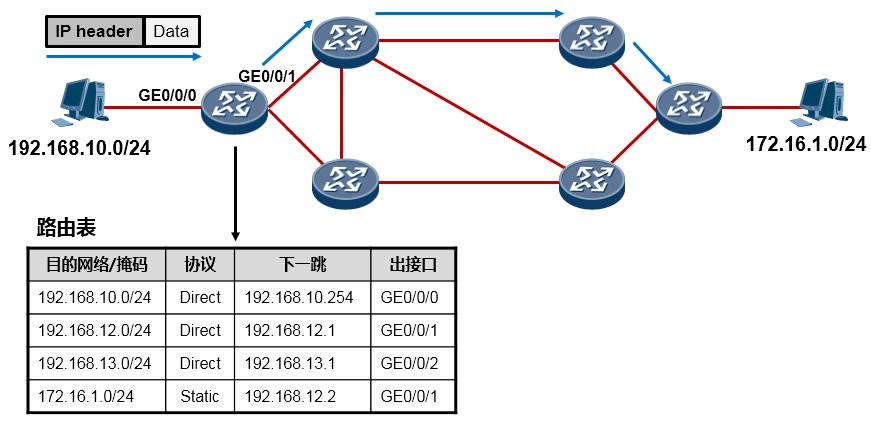

在一个IP网络中,路由(Routing)是个非常非常基本的概念。网络的基本功能是使得处于网络中的两个IP 节点能够互相通信,而通信实际上就是数据交互的过程,数据交互则需要网络设备帮助我们来将数据在两个通信节点之间进行传输。当路由器(或者其他三层设备)收到一个IP数据包时,路由器会找出报文中的IP 头里的目的IP地址,然后拿着目的IP地址到自己的路由表(Routing Table)中进行查询,找到“最匹配”的路由条目后,将数据包根据路由条目所指示的出接口或下一跳IP转发出去,这就是路由。

每台路由器都会在本地维护一个路由表,路由表中装载着路由器通过各种途径获知的路由条目(Route), 每一条路由条目可能包含:目的网络号及掩码长度、路由协议类型、出接口或下一跳IP、路由协议优先级、开销等信息元素。路由器通过直连、静态的或者动态的方式获取路由条目并维护自己的路由表,路由表是每台支持路由功能的设备进行数据转发的依据和基础,是一个非常重要的概念,任何一台支持路由功能的设备要执行数据转发或路由的动作,就必须拥有及维护一张路由表。

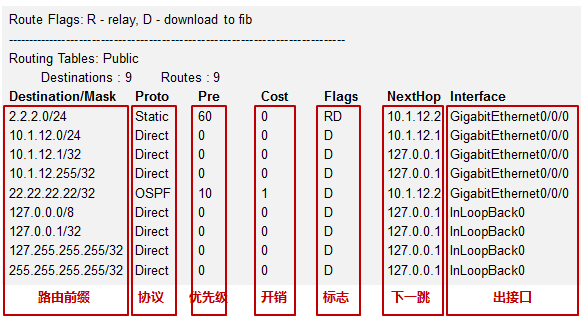

- IP 路由表

任何一台支持路由功能的设备要执行数据转发或路由的动作,就必须拥有及维护一张路由表,路由表可以理解为将数据包转发到特定目的地所依据的一张“地图”。在我司三层设备(如路由器、防火墙、三层交换机等)上查看IP路由表的命令如下:

[Huawei] display ip routing-table¶

[Huawei] display ip routing-table¶

每个路由条目必须包括下面几个信息元素:

**目的网络/掩码:**也被称为路由前缀,这是路由条目所关联的目的网络地址及网络掩码。一条完整的路由前缀由:网络地址+前缀长度(或者网络掩码)构成,两者缺一不可,例如192.168.1.0/24与192.168.1.0/25, 虽然网络地址相同,都是192.168.1.0,但是两者绝对是两条不同的路由,因为他们的前缀长度不相同。

**协议类型:**本条路由是通过什么途径学习到的,例如是直连的,或是静态的,或者是通过OSPF、IS-IS、

EIGRP、BGP等动态路由学习到的。

优先级:与协议类型对应,路由表中路由的获取来源有多种,每种协议类型对应不同的优先级,优先级值越小则路由越优。当一台路由器同时从多种不同的路由协议学习到去往同一个目的地的路由时,它将优选路由协议优先级值最小的那条路由。

**开销:**路由的度量值,在许多书籍或文档中也使用metric来描述。直连及静态路由的Cost为0。通过动态路由协议学习到的Cost则根据实际情况而定。不同的路由协议计算Cost的方法不同。

下一跳:去往目标网络的下一跳IP地址。

出接口:去往目标网络从本设备的哪个接口出去。

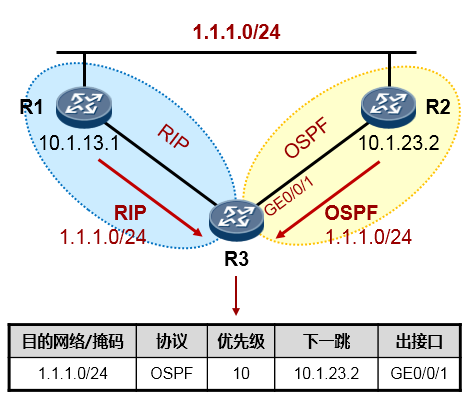

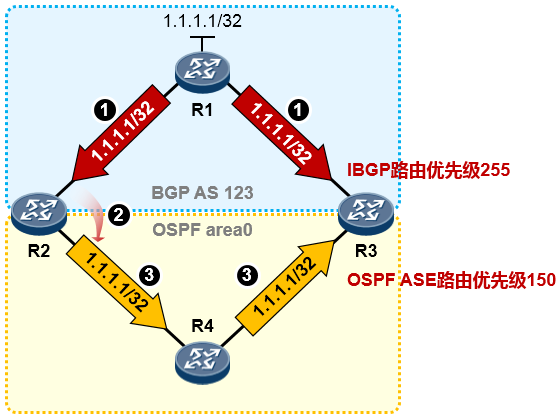

- 路由优先级

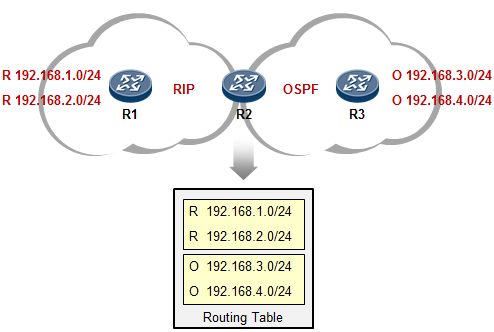

路由器可以通过多种途径获知路由条目:如通过静态手工配置,或通过各种动态路由协议学习等等。当路由器从多种不用的协议获知去往同一个目的地的路由时,路由器会比较这些路由的优先级(Preference),优选Preference值最小的路由。如果Preference值相等,例如是同种路由协议获取到的路由,则进一步比较开销值(Cost),当然,这其中还牵涉到不同的路由协议内在的工作机制问题,这就要针对不同的路由协议具体讨论了,我们这里暂时不讨论这么深入。

如下图,R3与R1运行的是RIP路由协议,R3又通过OSPF与R2建立邻接关系。R3同时从RIP及OSPF学习到了去往目的地1.1.1.0/24的路由,它最终会将OSPF的路由装载进路由表,也就是将R2作为实际去往

1.1.1.0/24的下一跳,因为OSPF协议的优先级值比RIP要小——优先级更高。当然,如果此时R2发生故障, 那么R3路由表中该条OSPF路由失效,则R3将RIP路由加载到路由表中。

针对不同的路由协议,对应的优先级见下表,这是个众所周知的约定(不同的厂家,可能有所不同,下表中罗列的是我司的产品特性):

| 路由协议或路由种类 | 优先级 | ||

|---|---|---|---|

| DIRECT | 0 | ||

| OSPF | 10 | ||

| IS-IS | 15 | ||

| STATIC | 60 | ||

| RIP | 100 |

|---|---|

| OSPF ASE | 150 |

| OSPF NSSA | 150 |

| IBGP | 255 |

| EBGP | 255 |

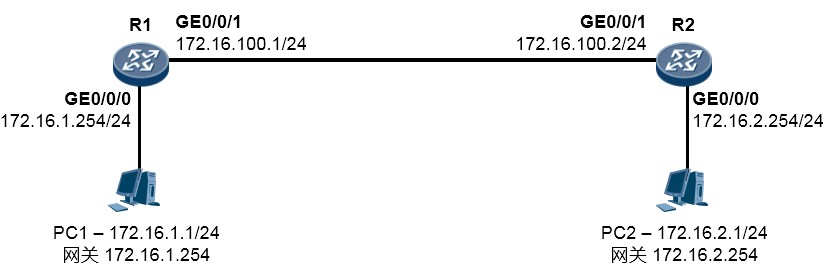

- 静态路由

关于静态路由¶

路由器的天职,就是维护路由表以及依据路由表进行数据转发。而路由表中包含通过各种途径学习到的路由表项(路由条目),主要有如下几种途径:

- 直连路由自动学习;

- 通过手工的方式为设备添加静态路由条目;

- 使用动态路由协议使得设备之间能够进行路由信息的更新及学习,动态地维护路由表项。以下图为例:

PC1的网关设置为172.16.1.254,也就是R1的GE0/0/0口IP;PC2的网关设置为172.16.2.254也就是R2 的GE0/0/0口IP。在初始情况下,对于R1而言,当接口UP以后,路由器会自动学习活跃的接口所在网络的网络地址及掩码并且维护自己的路由表,例如R1的路由表,可能像下面这样(省略了无关信息):

| 目的网络/掩码 | 协议 | 优先级 | 出接口 | 下一跳 |

|---|---|---|---|---|

| 172.16.1.0/24 | Direct | 0 | GE0/0/0 | 172.16.1.254 |

| 172.16.100.0/24 | Direct | 0 | GE0/0/1 | 172.16.100.1 |

R2的路由表类似,这里不再赘述。现在当PC1要访问PC2时,由于PC1的网关设置为R1的GE0/0/0口的

IP地址,于是PC1将目的地址为172.16.2.1的IP数据包发送给它的网关。而当R1收到这个数据包时,R1

发现这个数据包的目的地址是172.16.2.1,它就去查询自己的路由表,结果发现路由表中,并没有匹配

172.16.2.1的条目,因此数据包被丢弃,到目前为止PC1是无法与PC2互访的。那么如何才能使R1正常转发这个数据包呢?当然需要R1的路由表中有相关的条目来做指示。

最简单的一种方式是,通过手工的方式为R1添加去往172.16.2.0/24的路由条目,这种方式添加的路由称为静态路由。

静态路由的配置的命令非常简单:

[Quidway] ip route-static 172.16.2.0 24 172.16.100.2 命令中的红色字体部分是这条路由的目的网络地址(172.16.2.0)及掩码长度(24);蓝色字体部分是 去往这个目的地的“下一跳IP地址”。于是R1的路由表变成下面这个样子:

我们看到,R1的路由表里出现了一个新增的条目,路由前缀是172.16.2.0/24,协议类型为“静态”, 优先级为60,出接口为GE0/0/1,去往目的地的下一跳IP是172.16.100.2。这样一来,当R1收到PC1发往172.16.2.1的数据包时,它查看路由表,发现路由表中有一个条目匹配,于是R1将该数据包丢给该条路由指示的下一跳172.16.100.2,这个数据包被转发到了R2,再由R2查它的路由表,R2发现数据包的目的地172.16.2.1在本地路由表中有路由条目匹配,而且是直连网络,因此R2将数据包根据路由条目的指示从GE0/0/0口发送出去,最终PC2收到了这个数据包。

现在问题来了,我们在R1上增加了这条静态路由后,PC1与PC2就能够互通了么?答案是否定的,为什么?因为两个节点之间的数据通信往往是双向的,有去得有回,在R1上增加去往172.16.2.0/24的静态路由后,PC1发往PC2的数据包是能够被转发到PC2的,但是如果此刻PC2要回送报文呢?PC2回送的数据包目的IP地址就是172.16.1.1,这个数据包首先被PC2发往自己的网关也就是R2,R2查看路由表,却没有发现匹配目的地址172.16.1.1的路由,于是就丢包。

因此,为了使得PC1与PC2之间能够相互通信,我们还需要做一步动作,也就是在R2上也增加一条路由,路由的目的地是172.16.1.0/24网络,下一跳呢?当然就是172.16.100.1了。如此一来PC1及PC2互相通信就没有问题了。

静态路由的配置¶

方法一:关联下一跳IP的方式:¶

[Quidway] ip route-static 172.16.2.0 24 172.16.100.2

红色字体部分为该路由条目的网络地址;

蓝色字体部分为该目的网络的网络掩码或者掩码长度;此处24等同于255.255.255.0。绿色字体部分为去往该网络的下一跳IP地址;

方法二:关联出接口的方式:¶

[Quidway] ip route-static 172.16.2.0 24 GigabitEthernet0/0/1

红色字体部分为该路由条目的网络地址; 蓝色字体部分为网络掩码或者掩码长度;

绿色字体部分为去往该网络的出接口,注意,在华为路由器上,静态路由可关联出接口或下一跳IP,或两者都关联。如果路由的出接口为点对点接口(例如采用HDLC或PPP封装的串行接口),则可只关联出接口。但若出接口为广播多路访问型接口,例如以太网口,那么就必须关联下一跳,如**ip route-static 172.16.2.0 24 GigabitEthernet0/0/1 172.16.100.2**,或者**ip route-static 172.16.2.0 24 172.16.100.2**。

- 静态路由简单实验

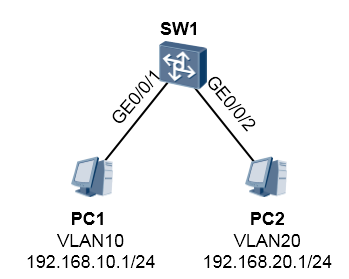

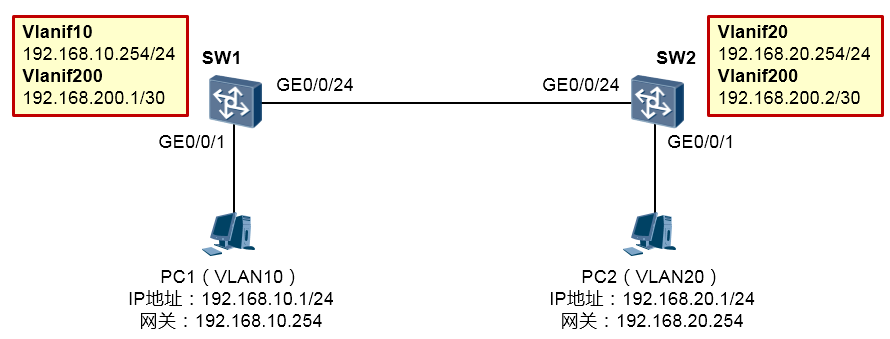

在上图所示的网络中,SW1连接着PC1,PC1属于VLAN10,使用的网段是192.168.10.0/24;SW2连接着

PC2,PC2属于VLAN20,使用的网段是192.168.20.0/24;PC1及PC2的网关分别为SW1及SW2。两台交换机通过VLAN200实现三层对接,要求完成交换机的配置,使得PC1与PC2能够相互通信。

SW1的配置如下:

SW2的配置如下:

完成上述配置后,PC1即可与PC2相互通信。在SW1上检查一下路由表:

| \<SW1>display ip routing-table Route Flags: R - relay, D - download to fib ------------------------------------------------------------------------------ Routing Tables: Public | ||||||

|---|---|---|---|---|---|---|

| Destinations : 7 | Routes : 7 | |||||

| Destination/Mask | Proto | Pre | Cost | Flags | NextHop | Interface |

| 127.0.0.0/8 | Direct | 0 | 0 | D | 127.0.0.1 | InLoopBack0 |

| 127.0.0.1/32 | Direct | 0 | 0 | D | 127.0.0.1 | InLoopBack0 |

| 192.168.10.0/24 | Direct | 0 | 0 | D | 192.168.10.254 | Vlanif10 |

| 192.168.10.254/32 | Direct | 0 | 0 | D | 127.0.0.1 | Vlanif10 |

| 192.168.20.0/24 | Static | 60 | 0 | RD | 192.168.200.2 | Vlanif200 |

| 192.168.200.0/30 | Direct | 0 | 0 | D | 192.168.200.1 | Vlanif200 |

| 192.168.200.1/32 | Direct | 0 | 0 | D | 127.0.0.1 | Vlanif200 |

在以上输出中能看到我们配置的静态路由,SW2同理。

当然此时在SW1 上也可以直接ping 通PC2 , 但是实际上, SW1 在ping PC2 时, 报文的源IP 地址是192.168.200.1 , 因此如果我们要验证192.168.10.0/24 网段到PC2 的可达性,可以在SW1 执行ping

192.168.20.1测试时,强制指定探测报文的源IP地址为192.168.10.254:

在网络设备上,执行ping命令时,关联-a关键字可指定ICMP探测报文的源地址(需为本设备上的IP地址)。

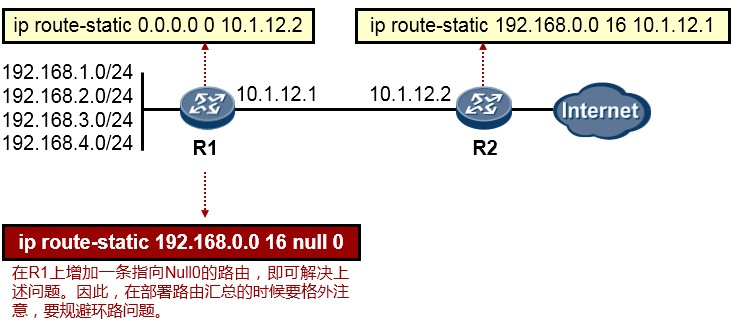

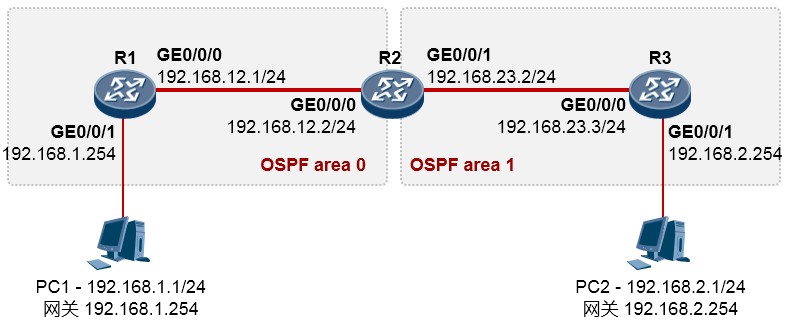

- 默认路由(缺省路由)